KI Cyberangriffe

Da künstliche Intelligenz die Geschäftsabläufe revolutioniert, setzen 91% der Organisationen KI-Systeme in unternehmenskritischen Arbeitsabläufen ein. Während diese Technologien transformative Möglichkeiten bieten, stehen sie vor beispiellosen Cyberangriffen, denen herkömmliche Sicherheitsframeworks nicht angemessen begegnen können.

Dieser Leitfaden untersucht aufkommende Vektoren von KI-Cyberangriffen und erörtert umfassende Verteidigungsstrategien, die es Organisationen ermöglichen, ihre KI-Investitionen zu schützen, während sie operative Exzellenz und Datensicherheit aufrechterhalten.

Die hochmoderne KI-Sicherheitsplattform von DataSunrise bietet Zero-Touch-Bedrohungsschutz mit autonomer Angriffserkennung über alle wichtigen KI-Plattformen hinweg. Unser kontextbasiertes Schutzsystem integriert Cyberabwehr nahtlos mit technischen Kontrollen und bietet eine chirurgisch präzise Angriffsminderung für einen umfassenden Schutz von KI-Systemen.

Kritische Vektoren von KI-Cyberangriffen

KI-Systeme stehen vor einzigartigen Sicherheitsbedrohungen, die spezielle Schutzansätze erfordern:

Angriffe durch Prompt-Injektion

Angreifer erstellen bösartige Eingaben, die darauf ausgelegt sind, Systemanweisungen zu überschreiben und das Verhalten der KI zu manipulieren, was potenziell zu unautorisiertem Zugriff auf Systemfunktionen, zur Preisgabe von sensiblen Informationen oder zur Eskalation von Berechtigungen führen kann. Fortgeschrittene Techniken umfassen indirekte Injektionen durch Inhalte Dritter und mehrstufige Angriffe, die einer Erkennung entgehen – ähnlich wie SQL-Injection-Schwachstellen in traditionellen Systemen.

Vergiftung von Trainingsdaten

Angreifer manipulieren Trainingsdatensätze, um das Verhalten von Modellen zu beeinflussen, indem sie voreingenommene Inhalte einfügen, Hintertüren auslösen oder Sicherheitslücken einführen. Diese Angriffe gefährden die KI-Systeme von der Basis her, was umfangreiche Neutrainingsmaßnahmen zur Behebung und eine umfassende Datenbankverschlüsselung zum Schutz der Trainingsdaten erfordert.

Modell-Extraktion und Diebstahl von geistigem Eigentum

Raffinierte Angreifer versuchen, proprietäre Modelle durch systematisches Abtasten von APIs und Analyse von Abfragen zu rekonstruieren. Angriffe zur Modell-Extraktion gefährden Wettbewerbsvorteile und Investitionen in geistiges Eigentum, weshalb umfassende Prüfprotokolle und Verhaltensanalysen erforderlich sind, um ungewöhnliche Abfragemuster zu erkennen.

Adversarial Beispiele

Angreifer erstellen Eingaben, die speziell darauf ausgelegt sind, dazu zu führen, dass KI-Systeme Daten falsch klassifizieren oder fehlerhafte Entscheidungen treffen. Adversarial Beispiele nutzen mathematische Eigenschaften neuronaler Netze aus, um unmerkliche Störungen zu erzeugen, die die Modellausgaben dramatisch verändern. Organisationen müssen robuste Sicherheitsregeln implementieren, um diese ausgeklügelten Angriffsmuster zu erkennen und zu blockieren.

Implementierung der Erkennung von KI-Angriffen

Die Erkennung von Prompt-Injektionsangriffen erfordert eine Echtzeitanalyse der Benutzereingaben, kombiniert mit Mustererkennung und Verhaltensüberwachung. Organisationen sollten Data-Discovery-Funktionen nutzen, um sensible Informationen in KI-Interaktionen zu identifizieren. Die folgende Implementierung zeigt, wie bösartige Aufforderungen, die versuchen, KI-Systeme zu manipulieren, identifiziert werden können:

import re

from datetime import datetime

class AIAttackDetector:

def __init__(self):

self.injection_patterns = [

r'ignore\s+previous\s+instructions',

r'disregard\s+all\s+prior\s+commands',

r'act\s+as\s+if\s+you\s+are\s+administrator'

]

def detect_prompt_injection(self, prompt: str, user_id: str):

"""Erkennt in Echtzeit Versuche der Prompt-Injektion"""

detection_result = {

'user_id': user_id,

'threat_level': 'LOW',

'attack_detected': False

}

# Überprüfe bekannte Injektionsmuster

for pattern in self.injection_patterns:

if re.search(pattern, prompt, re.IGNORECASE):

detection_result['attack_detected'] = True

detection_result['threat_level'] = 'HIGH'

break

return detection_result

Überwachung der Modellintegrität

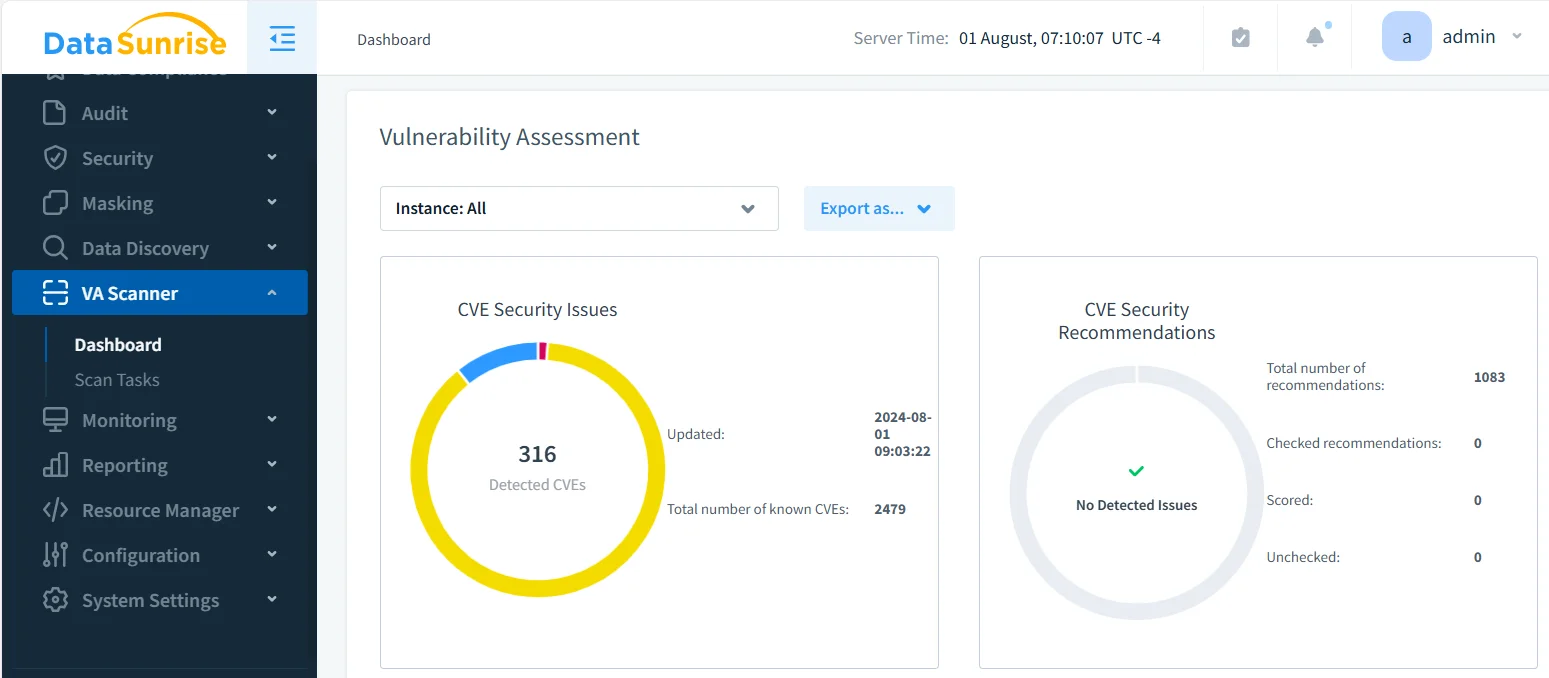

Die Überwachung der Integrität von KI-Modellen erfordert einen kontinuierlichen Vergleich der aktuellen Leistungsmetriken mit etablierten Basiswerten, um eine Vergiftung der Trainingsdaten zu erkennen. Regelmäßige Schwachstellenbewertungen helfen dabei, Schwächen zu identifizieren, bevor Angreifer sie ausnutzen. Diese Implementierung verfolgt Leistungsabweichungen, die auf kompromittierte Modelle hinweisen könnten:

class AIModelIntegrityMonitor:

def __init__(self, baseline_metrics):

self.baseline_metrics = baseline_metrics

self.alert_threshold = 0.15

def detect_model_poisoning(self, current_performance: dict):

"""Überwacht Anzeichen einer Vergiftung der Trainingsdaten"""

integrity_assessment = {

'poisoning_detected': False,

'anomalies': []

}

# Vergleiche Leistung mit dem Basiswert

for metric, baseline_value in self.baseline_metrics.items():

current_value = current_performance.get(metric, 0)

deviation = abs(current_value - baseline_value) / max(baseline_value, 0.001)

if deviation > self.alert_threshold:

integrity_assessment['anomalies'].append({

'metric': metric,

'deviation': deviation

})

integrity_assessment['poisoning_detected'] = True

return integrity_assessment

Strategie zur Implementierung von Verteidigungsmaßnahmen

Für Organisationen:

- Mehrschichtige Sicherheit: Implementieren Sie Tiefenverteidigungsstrategien mit rollenbasierter Zugriffskontrolle

- Kontinuierliche Überwachung: Setzen Sie Echtzeitüberwachung zur Angriffserkennung ein

- Vorfallreaktion: Etablieren Sie KI-spezifische Reaktionsverfahren mit automatisierter Bedrohungsminderung

- Compliance-Management: Nutzen Sie Compliance-Manager-Tools, um die Einhaltung gesetzlicher Vorgaben sicherzustellen

Für technische Teams:

- Eingabesäuberung: Implementieren Sie robuste Validierungen mit dynamischem Datenmasking und statischem Masking für sensible Daten

- Ratenbegrenzung: Verhindern Sie die Extraktion von Modellen durch intelligente Ratenbegrenzung

- Audit-Protokollierung: Führen Sie umfassende Prüfprotokolle mit optimierter Audit-Speicherung

DataSunrise: Umfassender Schutz vor KI-Cyberangriffen

DataSunrise bietet unternehmensgerechten Schutz vor Cyberangriffen, der speziell für KI-Umgebungen entwickelt wurde. Unsere Lösung liefert autonome Bedrohungserkennung mit Echtzeit-Angriffsminderung über ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant und maßgeschneiderte KI-Einrichtungen und gewährleistet KI-Konformität per Voreinstellung.

Wesentliche Verteidigungsfunktionen:

- ML-gestützte Bedrohungserkennung: Kontextbewusster Schutz mit der Erkennung verdächtigen Verhaltens in allen KI-Interaktionen unter Einsatz fortschrittlicher LLM- und ML-Tools

- Prävention von Prompt-Injektionen: Zero-Touch-KI-Überwachung mit automatischer Erkennung von Angriffsmustern

- Schutz der Modellintegrität: Kontinuierliche Überwachung zur Erkennung von Vergiftungsversuchen bei Trainingsdaten

- Plattformübergreifende Abdeckung: Einheitlicher Schutz über 50+ unterstützte Plattformen mit herstellerunabhängigem Schutz

- Automatisierte Reaktion: Echtzeit-Konformität mit sofortiger Bedrohungsbenachrichtigung

Die flexiblen Bereitstellungsmodi von DataSunrise unterstützen On-Premise-, Cloud- und hybride KI-Umgebungen mit nahtloser Integration. Organisationen erreichen eine signifikante Reduzierung erfolgreicher KI-Cyberangriffe, eine verbesserte Bedrohungssichtbarkeit durch umfassende Prüfprotokolle und ein optimiertes Sicherheitsmanagement mit No-Code-Policy-Automatisierung. Unsere Datenbank-Firewall bietet zusätzliche Schutzschichten gegen unautorisierten Zugriff.

Im Gegensatz zu Lösungen, die eine ständige Regelanpassung erfordern, bietet DataSunrise eine autonome Compliance-Orchestrierung mit kontinuierlicher regulatorischer Kalibrierung. Unsere kosteneffiziente, skalierbare Plattform bedient Organisationen von Start-ups bis hin zu Fortune-500-Unternehmen mit flexiblen Preismodellen.

Fazit: Aufbau widerstandsfähiger KI-Sicherheit

KI-Cyberangriffe stellen komplexe Bedrohungen dar, die umfassende Verteidigungsstrategien erfordern, um die einzigartigen Schwachstellen in KI-Systemen anzugehen. Organisationen, die robuste KI-Sicherheitsrahmen implementieren, positionieren sich, um das transformative Potenzial der KI zu nutzen und gleichzeitig Schutz gegen sich wandelnde Bedrohungen zu gewährleisten.

Durch die Implementierung fortschrittlicher Verteidigungsrahmen mit automatisierter Überwachung und intelligenter Bedrohungserkennung können Organisationen KI-Innovationen mit Zuversicht einsetzen, während sie ihre wertvollsten Vermögenswerte schützen. Die Zukunft gehört den Organisationen, die sowohl KI-Innovation als auch umfassende Cybersicherheit mit kontinuierlichem Datenschutz meistern.

Schützen Sie Ihre Daten mit DataSunrise

Sichern Sie Ihre Daten auf jeder Ebene mit DataSunrise. Erkennen Sie Bedrohungen in Echtzeit mit Activity Monitoring, Data Masking und Database Firewall. Erzwingen Sie die Einhaltung von Datenstandards, entdecken Sie sensible Daten und schützen Sie Workloads über 50+ unterstützte Cloud-, On-Premise- und KI-System-Datenquellen-Integrationen.

Beginnen Sie noch heute, Ihre kritischen Daten zu schützen

Demo anfordern Jetzt herunterladen