LLM Anwendung Sicherheits-Checkliste

Einführung

Während Organisationen Large Language Models (LLMs) in die Produktion integrieren, vergrößert sich die Angriffsfläche über reine Datenlecks und Prompt Injection hinaus. Jedes mit einem LLM verbundene System—ob eingebettet in Chatbots, Analysetools oder Unternehmenssuche—muss Benutzerfreundlichkeit mit Datensicherheit und Compliance in Einklang bringen.

Obwohl moderne KI-APIs die Modellendpunkte schützen, liegen Schwachstellen oft in den Integrationspunkten: Eingabesäuberung, Plugin-Berechtigungen, Vektorspeicherung oder ungeschützter Prompt-Logik. Sichere KI-Anwendungen zu erstellen bedeutet, kontinuierliche Überwachung, Verschlüsselung und Least-Privilege-Richtlinien vom Prompt bis zur Antwort zu implementieren.

Verständnis der LLM Anwendungssicherheit

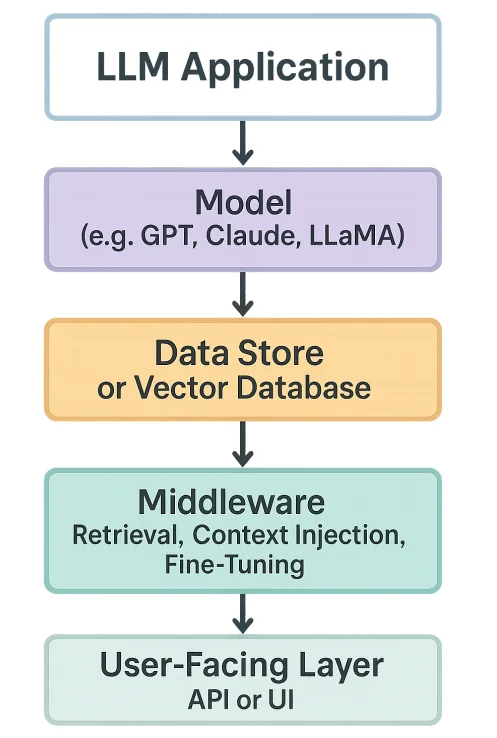

Eine LLM-Anwendung kombiniert typischerweise vier Elemente:

- Das Modell (z.B. GPT, Claude, LLaMA)

- Den Datenspeicher oder die Vektor-Datenbank

- Die Middleware (Abruf, Kontextinjektion, Feineinstellung)

- Die benutzerorientierte Schicht (API oder UI)

Jede Ebene bringt Risiken mit sich:

- Das Modell könnte sensible Daten speichern.

- Die Abrufebene könnte private Einbettungen offenlegen.

- Plugins könnten unbeabsichtigte Aktionen ausführen.

- Logs könnten PII oder vertrauliche Tokens aufzeichnen.

Sicherheit bedeutet hier, sowohl die Pipeline als auch die daraus generierte Intelligenz zu schützen.

Zentrale Sicherheitsherausforderungen

- Prompt-Injection-Angriffe – Bösartige Eingaben, die das Modellverhalten manipulieren, um sensible Daten zu lecken oder zu verändern.

- Datenexfiltration über Plugins – Unbeschränkte Plugin-APIs oder Aufrufe externer Tools, die private Daten exportieren.

- Vergiftung von Trainingsdaten – Verunreinigte Fine-Tuning- oder Abruf-Korpora, die falsche Fakten oder Schwachstellen einführen.

- Injektion in Modellausgaben – Angreifer betten bösartige Payloads in Antworten ein (z.B. Cross-Site-Scripting).

- Compliance Drift – Wenn LLMs sensible Daten ohne Audit-Trails verarbeiten und dadurch DSGVO oder HIPAA-Standards verletzen.

Kern-Sicherheitsebenen für LLM-Anwendungen

1. Datensicherheit und Compliance

- Verschlüsseln Sie gespeicherte Einbettungen und Vektor-Indizes mithilfe von Datenbankverschlüsselung.

- Klassifizieren und maskieren Sie sensible Daten mit dynamischer Maskierung oder statischer Maskierung, bevor sie dem Modell zugeführt werden.

- Überprüfen Sie die Übereinstimmung mit Frameworks wie DSGVO und PCI DSS.

2. Zugriffskontrolle und Überwachung

- Setzen Sie rollenbasierte Zugriffskontrolle (RBAC) um.

- Implementieren Sie Reverse-Proxy-Gateways für Authentifizierung, Ratenbegrenzung und Anomalieerkennung.

- Zentralisieren Sie die Aktivitätsüberwachung für jeden API-Aufruf und jede Modellabfrage.

3. Schutz von Prompt und Kontext

- Säubern Sie Benutzereingaben und schwärzen Sie Geheimnisse, bevor Sie an das LLM weitergegeben werden.

- Setzen Sie „Schutzschienen“ ein, die Antworten validieren und vertrauliche Identifikatoren entfernen.

- Protokollieren Sie alle Prompts sicher mit Audit-Logs.

4. Sicherheit im Modelllebenszyklus

- Signieren und versionieren Sie jedes Modell und jeden Datensatz.

- Überprüfen Sie alle Fine-Tuning-Datensätze auf Injektionen oder bösartige Inhalte.

- Führen Sie kontinuierliche Integritätsprüfungen mittels Hashing oder digitaler Signaturen durch.

5. Netzwerk- und API-Verteidigung

- Verwenden Sie HTTPS/TLS für den gesamten Modellverkehr.

- Begrenzen Sie ausgehende Verbindungen von LLM-Anwendungen.

- Überwachen Sie alle Plugin- und externen API-Aufrufe auf Datenexfiltration.

Implementierungs-Best-Practices

Für Organisationen

- Datenklassifizierung zuerst: Identifizieren Sie, welche Eingaben sensibel oder reguliert sind.

- Einheitliche Compliance-Übersicht: Nutzen Sie Datenentdeckung und Compliance-Berichte von DataSunrise, um die Nutzung zu überwachen.

- Zero-Trust KI-Bereitstellung: Gehen Sie davon aus, dass jeder Prompt oder jede Antwort ein potentieller Angriffsvektor sein könnte.

- Regelmäßige Sicherheitstests: Führen Sie Red-Team- und adversarielle Bewertungen der LLM-Ausgaben durch.

Für technische Teams

- Hygiene beim Fine-Tuning: Validieren Sie Datensätze vor dem Feintuning oder der RAG-Aufnahme.

- Sicheres Geheimnis-Management: Betten Sie niemals API-Schlüssel in Prompts oder Umgebungsvariablen ein, ohne diese zu verschlüsseln.

- Verhaltensanalysen: Verwenden Sie Verhaltensanalysen, um anomale Abfragemuster zu erkennen.

- Least-Privilege-Richtlinie: Befolgen Sie das Prinzip des geringsten Privilegs über APIs und Modellzugriffsebenen hinweg.

LLM Anwendung Sicherheits-Checkliste (Zusammenfassung)

| Bereich | Wichtige Kontrollen | Tools / Techniken |

|---|---|---|

| Datenebene | Verschlüsselung, Maskierung, Compliance-Kennzeichnung | Datenbankverschlüsselung, Dynamische Maskierung |

| Zugriffskontrolle | RBAC, MFA, Proxies | Reverse Proxy, RBAC |

| Prompt-Ebene | Säuberung, Kontextfilter | Eigene Schutzschienen, Validierungsskripte |

| Modelllebenszyklus | Versionierung, Signierung, Validierung | GitOps, CI/CD-Scans |

| Überwachung | Zentralisierte Audit- und Anomalieerkennung | Aktivitätsüberwachung, Audit-Logs |

FAQ: LLM Anwendungssicherheit

F1. Was ist das größte Sicherheitsrisiko bei LLMs?

Prompt Injection und Datenexfiltration über verbundene Plugins oder externe APIs.

F2. Kann ein LLM Trainingsdaten leaken?

Ja — insbesondere feingetunte oder RAG-Modelle, die auf sensiblen Texten ohne Maskierung oder Verschlüsselung trainiert wurden.

F3. Wie kann ich die Einhaltung von DSGVO oder HIPAA sicherstellen?

Aktivieren Sie Datenmaskierung, Zustimmungsnachverfolgung und Audit-Trails für alle Modellinteraktionen.

F4. Was ist der beste Weg, um bösartige Aktivitäten zu erkennen?

Verwenden Sie Verhaltensanalysen und Echtzeitüberwachung, um ungewöhnliche Abfragemuster oder exzessive Token-Nutzung zu identifizieren.

F5. Wie sichert DataSunrise LLM-Pipelines?

Durch die Kombination von proxy-basierter Aktivitätsüberwachung, Maskierung und Datenschutz innerhalb eines einheitlichen Compliance-Rahmens.

Fazit

So wie föderiertes Lernen der Welt gezeigt hat, dass datenschutzfreundliche Zusammenarbeit möglich ist, beweist die Sicherung von LLMs, dass Intelligenz und Governance koexistieren können.

DataSunrise ermöglicht Organisationen, Verschlüsselung, Überwachung und Compliance im gesamten LLM-Ökosystem — von Vektorspeichern bis zu feingetunten Modellen — durchzusetzen, sodass kein Einblick auf Kosten der Sicherheit erzielt wird.

Empfohlene Lektüre: