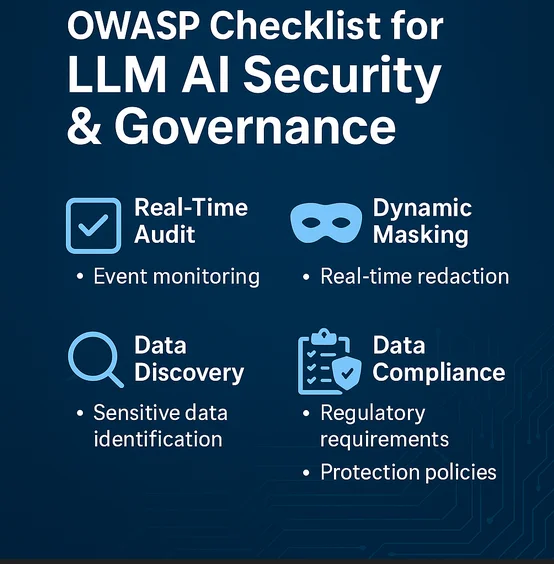

OWASP-Checkliste für LLM-KI-Sicherheit & Governance

Da der Einsatz großer Sprachmodelle (LLMs) in Unternehmenssicherheits- und Governance-Rahmenwerken zunimmt, hat die OWASP-Stiftung begonnen, kritische Problemfelder hervorzuheben. Dieser Artikel untersucht die praktische Anwendung der OWASP-Checkliste für LLM-KI-Sicherheit & Governance, wobei insbesondere der Fokus auf Echtzeit-Audit, dynamische Datenmaskierung, Datenentdeckung, allgemeine Datensicherheit und regulatorische Compliance liegt.

Warum die OWASP-Checkliste für GenAI-Systeme wichtig ist

LLMs wie GPT-4 und Claude werden in Tools integriert, die Protokolle analysieren, Bedrohungen klassifizieren oder die Reaktion auf Zwischenfälle automatisieren. Diese Modelle bringen jedoch neuartige Risiken mit sich, darunter Modell-Inversionsangriffe, Prompt-Injektionen, das Lecken sensibler Daten und den Missbrauch interner Datenbestände. Das OWASP Top 10 für LLMs bietet einen Rahmen, um diese Risiken zu identifizieren und zu mindern. Die Integration in die Unternehmensgovernance stellt sicher, dass GenAI ein Gewinn und keine Last darstellt.

Echtzeit-Audit für KI-Aktivitäten und Entscheidungsprozesse

LLMs agieren oft als Blackboxen. Die Protokollierung von Benutzereingaben, generierten Abschlüssen, Modellentscheidungen und Backend-Datenabfragen ist entscheidend für Audits. Echtzeit-Audit-Systeme wie DataSunrise Audit können eingreifen und protokollieren:

SELECT *

FROM vector_logs

WHERE embedding_model = 'GPT-4' AND confidence_score < 0.5;

Diese Beispielabfrage kann unsichere oder mit geringem Vertrauensniveau ausgestattete Modelloutputs zur Überprüfung aufdecken. Systeme wie Database Activity Monitoring ermöglichen das Taggen und Alarmieren basierend auf ungewöhnlichen Nutzungsmustern oder dem Zugriff auf sensible Vektor-Datenbanken.

Dynamische Maskierung in LLM-gesteuerten Abfragen

Wenn ein LLM dynamisch SQL-Abfragen generiert, besteht eine reale Gefahr, dass sensible Daten offengelegt werden. Durch die Verwendung dynamischer Maskierung wird sichergestellt, dass selbst wenn eine Eingabeaufforderung eine Datenabrufoperation auslöst, persönlich identifizierbare Informationen (PII) wie E-Mails oder Sozialversicherungsnummern verschleiert bleiben.

Zum Beispiel:

SELECT name, MASK(email), MASK(phone_number)

FROM customers

WHERE interaction_type = 'chatbot';

Dies ermöglicht es GenAI-gesteuerten Systemen, sicher in kundenorientierten Anwendungen zu arbeiten, ohne Datenschutzverpflichtungen zu verletzen.

Datenentdeckung und LLM-Eingabefilterung

Effektive Datenentdeckung hilft dabei, zu identifizieren, welche Teile des Data Warehouse oder Vektor-Speichers sensible Datensätze enthalten. In Kombination mit LLM-Pipelines stellt dies sicher, dass Eingabeaufforderungen keinen unautorisierten Kontext abrufen oder einfügen.

OWASP empfiehlt die Klassifizierung und Filterung von Trainingsdaten und Laufzeiteingaben, um Datenlecks zu mindern. Werkzeuge wie Amazon Macie, die Discovery Engine von DataSunrise und das Scannen von Vektor-Metadaten spielen dabei eine wesentliche Rolle.

Ausrichtung an Sicherheitsrichtlinien und Bedrohungsmodellen

Gemäß den OWASP-Richtlinien umfasst die Angriffsfläche von LLMs freigelegte APIs, Drittanbieter-Plugins, unsichere Modellkonfigurationen und zu großzügigen Datenbankzugriff. Die Governance sollte Folgendes beinhalten:

Begrenzung des Modellausgabekontexts mittels Systemaufforderungen.

Durchsetzung von RBAC (Rollenbasierter Zugriffskontrolle).

Blockieren gefährlicher Abfragen mittels einer Datenbank-Firewall.

OWASP empfiehlt außerdem Verhaltensanalysen, um Prompt-Fluten oder Missbrauch zu erkennen.

Sicherstellung der Datenkonformität beim Einsatz von Generativer KI

Compliance bleibt zentral, wenn GenAI mit geschützten Daten (DSGVO, HIPAA, PCI DSS) interagiert. Ein Compliance-Manager für GenAI-Pipelines hilft dabei, abzubilden:

Welche Datentypen vom Modell verarbeitet werden.

Ob Ausgaben gespeichert oder protokolliert werden.

Ob abgeleitete Informationen Benutzer re-identifizieren können.

In der Praxis beinhaltet dies die Konfiguration automatisierter Compliance-Berichte und die Kombination von Audit-Trail-Erkenntnissen mit Maskierungs- und Filterregeln.

Externe Referenzpunkte

Mehrere externe Ressourcen befassen sich ebenfalls mit der Schnittstelle von GenAI und Daten-Governance:

NIST AI Risk Management Framework für strukturierte Governance.

Microsofts Responsible AI Standard für den Einsatz großer Modelle.

AWS-Leitfaden zu Athena-Monitoring und Maskierung für KI-zugängliche Datensätze.

Diese können die OWASP-Prinzipien ergänzen und dazu beitragen, eine durchgehende Sicherheit des KI-Lebenszyklus zu etablieren.

Fazit

Die OWASP-Checkliste für LLM-KI-Sicherheit & Governance ist mehr als ein Richtliniendokument. Sie ist ein Fahrplan zur Risikominderung, wenn generative KI in Sicherheitsoperationen, Compliance-Überwachung und Entscheidungsfindung eingebettet wird. Mit Werkzeugen wie DataSunrise Audit, dynamischer Maskierung und Datenentdeckungs-Engines können Organisationen Grenzen für das Verhalten von KI durchsetzen und gleichzeitig von deren Potenzial profitieren.

Die Daten-Governance muss sich parallel zur KI weiterentwickeln. Die Kombination des OWASP-Fokus mit konkreten Werkzeugen macht dies nicht nur möglich, sondern auch praktikabel.