Prompt-Sicherheit in KI & LLM-Interaktionen

Da Sprachmodelle zunehmend zum Kern der Geschäftsabläufe werden, bringen ihre Interaktionen mit Prompts neue Risikoschichten mit sich. Diese Risiken gehen über das Verhalten des Modells hinaus und betreffen, wie Prompts strukturiert, verarbeitet und protokolliert werden. „Prompt-Sicherheit in KI & LLM-Interaktionen“ hat sich als wesentliche Disziplin etabliert, um sensible Daten zu schützen, regulatorische Compliance zu gewährleisten und Manipulationen der KI-Ausgaben zu verhindern.

Warum Prompt-Sicherheit jetzt wichtig ist

Im Unterschied zu herkömmlichen Anwendungen reagieren LLMs wie ChatGPT oder Claude auf Eingaben, die private, regulierte oder auch feindselige Inhalte enthalten können. Dies schafft eine Angriffsfläche, bei der eine harmlos erscheinende Frage zur Offenlegung vertraulicher Daten, zu Richtlinienverstößen oder zur Manipulation der Ausgabe durch Prompt-Injection-Techniken führen kann.

Wenn sie in Dienste integriert werden, die mit internen Datenbanken oder Kundendatenpipelines verbunden sind, vervielfachen sich die sicherheitsrelevanten Auswirkungen. Deshalb müssen Echtzeit-Audit, dynamische Maskierung und Datenentdeckung zu Standardwerkzeugen in KI-Einsätzen werden.

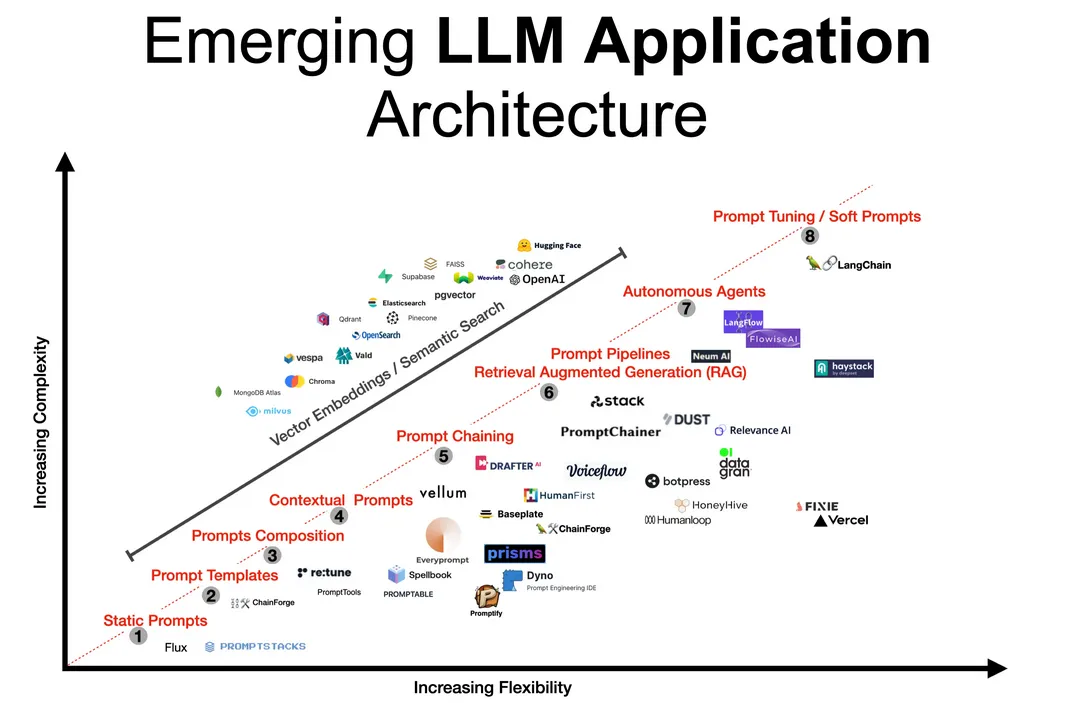

Verständnis der Prompt-Pipeline

Prompts durchlaufen mehrere Systeme – beginnend bei den Benutzeroberflächen, gefolgt von optionalen Vorverarbeitungsfiltern, dem Modell selbst und schließlich über nachgelagerte APIs wie SQL-Generatoren.

Dieser Ablauf muss wie eine sensible Transaktion behandelt werden. Das Protokollieren von Ein- und Ausgaben, das Erkennen von Anomalien und die sofortige Durchsetzung von Maskierungsrichtlinien gewährleisten bei jedem Schritt Sicherheit.

Für weiterführende technische Lektüre untersucht die MITRE ATLAS-Wissensdatenbank feindliche Taktiken gegen maschinelles Lernen, einschließlich promptbasierter Angriffsvektoren.

Echtzeit-Audit: Das Unsichtbare nachverfolgen

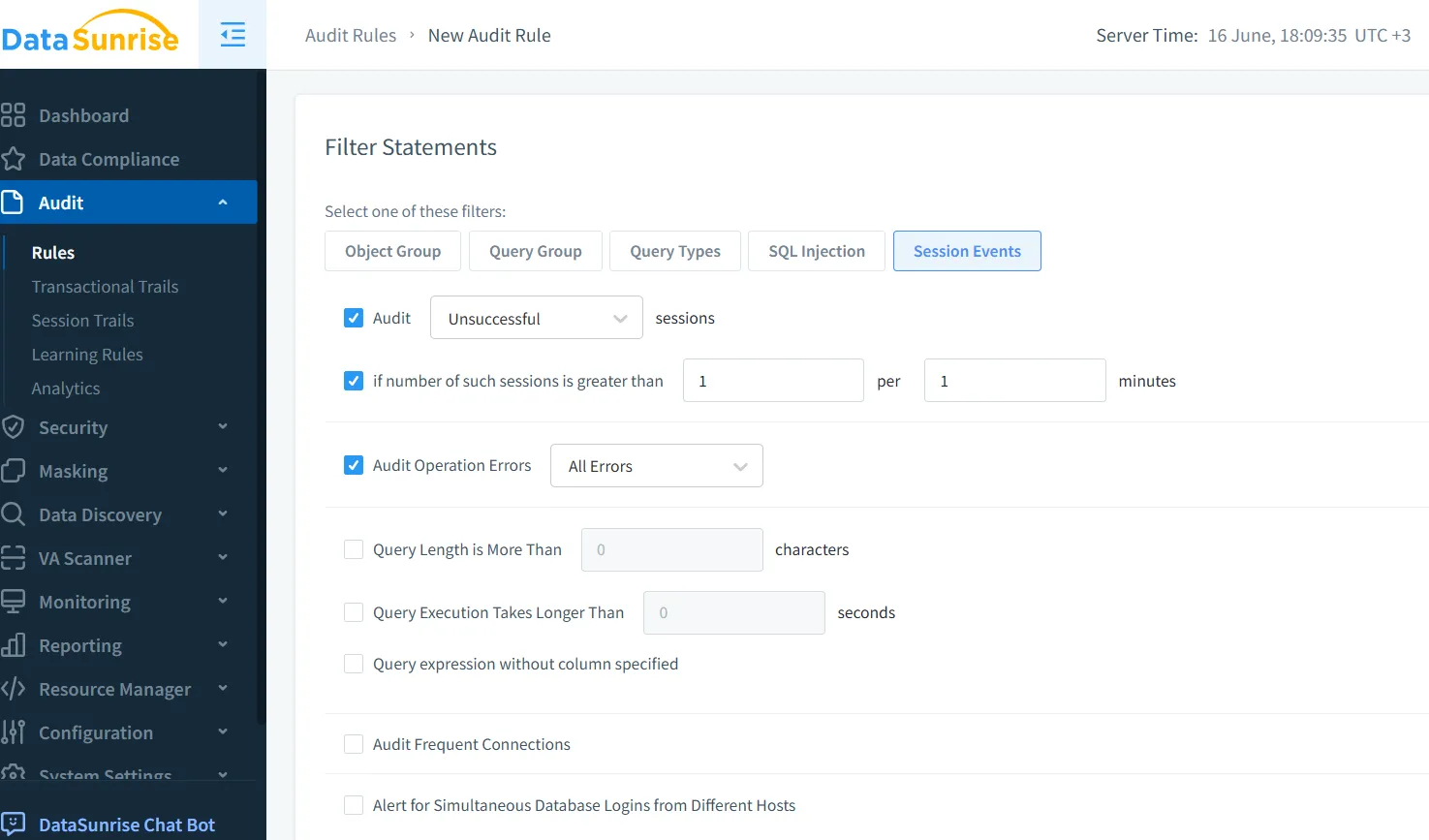

Prompt-Interaktionen hinterlassen oft keine Spuren, sofern sie nicht explizit konfiguriert werden. Echtzeit-Audit-Werkzeuge wie jene, die in der Audit-Trail-Engine von DataSunrise angeboten werden, können jede Anfrage, Abfrage und Transformation, die am Ein- und Ausgang vorgenommen wird, überwachen.

Dies ist besonders nützlich, wenn KI mit nachgelagerten Werkzeugen verbunden ist:

-- Beispiel, generiert aus dem Prompt:

SELECT name, ssn FROM employees WHERE clearance_level = 'high';

Ein Echtzeit-Audit kann sofort Abfragen erkennen, die auf sensible Felder zugreifen, und unbefugte Nutzungen kennzeichnen, bevor Ergebnisse zurückgegeben werden. Weitere Informationen zur Konfiguration von Audit-Regeln für KI-Prompts finden Sie in diesem Audit-Leitfaden.

Dynamische Maskierung: Schutz während der Antwort

Falls die Ausgabe des Modells sensible Daten enthält, müssen diese in Echtzeit maskiert werden. Dynamische Maskierung stellt sicher, dass, selbst wenn der Prompt versucht, private Felder zu extrahieren, das zurückgegebene Ergebnis verschleiert wird.

Zum Beispiel:

Prompt: Zeige mir aktuelle Transaktionen von VIP-Kunden.

LLM Ausgabe: Name: John D*****, Betrag: $45,000

Maskierungsregeln können je nach Benutzerrolle, Sitzungs-Kontext oder Bedrohungsgrad variieren. DataSunrise ermöglicht dies durch flexible Richtlinien, ohne die zugrundeliegenden Daten zu verändern.

Datenentdeckung: Erkennen, was auf dem Spiel steht

Bevor Maskierung durchgesetzt werden kann, muss bekannt sein, welche Daten sensibel sind. LLMs arbeiten oft über verschiedene Schemata und Repositorien hinweg, was eine manuelle Klassifizierung unskalierbar macht.

Automatisierte Datenentdeckungswerkzeuge durchsuchen nach PII, PHI, Zugangsdaten und anderen vertraulichen Feldern. Die Ergebnisse steuern automatisierte Richtlinien, die die Erzeugung von Ausgaben, die solche Daten beinhalten, blockieren, Maskierungsregeln anwenden und Compliance-Teams umgehend benachrichtigen.

Um umfassendere Risiken im Zusammenhang mit unstrukturierten Daten zu verstehen, bietet das AI Risk Management Framework des NIST strukturierte Leitlinien für die Governance im gesamten KI-Lebenszyklus.

Sicherung des Prompt-Lebenszyklus

Die Sicherheit in LLM-Interaktionen geht über die Filterung von Prompts hinaus. Sie umfasst die Steuerung des Zugriffs auf Modellprotokolle, das Management der Prompt-Historie und die Verhinderung von Datenausfluss durch geschickt strukturierte Abfragen.

Verwenden Sie einen Reverse-Proxy, um Prompts abzufangen und zu überprüfen, bevor sie das Modell erreichen. Speichern Sie Prompt- und Antwort-Audit-Trails sicher, um die SOX- und PCI-DSS-Compliance zu unterstützen. Setzen Sie Analysen des Benutzerverhaltens ein, um Abweichungen in Nutzungsmustern oder verdächtige Prompt-Strukturen zu identifizieren.

Eine gute Open-Source-Referenz für Muster zur Verhinderung von Prompt-Injection wird von Prompt Injection gepflegt, die reale Angriffsbeispiele und Gegenmaßnahmen katalogisiert.

Daten-Compliance und Prompt-Sicherheit

KI-Systeme, die Kundendaten verarbeiten, müssen mit Vorschriften wie der DSGVO und HIPAA im Einklang stehen. Prompt-Sicherheit unterstützt dies durch das Auditieren des KI-gesteuerten Datenzugriffs, die Maskierung geschützter Attribute und die Protokollierung von Aktivitäten zur Überprüfung.

Plattformen wie der Compliance Manager von DataSunrise automatisieren diese Prozesse und bringen KI-Interaktionen in Einklang mit den sich weiterentwickelnden gesetzlichen Anforderungen.

Letzte Gedanken: Mensch + Maschine Vertrauen

Da GenAI zunehmend in Entscheidungsprozesse und betriebliche Abläufe integriert wird, entwickelt sich die Prompt-Sicherheit zu einer grundlegenden Vertrauensebene. Echtzeit-Transparenz, Reaktionskontrollen und regulatorische Abstimmung stellen sicher, dass Innovation nicht die Sicherheit übertrifft.

Dieser Ansatz stärkt nicht nur die Systeme, sondern festigt auch das Vertrauen in eine verantwortungsvolle KI-Entwicklung.

Für weiterführende Lektüre sehen Sie, wie LLM- und ML-Werkzeuge in moderne Compliance-Workflows integriert werden.

Und wenn Sie bereit sind zu testen oder einzusetzen, können Sie DataSunrise herunterladen oder eine Demo anfordern.