Sicherheitsbewertung für generative KI-Modelle

Die generative KI hat sich von einer Forschungsneuheit zu einem zentralen Instrument im Unternehmensumfeld entwickelt. Von der Erstellung von Marketinginhalten über den Einsatz in virtuellen Assistenten bis hin zur Zusammenfassung von Kundentickets verarbeiten diese Modelle große Mengen sensibler Informationen. Dieser Umfang an Zugriff erfordert eine robuste Sicherheitsbewertungsstrategie, die auf das einzigartige Verhalten generativer KI-Systeme zugeschnitten ist.

Eine ordnungsgemäße Sicherheitsbewertung für generative KI-Modelle beschränkt sich nicht nur darauf, die Infrastruktur abzusichern. Sie beinhaltet die Überwachung der Interaktion dieser Modelle mit Daten, die Gewährleistung von Compliance und die Anpassung von Kontrollen, um versehentliche Lecks oder den Missbrauch sensibler Ausgaben zu verhindern.

Warum Sicherheitsbewertungen für generative KI-Modelle wichtig sind

Generative KI-Systeme können Trainingsdaten speichern, unerwartete Antworten erzeugen und mit Nutzern über natürliche Sprache interagieren – all dies stellt Sicherheitsherausforderungen dar, mit denen herkömmliche Systeme nicht konfrontiert sind. Ein einzelner Prompt könnte proprietäre Informationen oder personenbezogene Daten extrahieren, wenn nicht starke Datenschutzmaßnahmen vorhanden sind.

Sie bringen auch Compliance-Herausforderungen mit sich. Greift das Modell auf regulierte Daten (wie PHI oder durch PCI-DSS geschützte Felder) zu, muss diese Interaktion gemäß Richtlinien wie den HIPAA-Compliance-Richtlinien oder dem GDPR-Rahmenwerk verfolgt, maskiert und geprüft werden. Für einen umfassenderen Überblick über verantwortungsvolle KI-Praktiken, siehe Microsofts Leitfaden zu Responsible AI.

Echtzeitaudit von GenKI-Prompts und -Ausgaben

Echtzeit-Auditfunktionen sind unerlässlich, um sicherzustellen, dass generative KI-Systeme nicht als Black Boxes agieren. Jeder Prompt und jede generierte Antwort sollte mit kontextuellen Metadaten wie Benutzerrolle, Zeitstempel, IP-Adresse und verwendetem Modell erfasst werden. Diese Protokolle müssen sicher gespeichert und für Compliance-Überprüfungen und Bedrohungsforensik abfragbar gemacht werden.

Hier ist ein einfaches SQL-Beispiel, wie ein GenKI-Ausgabeaudit strukturiert werden könnte:

Um mehr zu erfahren, lesen Sie diese Protokollierungsreferenz von DataSunrise.

Dynamische Maskierung in KI-Ausgaben

Generative Modelle können versehentlich sensible Daten durch Abschlüsse oder abrufunterstützte Antworten preisgeben. Um dem entgegenzuwirken, sollte eine dynamische Datenmaskierung auf zwei Ebenen angewendet werden:

- Maskierung vor der Inferenz, bei der die Eingabe in das LLM dynamisch maskiert wird, wenn sie sensible Felder enthält.

- Maskierung nach der Inferenz, bei der die Ausgaben des Modells gescannt und vor der Weitergabe an den Endnutzer redaktiert werden.

Die dynamische Maskierung kann auch auf rollenbasierte Zugriffssteuerung zurückgreifen, um sicherzustellen, dass nur autorisierte Rollen die rohen Werte sehen. Beispielsweise, wenn ein Modell die letzten vier Ziffern der SSN eines Kunden abruft:

Ein ergänzendes Konzept ist die Durchsetzung von Zero Trust, wie in diesem Überblick zur Zero Trust-Architektur von NIST erklärt.

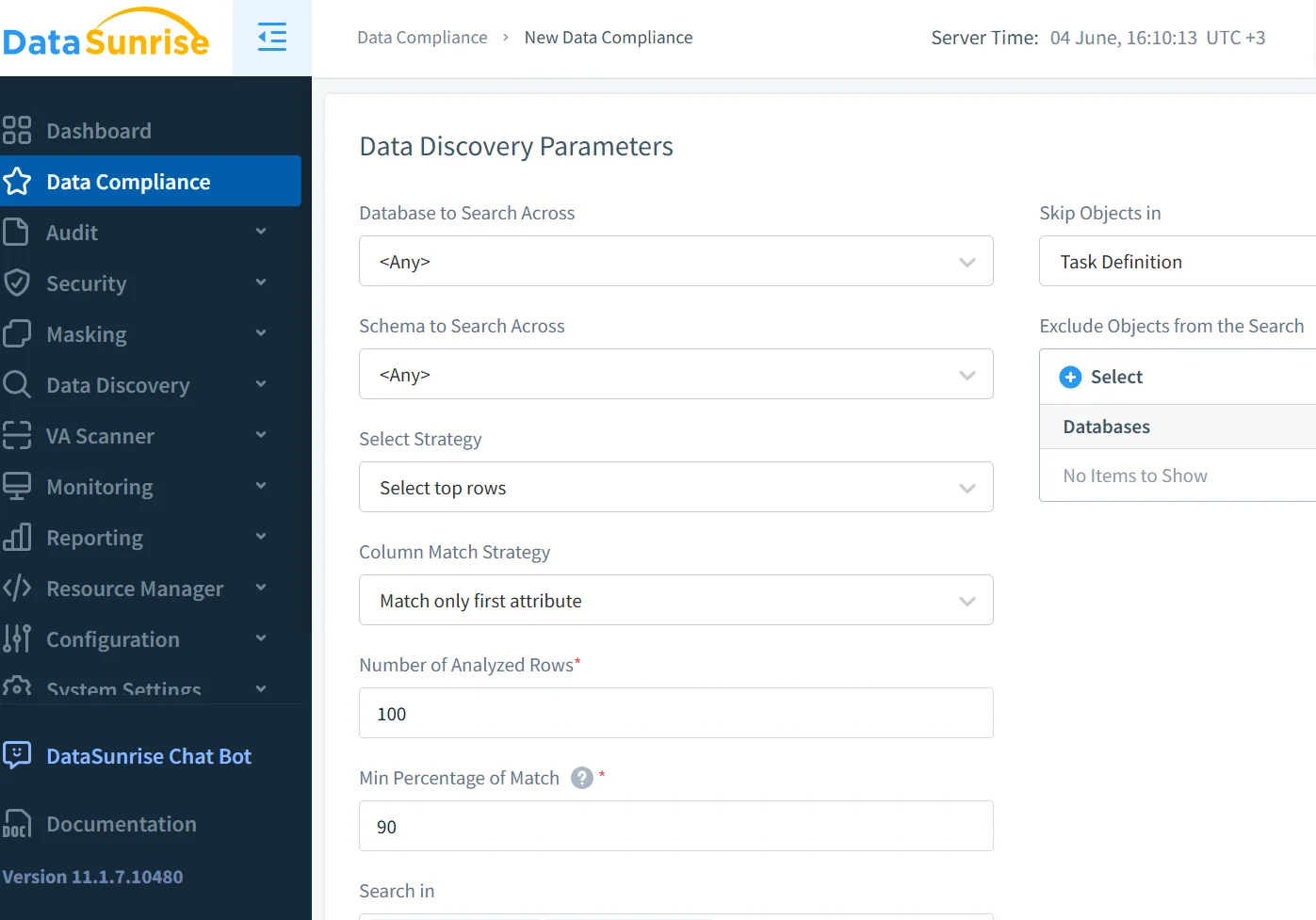

Datenerkennung vor dem Modelltraining

Bevor ein LLM mit internen Datensätzen trainiert oder feinabgestimmt wird, müssen Unternehmen alle Datenfelder, die sensible Inhalte enthalten könnten, klassifizieren und kartieren. Die Integration automatisierter Datenerkennungswerkzeuge gewährleistet Sichtbarkeit über strukturierte und semi-strukturierte Quellen hinweg.

Beispielsweise können Felder wie folgt gekennzeichnet werden:

- PII (z. B. Name, E-Mail, Telefon)

- PHI (z. B. Krankengeschichte)

- PCI (z. B. Kartennummer)

…kann die Maskierungs- und Audit-Richtlinien automatisch aktivieren.

Kombiniert mit Aktivitätsüberwachung stellt dies sicher, dass das Modell niemals nicht verfolgte oder risikoreiche Felder aufnimmt.

Weitere Best Practices zur Datenklassifikation finden Sie im Data Governance-Leitfaden von Google Cloud.

Durchsetzung von Sicherheits- und Compliance-Richtlinien für generative KI-Modelle

Um die Implementierung generativer KI-Modelle mit den Unternehmensrichtlinien in Einklang zu bringen, integrieren Sie sie in eine Datensicherheitsplattform, die in der Lage ist:

| Sicherheitsfunktion | Beschreibung |

|---|---|

| Modellzugriffsüberwachung | Echtzeitprotokollierung darüber, wer was und wann zugreift |

| Prompt-Injektion und Missbrauchsprävention | Filter und Leitplanken, um verdächtige Eingaben zu erkennen oder zu blockieren |

| Berichterstattung für Audit und Compliance | Erstellt strukturierte, compliance-konforme Berichte |

| Feldklassifikation und Tokenisierung | Identifiziert und schützt sensible Felder automatisch |

Werkzeuge wie der DataSunrise Compliance Manager automatisieren einen Großteil dieses Aufwands.

Weitere operative Anleitungen finden Sie auch in IBMs Papier zu den AI Governance Principles.

Beispiel: Blockierung des KI-Zugriffs auf finanzielle Felder

Angenommen, Ihr generatives Modell fragt eine PostgreSQL-Datenbank nach Finanzaufzeichnungen ab. Sie können KI-Prompts daran hindern, jemals auf Spalten wie salary oder card_number zuzugreifen, indem Sie eine Maskierungsrichtlinie verwenden:

Solche Kontrollen sind unerlässlich, um interne Daten-Compliance-Anforderungen einzuhalten.

Moderne Bedrohungen in der Sicherheit generativer KI-Modelle

KI-Systeme stehen vor neuen Bedrohungsklassen:

- Prompt-Injektion: Benutzer bringen das Modell dazu, Daten preiszugeben

- Training-Leckagen: Sensible Daten werden während des Feinabstimmens im Gedächtnis behalten

- Shadow-Zugriff: Unautorisierte Abfragen, die über KI-Wrapper ausgeführt werden

Um diese Bedrohungen zu verhindern, sind Verhaltensanalysen, Ratenbegrenzungen und speziell auf GenKI-Kontexte abgestimmte Erkennungsmodelle erforderlich. Techniken wie die Analyse des Nutzerverhaltens helfen, Anomalien in Nutzersitzungen zu identifizieren.

Für weiterführende Informationen verweisen Sie auf OWASP’s LLM Top 10 und auf die Hinweise von OpenAI zu Sicherheits-Best Practices.

Abschließende Gedanken

Eine moderne Sicherheitsbewertung für generative KI-Modelle muss über statische Kontrollen hinausgehen. Sie erfordert dynamischen Schutz, Echtzeit-Transparenz und kontextbezogene Richtliniendurchsetzung. Mit den richtigen Werkzeugen – von der Datenerkennung über die Maskierung bis hin zu Audit-Trails – können Organisationen den Einsatz generativer KI sicher skalieren, ohne Vertrauen oder Compliance zu opfern.

Erfahren Sie, wie die GenKI-Sicherheitsfunktionen von DataSunrise eine sichere und compliance-konforme KI-Einführung im großen Maßstab unterstützen.