Management der Sicherheitslage in KI & LLM-Umgebungen

Im Zeitalter der Generativen KI (GenAI) und großer Sprachmodelle (LLMs) sind Daten nicht nur eine Ressource, sondern ein aktiver Teilnehmer bei jeder Interaktion. Diese Modelle analysieren, speichern und reagieren auf Eingaben mit erstaunlicher Flüssigkeit, wobei sie jedoch tief in sensible, regulierte oder proprietäre Informationen verwickelt werden. Die herkömmliche Sicherheitscheckliste reicht nicht mehr aus. Stattdessen ist eine dynamische und anpassungsfähige Strategie erforderlich – und diese beginnt mit einem Fokus auf Management der Sicherheitslage in KI & LLM-Umgebungen.

Was macht die Sicherheit in KI & LLM-Umgebungen anders?

Im Gegensatz zu statischen Softwaresystemen arbeiten LLMs auf Basis von Wahrscheinlichkeiten, die aus massiven Datensätzen abgeleitet werden. Dies führt zu neuen Herausforderungen. Trainingsdaten können personenbezogene Informationen (PII) oder Geschäftsgeheimnisse enthalten. Die Ausgabe von Inferenzprozessen könnte solche Informationen versehentlich preisgeben. Böswillige Eingaben können sogar unbeabsichtigte oder schädliche Verhaltensweisen auslösen. Diese Risiken bedeuten, dass das Sicherheitsmanagement den gesamten KI-Lebenszyklus abdecken muss – von der Datenerfassung und Schulung bis hin zur Bereitstellung und Nutzerinteraktion.

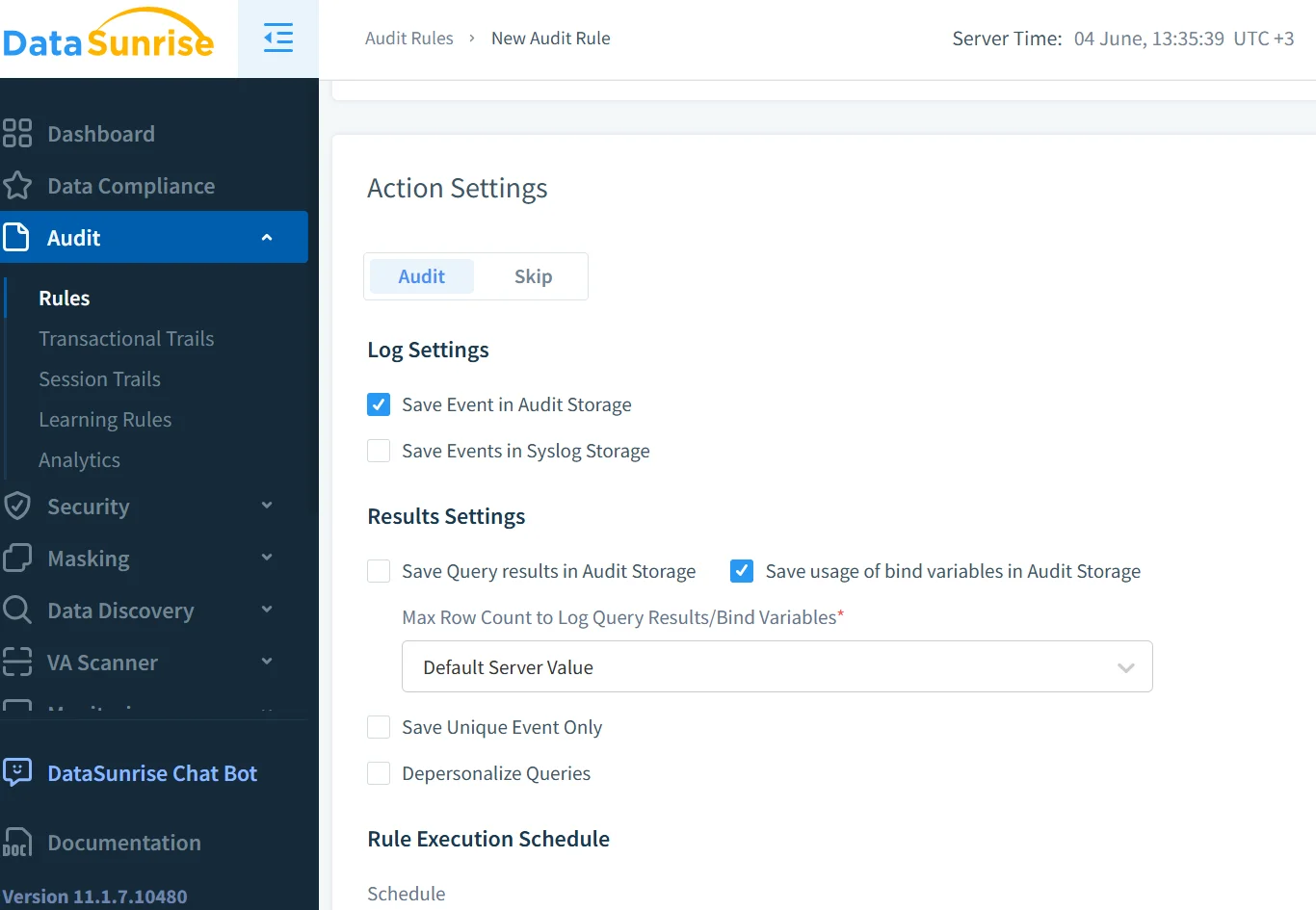

Echtzeit-Audit für LLM-Interaktionen

Audit-Protokolle bilden das Rückgrat eines jeden effektiven Sicherheitsmanagement-Frameworks. Aber in GenAI benötigen wir Echtzeit-Audit-Funktionen, die über grundlegende Operationen hinausgehen. Zum Beispiel betrachten Sie dieses SQL-ähnliche Abfragemuster, um den Zugriff auf KI-Eingaben zu protokollieren:

INSERT INTO audit_logs (user_id, prompt, timestamp, model_version)

SELECT CURRENT_USER, :prompt_text, NOW(), :model_id;

Die Kombination mit einem Echtzeit-Überwachungstool stellt sicher, dass Eingaben, Abschlüsse und sogar Einbettungen erfasst, markiert und entsprechende Maßnahmen ergriffen werden. Mithilfe der Überwachung der Datenbankaktivitäten können Sicherheitsteams benachrichtigt werden, wenn eine Eingabe sensible Datensätze berührt oder hochriskante Ergebnisse erzeugt.

Sensiblen Daten entdecken, bevor sie Ihr Modell erreichen

LLMs sind datenhungrig, aber nicht alle Daten sollten in ein Modell eingespeist werden. Hier kommt die Datenerkennung ins Spiel. Sie ermöglicht es Organisationen, sensible Inhalte zu identifizieren, zu klassifizieren und zu kennzeichnen, bevor diese jemals die Trainingspipeline erreichen. Ein verhaltensbasierter Scanner kann Klartext-Anmeldeinformationen oder gesundheitsbezogene Formulierungen markieren, wodurch problematische Daten isoliert werden.

Datenerkennungs-Tools, die in Pipelines integriert sind, helfen dabei, rollenbasierte Zugriffskontrollen durchzusetzen, sodass nur autorisierte Benutzer Datensätze freigeben können. Externe Plattformen wie AWS Macie bieten zudem eine fortschrittliche Inhaltsinspektion, um PII in großen Datenmengen zu erkennen.

Dynamische Maskierung für den Schutz auf Eingabeebene

Eine Eingabe wie “Erzählen Sie mir etwas über mein Konto” mag zunächst unbedenklich erscheinen, bis tatsächlich Kundendaten abgerufen werden. Dynamische Maskierung unterbricht diesen Prozess, indem sie sensible Werte in Echtzeit bereinigt oder ersetzt. Dadurch wird verhindert, dass vertrauliche Informationen während der Eingabe-Antwort-Zyklen durchsickern.

# Beispiel: Maskierung der Kontonummer in der Eingabe, bevor sie an das Modell gesendet wird

if "account_number" in prompt:

prompt = prompt.replace(user_account_number, "***-****-1234")

In Retrieval-Augmented Generation (RAG)-Systemen stellt dynamische Maskierung sicher, dass vektorisierte Dokumentergebnisse nicht den redigierten Inhalt wieder einführen. LangChain unterstützt zudem Richtliniendurchsetzungsschichten, um maskierte Ein- und Ausgaben zu verwalten.

Aufbau einer konformen und anpassungsfähigen Sicherheitsstrategie

Die Einhaltung von Sicherheitsvorschriften wird zunehmend zentral für den Einsatz von LLMs. Vorschriften wie die DSGVO, HIPAA und vorgeschlagene KI-Governance-Gesetze fordern klare Verantwortlichkeiten.

Ein solides Sicherheitsmanagement umfasst Audit-Trails, Echtzeitwarnungen, Maskierung in Verbindung mit Compliance-Regeln und automatisierte Berichterstattung. Der Compliance-Manager von DataSunrise erleichtert die Verfolgung von Verstößen. Ebenso bietet Googles Secure AI Framework (SAIF) Prinzipien zur Absicherung von KI-Ökosystemen.

Beispiel: Absicherung eines auf RAG basierenden internen Assistenten

Betrachten Sie einen firmeninternen LLM-Assistenten, der RAG zur Beantwortung von Personalfragen einsetzt. Eine Eingabe wie “Zeigen Sie mir die Gehaltsaufteilung für Führungskräfte” könnte eingeschränkte Informationen zutage fördern.

Um dem entgegenzuwirken:

- Echtzeitprotokolle verfolgen Anfragen und erkennen Schlüsselwörter.

- Maskierung bereinigt numerische Werte in der Antwort.

- Die Datenerkennung kennzeichnet sensible Dateien wie Gehaltsabrechnungs-Tabellen.

- Sicherheitsregeln schränken den Zugriff basierend auf der Benutzerrolle ein.

Das System wird kontextbewusst und konform, wobei sowohl Funktionalität als auch Sicherheit gewährleistet bleiben.

Die Zukunft der Sicherheitslage in GenAI

Das Management der Sicherheitslage in LLMs muss sich zusammen mit den Modellen weiterentwickeln. Es geht nicht nur darum, Zugänge mittels Firewalls zu schützen – es geht darum, KI-Systeme mit eingebauter Widerstandsfähigkeit zu gestalten. Das bedeutet, klassische Techniken wie Datenschutz mit Echtzeit-Bedrohungserkennung und Nutzerverhaltensanalysen zu kombinieren.

Mehr Werkzeuge tauchen auf, um diese Lücken zu schließen – von Microsofts Azure AI-Inhaltsfiltern bis hin zu Anthropics Constitutional AI, das ethische Beschränkungen auf Modellebene auferlegt.

Organisationen müssen GenAI nicht als Blackbox betrachten, sondern als ein lebendiges System. Überwachung, Auditing, Maskierung und Compliance müssen integraler Bestandteil des KI-Designprozesses sein.

Für weitere Einblicke, sehen Sie, wie DataSunrise über 40 Datenbankplattformen mit Sicherheitsmanagement-Tools für sowohl traditionelle als auch GenAI-Systeme unterstützt.