Sicherheitsmaßnahmen für generative KI-Systeme

Während generative KI weiterhin Branchen von Finanzen bis Gesundheitswesen prägt, wachsen auch ihre sicherheitstechnischen Implikationen in rasantem Tempo. Diese Systeme verarbeiten enorme Mengen sensibler Informationen, und wenn sie ungeschützt bleiben, können sie zu einem Einfallstor für Datenpannen, Prompt-Injection-Angriffe oder unbefugte Dateneinblicke werden. In diesem Artikel beleuchten wir die wesentlichen Sicherheitsmaßnahmen für generative KI-Systeme – mit Fokus auf Echtzeit-Audit, dynamisches Masking, Datenentdeckung und Compliance-Durchsetzung – um sicherzustellen, dass diese leistungsstarken Modelle sicher betrieben werden.

Warum generative KI spezialisierte Sicherheit benötigt

Anders als herkömmliche Anwendungen lernen generative KI-Systeme aus historischen Datensätzen und interagieren mittels offener Prompts. Sie können vertrauliche Benutzereingaben oder sensible Geschäftsdaten abrufen, um Antworten zu generieren. Dieses Interaktionsmodell birgt zwei wesentliche Risiken: unbeabsichtigte Datenlecks in den Modellergebnissen und verdeckten Zugriff auf sensible Datenbanken.

Um diese Risiken zu adressieren, müssen Sicherheitskontrollen direkt in die KI-Datenpipelines integriert werden. Dies schließt nicht nur oberflächliche Überwachung ein, sondern auch kontextbewusste Techniken wie Verhaltensanalysen, dynamisches Datenmasking und ein umfassendes Audit-Trail-Management.

Echtzeit-Auditierung von KI-Interaktionen

Echtzeit-Audit-Logs bilden das Fundament jeder KI-System-Sicherheit. Jede Interaktion – vom abgesendeten Prompt über das verwendete Modell bis hin zur abgefragten Datenquelle – sollte klar nachvollziehbar sein. Dies ermöglicht es den Sicherheitsteams, Aktivitäten zu rekonstruieren und unbefugtes Verhalten bestimmten Benutzern oder Prompt-Mustern zuzuordnen.

Werkzeuge wie DataSunrises Datenbank-Aktivitätsüberwachung ermöglichen kontinuierliche Verfolgung und können mit SIEM-Plattformen integriert werden, um bei Auffälligkeiten Warnungen auszulösen. Diese können etwa häufige Prompt-Wiederholungen, ungewöhnliche Abfrageraten oder unerwarteten Zugriff auf geschützte Spalten umfassen.

Beispiel (PostgreSQL-Stil Log-Capture-Trigger):

CREATE OR REPLACE FUNCTION log_prompt_event()

RETURNS TRIGGER AS $$

BEGIN

INSERT INTO ai_audit_log(user_id, prompt_text, access_time)

VALUES (current_user, NEW.prompt, NOW());

RETURN NEW;

END;

$$ LANGUAGE plpgsql;

Dynamisches Datenmasking in KI-Pipelines

Generative KI-Modelle, die auf Live-Datenbanken zugreifen, können unbeabsichtigt private Informationen in ihren Antworten preisgeben. Dynamisches Datenmasking verhindert dies, indem es die Ansicht auf Daten je nach Kontext verändert. So könnte ein Modell, das auf eine Finanzdatenbank zugreift, maskierte Werte wie ****-****-****-1234 zurückgeben, wenn es sich auf Kreditkartennummern bezieht, um sicherzustellen, dass der ursprüngliche Inhalt geschützt bleibt.

Dynamisches Datenmasking kann während der Ausführung von Abfragen oder in der Antwortschicht des KI-Systems angewendet werden. Microsofts Dokumentation zum DDM bietet weitere Implementierungshinweise.

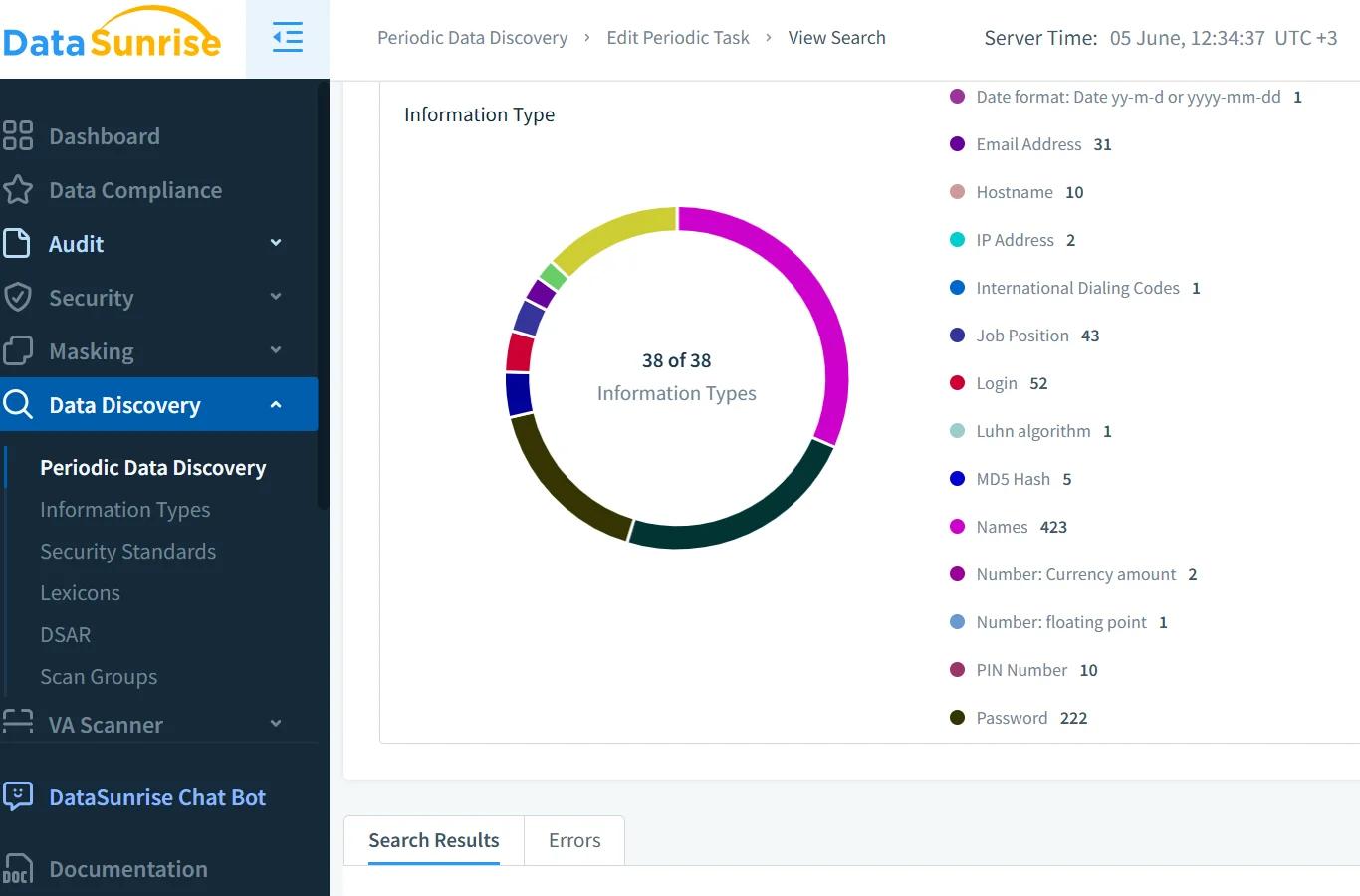

Datenentdeckung und Klassifizierung vor dem Modellzugriff

Bevor generative Modelle Zugriff auf strukturierte Daten erhalten, ist es essenziell, sensible Inhalte zu klassifizieren. Personenbezogene Daten (PII), geschützte Gesundheitsinformationen (PHI) und finanzielle Kennziffern müssen im Voraus identifiziert werden. Dies geschieht mithilfe automatisierter Datenentdeckungswerkzeuge, die Tabellen, Spalten und Dateiinhalte prüfen.

Mithilfe der DataSunrise-Discovery-Engine und cloud-nativer Plattformen wie Google Cloud DLP können Organisationen Daten systematisch taggen und entsprechende Handhabungsrichtlinien zuweisen.

Durchsetzung der Daten-Compliance in LLM-Workflows

Generative KI muss innerhalb der Grenzen regulatorischer Rahmenbedingungen wie der DSGVO, HIPAA und PCI DSS operieren. Diese Regeln legen fest, wie Daten abgerufen, maskiert, auditierbar gemacht und berichtet werden sollen.

Der DataSunrise Compliance Manager vereinfacht die Durchsetzung, indem er Zugriffsprivilegien den spezifischen Anforderungen der jeweiligen Regelungen zuordnet. Er kann zudem Berichte erstellen, die speziell für Audits zugeschnitten sind, und Verstöße in Echtzeit hervorheben. Ergänzende Ansätze aus IBMs Richtlinien für KI-Ethik stärken den Rahmen für transparente und verantwortungsbewusste KI-Operationen.

Sicherheitsregeln und Zugriffsverwaltung

Generative KI-Umgebungen profitieren von fein granulierten Sicherheitsrichtlinien. Über traditionelle RBAC hinaus muss die Sicherheit auch Intentions-Erkennung und Verhaltensprofilierung beinhalten. Ein Benutzer, der versucht, private Daten über mehrdeutige Prompts statt expliziter Abfragen zu extrahieren, könnte oberflächliche Kontrollen umgehen.

Aus diesem Grund sind erweiterte SQL-Injection-Minderungsregeln und adaptive Sicherheitsmaßnahmen von entscheidender Bedeutung. Sie ermöglichen es, Missbrauch zu erkennen, indem sie Prompt-Muster, Zugriffszeiten und Abweichungen vom normalen Nutzerverhalten analysieren.

Blick in die Zukunft: Intelligentere KI, intelligentere Sicherheit

Die Zukunft der KI-Sicherheit liegt in der Kontextsensitivität. Vektor-Datenbanken, Plugins von Drittanbietern und Streaming-Daten-Schnittstellen eröffnen neue Risikoflächen. Um diese zu mindern, setzen Organisationen zunehmend auf die Erkennung von Verhaltensanomalien, Echtzeitwarnungen und mehrschichtige Ausgabe-Filterung.

Ressourcen wie Microsofts Responsible AI Dashboard und OpenAIs Systemcard-Methodologie helfen Teams, Modellzugriffsmuster zu kartieren. Plattformen wie DataSunrise unterstützen die Durchsetzung von Richtlinien und das Auditing als Teil eines umfassenderen Sicherheitsstapels.

Schlussfolgerung

Der Aufstieg von LLMs hat das Verständnis dessen, wie eine sichere Infrastruktur aussehen muss, neu definiert. Starke Audit-Trails, dynamisches Masking, die Entdeckung sensibler Daten und Echtzeit-Compliance sind nun essenziell – nicht optional.

Durch den Einsatz dieser Sicherheitsmaßnahmen für generative KI-Systeme legen Sie das Fundament für verantwortungsvolle KI und reduzieren das Risiko von Reputations- oder Rechtsfolgen.

Erkunden Sie das DataSunrise Knowledge Center und ergänzen Sie Ihre Sicherheitsstrategie mit Rahmenwerken wie NIST AI RMF, ISO/IEC 23894 oder OECD’s KI-Prinzipien.