Sicherheitsrisiken bei generativen KI-Arbeitslasten

Generative AI (GenKI) Arbeitslasten haben neu definiert, wie Unternehmen mit Daten interagieren. Von der Inhaltserstellung bis hin zu automatisierten Entscheidungsprozessen erzeugen diese Modelle enormen Mehrwert – bringen jedoch auch einzigartige Sicherheitsrisiken mit sich. Da die Einführung von GenKI in allen Branchen zunimmt, wird es unerlässlich, zu verstehen, wie diese Arbeitslasten gesichert werden können. Für einen Überblick über aufkommende Bedrohungen in GenKI verweisen Sie auf MITRE’s Generative KI Sicherheitsrahmenwerk.

Warum GenKI-Arbeitslasten von Natur aus risikoreich sind

Im Gegensatz zu traditionellen KI-Modellen, die mit statischen Eingaben arbeiten, interagieren GenKI-Modelle mit dynamischen, oft sensiblen Daten. Diese Modelle können Trainingsdaten einprägen, auf natürliche Sprachbefehle reagieren und synthetische Ausgaben generieren, die versehentlich regulierte oder proprietäre Informationen offenlegen können.

Die inhärenten Risiken beinhalten:

| Risikokategorie | Beschreibung |

|---|---|

| Leckage sensibler Daten | GenKI-Modelle können vertrauliche Trainingsdaten einprägen und reproduzieren. |

| Offenlegung personenbezogener Daten | Persönlich identifizierbare Informationen (PII) könnten in den Modelloutputs erscheinen. |

| Prompt-Injektion | Böswillige Benutzer könnten Eingabeaufforderungen so gestalten, dass sie die Sicherheitsanweisungen des Modells überschreiben. |

| Ausnutzung über Modelloutputs | Angreifer können das Modell dazu bringen, interne oder geschützte Daten preiszugeben. |

Diese Angriffsvektoren erfordern fortschrittliche Sicherheitsvorkehrungen, die über den herkömmlichen API-Schutz hinausgehen. Die Komplexität steigt weiter, wenn große Sprachmodelle (LLMs) über benutzerorientierte Schnittstellen bereitgestellt oder mit internen Systemen mit Echtzeit-Datenzugriff verknüpft werden.

Echtzeit-Audit für Modellinteraktionen

Um Missbrauch oder Anomalien in GenKI-Interaktionen zu erkennen, ist ein Echtzeit-Audit entscheidend. Traditionelles Logging kann das „Was“ erfassen, aber Echtzeit-Auditsysteme fangen das „Warum“ und „Wie“ hinter der Anfrage ein. Siehe auch Google Clouds Leitfaden zum Sichern von KI-Arbeitslasten mittels Audit-Logging.

Beispiel: Angenommen, ein Benutzer sendet eine Eingabeaufforderung wie:

SELECT user_id, endpoint, timestamp

FROM api_logs

WHERE endpoint LIKE '%admin%' AND response_code = 200;

In einem von GenKI unterstützten Assistenten, der in Ihre Datenbank eingebunden ist, könnte dies betriebliches Verhalten offenbaren, sofern Logging und regelbasiertes Alerting nicht vorhanden sind.

Plattformen wie DataSunrise Audit Logs bieten Echtzeit-Benachrichtigungen und detaillierte Einblicke in das Benutzerverhalten, die es den Sicherheitsteams ermöglichen, Zugriffsmuster nachzuvollziehen und Anomalien zu erkennen, bevor Schaden entsteht.

Dynamisches Masking: Leitplanken bei Live-Interaktionen

Dynamisches Masking ist entscheidend, wenn GenKI-Tools Antworten auf Basis von Live-Daten generieren. Indem Anfragen und Antworten abgefangen werden, können Sie sensible Felder schwärzen oder verbergen, bevor sie das Modell oder den Endbenutzer erreichen.

-- Originalwert: 1234-5678-9012-3456

-- Maskierte Ausgabe: XXXX-XXXX-XXXX-3456

Dies erfüllt nicht nur die Datenschutzanforderungen, sondern verhindert auch, dass die KI Muster, die mit sensiblen Identitäten verknüpft sind, „lernt“.

Erfahren Sie mehr über dynamisches Datenmasking und seine Rolle im Datenschutz für GenKI-Arbeitslasten.

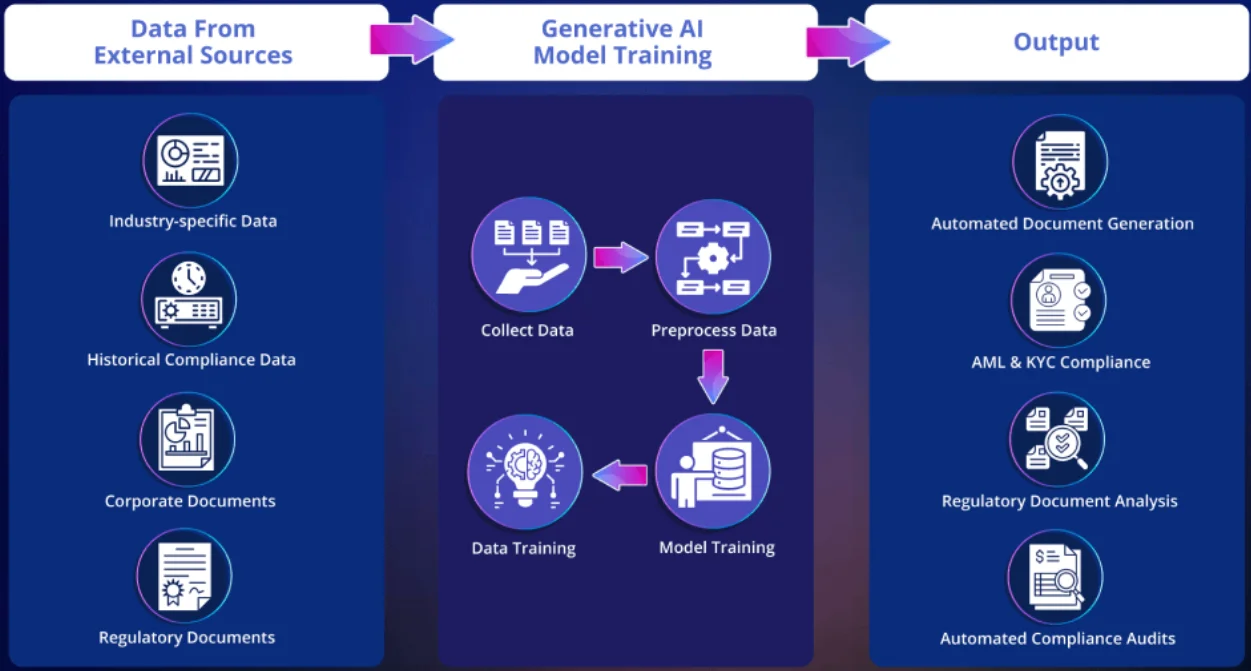

Datenentdeckung vor der Implementierung

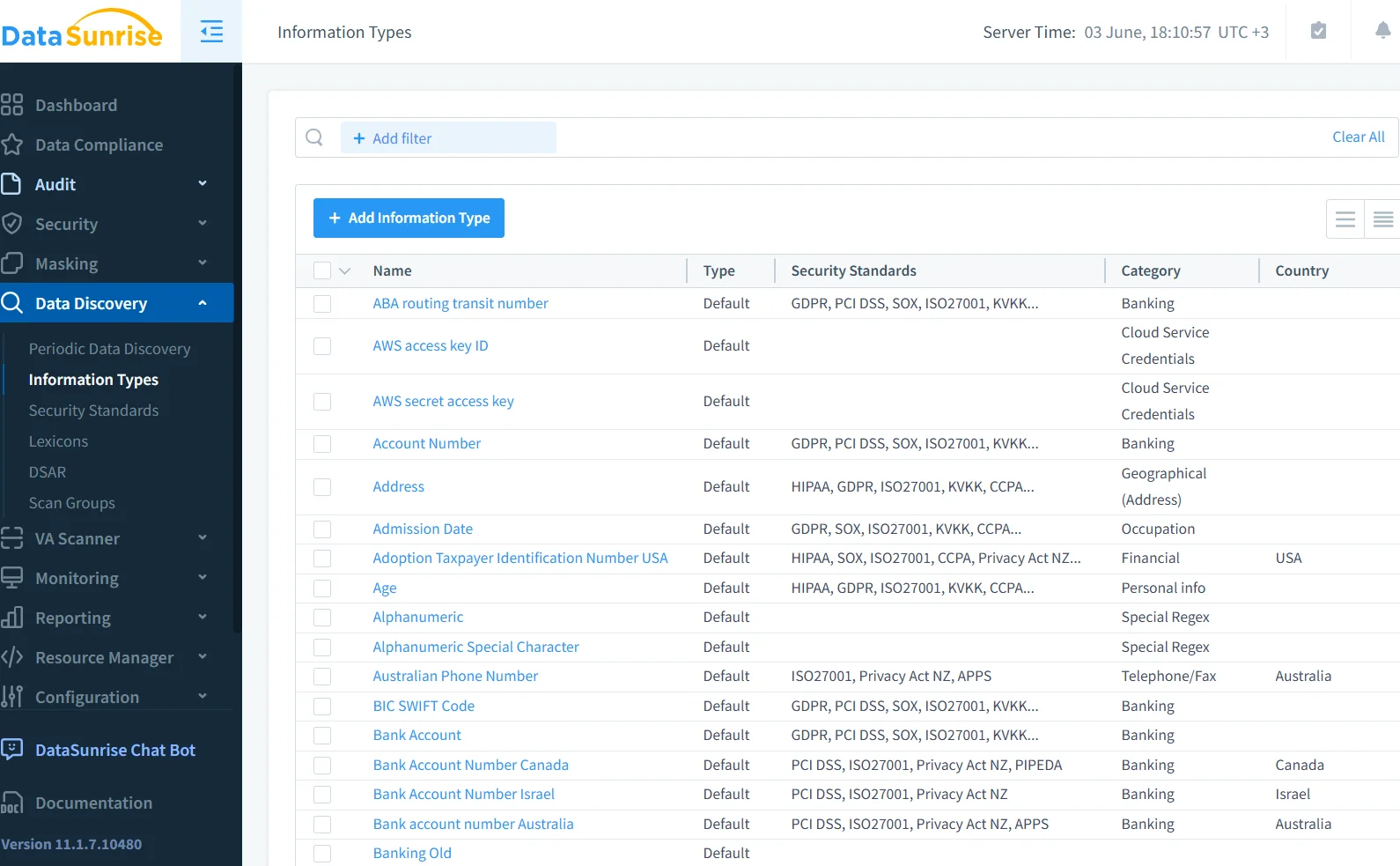

GenKI-Modelle werden häufig auf großen, föderierten Datensätzen trainiert. Ohne zu wissen, was enthalten ist, agieren Sie im Dunkeln. Mit Hilfe von Datenentdeckungstools können Sicherheitsteams Datenbanken, Data Lakes und Dateisysteme scannen, um regulierte Daten zu klassifizieren, bevor diese LLMs ausgesetzt werden. Dies ist besonders wichtig, wenn benutzerdefinierte GenKI-Modelle mit Unternehmensdokumenten oder Kundenverläufen trainiert werden. Für zusätzlichen Kontext bietet IBM einen Leitfaden zur automatisierten Datenklassifizierung und -entdeckung für KI.

-- Beispielregel in der Discovery-Engine

IF column_name LIKE '%ssn%' OR column_name LIKE '%dob%' THEN classify AS 'PII'

Diese Metadaten ermöglichen richtlinienbasiertes Masking und Echtzeitwarnungen, wenn GenKI-Interaktionen auf markierte Datentypen zugreifen.

Compliance & Governance: Wo KI auf Regulierung trifft

Sicherheit für GenKI geht nicht nur darum, technische Exploits zu verhindern – es geht darum, die Einhaltung von Rahmenwerken wie GDPR, HIPAA und PCI DSS sicherzustellen. Diese Rahmenwerke erfordern:

- Datenminimierung

- Zugriffsprotokollierung

- Einwilligung der Nutzer für die Verarbeitung

Die Nichtimplementierung von Kontrollen kann zu rechtlichen Konsequenzen führen, insbesondere wenn KI-generierte Outputs geschützte Daten reproduzieren.

Rollenbasierte Zugriffssteuerung (RBAC) und Audit-Trails helfen dabei, Compliance-Bemühungen zu dokumentieren und im Falle einer Untersuchung die Absicht nachzuweisen.

Code Injection & Prompt Hacking

Prompt-Injektion ist ein zunehmender Bedrohungsvektor in GenKI-Systemen. Angreifer können schädliche Anweisungen in scheinbar harmlose Eingabeaufforderungen einbetten, wodurch das Modell dazu veranlasst wird, sensible Daten preiszugeben oder voreingestellte Schutzmaßnahmen zu umgehen. Die OWASP Foundation hat eine Top-10-Liste für LLM-Anwendungsrisiken veröffentlicht, zu der auch Prompt-Injektionsvektoren gehören.

Die Kombination von Audit-Regelsätzen mit Pipelines zur Eingabe-Säuberung ist ein effektiver Weg, um solche Angriffe zu mindern.

Ein praktisches Beispiel: Verwendung von SQL-Audit & Masking in LLM-gestützten Systemen

Wenn dies über ein SQL-Generierungsmodul geleitet wird, könnte das Backend eine Abfrage generieren wie:

-- Audit überfälliger Salden

SELECT customer_name, balance_due FROM billing WHERE status = 'overdue';

Ohne Maskierung könnten finanzielle Felder im Klartext angezeigt werden. Mit Maskierungsrichtlinien werden sensible Beträge teilweise geschwärzt.

Um nachzuvollziehen, wer wann auf was zugegriffen hat, protokolliert die Database Activity Monitoring die Interaktion und verknüpft sie mit einer Benutzersitzung oder einem API-Schlüssel.

Shift Left: Sicheres GenKI durch Design

Viele Sicherheitslücken in GenKI-Arbeitslasten entstehen, weil Teams sich auf die Modellleistung und nicht auf das Systemdesign konzentrieren. Durch ein “Shift Left” – das frühzeitige Anwenden von Sicherheitskontrollen im Lebenszyklus – kann Governance in jede Komponente integriert werden:

- Datenaufnahme: Scannen und Kennzeichnen sensibler Eingaben

- Modellanpassung: Beschränkung der Exposition gegenüber sensiblen Korpora

- Serving-Stack: Anwendung von Inline-Maskierung und Zugriffskontrollen

- Ausgabeschicht: Säuberung und Auditierung der Modellantworten

Dieser Ansatz stimmt mit modernen DevSecOps- und data-inspired security-Praktiken überein, die sowohl Transparenz als auch Schutz verbessern.

Fazit: Ein neues Sicherheitsparadigma für KI

Der Aufstieg von GenKI führt eine völlig neue Risikokategorie ein, mit der herkömmliche Sicherheitsmodelle nicht umgehen können. Doch durch die Kombination von Echtzeit-Audit, dynamischer Maskierung, Datenentdeckung und richtliniengetriebener Governance ist es möglich, sichere und konforme GenKI-Systeme aufzubauen, ohne Innovationen zu opfern. Erfahren Sie, wie NIST das KI-Risikomanagement in ihrem AI RMF 1.0 angeht.

Für einen tieferen Einblick, wie Tools wie DataSunrise dabei helfen können, diese Transformation zu bewirken, entdecken Sie deren Audit-Leitfäden, Datenmaskierung und Datenbank-Firewall-Funktionen.