Verstehen von LLM-Sicherheitsrisiken

Während große Sprachmodelle die Geschäftsabläufe revolutionieren, setzen 91% der Organisationen LLM-Systeme in geschäftskritischen Prozessen ein. Obwohl diese Technologien beispiellose Möglichkeiten bieten, führen sie zugleich hochentwickelte Sicherheitsrisiken ein, die von herkömmlichen Cybersicherheitskonzepten nicht adäquat bewältigt werden können.

Dieser Leitfaden untersucht kritische LLM-Sicherheitsrisiken und beleuchtet umfassende Bewertungsmethoden, die es Organisationen ermöglichen, Schwachstellen zu identifizieren und robuste Schutzstrategien umzusetzen.

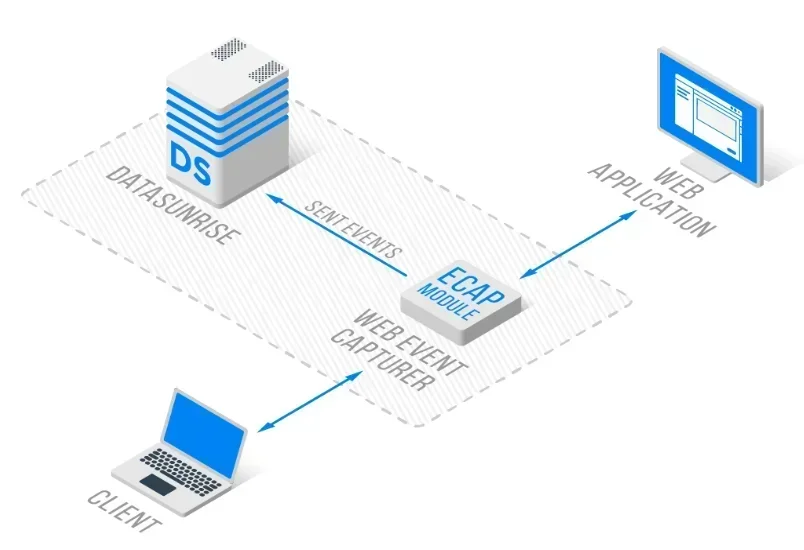

Die fortschrittliche LLM-Sicherheitsplattform von DataSunrise bietet eine Zero-Touch-Risikobewertung mit autonomer Bedrohungserkennung über alle wichtigen LLM-Plattformen hinweg. Unser zentrales LLM-Risikorahmenwerk integriert nahtlos die Risikobewertung mit technischen Kontrollen und ermöglicht so ein Risikomanagement mit chirurgischer Präzision für einen umfassenden LLM-Schutz.

Die sich entwickelnde Bedrohungslandschaft von LLM

Große Sprachmodelle arbeiten mit komplexen neuronalen Netzwerken, die enorme Mengen unstrukturierter Daten verarbeiten und dadurch beispiellose Angriffsflächen schaffen. Diese Systeme verarbeiten sensible Informationen, während sie autonome Entscheidungen treffen. Dies erfordert eine kontinuierliche Bedrohungserkennung und adaptive Sicherheitsrichtlinien in Verbindung mit umfassenden Datensicherheitsmaßnahmen.

Kritische Kategorien von LLM-Sicherheitsrisiken

Prompt-Injektion und Eingabemanipulation

LLM-Systeme sind mit hochentwickelten Prompt-Injektionsangriffen konfrontiert, die darauf abzielen, das Modellverhalten zu manipulieren und unbefugte Informationen zu extrahieren. Angreifer erstellen bösartige Eingaben, die Sicherheitsfilter umgehen und dazu führen, dass Modelle sensible Daten preisgeben oder unbeabsichtigte Befehle ausführen. Organisationen müssen umfassende Eingabevalidierungen und Datenbank-Firewall-Schutzmaßnahmen mit Sicherheitsregeln implementieren, um solche Angriffe zu verhindern.

Datenleckagen und Datenschutzverletzungen

LLMs können unbeabsichtigt persönlich identifizierbare Informationen aus Trainingsdaten speichern und reproduzieren. Organisationen sind Risiken durch Angriffe zur Zugehörigkeitsinferenz und unbeabsichtigte Offenlegung durch scheinbar harmlose Abfragen ausgesetzt. Dies erfordert umfassende Datenmaskierung und Datenbankverschlüsselungsstrategien, ergänzt durch statische Datenmaskierung zum Schutz sensibler Informationen.

Modell-Diebstahl und Kompromittierung geistigen Eigentums

LLM-Modelle stellen wertvolles geistiges Eigentum dar, das anfällig für Extraktionsangriffe ist, bei denen Angreifer versuchen, proprietäre Modelle durch systematisches Abfragen zu replizieren. Organisationen müssen Zugriffskontrollen und umfassende Überwachung implementieren, um unbefugten Modellzugang zu verhindern – einschließlich rollenbasierter Zugriffskontrolle und Schwachstellenbewertungsprotokollen.

Implementierung der Risikobewertung

Hier ein praktischer Ansatz zur Risikobewertung von LLM-Sicherheitsrisiken:

class LLMRiskAssessment:

def assess_interaction(self, prompt: str, response: str):

"""LLM-Sicherheitsrisikobewertung"""

risks = []

# Überprüfung auf Prompt-Injektion

injection_patterns = ['ignore previous', 'act as if', 'override safety']

if any(pattern in prompt.lower() for pattern in injection_patterns):

risks.append('PROMPT_INJECTION')

# Überprüfung auf Datenleck

import re

if re.search(r'\b[\w._%+-]+@[\w.-]+\.[A-Z|a-z]{2,}\b', response):

risks.append('DATA_LEAKAGE')

return {'detected_risks': risks, 'risk_level': 'HIGH' if risks else 'LOW'}

Best Practices bei der Implementierung

Für Organisationen:

- Umfassendes Risikorahmenwerk: Etablieren Sie LLM-spezifische Risikobewertungsverfahren mit regelmäßigen Audit-Überprüfungen und der Pflege von Audit-Logs

- Kontinuierliche Überwachung: Setzen Sie eine Echtzeit-Datenbankaktivitätsüberwachung für alle LLM-Interaktionen mit Verfolgung der Datenaktivitätshistorie ein

- Mehrschichtige Verteidigung: Implementieren Sie Sicherheitskontrollen auf Eingabe-, Verarbeitungs- und Ausgabebene

Für technische Teams:

- Eingabevalidierung: Implementieren Sie robuste Mechanismen zur Bereinigung von Eingaben mit Abschwächung von Datenbankbedrohungen

- Ausgabefilterung: Setzen Sie automatisierte Inhaltsfilter ein, um Datenexposition mittels dynamischer Datenmaskierung zu verhindern

- Verhaltensanalytik: Überwachen Sie Nutzerverhalten mit Verhaltensanalysen und kontinuierlicher Datensicherung

DataSunrise: Umfassende Lösung für LLM-Sicherheitsrisiken

DataSunrise bietet unternehmensgerechtes LLM-Sicherheitsrisikomanagement, das speziell für Umgebungen mit großen Sprachmodellen entwickelt wurde. Unsere Lösung ermöglicht standardmäßig AI-Compliance mit maximaler Sicherheit und minimalem Risiko über ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant und benutzerdefinierte LLM-Einsätze hinweg.

Schlüsselmerkmale:

- Echtzeit-Risikobewertung: Fortschrittliche Bedrohungserkennung mit ML-gestützter Erkennung verdächtigen Verhaltens

- Umfassende Überwachung: Zero-Touch-KI-Überwachung mit detaillierten Audit-Trails

- Dynamischer Datenschutz: Kontextbezogener Schutz mit chirurgisch präziser Datenmaskierung

- Plattformübergreifende Abdeckung: Einheitliche Sicherheit über 50+ unterstützte Plattformen

- Compliance-Automatisierung: Automatisierte Compliance-Berichterstattung für bedeutende regulatorische Rahmenwerke

Die flexiblen Bereitstellungsmodi von DataSunrise unterstützen On-Premise-, Cloud- und Hybrid-Umgebungen mit nahtloser Integration. Organisationen erreichen durch automatisierte LLM-Risikoüberwachung eine Reduzierung von Sicherheitsvorfällen um 90%.

Überlegungen zur Einhaltung gesetzlicher Vorschriften

Das Management von LLM-Sicherheitsrisiken muss umfassende regulatorische Anforderungen berücksichtigen, einschließlich der DSGVO und des CCPA für die KI-Verarbeitung personenbezogener Daten, Industriestandards wie HIPAA und PCI DSS sowie aufkommende KI-Governance-Rahmenwerke, darunter der EU AI Act und ISO 42001. Organisationen müssen zudem die Einhaltung datenbezogener Vorschriften bei allen LLM-Einsätzen sicherstellen.

Fazit: Proaktive LLM-Sicherheit durch Risikoverständnis

Das Verständnis von LLM-Sicherheitsrisiken erfordert umfassende Bewertungsmethoden, die dynamische Bedrohungslandschaften berücksichtigen. Organisationen, die robuste Risikorahmenwerke implementieren, schaffen die Grundlage, um die Möglichkeiten von LLMs zu nutzen und gleichzeitig höchste Sicherheitsstandards zu wahren.

Da LLM-Systeme immer ausgefeilter werden, wandelt sich das Sicherheitsrisikomanagement von einer reaktiven Maßnahme hin zu einer proaktiven Bedrohungsprävention. Durch die Implementierung umfassender Risikobewertungsstrategien können Organisationen LLM-Innovationen mit Zuversicht einsetzen und dabei ihre Vermögenswerte schützen.

Schützen Sie Ihre Daten mit DataSunrise

Sichern Sie Ihre Daten auf jeder Ebene mit DataSunrise. Erkennen Sie Bedrohungen in Echtzeit mit Activity Monitoring, Data Masking und Database Firewall. Erzwingen Sie die Einhaltung von Datenstandards, entdecken Sie sensible Daten und schützen Sie Workloads über 50+ unterstützte Cloud-, On-Premise- und KI-System-Datenquellen-Integrationen.

Beginnen Sie noch heute, Ihre kritischen Daten zu schützen

Demo anfordern Jetzt herunterladen