Wie Generative KI die Sicherheitspraktiken beeinflusst

Generative KI (GenKI) transformiert, wie Organisationen Software entwickeln, Daten verwalten und Nutzer bedienen. Doch mit dieser Innovation kommt auch ein Risiko. Während GenKI-Tools Text, Code, Bilder und Entscheidungen generieren, schaffen sie auch neue Angriffspunkte. Das Verständnis, wie generative KI die Sicherheitspraktiken beeinflusst, ist entscheidend für jede Organisation, die mit sensiblen oder regulierten Daten arbeitet.

Ein neuer Angriffsvektor: Sprache als Bedrohungsfläche

Traditionelle Sicherheitsansätze gehen von vorhersehbaren Eingaben aus. GenKI durchbricht diese Annahme. Durch die Verarbeitung von menschlichen Eingabeaufforderungen öffnen LLMs (Large Language Models) die Tür für Prompt-Injektion, Datenausspähung und versehentliche Lecks. Ein Modell, das mit proprietären Daten trainiert wurde, könnte – wenn es richtig angestoßen wird – diese regenerieren und offenlegen.

Im Gegensatz zu herkömmlichen Abfragen können GenKI-Prompts unbeabsichtigte Operationen auslösen. Angreifer können Prompts manipulieren, um Privilegien zu eskalieren oder sensible Trainingsinhalte abzurufen. Diese Herausforderungen erfordern einen Wandel in der Durchsetzung von Sicherheitsrichtlinien – insbesondere für Systeme, die mit LLM-APIs integriert sind.

Eine ausführliche Analyse von Prompt-Injektionsangriffen wurde in diesem Artikel von OWASP dargelegt, der die Herausforderung beleuchtet, das Verhalten eines Modells bei unvorhersehbaren Eingaben zu kontrollieren.

Echtzeit-Audit für KI-Systeme

Alte Auditprotokolle erfassen nicht die Feinheiten von GenKI-Prompts. Es reicht nicht mehr aus, lediglich „Abfrage ausgeführt“ zu protokollieren – wir müssen den vollständigen Prompt, das Ergebnis und nachgelagerte Aktionen erfassen.

Moderne Tools wie Echtzeit-Audit-Systeme für GenKI-integrierte Umgebungen protokollieren jede Anfrage, einschließlich Eingabeaufforderungen, Kontext und Antworten. Dies verbessert die Transparenz, unterstützt forensische Untersuchungen und hilft dabei, subtile Missbräuche wie Prompt Engineering-Angriffe zu erkennen.

Plattformen wie DataSunrise Audit Logs entwickeln sich weiter, um diese speziellen Arbeitslasten zu bewältigen, wodurch Teams in die Lage versetzt werden, KI-gesteuerte Aktivitäten mit vollem Kontext zu überwachen.

Dynamische Maskierung zur Generierungszeit

Wenn LLMs Ausgaben generieren, könnten sie persönliche oder sensible Informationen enthalten – insbesondere wenn das Modell auf internen Datensätzen feinabgestimmt wurde. Hier wird dynamische Maskierung unerlässlich.

Anstatt nur die Eingabedaten zu maskieren, erfordert GenKI eine Maskierung auf Ausgabeebene. Es schwärzt Inhalte in Echtzeit ab und filtert PII oder regulierte Begriffe dynamisch. Im Gegensatz zu statischen Methoden passt sich die dynamische Maskierung unvorhersehbaren Ausgaben an und setzt Richtlinien in unterschiedlichen Benutzerkontexten durch.

SELECT genai_response

FROM model_output

WHERE user_id = CURRENT_USER()

AND mask_sensitive(genai_response) = TRUE;

Eine umfassendere Perspektive zu diesem Thema bietet der Bericht von Google DeepMind zur Sicherheit von LLMs, welcher erörtert, wie die Sicherheit der Antwort von einer Echtzeit-Inhaltsfilterung abhängt.

Verborgene Datenrisiken entdecken

Viele GenKI-Systeme werden mit unklassifizierten oder schlecht gekennzeichneten Datensätzen trainiert. Dies führt dazu, dass sensible Daten durch scheinbar harmlose Abfragen versehentlich offengelegt werden.

Tools zur Datenerkennung helfen dabei, Inhalte in Trainingsdaten, Vektorspeichern und Prompt-Historien zu klassifizieren. Sie identifizieren PII in Embeddings, markieren Geschäftsgeheimnisse, die im Kontextspeicher abgelegt sind, und machen nicht konforme Datensätze sichtbar, die GenKI-Workflows antreiben.

Diese Erkennungsschicht hilft dabei, Daten-Compliance-Vorschriften wie GDPR, HIPAA und PCI-DSS durchzusetzen – besonders wenn das Modell mit Live-Daten nachtrainiert wird. Für praktische Anleitungen beschreibt das AI Risk Management Framework des NIST bewährte Verfahren zur Datenklassifizierung und Bestandsaufnahme.

Sicherheit neu erfunden für prompt-getriebene Workflows

Sicherheitskontrollen müssen berücksichtigen, wie sich GenKI verhält. Anstelle statischer Rollen und Berechtigungen umfasst die Durchsetzung nun auch die Überwachung von Prompts, die Filterung von Ausgaben und RBAC für KI-Eingaben.

Musterbasierte SQL-Injektionserkennung spielt ebenfalls eine Rolle beim Aufspüren von Versuchen, Einschränkungen durch kreative Abfragen zu umgehen. Ein Benutzer mit Nur-Lese-Rechten sollte nicht in der Lage sein, Prompts zu erstellen, die maskierte oder geschwärzte Daten abrufen.

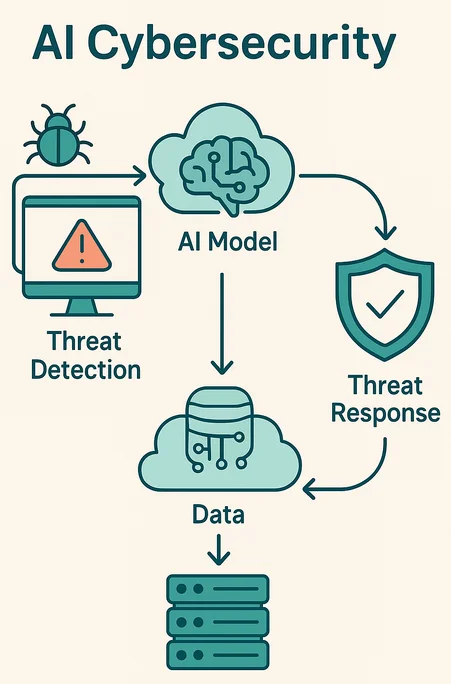

Echtzeit-Bedrohungserkennung kann ungewöhnliches Prompt-Verhalten feststellen – wie wiederholte Versuche, einen Namen zu extrahieren oder strukturierte Datensätze rekonstruiert werden sollen.

Compliance in der Geschwindigkeit der Generierung

Compliance war früher reaktiv: Protokolle scannen, Audits durchführen, Berichte versenden. GenKI zwingt Compliance-Teams dazu, in Echtzeit zu handeln. Da LLMs Antworten in Millisekunden generieren, muss die Durchsetzung von Richtlinien ebenso schnell erfolgen.

Automatisierte Compliance-Management-Lösungen gleichen Prompts mit Richtlinien ab, blockieren Ausgaben, wenn nötig, und lösen in Echtzeit Warnmeldungen über Tools wie MS Teams oder Slack aus.

Dies geht nicht nur darum, Strafen zu vermeiden. Es geht um Vertrauen. Wenn ein KI-Modell Patienteninformationen oder finanzielle Historien preisgibt, ist der Schaden unmittelbar und unwiderruflich. Die Lösung besteht darin, Verstöße zu verhindern, bevor die Ausgabe das System verlässt.

Beispiel: Blockierung von Prompts durch Richtlinieneinhaltung

Hier ein vereinfachtes Beispiel eines Prompt-Filters in Pseudocode:

if contains_sensitive_terms(prompt) or violates_compliance(prompt):

reject(prompt)

alert("Compliance rule triggered")

else:

forward(prompt)

Solche Regeln können in Sicherheitsrichtlinien integriert werden, um die Generierung auf Modell- oder Middleware-Ebene zu blockieren.

Ausblick: KI-native Sicherheitsmodelle

Zukünftige Sicherheitsplattformen werden GenKI als erstklassiges Bedrohungsmodell behandeln. Sie werden neue Kontrollen wie Prompt-Firewalls, semantisch bewusste DLP und KI-native SIEM-Integration einführen. Einige Plattformen werden kontinuierliche Maskierungsrichtlinien verwenden, die durch Verstärkungslernen gesteuert werden.

Um voraus zu bleiben, müssen Sicherheitsteams GenKI-Systeme als wahrscheinlichkeitsbasierte Agenten behandeln, nicht als vertrauenswürdige Werkzeuge. Das bedeutet, jede Interaktion zu überwachen, durchzusetzen und zu begrenzen.

Durch die Integration von Echtzeit-Audit, dynamischer Maskierung, Datenerkennung und KI-bewusster Compliance können Unternehmen GenKI nutzen, ohne die Datenintegrität zu gefährden. Denn wie generative KI die Sicherheitspraktiken beeinflusst ist nicht nur ein Trend – es ist die neue Basislinie für digitale Verteidigung.