Privacidad de Datos en IA Explicada

Introducción

Los sistemas de IA generativa como ChatGPT, Azure OpenAI y Qdrant están transformando industrias, desde la automatización del servicio al cliente hasta la aceleración de flujos de trabajo creativos. Pero con gran poder viene una gran responsabilidad: ¿cómo pueden las empresas asegurarse de que los datos sensibles no se filtren a través de estos sistemas? En esta guía, desglosamos los riesgos, las soluciones y las herramientas para salvaguardar sus datos en la era de la IA.

Los Riesgos Ocultos de la IA Generativa

Los modelos de IA generativa procesan grandes cantidades de datos, incluida información sensible. Aquí es donde las cosas pueden salir mal:

1. Fugas de Datos Aleatorias

Los modelos de IA pueden, de forma involuntaria, “recordar” y regurgitar datos sensibles de sus conjuntos de entrenamiento. Por ejemplo:

- Un chatbot de salud podría revelar registros de pacientes.

- Un asistente de codificación podría exponer algoritmos propietarios.

Este riesgo se intensifica cuando los modelos se ajustan con conjuntos de datos internos. Sin las salvaguardas adecuadas, incluso consultas inocuas podrían desencadenar revelaciones no deseadas.

2. Abuso del Modelo e Inyección de Prompts

Los atacantes pueden manipular los sistemas de IA para que revelen secretos:

- Atentados “DAN” (Do Anything Now): Saltarse las barreras éticas para extraer datos confidenciales.

- Infracción de derechos de autor: Generar código propietario o texto con derechos de autor.

- Extracción de datos: Engañar a los modelos para que divulguen fragmentos de datos de entrenamiento.

3. Salidas Dañinas por un Mal Ajuste Fino

Los modelos ajustados sin controles de seguridad pueden producir salidas sesgadas, poco éticas o que incumplen normativas. Por ejemplo:

- Generación de recomendaciones de contratación discriminatorias.

- Fuga de Información Personalmente Identificable (PII).

Cómo Interactúan las Bases de Datos con los Riesgos de Privacidad en la IA

La IA generativa no opera de forma aislada: depende de las bases de datos para los datos de entrenamiento, consultas en tiempo real y almacenamiento de salidas. Las vulnerabilidades comunes incluyen:

| Riesgo en la Base de Datos | Impacto en la IA |

|---|---|

| PII sin enmascarar en los datos de entrenamiento | Los modelos de IA aprenden y replican información sensible |

| Controles de acceso deficientes | Usuarios no autorizados explotan las API de IA |

| Transacciones sin auditoría | Sin visibilidad de lo generado por la IA |

Por ejemplo, si una IA de servicio al cliente extrae datos de una base de datos SQL con poca seguridad, los atacantes podrían utilizarla como una puerta trasera para extraer registros sensibles.

Mitigando los Riesgos de Privacidad en la IA: Un Marco de Trabajo en 3 Pasos

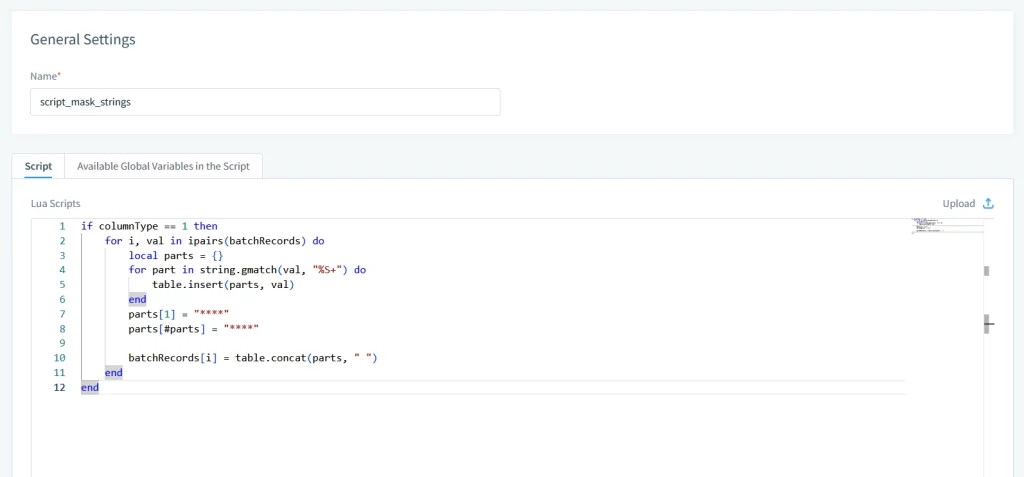

1. Sanitización de Entradas y Enmascaramiento de Datos

Antes de que los datos lleguen a los modelos de IA, sanitice las entradas utilizando:

- Enmascaramiento estático y dinámico: Reemplace los valores sensibles con datos realistas pero ficticios.

- Controles de Acceso Basados en Roles (RBAC): Restringa qué campos de datos pueden acceder los sistemas de IA.

2. Validación de Salida y Registros de Auditoría

Monitoree y registre cada interacción con la IA:

- Filtros Regex: Bloquee salidas que contengan números de tarjetas de crédito o correos electrónicos.

- Registros de auditoría: Rastrear quién usó la IA, lo que preguntaron y lo que se generó.

3. Ajuste Fino con Barreras de Seguridad

Al personalizar modelos, incorpore controles de seguridad:

- Detección de sesgos: Señale el lenguaje discriminatorio.

- Alineación de cumplimiento: Asegúrese de que las salidas cumplan con el GDPR o la HIPAA.

DataSunrise: Protegiendo la IA Generativa en Cada Capa

Nuestra plataforma ofrece una seguridad unificada tanto para bases de datos tradicionales como para sistemas modernos de IA. Así es como protegemos sus datos:

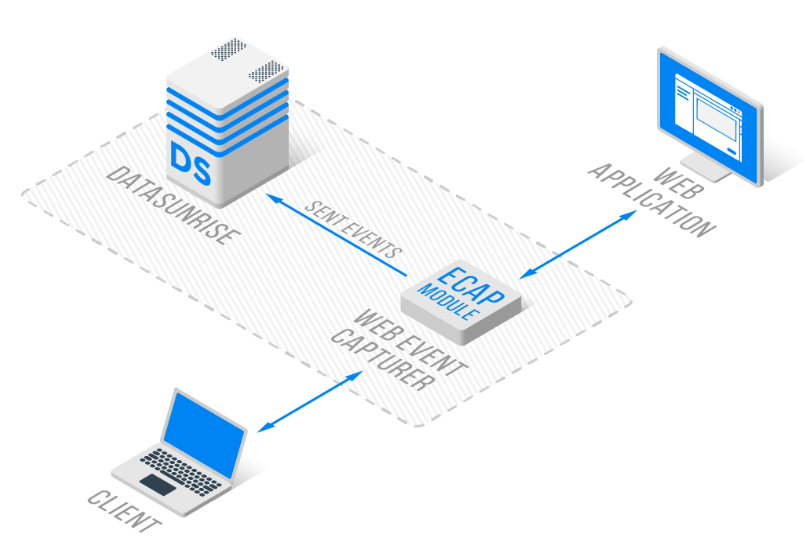

1. Auditoría y Monitoreo Específicos para la IA

- Registros transaccionales: Captura cada interacción con ChatGPT o Azure OpenAI en registros estandarizados.

- Alertas en tiempo real: Reciba notificaciones ante prompts sospechosos o fugas de PII utilizando el Monitoreo de Actividad de Bases de Datos.

2. Enmascaramiento de Datos para el Entrenamiento de la IA

- Enmascaramiento in situ: Anonimice los conjuntos de datos de entrenamiento sin moverlos.

- Redacción dinámica: Elimine datos sensibles de consultas de IA en vivo.

3. Automatización de Cumplimiento

- Plantillas preconstruidas para GDPR, HIPAA y PCI DSS.

- Informes de cumplimiento automatizado.

4. Soporte Multiplataforma

- Bases de Datos: MySQL, PostgreSQL, Neo4j, Cassandra y más de 40 adicionales.

- IA Generativa: ChatGPT, Qdrant y Azure OpenAI

Por Qué las Herramientas de Seguridad Tradicionales No Son Suficientes

Las herramientas de bases de datos heredadas carecen de características específicas para la IA:

| Capacidad | Herramientas Tradicionales | DataSunrise |

|---|---|---|

| Auditoría de prompts en IA | ❌ No | ✅ Sí |

| Enmascaramiento dinámico de datos | Básico | Avanzado (regex + NLP) |

| Cobertura multiplataforma | Limitada | Más de 40 bases de datos + sistemas de IA |

Comenzando con la Privacidad de Datos en IA

- Realice una Evaluación de Riesgos

Identifique dónde la IA interactúa con datos sensibles utilizando Data Discovery. - Implemente Barreras de Seguridad

Implemente Reglas de Seguridad para las API de IA y bases de datos. - Capacite a su Equipo

Eduque a los empleados sobre las Políticas de Seguridad en el uso de la IA.

Palabras Finales: Equilibrar la Innovación con la Seguridad

La IA generativa desbloquea un valor tremendo, pero solo si las empresas priorizan la privacidad de los datos. Al integrar prácticas y herramientas de seguridad robustas como DataSunrise, las organizaciones pueden mitigar los riesgos sin dejar de fomentar la innovación.

Descubra cómo nuestra plataforma protege sus flujos de trabajo de IA: