Sondages et Perspectives de Sécurité des LLM

Alors que les organisations intègrent les grands modèles de langage (LLM) dans leurs opérations quotidiennes, l’attention portée à la sécurité des LLM connaît une croissance rapide. Ces modèles traitent des données sensibles et doivent respecter des normes strictes en matière d’audit, de masquage et de conformité. Cet article explore les Sondages et Perspectives de Sécurité des LLM en présentant des techniques concrètes pour renforcer les déploiements GenAI et se conformer à des réglementations telles que le RGPD et la HIPAA.

LLM dans des cas d’utilisation orientés sécurité

Les LLM prennent désormais en charge des tâches telles que la détection de phishing, la synthèse de journaux et la génération de règles. Cependant, l’accès au code, aux journaux ou aux données des utilisateurs engendre le risque de fuites accidentelles. C’est pourquoi l’utilisation d’outils de surveillance de la conformité en temps réel et de masquage dynamique est essentielle lorsque les LLM fonctionnent en environnements de production.

Des modèles de menace plus détaillés sont disponibles dans ce billet de blog MITRE ATLAS, qui expose des tactiques adversariales spécifiques aux LLM.

Audit en temps réel pour l’inférence et l’entraînement

L’accès aux données des LLM doit être surveillé tout comme les requêtes de base de données. Les audits en temps réel enregistrent les détails des requêtes, le contexte récupéré et les recherches vectorielles. Par exemple, si votre LLM utilise PostgreSQL avec pgvector, vous pouvez consigner ces requêtes en utilisant le module de Surveillance de l’Activité de la Base de Données.

SELECT content FROM documents

WHERE embedding <#> '[0.134, -0.256, 0.789, ...]' < 0.75

LIMIT 5;

Cette requête peut être examinée instantanément pour la classification des sources de données ou pour détecter des violations de conformité. Vous pouvez également explorer les méthodes d’audit dans le blog technique de Pinecone, qui met en lumière les défis liés aux vecteurs.

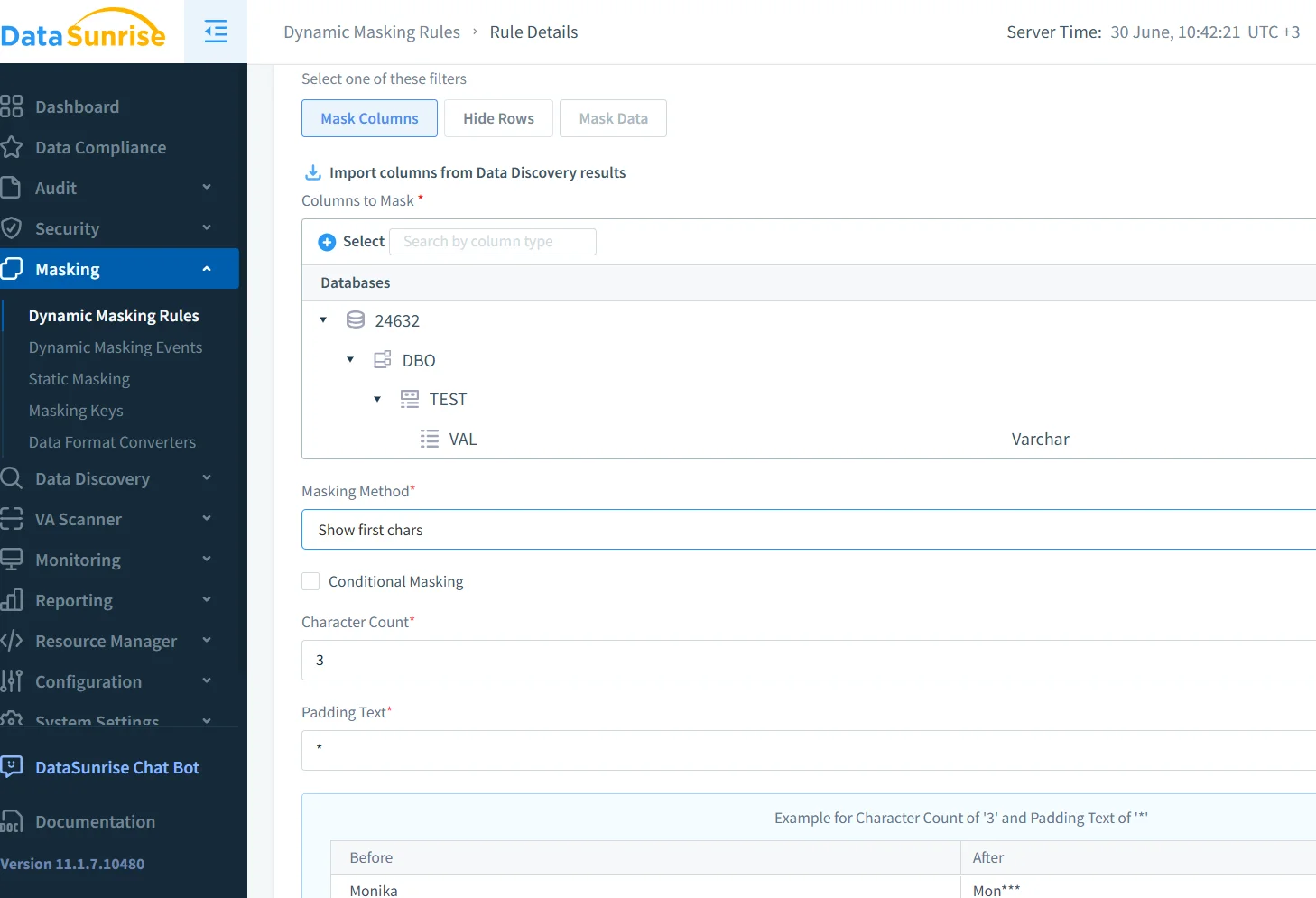

Masquage dynamique pour la sécurité des prompts

Le masquage dynamique dissimule les éléments sensibles tels que les e-mails ou les identifiants avant qu’ils n’atteignent le modèle. Il s’applique de manière contextuelle et peut varier selon le rôle ou le modèle. Chez DataSunrise, le masquage des données fonctionne sur l’ensemble des prompts à l’aide de modèles basés sur des règles.

{"user_id": "u-4982", "email": "[email protected]", "error": "access denied"}Devient :

{"user_id": "u-4982", "email": "*****@company.com", "error": "access denied"}L’article d’OpenAI sur l’apprentissage du refus explore des stratégies de masquage similaires.

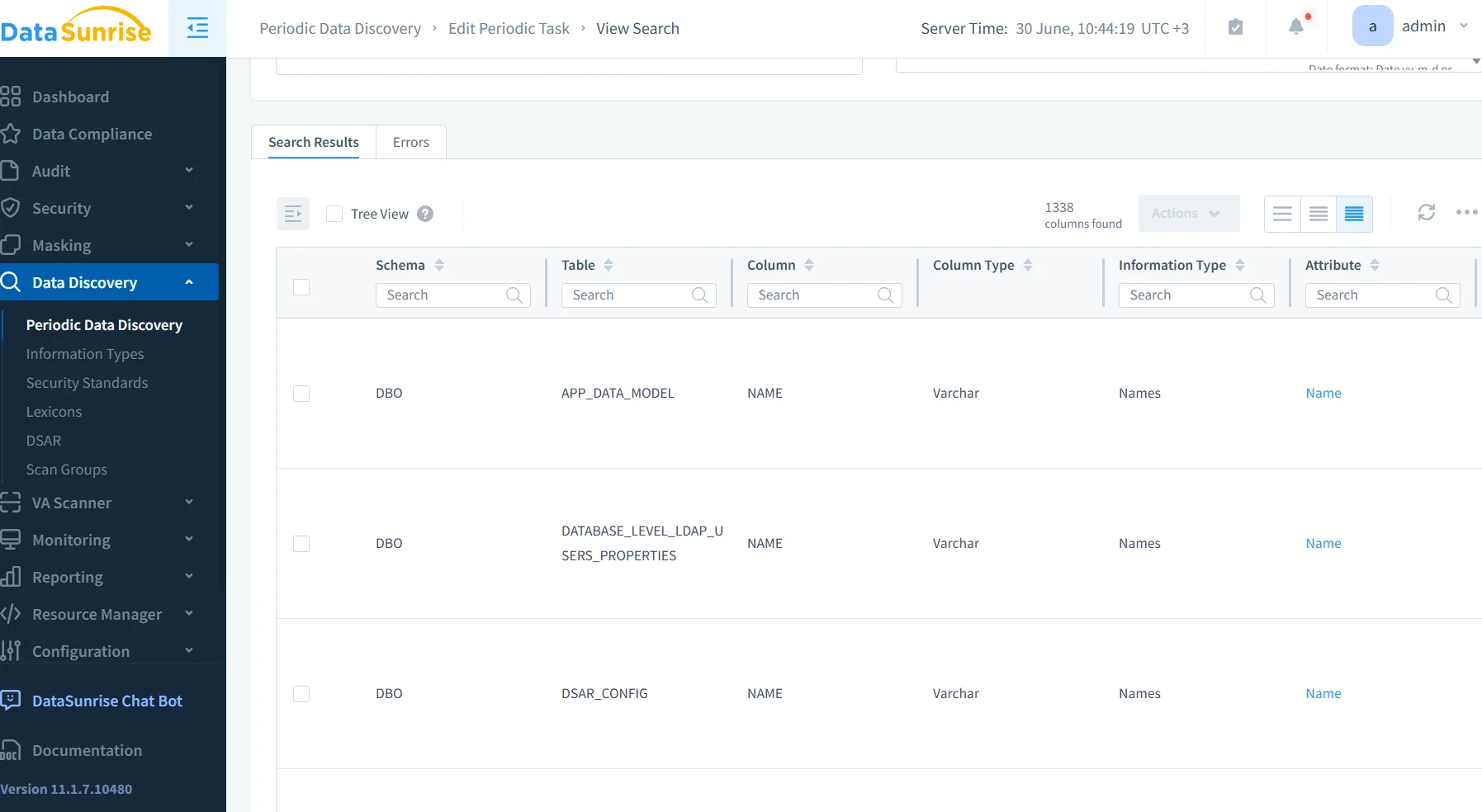

Découverte des données dans les pipelines d'embedding

Dans de nombreux systèmes, la vectorisation commence avant même que le contenu ne soit analysé. Cette approche est risquée. Utilisez plutôt des outils de découverte des données pour examiner les enregistrements avant de les indexer.

Les enregistrements contenant des informations personnelles identifiables (PII) ou des informations de santé protégées (PHI) peuvent être signalés et redirigés. DataSunrise s’intègre aux flux de travail tels qu’Airflow ou dbt pour appliquer ces analyses automatiquement.

Le guide de Cohere sur la confidentialité des LLM montre comment appliquer des bonnes pratiques similaires.

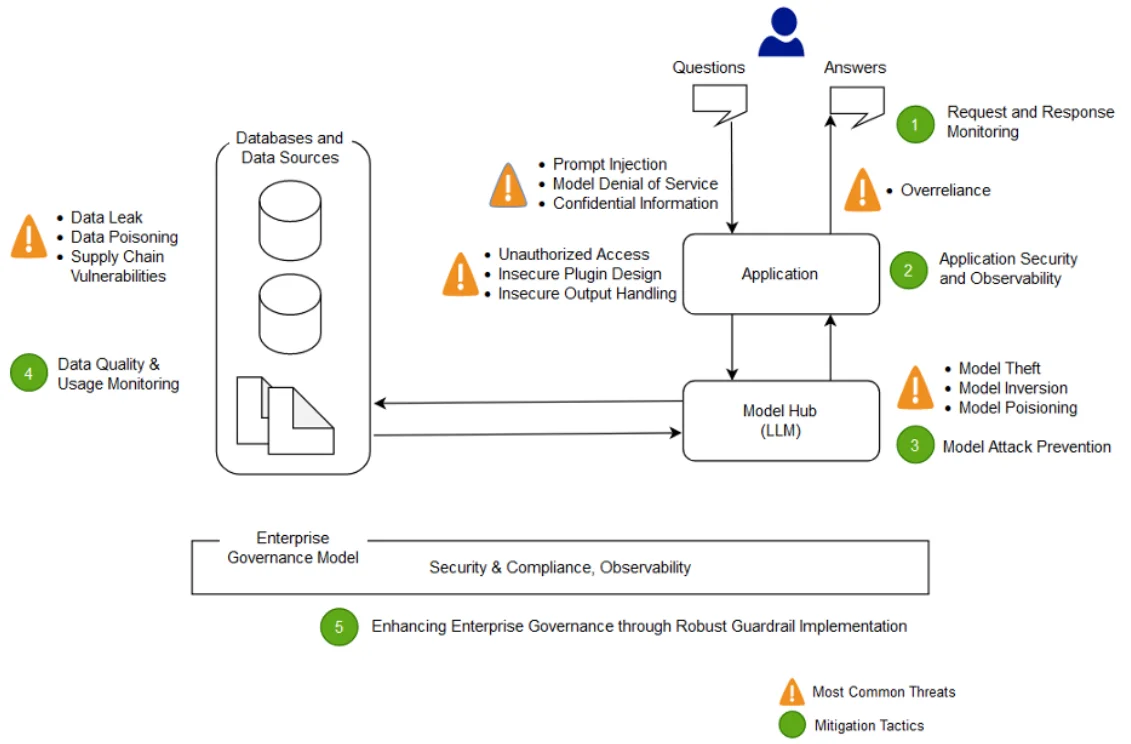

Perspectives de sécurité issues des déploiements de LLM

Les enquêtes menées auprès des équipes de sécurité mettent en lumière des problèmes récurrents. L’injection de prompt reste une préoccupation. L’absence de règles de masquage permet la mémorisation de contenus sensibles. Les lacunes dans les traces d’audit vectorielles retardent les enquêtes, et les modifications du modèle passent inaperçues.

Pour y remédier, de nombreuses équipes intègrent des tags d’audit, limitent les prompts et utilisent des passerelles pour le trafic d’inférence. Vous pouvez explorer des mesures d’atténuation plus approfondies dans LLMGuard, qui examine à la fois les contrôles de proxy et les méthodes de filtrage de tokens.

Opérations LLM prêtes pour la conformité

Pour se conformer au RGPD, à la HIPAA ou au PCI-DSS, votre système doit consigner l’accès aux données, classifier les sources et appliquer le masquage lorsque cela est nécessaire. L’isolation entre les LLM et les données en temps réel est également essentielle.

Le Gestionnaire de Conformité DataSunrise prend en charge tous ces contrôles et s’intègre facilement aux plateformes SIEM externes. Vous pouvez également consulter le Cadre de Gestion des Risques liés à l’IA du NIST pour obtenir des conseils plus larges.

À venir : Pare-feux de données compatibles avec les LLM

La prochaine génération de pare-feux n’inspectera pas seulement le SQL — elle analysera également les prompts, les embeddings et les complétions. Ces outils détecteront les utilisations abusives, empêcheront le partage excessif et bloqueront les flux dangereux. Tout comme un pare-feux de base de données, mais adapté aux LLM.

Des projets tels que Guardrails AI et LLM-Defender développent cette vision. Associés aux politiques de sécurité basées sur des règles proposées par DataSunrise, le résultat est une protection solide et adaptative.

Ce concept se retrouve dans l’Intelligence Artificielle Constitutionnelle d’Anthropic, qui propose des LLM intégrant dès leur conception des vérifications internes de conformité aux politiques.

Réflexions finales

Les LLM d’aujourd’hui nécessitent plus que de la performance : ils ont besoin de protection. Les audits en temps réel, le masquage dynamique et les flux de travail de découverte constituent l’essence des Sondages et Perspectives de Sécurité des LLM modernes. Avec des plateformes comme DataSunrise, ces mesures de protection font partie intégrante de votre architecture LLM — et non une réflexion après coup.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant