Atténuation des Risques de Sécurité de l’IA

À mesure que les modèles d’IA générative (GenIA) deviennent une partie intégrante de l’infrastructure moderne, ils introduisent de nouveaux vecteurs d’exposition aux risques de sécurité. Des requêtes SQL hallucinées et des fuites de données involontaires à l’injection de commandes malveillantes, la GenIA redéfinit le paysage des risques. Cet article explore des stratégies pratiques pour atténuer les risques de sécurité de l’IA grâce à des défenses en couches telles que l’audit en temps réel, le masquage dynamique, la découverte de données et une application rigoureuse de la conformité.

Pourquoi la GenIA Pose des Défis de Sécurité Uniques

Les systèmes de GenIA fonctionnent sur une logique probabiliste, ce qui signifie qu’ils peuvent générer des résultats imprévisibles à partir d’instructions vaguement structurées. Ces résultats peuvent inclure des données sensibles des clients, des informations personnelles identifiables ou des identifiants d’accès appris durant l’entraînement ou récupérés lors du chaînage de commandes. Pire encore, les utilisateurs interagissant avec des systèmes de GenIA pourraient extraire des informations non autorisées si des garde-fous ne sont pas appliqués.

Considérons un cas où un agent de GenIA génère des requêtes SQL pour analyser les données d’achat des clients. Une commande malveillante pourrait le tromper en lui faisant exécuter ce qui suit :

SELECT * FROM customers WHERE ssn IS NOT NULL;

Si cette requête contourne les règles de sécurité, elle pourrait divulguer des dossiers sensibles. C’est pourquoi l’analyse contextuelle et les contrôles dynamiques sont essentiels pour prévenir les abus.

Un autre exemple pourrait impliquer des tentatives d’énumération du schéma de la base de données :

SELECT table_name FROM information_schema.tables WHERE table_schema = 'public';

Cela pourrait exposer des structures de table utiles pour des attaques ultérieures.

Audit en Temps Réel pour les Systèmes d’IA

L’audit en temps réel est la première ligne de défense pour les déploiements de GenIA. Il capture et enregistre les interactions, les requêtes et les actions qui en résultent afin d’identifier les abus ou les violations des politiques. Les pistes d’audit jouent également un rôle crucial dans l’analyse forensique et la réponse réglementaire.

Des outils comme le moteur de règles d’audit de DataSunrise permettent aux organisations de définir des déclencheurs spécifiques pour les requêtes initiées par des agents de GenIA. Combinés à la surveillance de l’activité de la base de données, ces journaux offrent une visibilité sur la manière dont les modèles interagissent avec les sources de données structurées et non structurées.

Voici un exemple de modèle de règle de journalisation :

WHEN query_text LIKE '%ssn%' THEN log_event;

Masquage Dynamique comme Garde-Fou pour l’IA

L’une des méthodes les plus efficaces pour prévenir l’exposition des données sensibles consiste à masquer dynamiquement la sortie en temps réel. Contrairement au masquage statique, qui modifie les données au repos, le masquage dynamique opère à la volée. Cela signifie que les champs sensibles, tels que les numéros de carte de crédit, les identifiants nationaux ou les adresses, sont remplacés par des valeurs de substitution lorsqu’ils sont consultés via des interfaces pilotées par l’IA.

DataSunrise prend en charge des politiques de masquage dynamique qui peuvent être définies en fonction des rôles, du contexte de la requête ou de l’origine de l’application. Lorsqu’associées à des interfaces de grands modèles de langage, ces politiques garantissent que même si une commande tente d’accéder à des champs restreints, le modèle ne voit que des données masquées.

Exemple de règle de masquage dynamique :

MASK COLUMN customers.credit_card USING 'XXXX-XXXX-XXXX-####';

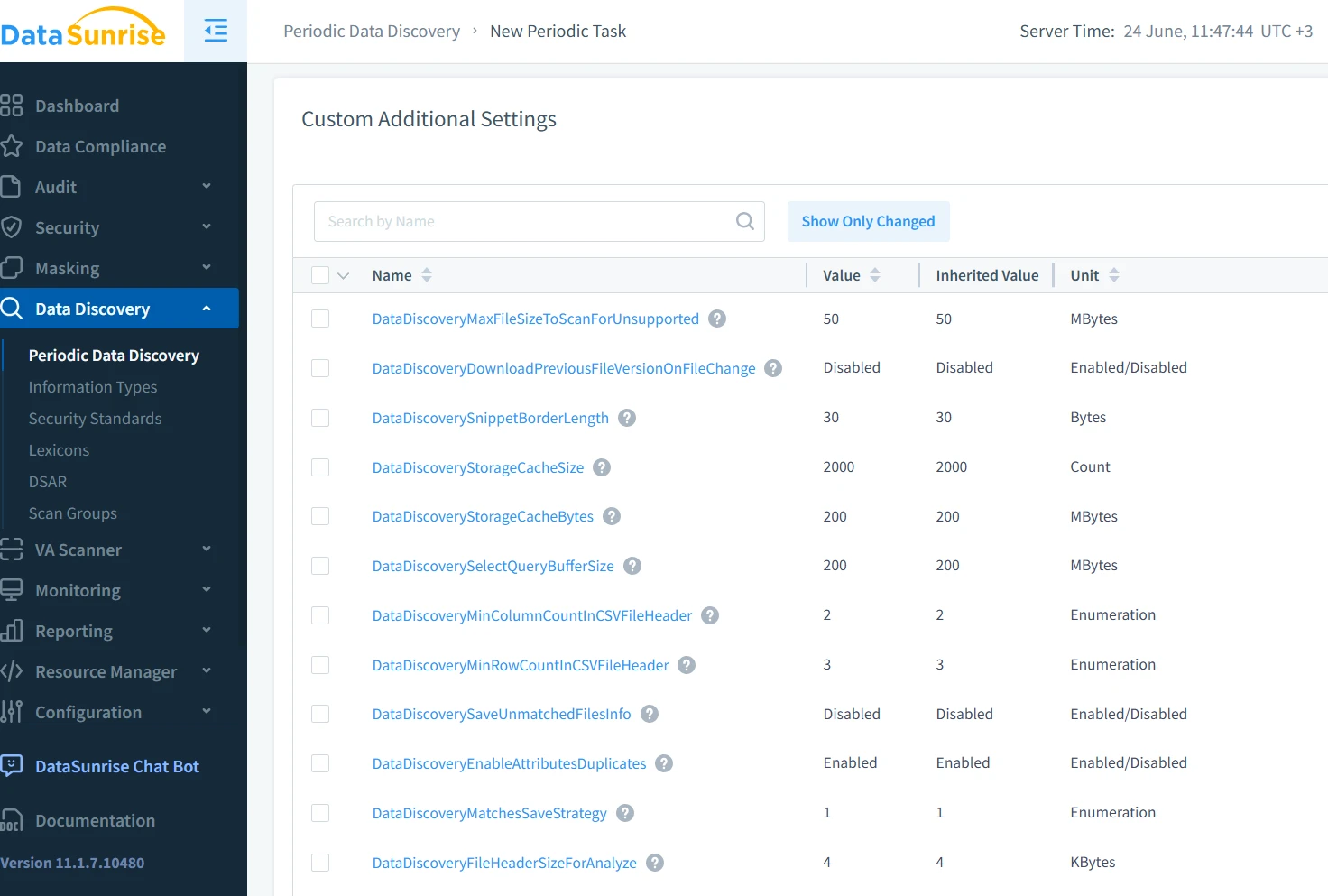

Découverte de Données pour la Cartographie de l’Accès Sensible dans l’IA

Avant de pouvoir protéger les données contre les abus de la GenIA, il faut savoir où elles se trouvent. Les outils de découverte de données identifient et classifient les enregistrements sensibles dans les bases de données, les lacs de données et les systèmes de fichiers. Cela comprend à la fois les champs structurés (comme le nom et l’email) et les motifs semi-structurés (comme les journaux et les transcriptions de discussions).

La découverte automatisée de données aide à créer des cartes de sensibilité contextuelle qui informent les politiques d’accès et guident les limites d’interaction des modèles. Cette approche proactive garantit que les développeurs et les auditeurs comprennent quelles données le système d’IA pourrait accéder durant l’exécution.

Par exemple, une analyse simple pourrait identifier des emails via une expression régulière :

[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Za-z]{2,}

Application de la Sécurité et de la Conformité

La sécurité de l’IA ne se limite pas à prévenir les fuites de données ; il s’agit également de satisfaire aux normes légales et réglementaires. Des cadres tels que le RGPD, HIPAA et PCI-DSS exigent désormais une protection continue des données, un contrôle d’accès basé sur les rôles et des journaux pouvant être audités — des exigences qui s’appliquent également aux systèmes pilotés par l’IA.

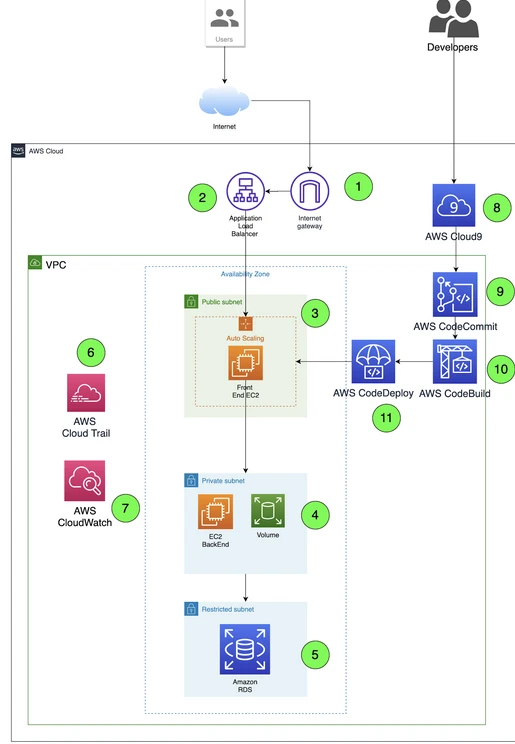

L’intégration d’une plateforme d’automatisation de la conformité assure le suivi en temps réel et l’application de ces normes lors de toutes les interactions des utilisateurs, y compris lors des sessions de GenIA. Cela permet aux organisations de mettre en œuvre des politiques telles que l’accès au moindre privilège, de limiter l’étendue des données sensibles et d’assurer la traçabilité en aval.

Exemple de restriction de rôle :

GRANT SELECT ON orders TO analyst_role;

REVOKE SELECT ON customers FROM analyst_role;

En utilisant le rapport automatisé de conformité, les équipes de sécurité peuvent créer des journaux prêts pour l’audit qui détaillent chaque interaction de l’IA avec des données réglementées, réduisant ainsi les efforts manuels et les erreurs humaines lors des audits de sécurité.

Combiner les Mesures pour une Défense en Profondeur

Chacun de ces mécanismes — audit en temps réel, masquage, découverte et conformité — fournit une protection partielle. Mais lorsqu’ils sont combinés, ils forment une défense en couches bien plus résiliente. Cela est particulièrement important dans les contextes de GenIA où aucun contrôle unique ne peut prédire ou prévenir entièrement un comportement à risque.

Imaginez ce processus : un grand modèle de langage génère une requête SQL ; le système audite la demande, applique un masquage aux champs d’informations personnelles, filtre les données et enregistre l’interaction. Pendant ce temps, des moteurs de conformité scrutent les violations potentielles des politiques. Cette approche holistique atténue les risques sans freiner l’innovation.

Pratiques Externes et Perspectives d’Avenir

En plus des protections intégrées à la plateforme, les meilleures pratiques des fournisseurs de cloud tels qu’AWS Macie et SecurityHub évoluent pour répondre aux préoccupations liées à la GenIA. Ces services s’intègrent avec des outils tels que Lake Formation ou CloudTrail pour surveiller l’utilisation des données sensibles et le comportement des utilisateurs dans les flux de travail de l’IA.

À mesure que la sécurité de l’IA évolue, les outils que nous utilisons doivent aussi évoluer. Le défi n’est pas seulement technique — il est aussi philosophique. Comment sécuriser des systèmes qui raisonnent et s’adaptent de manière autonome ? Tout commence par la sensibilisation, les outils et la conception de politiques proactives.

Conclusion

La GenIA transforme les industries, mais elle redéfinit également le paysage des menaces. L’atténuation des risques de sécurité de l’IA nécessite plus que des pare-feux traditionnels ou des rôles d’utilisateur — elle requiert une stratégie multi-couches et consciente du contexte. Les audits en temps réel, le masquage dynamique, la découverte de données et des outils automatisés de conformité comme ceux de DataSunrise sont essentiels pour sécuriser des infrastructures alimentées par l’IA sans étouffer leur potentiel.