Sécurité des données dans le cloud pour les déploiements d’IA et de LLM

Les modèles d’IA générative (GenAI) et les grands modèles de langage (LLM) ont transformé la manière dont les applications natives dans le cloud traitent et génèrent des données. Ces outils améliorent l’automatisation, la prise de décision et la personnalisation, mais ils introduisent également des défis importants en matière de sécurité des données. Lorsque les modèles interagissent avec des informations sensibles ou réglementées, il devient essentiel d’assurer leur traitement sécurisé et conforme. Dans cet article, nous explorons les composants clés de la sécurité des données dans le cloud pour les déploiements d’IA et de LLM, en nous concentrant sur l’audit en temps réel, le masquage dynamique, la découverte des données et les stratégies de conformité.

Risques spécifiques au cloud liés aux IA et aux LLM

Les LLM déployés dans les environnements cloud peuvent ingérer, traiter et générer des réponses basées sur des données sensibles d’entreprise. Ces réponses peuvent involontairement divulguer des identifiants personnels, des secrets commerciaux ou des contenus réglementés tels que des informations sur la santé ou les paiements. Comme les plateformes cloud distribuent et dimensionnent dynamiquement les charges de travail, la visibilité sur l’accès et le traitement des données devient plus complexe. Ce manque de visibilité et de contrôle crée un risque d’exposition non autorisée des données, en particulier si les sorties de GenAI sont enregistrées ou mises en cache de manière inappropriée.

Sécurisation des charges de travail d’IA avec l’audit en temps réel

L’un des éléments fondamentaux pour sécuriser les flux de travail d’IA et de LLM est la mise en œuvre d’audits en temps réel. Les audits en temps réel enregistrent toutes les interactions entre les utilisateurs, les services et l’infrastructure de données sous-jacente. En analysant ces interactions au fur et à mesure, les organisations peuvent détecter les violations de politiques, les activités suspectes et les schémas d’utilisation de l’IA clandestine.

Par exemple, lorsqu’un utilisateur interroge un modèle d’IA pour générer un résumé de profil client, une trace d’audit devrait capturer :

SELECT * FROM customer_profiles WHERE customer_id = '12345';

Cette trace peut ensuite être liée à la sortie du modèle et stockée dans un journal inviolable, permettant aux équipes d’examiner le comportement des invites ou de diagnostiquer des problèmes de conformité. Des plateformes telles que DataSunrise offrent des journaux d’audit détaillés qui s’intègrent aux SIEM, permettant des alertes automatiques et des visualisations des interactions d’IA à risque.

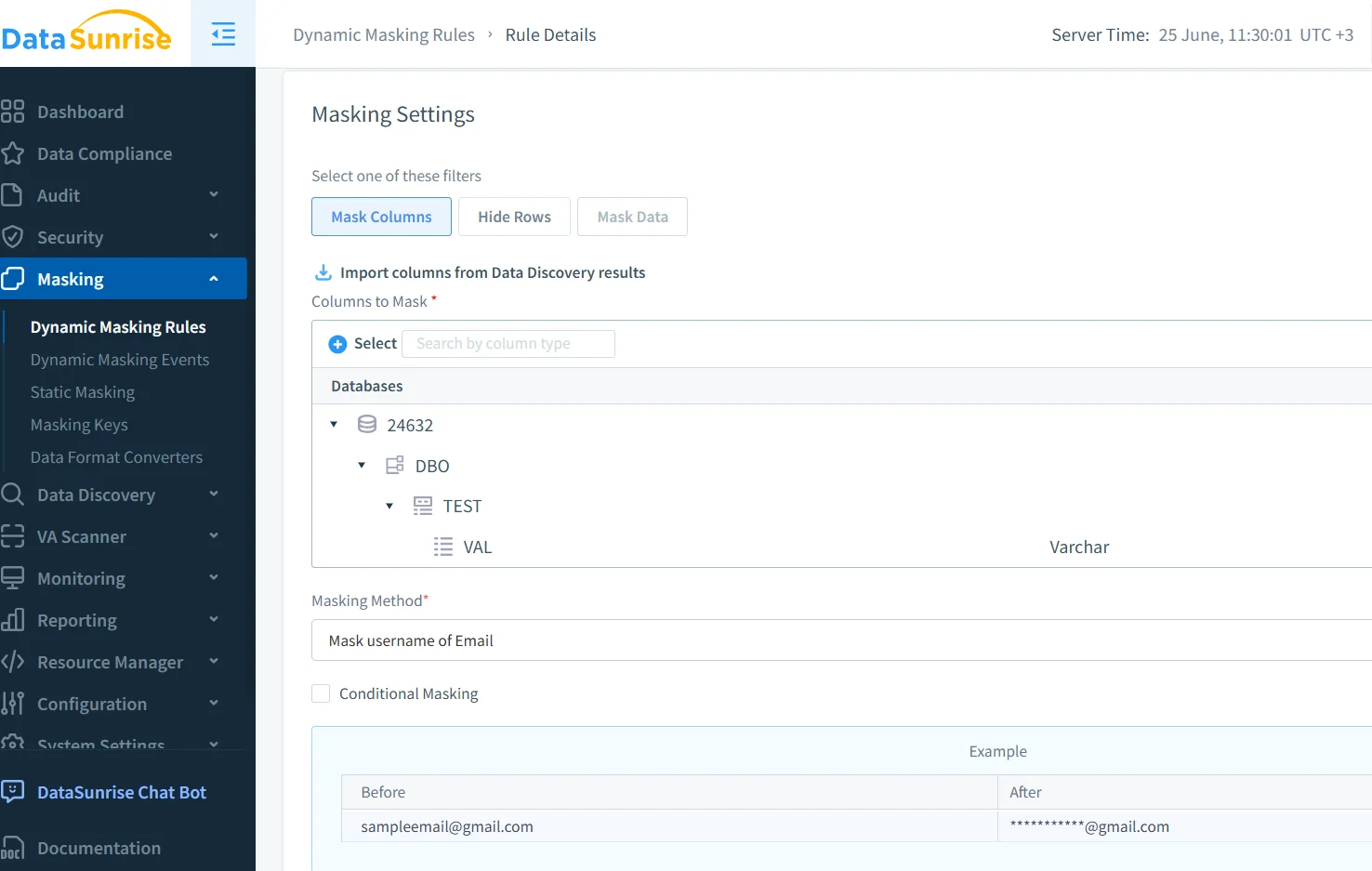

Application du masquage dynamique aux sorties de l’IA

Le masquage dynamique joue un rôle crucial dans la prévention des fuites de données lors des inférences GenAI. Contrairement au masquage statique, qui modifie les données au repos, le masquage dynamique s’effectue en temps réel, juste avant que la sortie n’atteigne l’utilisateur ou le modèle. Cela garantit que des champs sensibles tels que les numéros de sécurité sociale, les codes médicaux ou les dossiers financiers sont toujours masqués lors des interactions avec l’IA.

Imaginez un LLM utilisé pour assister les agents du service client. Lorsqu’un agent demande au modèle de résumer une commande comportant des informations personnelles (PII), les règles de masquage doivent garantir que des champs tels que celui-ci :

{"customer": "John Smith", "card_number": "4111-XXXX-XXXX-1234"}

sont livrées avec des valeurs masquées à la fois à l’agent et dans les journaux stockés. DataSunrise prend en charge le masquage dynamique qui fonctionne sur l’ensemble des bases de données cloud et s’intègre aux pipelines basés sur les LLM.

Découvrir les données sensibles avant qu’elles ne se divulguent

Les modèles d’IA entraînés ou sollicités sur des sources de données inconnues sont susceptibles de provoquer des fuites d’informations. Les outils de découverte de données aident à prévenir cela en scannant les data lakes, entrepôts et flux de données à la recherche d’attributs sensibles — tels que les dossiers de santé personnels, les jetons d’accès ou les identifiants financiers. L’intégration des résultats de découverte dans les pipelines GenAI garantit que les modèles n’accèdent qu’aux ensembles de données conformes.

Le module de découverte de données de DataSunrise classe automatiquement l’information sur les plateformes de stockage cloud, aidant les équipes de conformité à empêcher que des données réglementées n’entrent dans les phases d’entraînement ou d’inférence. Cette démarche proactive est essentielle pour permettre une automatisation sécurisée basée sur l’IA.

Renforcer la conformité dans les architectures pilotées par l’IA

Lorsque les systèmes d’IA basés sur le cloud interagissent avec des contenus réglementés, les cadres de conformité tels que le RGPD, HIPAA et PCI-DSS deviennent essentiels. Ces régulations imposent l’auditabilité, la minimisation des données et le contrôle d’accès basé sur les rôles. Appliquer ces contrôles aux modèles d’IA et à leurs entrées/sorties de données n’est plus optionnel.

Des solutions telles que Compliance Manager de DataSunrise permettent aux administrateurs de sécurité de l’IA de créer des politiques personnalisées alignées sur les normes de l’industrie. Les règles peuvent imposer le masquage de colonnes spécifiques, restreindre l’accès au modèle en fonction des rôles ou garantir que toute utilisation de LLM avec des données personnelles soit entièrement traçable.

Construire une sécurité multicouche pour l’IA dans le cloud

La sécurité dans les environnements GenAI basés sur le cloud ne se résume pas à un seul contrôle. Elle nécessite un modèle de défense en couches :

- Audit : Capturer et analyser les interactions en temps réel.

- Masquage : Empêcher l’exposition de contenus sensibles.

- Découverte : Cartographier et classifier les actifs de données sensibles.

- Contrôles d’accès : Mettre en place un contrôle d’accès contextuel basé sur les rôles (RBAC) et le principe du moindre privilège.

- Conformité : Aligner l’architecture sur des normes telles que le RGPD ou HIPAA.

Des outils comme le pare-feu de base de données de DataSunrise et les modèles de politique de sécurité aident les équipes de sécurité à appliquer ces contrôles dans les environnements centrés sur l’IA.

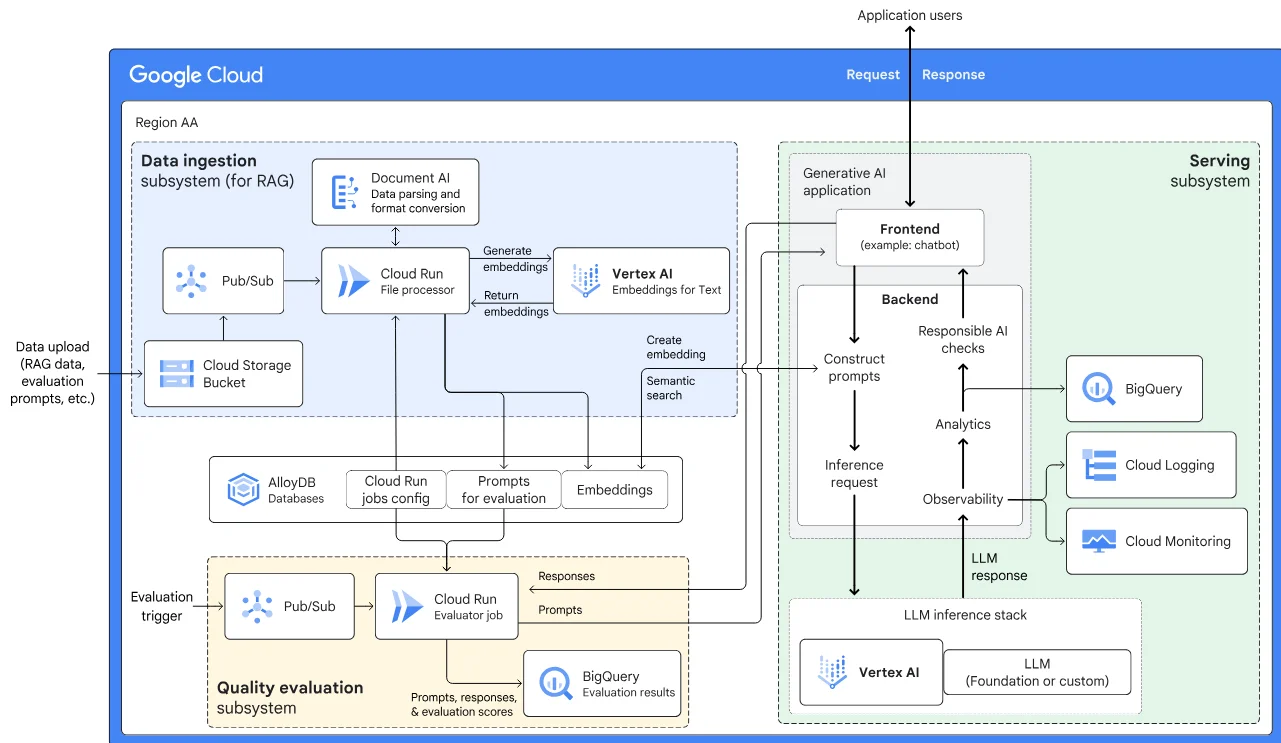

Des ressources externes telles que le Secure AI Framework (SAIF) de Google et le cadre de gestion des risques d’IA du NIST fournissent des conseils supplémentaires aux organisations qui construisent des systèmes d’IA résilients.

Conclusion

La sécurité des données dans le cloud pour les déploiements d’IA et de LLM ne se limite pas à la protection du périmètre. À mesure que les systèmes d’IA évoluent, les stratégies de sécurité qui les entourent doivent également évoluer. Les traces d’audit en temps réel, le masquage dynamique, la découverte intelligente des données et les garde-fous automatisés de conformité forment la base d’une GenAI fiable. Grâce à des plateformes telles que DataSunrise, les organisations peuvent avancer rapidement sans sacrifier le contrôle, permettant ainsi une innovation en matière d’IA sécurisée, évolutive et conforme.