Directives de Sécurité OWASP LLM

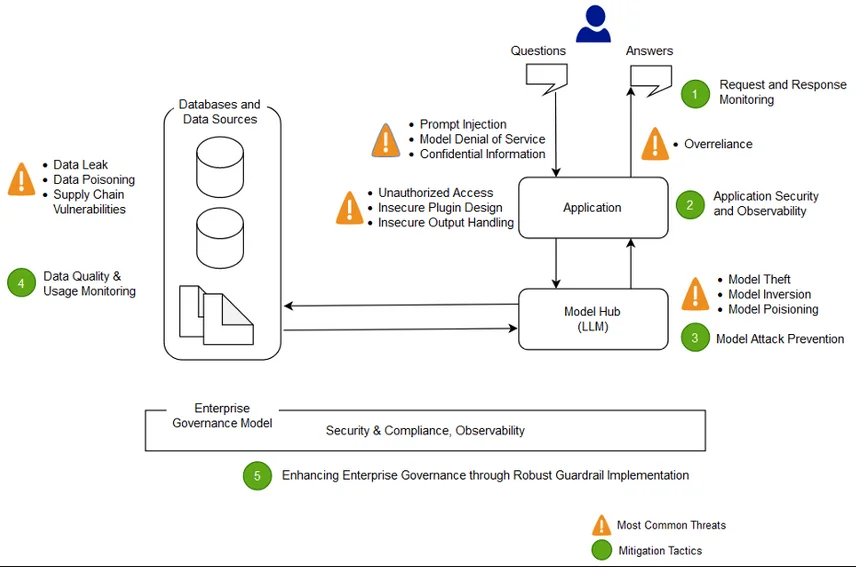

Les modèles de langage de grande taille (LLM) sont de plus en plus intégrés dans les applications modernes et les flux de travail, propulsant tout, des chatbots d’assistance clientèle à l’interprétation en temps réel des données. Mais avec un grand pouvoir viennent de nouvelles surfaces d’attaque. Le Top 10 OWASP LLM a suscité des discussions mondiales sur la manière d’aborder les risques liés à GenAI, et désormais les équipes de sécurité doivent élargir leurs manuels d’intervention.

Cet article examine comment utiliser les directives de sécurité OWASP LLM pour sécuriser les systèmes intégrant des LLM tout en réalisant un audit en temps réel, un masquage dynamique, une découverte des données et une conformité réglementaire.

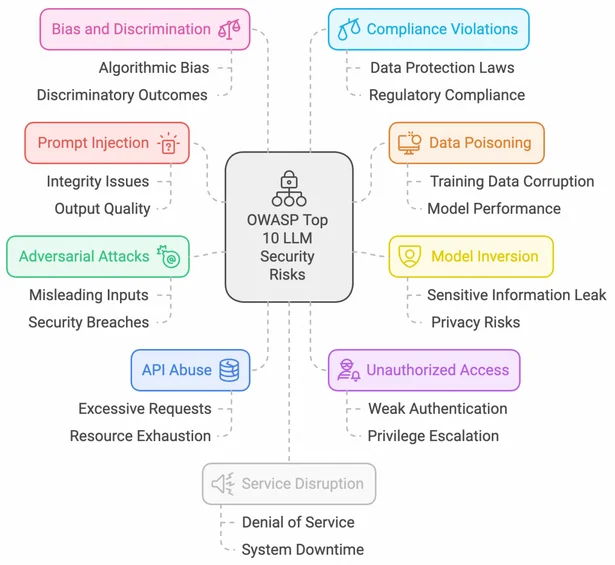

Comprendre le paysage OWASP des LLM

L’initiative d’OWASP autour des LLM offre une approche structurée pour identifier et atténuer les vulnérabilités spécifiques aux systèmes GenAI. Parmi les principales menaces figurent l’injection de requêtes, les attaques par déni de service sur le modèle, les fuites de données sensibles et l’utilisation non sécurisée de plugins.

Les équipes de sécurité peuvent se référer au Top 10 OWASP pour les applications LLM afin d’aligner leur adoption de GenAI avec un processus de modélisation des menaces adapté aux flux de travail des LLM.

Audit en temps réel : Surveiller le comportement de l’IA et l’accès aux données

Pour protéger les systèmes propulsés par des LLM, il est essentiel de mettre en place des mécanismes d’audit qui capturent à la fois les interactions des utilisateurs et les requêtes internes émises par le système.

Des solutions telles que les règles d’audit de DataSunrise et la surveillance de l’activité des bases de données peuvent assurer un suivi continu des interactions des LLM avec des sources de données structurées.

Voici un extrait PostgreSQL pour capturer les schémas d’accès par les agents LLM :

SELECT datname, usename, query, backend_start, state_change

FROM pg_stat_activity

WHERE application_name LIKE '%llm_agent%';

Les journaux d’audit enrichis avec le contexte utilisateur, les entrées/sorties du modèle et les métadonnées de timestamp aident les organisations à se préparer aux enquêtes forensiques et à détecter les comportements anormaux.

Masquage dynamique des données pour la sécurité des requêtes

Lorsque des LLM accèdent aux données de production, des champs sensibles non masqués peuvent être exposés involontairement dans la sortie. L’intégration du masquage dynamique directement dans le pipeline de données est essentielle.

En utilisant la capacité de masquage dynamique de DataSunrise, vous pouvez masquer ou tokeniser les informations personnelles identifiables (PII) avant qu’elles ne soient insérées dans les requêtes.

Une règle de masquage pourrait remplacer les adresses e-mail réelles par des valeurs factices telles que :

REPLACE(email, SUBSTRING(email, 1, POSITION('@' IN email)-1), 'user')

Cela garantit la conformité avec le RGPD et la HIPAA lors de la construction de solutions d’IA utilisant des données réelles.

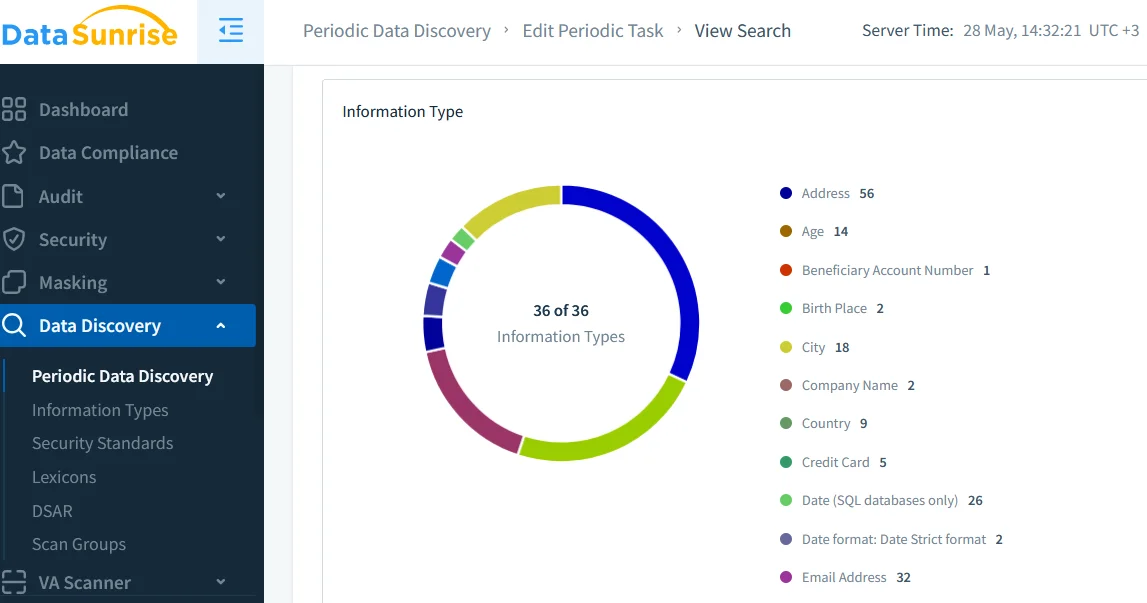

Découverte des données : Bâtir la confiance dans votre corpus d’entrée

Les LLM peuvent amplifier les risques s’ils sont entraînés ou ajustés sur des ensembles de données inconnus ou non classifiés. Les outils de découverte des données permettent aux organisations de scanner, étiqueter et cataloguer automatiquement les données sensibles avant qu’elles n’atteignent une couche d’intégration ou de récupération.

Un processus de découverte robuste aide à réduire les pipelines d’IA non autorisés et s’aligne sur des politiques de sécurité telles que le contrôle d’accès basé sur les rôles (RBAC).

Des solutions externes de gouvernance des données telles qu’Open Policy Agent peuvent également s’intégrer à ces résultats pour imposer des conditions d’accès dynamiques pour les agents de création de requêtes.

Politiques de sécurité : Alignement des flux de travail de l’IA avec les contrôles

Les LLM ne peuvent pas être surveillés comme des applications traditionnelles — leurs comportements sont probabilistes, sensibles au contexte et souvent non déterministes. Ainsi, les organisations doivent appliquer des politiques de sécurité à plusieurs niveaux qui incluent :

- Validation des entrées et filtrage des sorties

- Limitation du taux et surveillance de l’utilisation des API

- Mise en quarantaine des plugins ou workflows de révision

Consultez le guide de sécurité de DataSunrise pour construire un modèle de défense en profondeur adapté aux opérations GenAI.

Pour réduire la dérive de sécurité induite par les LLM, certaines équipes déploient un pare-feu léger ou un proxy afin d’analyser le contenu des requêtes et de masquer toute donnée non conforme avant de l’envoyer au modèle. Les règles de sécurité contre l’injection SQL peuvent être adaptées pour prévenir les exploitations d’injection de requêtes.

Protections inspirées par OWASP en un coup d’œil

| Catégorie | Contrôles recommandés | Objectif |

|---|---|---|

| Gestion des entrées | Validation, vérification de la longueur, filtrage des tokens | Prévenir l’injection de requêtes et les abus |

| Accès aux données | Accès basé sur les rôles, audit en temps réel, masquage | Appliquer le principe du moindre privilège et assurer la conformité |

| Filtrage des sorties | Filtres regex, vérification de toxicité, caviardage | Limiter l’exposition de données nocives ou privées |

| Utilisation de plugins et d’outils | Liste blanche de plugins, sandboxing, limitation de débit | Réduire la compromission du modèle via les intégrations |

| Journalisation de la conformité | Journaux d’audit, règles d’alerte, classification des données | Supporter les exigences du RGPD, de la HIPAA, du PCI DSS |

Conformité : Quand l’IA rencontre la réglementation

L’adoption des LLM n’exempte pas une organisation de se conformer aux normes. Au contraire, des réglementations telles que SOX, PCI DSS et la HIPAA s’appliquent de manière encore plus stricte lorsque des agents automatisés accèdent ou agissent sur des données sensibles.

L’utilisation d’une infrastructure d’IA consciente de la conformité qui combine les journaux d’audit, le masquage et des outils de génération de rapports permet aux entreprises de documenter des preuves pour les audits et de démontrer l’application des politiques.

Plusieurs initiatives open-source émergent également pour standardiser les journaux d’audit de l’IA, telles que PyRIT de Microsoft et les efforts de l’UE autour de la loi sur l’IA.

Conclusion : Construire des systèmes LLM sécurisés et conformes

Suivre les directives de sécurité OWASP LLM ne consiste pas à limiter l’innovation — il s’agit d’assurer la confiance, la responsabilité et l’alignement avec une sécurité de niveau entreprise. En combinant audit en temps réel, masquage dynamique et découverte des données, les organisations peuvent maîtriser la complexité de GenAI et libérer tout son potentiel sans s’exposer à des risques excessifs.

Pour approfondir, explorez le gestionnaire de conformité de DataSunrise et ses perspectives sur la sécurité LLM/ML pour protéger des bases de données hybrides et alimentées par l’IA.