Comment l’IA générative impacte les pratiques de sécurité

L’IA générative (GenAI) transforme la manière dont les organisations développent des logiciels, gèrent les données et servent les utilisateurs. Mais cette innovation s’accompagne de risques. Alors que les outils de GenAI génèrent du texte, du code, des images et prennent des décisions, ils créent également de nouvelles surfaces d’attaque. Comprendre comment l’IA générative impacte les pratiques de sécurité est essentiel pour toute organisation manipulant des données sensibles ou réglementées.

Un nouveau vecteur d’attaque : la langue comme surface de menace

La sécurité traditionnelle part du principe que les entrées sont prévisibles. L’IA générative brise cette hypothèse. En traitant les instructions humaines, les grands modèles de langage (LLM) ouvrent la porte à l’injection de commandes, à l’exfiltration de données et aux fuites accidentelles. Un modèle entraîné sur des données propriétaires pourrait, avec la bonne sollicitation, régénérer et exposer ces données.

Contrairement aux requêtes conventionnelles, les instructions pour l’IA générative peuvent déclencher des opérations inattendues. Les attaquants peuvent manipuler ces instructions pour escalader leurs privilèges ou récupérer des contenus sensibles d’entraînement. Ces défis exigent une évolution dans l’application des politiques de sécurité — surtout pour les systèmes intégrés aux API des LLM.

Une analyse approfondie des attaques par injection de commandes a été présentée dans cet article d’OWASP, qui met en lumière la difficulté de contrôler le comportement du modèle lorsque les entrées sont imprévisibles.

Audit en temps réel pour les systèmes d’IA

Les anciens journaux d’audit ne capturent pas la subtilité des instructions de l’IA générative. Il ne suffit plus d’enregistrer « requête exécutée » — nous devons consigner l’instruction complète, le résultat et les actions subséquentes.

Des outils modernes tels que les systèmes d’audit en temps réel pour les environnements intégrant l’IA générative enregistrent chaque requête, y compris les instructions d’entrée, le contexte et les réponses. Cela améliore la visibilité, soutient les enquêtes forensiques et aide à détecter les abus subtils tels que les attaques d’ingénierie d’invite.

Des plateformes comme DataSunrise Audit Logs évoluent pour gérer ces charges de travail uniques, permettant aux équipes de surveiller l’activité pilotée par l’IA avec un contexte complet.

Masquage dynamique lors de la génération

Lorsque les LLM génèrent une sortie, ils peuvent inclure des informations personnelles ou sensibles — surtout si le modèle a été affiné avec des jeux de données internes. C’est ici qu’intervient le masquage dynamique.

Au lieu de masquer uniquement les données d’entrée, l’IA générative nécessite un masquage au niveau de la sortie. Ce mécanisme rédige le contenu lors de la réponse, filtrant dynamiquement les informations personnelles identifiables (PII) ou les termes réglementés. Contrairement aux méthodes statiques, le masquage dynamique s’adapte aux sorties imprévisibles et applique les politiques à travers différents contextes utilisateur.

SELECT genai_response

FROM model_output

WHERE user_id = CURRENT_USER()

AND mask_sensitive(genai_response) = TRUE;

Une perspective plus large sur ce sujet est fournie dans le rapport de Google DeepMind sur la sécurité des LLM, qui explique comment la sécurité des réponses dépend du filtrage du contenu en temps réel.

Découverte des risques liés aux données cachées

De nombreux systèmes d’IA générative sont entraînés sur des jeux de données non classifiés ou mal étiquetés. Cela peut conduire à l’exposition accidentelle de données sensibles via des requêtes apparemment inoffensives.

Les outils de découverte des données aident à classifier le contenu à travers les données d’entraînement, les magasins de vecteurs et l’historique des requêtes. Ils identifient les informations personnelles dans les embeddings, signalent les secrets commerciaux stockés en mémoire contextuelle, et mettent en lumière les ensembles de données non conformes alimentant les flux de travail de l’IA générative.

Cette couche de découverte aide à faire respecter les réglementations de conformité des données telles que le RGPD, HIPAA et PCI-DSS — surtout lorsque le modèle se réentraîne sur des données en direct. Pour des conseils pratiques, le cadre de gestion des risques liés à l’IA du NIST expose les meilleures pratiques pour la classification et l’inventaire des données.

La sécurité réinventée pour les flux de travail pilotés par des instructions

Les contrôles de sécurité doivent tenir compte du comportement de l’IA générative. Au lieu de rôles et de permissions statiques, l’application des politiques inclut désormais la surveillance des instructions, le filtrage des sorties et le contrôle d’accès basé sur les rôles (RBAC) pour les entrées d’IA.

La détection d’injections SQL basée sur des motifs, telle que décrite dans l’approche de DataSunrise, joue également un rôle dans la détection des tentatives de contourner les restrictions via des requêtes créatives. Un utilisateur ayant un accès en lecture seule ne devrait pas être en mesure de formuler des instructions qui récupèrent des données masquées ou expurgées.

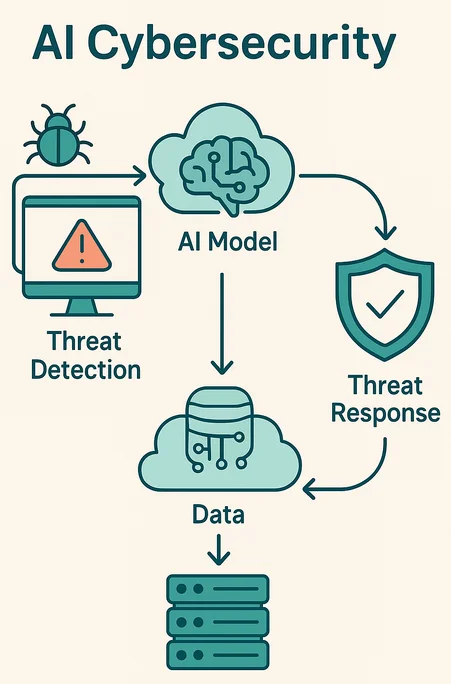

La détection des menaces en temps réel peut repérer un comportement inhabituel dans les instructions — comme des tentatives répétées d’extraire un nom ou de reconstituer des enregistrements structurés.

Conformité à la vitesse de la génération

La conformité était autrefois réactive : analyser les journaux, lancer des audits, envoyer des rapports. L’IA générative oblige les équipes de conformité à agir en temps réel. Avec des LLM générant des réponses en quelques millisecondes, l’application des politiques doit être tout aussi rapide.

Les solutions automatisées de gestion de la conformité associent les instructions aux politiques, bloquent les sorties lorsque nécessaire, et déclenchent des alertes en temps réel via des outils tels que MS Teams ou Slack.

Il ne s’agit pas seulement d’éviter les amendes. Il s’agit de confiance. Lorsqu’un modèle d’IA révèle des informations sur un patient ou un historique financier, les dommages sont immédiats et irrémédiables. La solution consiste à prévenir les violations avant que la sortie ne quitte le système.

Exemple : Blocage des instructions avec application des politiques

Voici un exemple simplifié d’un filtre d’instructions en pseudo-code :

if contains_sensitive_terms(prompt) or violates_compliance(prompt):

reject(prompt)

alert("Règle de conformité déclenchée")

else:

forward(prompt)

De telles règles peuvent s’intégrer aux politiques de sécurité pour bloquer la génération au niveau du modèle ou du middleware.

Vers l’avenir : des modèles de sécurité natifs à l’IA

Les futures plateformes de sécurité considéreront l’IA générative comme un modèle de menace de première classe. Elles introduiront de nouveaux contrôles tels que des pare-feux pour instructions, une prévention des pertes de données (DLP) sémantiquement consciente et une intégration SIEM native à l’IA. Certaines plateformes utiliseront des politiques de masquage continu guidées par l’apprentissage par renforcement.

Pour rester en avance, les équipes de sécurité doivent traiter les systèmes d’IA générative comme des agents probabilistes, et non comme des outils de confiance. Cela signifie surveiller, appliquer et instaurer des limites à chaque interaction.

En intégrant l’audit en temps réel, le masquage dynamique, la découverte et la conformité adaptée à l’IA, les entreprises peuvent exploiter l’IA générative sans compromettre l’intégrité des données. Car la manière dont l’IA générative impacte les pratiques de sécurité n’est pas une tendance — c’est le nouveau socle de la défense numérique.