Aperçus de sécurité des applications ML

Alors que l’apprentissage automatique transforme les opérations des entreprises, la plupart des organisations déploient des applications ML dans des processus métiers critiques. Bien que le ML offre des capacités de transformation, il introduit des défis de sécurité sophistiqués que les cadres de protection traditionnels ne peuvent pas résoudre de manière adéquate.

Ce guide examine les aperçus de sécurité des applications ML, explorant des stratégies d’implémentation qui permettent aux organisations de construire des infrastructures ML sécurisées et résilientes tout en maintenant l’excellence opérationnelle.

La plateforme de sécurité ML de pointe de DataSunrise offre une orchestration de sécurité sans intervention (Zero-Touch Security Orchestration) avec une protection ML autonome sur toutes les principales plateformes d’apprentissage automatique. Notre protection contextuelle intègre de manière transparente la sécurité ML aux contrôles techniques, fournissant une gestion de la sécurité d’une précision chirurgicale pour une protection complète des applications ML avec la conformité à l’IA par défaut.

Comprendre les Fondamentaux de la Sécurité des Applications ML

Les applications d’apprentissage automatique fonctionnent grâce à des algorithmes complexes qui traitent d’immenses ensembles de données, font des prédictions autonomes et s’adaptent continuellement grâce à des mécanismes d’apprentissage. Contrairement aux applications traditionnelles, les systèmes ML créent des surfaces d’attaque dynamiques où le comportement des modèles, les données d’entraînement et les processus d’inférence présentent tous des vulnérabilités de sécurité uniques nécessitant des approches de protection spécialisées.

Une sécurité ML efficace englobe la protection des chaînes de données, la vérification de l’intégrité des modèles, la surveillance des inférences et des capacités d’audit complètes conçues spécialement pour les environnements d’apprentissage automatique.

Vecteurs de Menaces Critiques pour la Sécurité des Applications ML

Les applications ML font face à des défis de sécurité uniques nécessitant des stratégies de protection spécialisées :

- Empoisonnement des Données d’Entraînement : Injection malveillante d’échantillons corrompus dans les ensembles de données d’entraînement pour manipuler le comportement du modèle et compromettre l’intégrité des données

- Attaques d’Extraction de Modèles : Tentatives basées sur API pour reconstruire des modèles propriétaires et voler de la propriété intellectuelle par accès non autorisé

- Inférence Adversariale : Entrées soigneusement élaborées conçues pour tromper les systèmes de prédiction et extraire des informations sensibles

- Fuite de Données : Attaques par inversion de modèle et inférence d’appartenance qui exposent les données d’entraînement via des violations de données nécessitant des protocoles de découverte des données

Cadre de Mise en Œuvre de la Sécurité

Une sécurité ML efficace nécessite des approches de validation pratiques pour les phases d’entraînement et d’inférence :

Validation de la Sécurité des Données d’Entraînement

L’implémentation suivante démontre comment valider l’intégrité des données d’entraînement et détecter des anomalies statistiques qui pourraient indiquer des tentatives d’empoisonnement. Ce validateur vérifie les hachages de données par rapport aux références de base et surveille les propriétés statistiques inhabituelles pouvant suggérer une manipulation malveillante.

import hashlib

import numpy as np

from datetime import datetime

class MLDataSecurityValidator:

def __init__(self):

self.anomaly_threshold = 2.0

self.integrity_baseline = {}

def validate_training_data(self, dataset, dataset_id):

"""Validation de sécurité complète pour les données d'entraînement ML"""

validation_result = {

'timestamp': datetime.utcnow().isoformat(),

'dataset_id': dataset_id,

'security_score': 100,

'threats_detected': [],

'recommendations': []

}

# Vérification de l'intégrité des données

current_hash = hashlib.sha256(str(dataset).encode()).hexdigest()

baseline_hash = self.integrity_baseline.get(dataset_id)

if baseline_hash and current_hash != baseline_hash:

validation_result['threats_detected'].append({

'type': 'DATA_TAMPERING',

'severity': 'HIGH',

'description': 'Intégrité de l\'ensemble de données compromise'

})

validation_result['security_score'] -= 30

# Stocker la référence de base pour les comparaisons futures

if not baseline_hash:

self.integrity_baseline[dataset_id] = current_hash

return validation_result

Moniteur de Sécurité pour l’Inférence du Modèle

Ce moniteur de sécurité démontre la protection en temps réel pour les points de terminaison d’inférence ML. Il suit les modèles de requêtes pour détecter d’éventuelles tentatives d’extraction de modèles et identifie des schémas d’entrées suspects pouvant indiquer des attaques adversariales.

class MLInferenceSecurityMonitor:

def __init__(self, model_name):

self.model_name = model_name

self.request_history = []

self.rate_limit_threshold = 100 # requêtes par minute

def monitor_inference_request(self, user_id, input_data, prediction):

"""Surveillance de sécurité en temps réel pour les requêtes d'inférence ML"""

security_assessment = {

'timestamp': datetime.utcnow().isoformat(),

'user_id': user_id,

'model_name': self.model_name,

'risk_level': 'LOW',

'security_flags': []

}

# Détection de dépassement du seuil de fréquence des requêtes

recent_requests = len([r for r in self.request_history

if r['user_id'] == user_id and

(datetime.utcnow() - datetime.fromisoformat(r['timestamp'])).seconds < 60])

if recent_requests > self.rate_limit_threshold:

security_assessment['security_flags'].append({

'type': 'RATE_LIMIT_EXCEEDED',

'severity': 'HIGH',

'description': 'Tentative potentielle d\'extraction de modèle'

})

security_assessment['risk_level'] = 'HIGH'

return security_assessment

Meilleures Pratiques d’Implémentation

Pour les Organisations :

- Établir la Gouvernance de la Sécurité ML : Créer des équipes de sécurité ML spécialisées avec des politiques de sécurité complètes et un alignement sur les réglementations de conformité

- Déployer la Surveillance en Temps Réel : Mettre en place une surveillance de l’activité des bases de données à travers les pipelines ML avec une analyse du comportement des utilisateurs

- Maintenir la Documentation de Sécurité : Créer des pistes d’audit complètes avec une optimisation adéquate du stockage des audits

- Évaluations de Sécurité Régulières : Réaliser des évaluations des vulnérabilités périodiques et des tests de sécurité

Pour les Équipes Techniques :

- Sécuriser les Pipelines ML : Mettre en œuvre le chiffrement des bases de données pour les données d’entraînement avec des protocoles de gestion des données de test

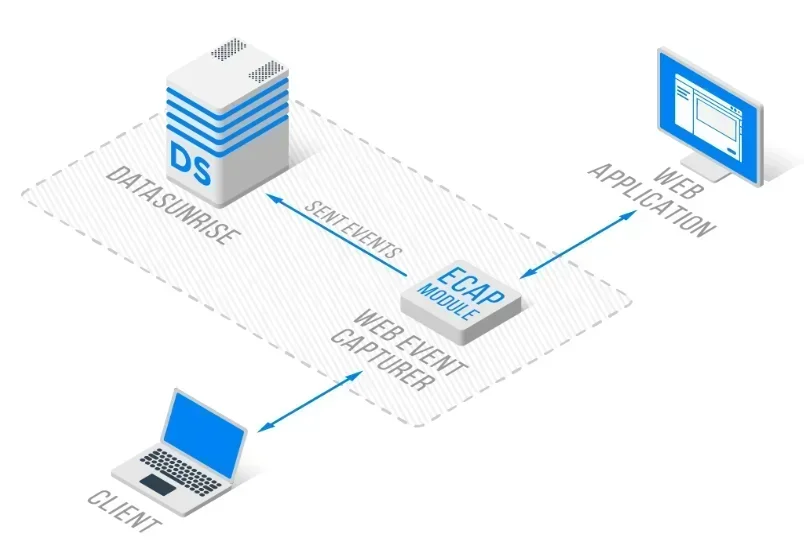

- Protection du Modèle : Déployer des contrôles d’accès et la protection de la propriété intellectuelle en utilisant une architecture de proxy inverse

- Détection en Temps Réel : Configurer une détection automatisée des menaces avec les capacités d’un pare-feu pour base de données

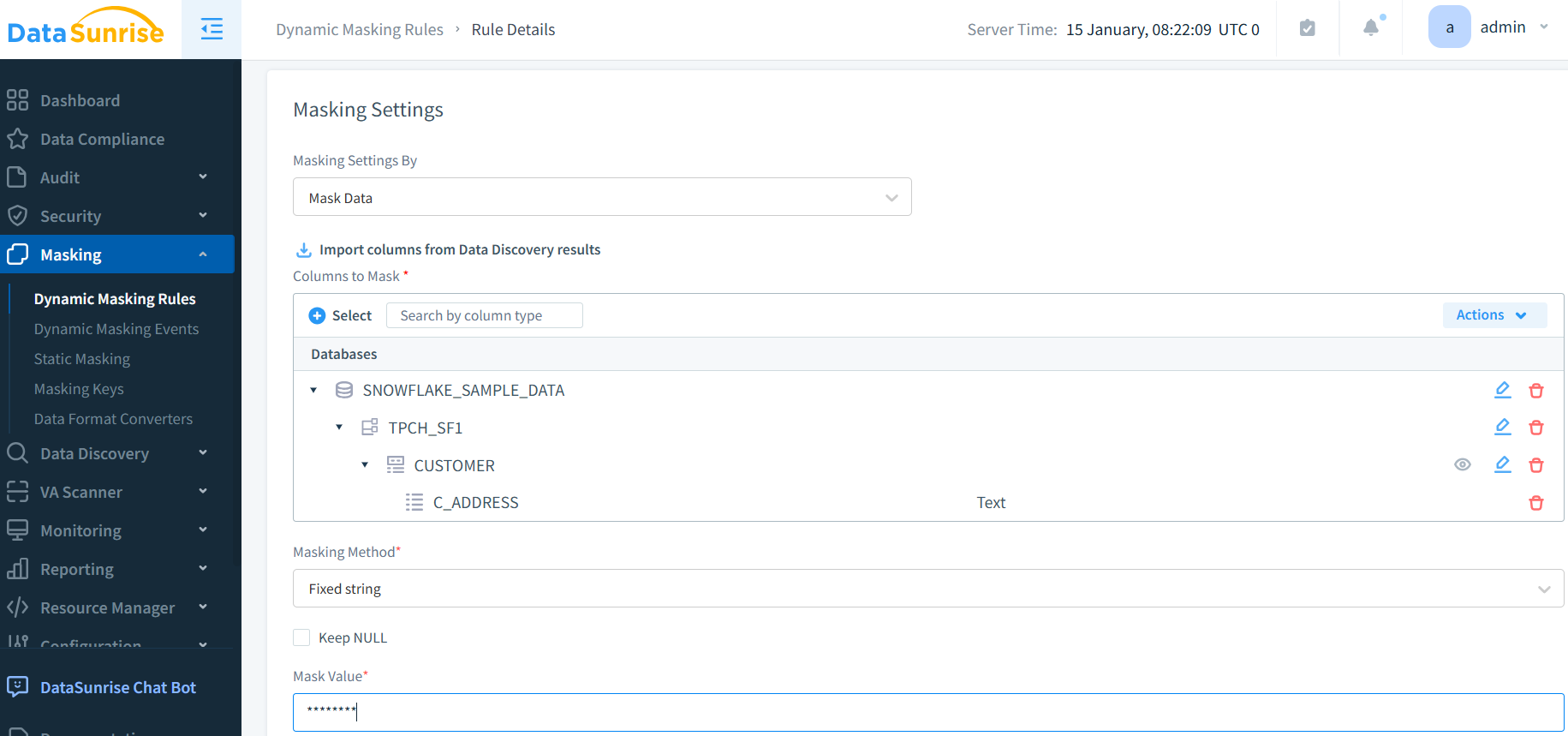

- Contrôles de Confidentialité : Mettre en œuvre des techniques complètes de masquage des données et de génération de données synthétiques

DataSunrise : Solution de Sécurité ML Complète

DataSunrise fournit des solutions de sécurité de niveau entreprise conçues spécifiquement pour les applications d’apprentissage automatique. Notre plateforme offre une sécurité maximale, un risque minimal avec une protection ML en temps réel sur toutes les principales plateformes ML, y compris TensorFlow, PyTorch et les services ML basés sur le cloud.

Caractéristiques Clés :

- Surveillance en Temps Réel de l’Activité ML : Suivi complet avec des journaux d’audit pour toutes les interactions ML

- Détection Avancée des Menaces : Détection de comportements suspects alimentée par ML avec une protection contextuelle

- Protection Dynamique des Données : Masquage des données avec une précision chirurgicale pour la protection des informations personnelles dans les ensembles de données d’entraînement

- Couverture Multi-Plateforme : Sécurité unifiée sur plus de 50 plateformes prises en charge

- Automatisation de la Conformité : Rapports automatisés de conformité pour les principaux cadres réglementaires via l’outil de gestion de conformité DataSunrise

Les modes de déploiement flexibles de DataSunrise prennent en charge les environnements ML sur site, dans le cloud et hybrides avec une implémentation sans intervention. Les organisations réalisent une réduction significative des incidents de sécurité et bénéficient d’une protection accrue des modèles grâce à une surveillance automatisée.

Conclusion : Construire des Fondations ML Sécurisées

Les aperçus de sécurité des applications ML révèlent l’importance cruciale de cadres de protection complets pour répondre aux menaces uniques de l’apprentissage automatique. Les organisations qui mettent en œuvre des stratégies de sécurité ML solides se positionnent pour exploiter le potentiel transformateur du ML tout en préservant la confiance des parties prenantes et la résilience opérationnelle.

À mesure que les applications ML deviennent de plus en plus centrales dans les opérations commerciales, la sécurité évolue d’un simple ajout optionnel à une capacité essentielle pour l’entreprise. En mettant en œuvre des cadres de sécurité avancés avec une surveillance automatisée, les organisations peuvent déployer en toute confiance des innovations ML tout en protégeant leurs actifs de données précieux.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant