Les principales entreprises de sécurité LLM

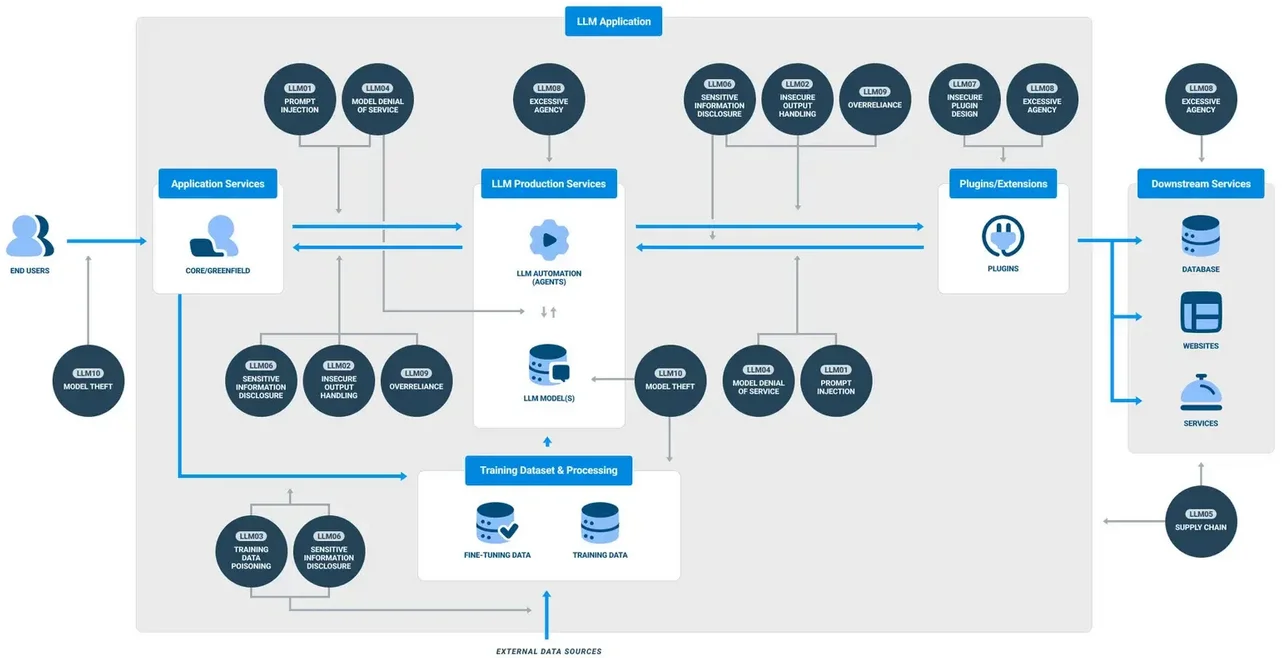

Alors que les systèmes d’intelligence artificielle générative (GenAI) deviennent essentiels dans les flux de travail des entreprises, le besoin d’une sécurité robuste et en temps réel se fait de plus en plus sentir. Ces grands modèles de langage (LLM) traitent d’énormes quantités d’informations sensibles, allant des dossiers clients aux algorithmes propriétaires. Face à des menaces allant de l’injection de prompt à la fuite de données, les organisations se tournent vers des plateformes avancées spécialisées dans l’observabilité des LLM, l’audit, le masquage et la conformité. Dans ce paysage, plusieurs fournisseurs se distinguent. Cet article explore les Principales entreprises de sécurité LLM et la manière dont elles favorisent une adoption sécurisée du GenAI grâce à des capacités essentielles telles que l’audit en temps réel, le masquage dynamique et l’application automatisée de la conformité.

Sécuriser le GenAI : Les fondations techniques

La sécurité des LLM dépasse le simple chiffrement du stockage ou l’activation de journalisations basiques. Un pipeline GenAI sécurisé requiert une visibilité complète sur toute la chaîne — depuis l’entrée de la demande jusqu’à la réponse finale du LLM — ainsi qu’une application en ligne des politiques et une classification des données. Cela inclut :

- Audit en temps réel des interactions utilisateurs et décisions du LLM

- Masquage dynamique des informations personnelles/médicales (PII/PHI) lors de l’inférence

- Découverte et classification des données avant l’ingestion dans le modèle

- Politiques d’accès évolutives selon les habitudes d’utilisation

- Flux de travail de conformité alignés sur des normes telles que le RGPD ou la HIPAA

Selon MIT Sloan, une bonne pratique essentielle consiste à considérer les LLM à la fois comme des surfaces de risque et comme des points terminaux intelligents.

Examinons comment les principaux fournisseurs de sécurité dans ce domaine répondent à ces besoins.

DataSunrise : Politiques granulaires pour les pipelines LLM et de bases de données

À l’origine axé sur la sécurité des bases de données, DataSunrise a étendu ses capacités pour prendre en charge la sécurité du GenAI. Son moteur d’audit en temps réel permet aux organisations de suivre les requêtes LLM émises via du SQL intégré ou des API connectées aux prompts. Le masquage est appliqué de manière dynamique en fonction du rôle de l’utilisateur et du contexte des règles, grâce à des règles de masquage dynamique flexibles. Ces politiques s’adaptent en fonction de l’analyse du comportement et du contexte d’accès.

La découverte des données est également un atout majeur. La plateforme analyse automatiquement les bases de données structurées et semi-structurées pour identifier les informations personnelles ou sensibles avant qu’elles n’atteignent les phases d’entraînement ou d’inférence du modèle. Combinées aux politiques de sécurité et aux techniques d’optimisation de stockage des audits, ces mesures garantissent que les déploiements GenAI restent vérifiables, masqués et conformes dans des environnements de production.

-- Exemple : Appliquer le masquage dynamique sur une colonne accessible par un LLM

CREATE MASKING RULE mask_llm_sensitive_data

ON schema.customer_data (ssn, email)

WHEN ROLE IN ('llm_user', 'analyst')

USING 'XXXX-XX-####', '***@example.com';

Securiti.ai : Intelligence de données autonome pour GenAI

Securiti propose une plateforme cloud de contrôle des données alimentée par l’IA, automatisant la découverte, la classification et la gouvernance des accès dans des environnements hybrides. Ses solutions sont de plus en plus utilisées dans les pipelines GenAI, où les développeurs ajustent les modèles sur des données d’entreprise ou intègrent les LLM dans des flux analytiques.

Les alertes de conformité en temps réel, le masquage basé sur la classification et les politiques d’accès gérées par l’IA sont des atouts majeurs. L’intégration de Securiti avec des outils natifs du cloud tels que Snowflake, Azure SQL et Cosmos DB garantit l’application sans faille des obligations du RGPD et de la HIPAA, de l’inférence au stockage.

La plateforme a récemment été reconnue dans le Forrester Wave pour les logiciels de gestion de la confidentialité pour son leadership en matière d’application automatisée des politiques.

Duality Technologies : Collaboration GenAI préservant la confidentialité

Duality se concentre sur la collaboration sécurisée des données et l’entraînement de l’IA grâce au chiffrement homomorphe et au calcul multipartite sécurisé. Bien qu’il ne soit pas un outil de protection LLM complet, Duality permet des cas d’utilisation où le GenAI est entraîné sur des ensembles de données conjointes sans exposer les informations brutes. Ceci est crucial pour les secteurs des services financiers ou de la santé où la conformité aux normes PCI-DSS ou aux lois sur la localisation des données est rigoureuse.

IDC rapporte que l’apprentissage fédéré et le calcul préservant la confidentialité gagnent du terrain dans les initiatives de gouvernance de l’IA, Duality étant l’un des principaux fournisseurs.

HiddenLayer : Détection des menaces spécifiques au ML

HiddenLayer propose une plateforme de sécurité adaptée aux systèmes d’apprentissage automatique. Pour les organisations déployant des LLM, elle offre une protection contre les prompts adversariaux, l’extraction de modèles et les attaques d’évasion. La couche de surveillance en temps réel de la plateforme peut détecter des anomalies dans les résultats du GenAI ou dans les comportements d’accès et déclencher des défenses automatiques.

Bien que HiddenLayer ne réalise pas nativement la découverte ou le masquage des données, sa spécialisation dans la sécurité des modèles d’IA pendant et après leur entraînement en fait un candidat solide pour les environnements à haut risque. Son moteur de détection est aligné sur le NIST AI Risk Management Framework, renforçant les pratiques d’assurance des modèles.

Protéger l’avenir : Bonnes pratiques au-delà des outils

Choisir la bonne plateforme est crucial, mais sécuriser le GenAI nécessite également des pratiques opérationnelles bien définies. Voici quelques points à retenir :

- Toujours scanner et classifier les données d’entrée avant l’entraînement

- Activer l’audit à chaque invocation de prompt

- Utiliser une sécurité inspirée des données pour définir un masquage adaptatif

- Aligner les journaux des LLM avec les politiques de conformité et les délais de conservation

Des lectures complémentaires de Google DeepMind expliquent pourquoi l’ajustement, les garde-fous et les boucles d’audit continues sont essentiels à la sécurité des LLM dans les domaines à enjeux élevés.

Les équipes de sécurité doivent considérer les LLM comme des consommateurs et générateurs de données dynamiques, nécessitant non seulement des défenses périmétriques, mais également une observabilité approfondie et une application granulaire des accès.

Conclusion

Alors que l’adoption des LLM s’accélère, les entreprises doivent adapter leur infrastructure de sécurité aux nouveaux risques et pressions réglementaires. Les Principales entreprises de sécurité LLM présentées ici – DataSunrise, Securiti.ai, Duality et HiddenLayer – apportent chacune des atouts différents. Qu’il s’agisse de pistes d’audit, de masquage, de collaboration chiffrée ou de détection de menaces, chacune fournit des mesures de protection essentielles adaptées aux charges de travail GenAI. Une approche multicouche combinant ces capacités est la manière la plus efficace de sécuriser l’IA générative dans les environnements d’entreprise.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant