Liste de vérification de sécurité et de gouvernance GenAI pour les LLM

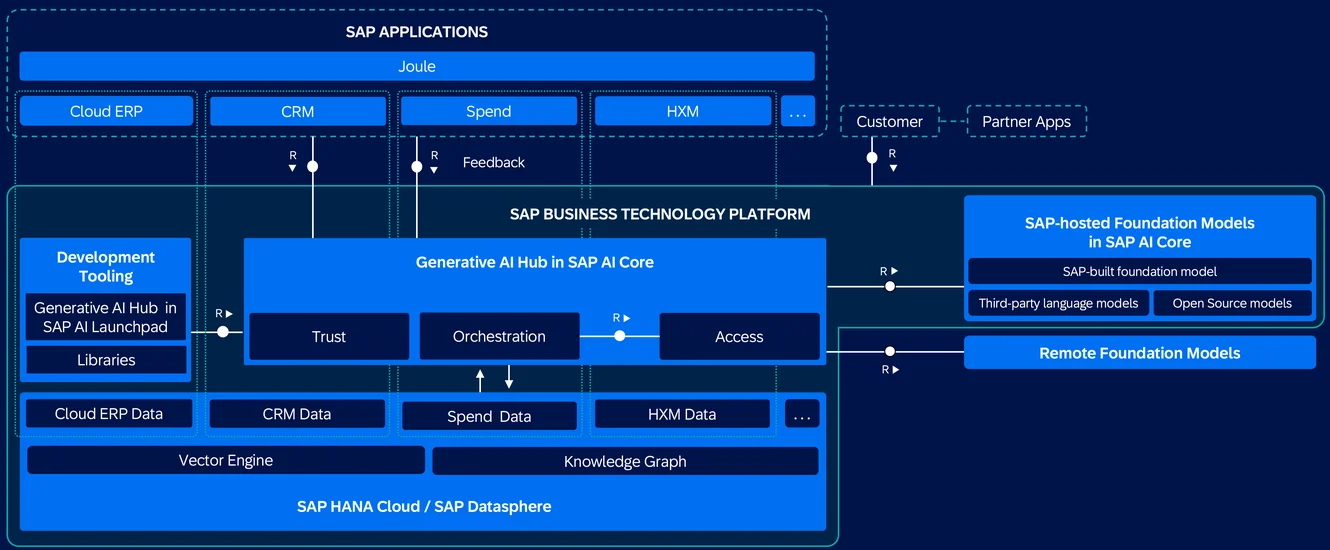

L’intelligence artificielle générative (GenAI), notamment les modèles alimentés par de grands modèles de langage (LLM), ouvre une nouvelle frontière de l’innovation – et du risque. Ces modèles ingèrent, génèrent et traitent des données à grande échelle, souvent issues de sources diverses et sensibles. Avec un grand pouvoir vient le besoin urgent d’une sécurité renforcée et d’une gouvernance adaptée.

Cette liste de vérification décrit comment sécuriser les pipelines GenAI grâce à des contrôles en couches : visibilité, protection, responsabilité et automatisation.

Surveillance en temps réel des charges de travail des LLM

Les LLM ne ressemblent peut-être pas à des bases de données traditionnelles, mais leur comportement doit être consigné tout aussi minutieusement. Enregistrer chaque interaction – des invites aux réponses générées – vous permet de suivre l’exposition des données sensibles, de détecter les abus et de satisfaire les auditeurs de conformité. Des outils tels que Surveillance de l’activité de la base de données offrent cette visibilité en temps réel.

SELECT * FROM pg_stat_activity WHERE datname = 'llm_logs';

Cet exemple PostgreSQL montre comment corréler les sessions de base de données avec les métadonnées d’utilisation des LLM.

Voir également : Règles d’apprentissage et Audit pour affiner les politiques d’audit.

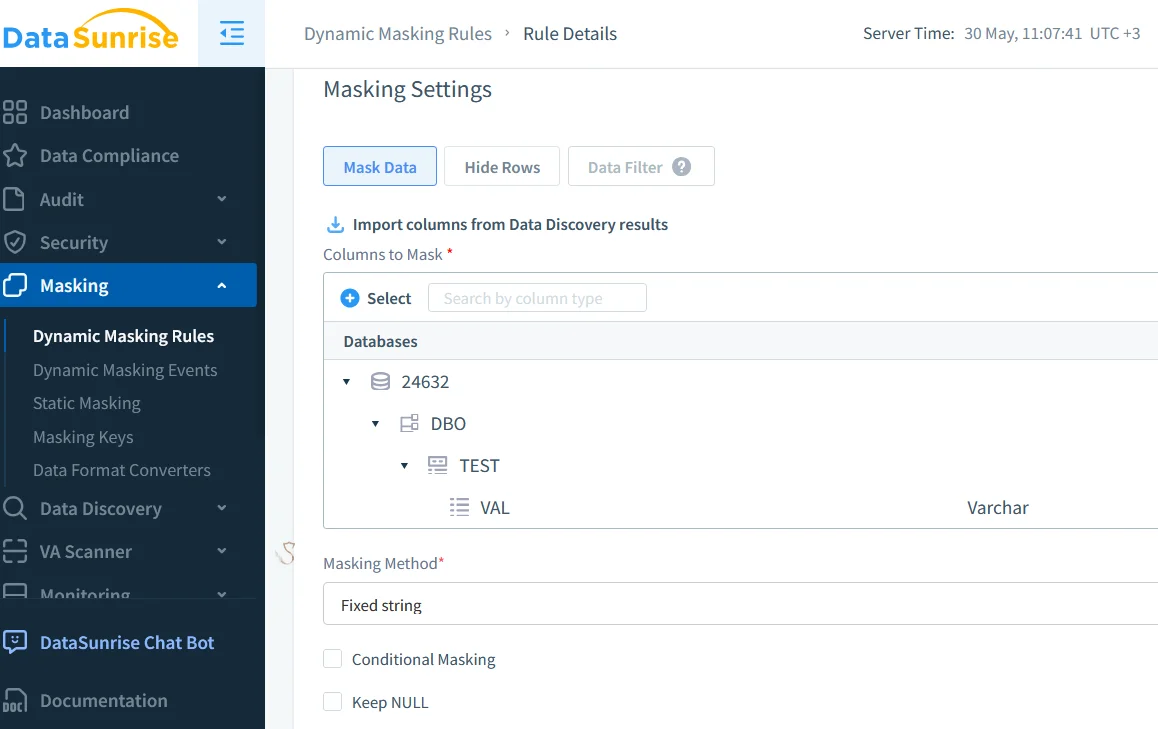

Masquage des données en temps réel dans les pipelines GenAI

Les données sensibles telles que les emails des clients, les jetons ou les dossiers médicaux ne doivent pas être divulguées dans les invites, les réponses ou les journaux. Le masquage dynamique des données agit en temps réel, s’ajustant en fonction du rôle de l’utilisateur ou de son niveau d’accès.

Il est particulièrement précieux dans des environnements comme les outils d’ingénierie des invites, les systèmes basés sur le RAG et les API d’inférence partagées – où les interactions des utilisateurs sont fréquentes et les risques liés aux données élevés.

Pour une compréhension approfondie de la protection des champs sensibles, consultez l’article sur le Masquage sur place.

Découverte automatisée des données sensibles

On ne peut pas gouverner ce que l’on ne peut pas trouver. Les analyses automatisées de découverte de données sont essentielles pour localiser les champs sensibles, en particulier dans les magasins de vecteurs ou les pipelines multimodaux.

Ces analyses classifient les invites d’entrée et les données des utilisateurs, étiquettent les sorties pour l’application des politiques et répondent aux exigences réglementaires telles que le RGPD ou la HIPAA. Elles aident les équipes à garder le contrôle sur ce que le modèle apprend et produit.

Consultez Considérer les données comme un atout précieux pour renforcer votre stratégie de découverte.

Contrôle d’accès et restrictions au niveau des invites

Les LLM sont susceptibles d’être mal utilisés via l’injection dans les invites ou l’escalade des plugins. Pour réduire ces risques, mettez en place un contrôle d’accès basé sur les rôles (RBAC) et un filtrage des entrées. Ces mesures empêchent les fuites provenant d’utilisateurs peu fiables, limitent les abus d’invites visant des actions administratives et aident à gérer l’accès entre les équipes et les départements.

Vous pouvez également explorer les notions de Contrôles d’accès et du Principe du moindre privilège pour renforcer les déploiements des LLM.

Gestion de la conformité simplifiée

Les révisions manuelles ne peuvent pas suivre le rythme de l’évolution. Des outils tels que le Gestionnaire de conformité aident à définir les correspondances réglementaires, à appliquer les règles d’accès et de conservation et à générer des rapports à la demande.

Par exemple :

CREATE MASKING RULE mask_email

ON llm_prompt_logs(email)

USING FULL;

Cette règle garantit que les données des emails sont masquées avant d’être analysées ou exportées.

Vous pouvez approfondir l’importance de cette étape dans la Génération de rapports.

Ressources à explorer

Découvrez ces références pour approfondir vos connaissances sur la sécurisation des pipelines LLM :

- Framework de gestion des risques pour l’IA du NIST

- IA responsable de Microsoft

- Top 10 OWASP pour les LLM

- Cadre IA sécurisé de Google (SAIF)

- Document sur l’IA constitutionnelle d’Anthropic

Concevez pour la visibilité et la confiance

Sécuriser GenAI consiste à superposer des contrôles intelligents, sans entraver l’innovation. Votre pile de gouvernance devrait inclure une auditabilité en temps réel, un masquage tenant compte des rôles, une découverte continue et des vérifications de conformité automatisées.

Pour approfondir, lisez sur les Pistes d’audit, la Sécurité des données, les Outils LLM et ML pour la sécurité des bases de données et la Génération de données synthétiques comme alternative pour tester ou entraîner en toute sécurité les systèmes GenAI.