Risques et atténuations LLM OWASP

L’engouement pour les grands modèles de langage (LLM) a révolutionné la manière dont les organisations interagissent avec les données, automatisent les décisions et extraient des informations. Mais cette capacité transformatrice s’accompagne d’un nouveau lot de risques en matière de sécurité et de conformité. Le Top 10 OWASP pour les applications LLM met en lumière ces vulnérabilités et propose des stratégies d’atténuation essentielles pour toute organisation utilisant l’IA générative.

Cet article examine ces risques en se concentrant sur l’audit en temps réel, le masquage dynamique, la découverte de données et la manière de maintenir la conformité des données dans des environnements propulsés par GenAI.

Comprendre le paysage : catégories de risques des LLM

OWASP catégorise les risques spécifiques aux LLM en domaines tels que l’injection de consignes, la fuite de données, l’utilisation abusive du modèle, les plugins non sécurisés et l’empoisonnement des données d’entraînement. Ces menaces exploitent les forces mêmes de GenAI — son adaptabilité et son apprentissage contextuel — et pourraient inciter le modèle à contourner les garde-fous internes et à divulguer des résultats sensibles.

Audit en temps réel : Surveillez tout, réagissez instantanément

Atténuer les risques dans des environnements LLM dynamiques commence par une visibilité accrue. Les capacités d’audit en temps réel permettent aux organisations de surveiller les requêtes, les réponses et les schémas d’accès aux données au fur et à mesure qu’ils se produisent. Des outils tels que les journaux d’audit DataSunrise peuvent immédiatement signaler des tentatives d’accès non autorisé aux données ou des schémas de consignes suspects.

Par exemple, une règle de sécurité pourrait détecter des tentatives répétées d’énumération de champs sensibles du schéma et déclencher des alertes via Slack ou MS Teams :

{

"event_type": "query_attempt",

"query": "SELECT * FROM information_schema.columns WHERE ...",

"action": "alert_and_block"

}

Grâce à la prise en charge des notifications en temps réel et des règles d’audit basées sur l’apprentissage, les équipes peuvent adapter la logique d’audit aux menaces évolutives liées aux LLM.

Masquage dynamique : Ne vous contentez pas de bloquer, obscurcissez

Le masquage dynamique des données protège les informations personnelles identifiables (IPI) et les champs sensibles lors des interactions avec les LLM sans compromettre la fonctionnalité des applications. Plutôt que de supprimer complètement l’accès, il substitue les valeurs réelles par des espaces réservés masqués.

Par exemple, la réponse à une requête vectorielle :

SELECT name, credit_card_number FROM customers LIMIT 1;

pourrait retourner :

John Doe | XXXX-XXXX-XXXX-1234

Cette capacité est essentielle pour les cas d’utilisation impliquant l’augmentation de consignes ou le RAG (Retrieval-Augmented Generation), où le LLM doit récupérer et synthétiser les données de l’entreprise sans enfreindre les règles de confidentialité. Le masquage dynamique dans DataSunrise permet d’appliquer des politiques fines par rôle ou en fonction du comportement du modèle.

Découverte de données : Sachez ce que vous possédez avant que les LLM ne le fassent

Avant de mettre en place des mesures de sécurité pour les LLM, il est essentiel de comprendre où résident les données sensibles. C’est là qu’interviennent des outils automatisés de découverte de données.

Le recensement des actifs de données à travers des sources non structurées, des bases de données relationnelles et des index vectoriels peut aider à prioriser les contrôles et à réduire l’exposition. L’intégration avec les pipelines de LLM garantit que seules les données conformes et classifiées sont éligibles à l’augmentation ou à l’inférence.

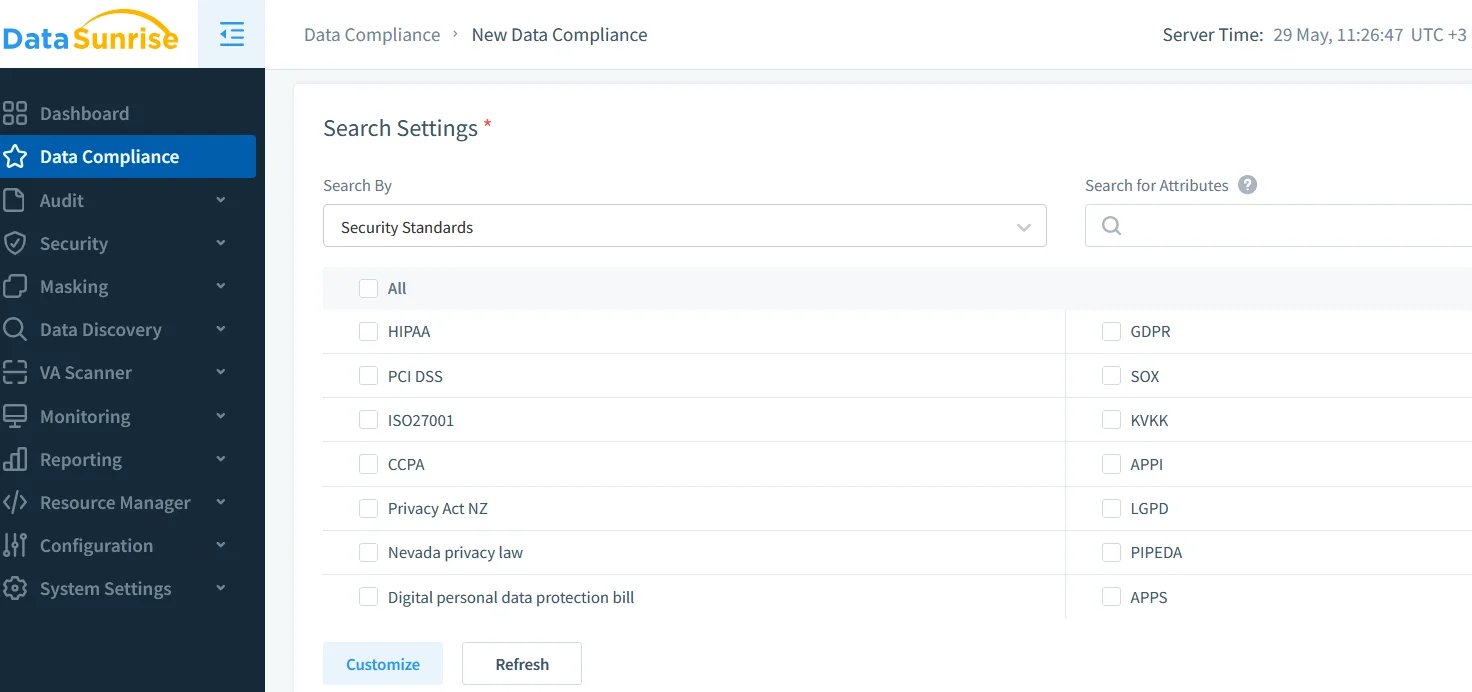

Conformité des données : Alignement de l’utilisation des LLM avec les normes mondiales

Le RGPD, la HIPAA, le PCI DSS et d’autres réglementations s’appliquent, que les données soient traitées par des humains ou par des machines. Par conséquent, intégrer les LLM dans les flux de données nécessite traçabilité, contrôle d’accès et pistes d’audit claires.

Des solutions telles que le DataSunrise Compliance Manager offrent un tableau de bord centralisé pour gérer les artefacts de conformité, les politiques de masquage et les résultats d’audit. Cela aide les organisations à réussir leurs audits et à démontrer une utilisation responsable des LLM.

De plus, la prise en charge du RGPD et de la HIPAA est intégrée aux couches d’audit et de masquage, garantissant que les résultats des LLM ne divulguent jamais d’informations de santé protégées ou des informations personnelles.

Interfaces de consignes sécurisées et contrôles basés sur les rôles

L’application du contrôle d’accès basé sur les rôles (RBAC) garantit que les consignes provenant de différents types d’utilisateurs (administrateur, analyste, API externe) sont régies par des politiques distinctes. Combiné avec des techniques de sécurité inspirées par les données (sécurité inspirée par les données), cela permet d’aligner l’utilisation des LLM aux standards de niveau entreprise.

Les systèmes de plugins sécurisés, les environnements d’exécution en sandbox et les règles de sécurité contre les injections SQL jouent également un rôle essentiel dans la protection contre les exploits courants des LLM.

Conclusion : Un avenir équilibré, audité et masqué pour GenAI

L’intégration de GenAI dans les environnements d’entreprise est inévitable, mais elle doit être réalisée de manière responsable. En adoptant le cadre de risques LLM d’OWASP, en appliquant un audit en temps réel, en utilisant le masquage dynamique, en permettant une découverte complète des données et en respectant les normes de conformité, les organisations peuvent exploiter en toute sécurité le plein potentiel de l’IA générative.

Pour en savoir plus sur la construction de systèmes GenAI sécurisés avec audit et masquage, consultez nos ressources sur la surveillance de l’activité de base de données et la sécurité des données.