Prévention des Fuites de Données pour les Pipelines GenAI et LLM

L’intelligence artificielle générative (GenAI) et les grands modèles de langage (LLM) ont transformé l’innovation basée sur les données, mais leur dépendance à d’immenses ensembles de données et à un accès guidé par des invites crée une faille dangereuse : une fuite de données incontrôlée. De l’entraînement sur des dossiers sensibles à la génération de résultats pouvant exposer involontairement des informations propriétaires ou personnelles, le risque n’est plus théorique. Prévenir la perte de données dans ces pipelines est essentiel.

Cet article explore des méthodes pratiques de Prévention des Fuites de Données pour les Pipelines GenAI et LLM, en se concentrant sur l’audit en temps réel, le masquage dynamique, la découverte de données et l’application des mesures de sécurité. Ces techniques fournissent des contrôles opérationnels qui aident les organisations à rester conformes et sécurisées sans compromettre l’innovation.

Pourquoi les outils DLP traditionnels ne suffisent pas

La plupart des systèmes conventionnels de prévention des fuites de données opèrent au niveau des fichiers. Ils surveillent les e-mails sortants, les transferts de données ou l’activité du presse-papiers et reposent sur une correspondance de motifs préétablie. Ces méthodes peinent dans les contextes GenAI où les données circulent à travers des modèles plutôt que des fichiers. Les pipelines LLM accèdent à des sources en temps réel telles que des bases de données et des API, mélangent des données sensibles et publiques, et stockent des contenus potentiellement régulés lors de l’entraînement.

Par exemple, une invite telle que « Résumez l’évaluation de performance interne du dernier trimestre » peut déclencher une fuite de données si le modèle a accès à la mémoire ou enregistre les requêtes précédentes. Cela signifie que les contrôles DLP doivent être intégrés à l’interface entre les données et le modèle. Comme le souligne le Cadre de gestion des risques liés à l’IA du NIST, les systèmes d’IA nécessitent des mesures de sauvegarde sur mesure qui évoluent en parallèle des modèles qu’ils supportent.

Découvrir les données avant de les protéger

Avant de mettre en place toute mesure préventive, les organisations doivent comprendre quelles données elles possèdent, où elles se trouvent et qui y accède. Cela commence par la découverte automatisée des données qui analyse les stockages structurés et non structurés à la recherche d’éléments sensibles tels que les informations personnelles (PII), les informations de santé (PHI) et la propriété intellectuelle.

Les outils de découverte de DataSunrise analysent en continu les champs sensibles, les associent aux exigences de conformité pertinentes et maintiennent la classification à jour. Cette visibilité proactive est essentielle avant de mettre en place des politiques d’audit ou de masquage.

Des recherches émergentes de Google DeepMind montrent que même des données d’entraînement anonymisées peuvent être ré-identifiées par les LLM, rendant la découverte précoce indispensable.

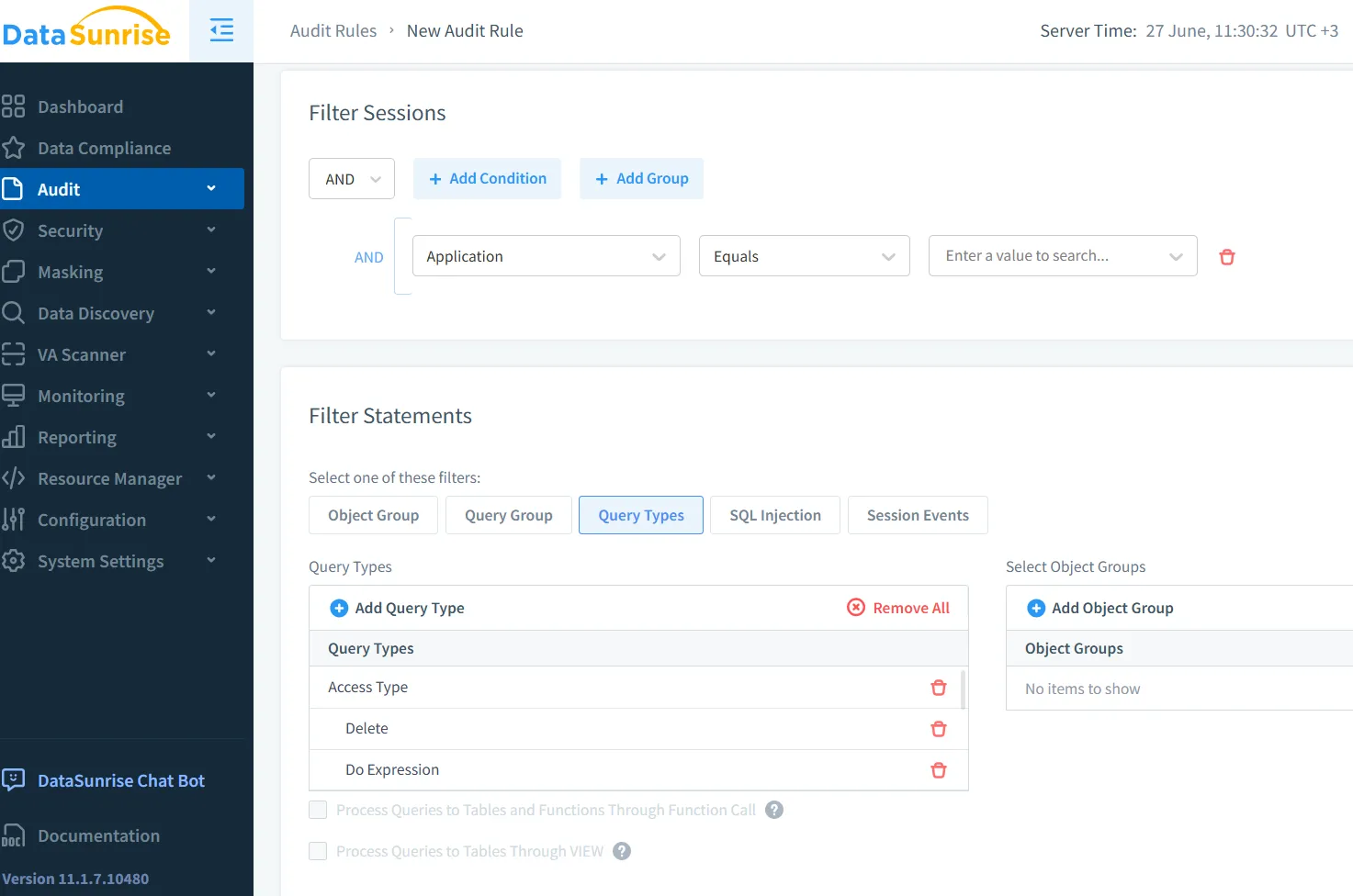

Audit en temps réel et traçabilité

Une fois la visibilité établie, l’audit en temps réel devient l’épine dorsale du déploiement sécurisé de la GenAI. Chaque requête vers le LLM, chaque interrogation de base de données et toute activité d’inférence doivent être enregistrées. La traçabilité de l’identité du demandeur, des données consultées et du résultat permet une sécurité proactive.

Prenez cet exemple de trace SQL :

SELECT customer_ssn, diagnosis FROM patient_records WHERE status = 'active';

Si émise par un compte système GenAI dépourvu d’accès aux PHI, un moteur d’audit tel que DataSunrise peut bloquer ou signaler la requête, émettant des alertes en temps réel aux analystes de sécurité. Les traces d’audit garantissent que même les interactions transitoires sont comptabilisées.

De plus, des plateformes telles que Microsoft Purview offrent une journalisation d’audit intégrée à des analyses basées sur les rôles, offrant une visibilité sur les interactions de données au niveau des utilisateurs au sein des pipelines d’IA.

Masquage des données pour une sortie sécurisée par l’IA

Le masquage statique fonctionne pour les environnements de test, mais n’est pas suffisant pour les LLM qui opèrent sur des données en direct. Les pipelines GenAI requièrent un masquage dynamique des données, qui intercepte les réponses en fonction de l’identité de l’utilisateur et des politiques.

Considérez l’invite suivante :

« Listez les clients VIP en Californie ainsi que leurs e-mails. »

Le masquage dynamique garantit que des sorties telles que :

Name: [REDACTED] | Email: [MASKED]@domain.com

sont affichées aux utilisateurs non privilégiés. Cette technique, soutenue par le masquage dynamique de DataSunrise, permet une interaction sécurisée sans compromettre l’intégrité ou la disponibilité de la base de données.

Des modèles open source tels que PySyft d’OpenMined commencent également à supporter des pipelines d’inférence préservant la confidentialité, démontrant l’attention croissante de la communauté sur ce sujet.

Application des règles de sécurité aux interfaces d’invite

Les interfaces GenAI incluent souvent des API, des bots Slack, des tableaux de bord ou des assistants internes. Ces interfaces sont vulnérables aux entrées non surveillées. L’application directe de règles de sécurité au niveau de la requête peut prévenir les exploitations.

Parmi les stratégies utiles, on compte le blocage des invites contenant des mots-clés tels que SSN, mot de passe ou informations financières, ainsi que la limitation de la fréquence d’accès. Le contrôle d’accès basé sur les rôles garantit que seuls les utilisateurs autorisés peuvent interagir avec des invites sensibles. Ces contrôles peuvent être appliqués via des politiques de sécurité intégrées à l’audit et au masquage.

De plus, l’IA constitutionnelle d’Anthropic propose d’intégrer directement les principes de sécurité dans le raisonnement du modèle, en complément des règles de sécurité basées sur le périmètre.

Conformité dans les pipelines GenAI

Des cadres de conformité tels que le RGPD, la HIPAA et la PCI-DSS imposent une gestion stricte des données personnelles et financières. Les LLM sans mécanismes d’application intégrés peuvent facilement enfreindre ces normes.

Pour rester en conformité :

- Maintenir des traces d’audit complètes pour toute l’activité GenAI.

- Masquer dynamiquement les données personnelles dans les résultats d’entraînement et d’inférence.

- Exploiter un gestionnaire de conformité pour automatiser l’application des politiques et la génération de rapports.

Les recommandations du Conseil européen de la protection des données sur l’IA renforcent la nécessité de garanties démontrables et de transparence dans tous les systèmes génératifs.

Vers une GenAI transparente et sécurisée

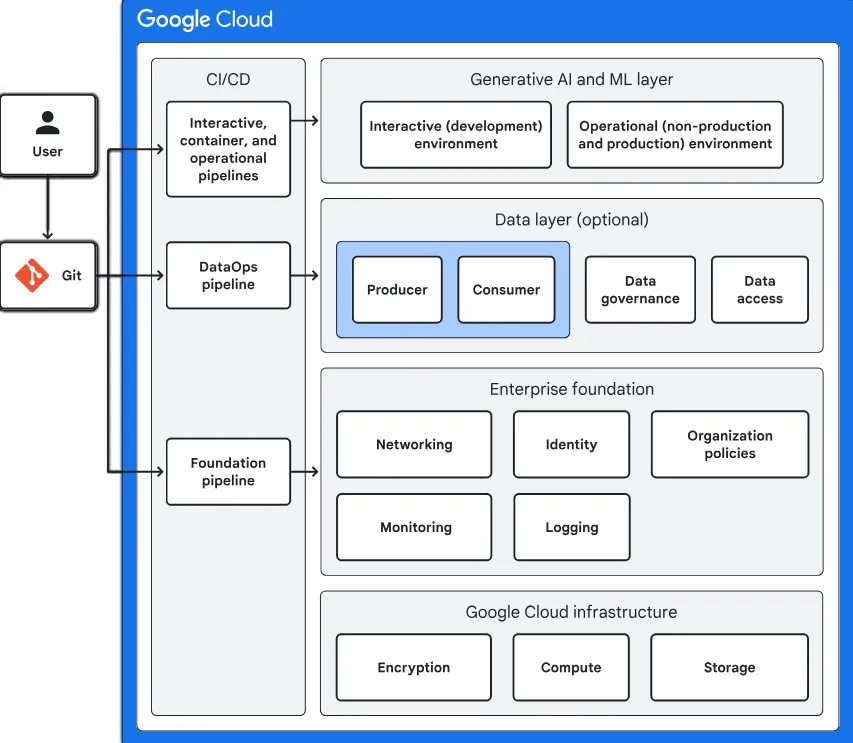

Sécuriser les pipelines GenAI nécessite plus que de combler les vulnérabilités après coup. Cela requiert une approche contextuelle où la classification des données, l’audit, le masquage et l’application des politiques sont intégrés au pipeline.

Avec des outils tels que DataSunrise, les organisations peuvent construire des applications LLM sécurisées, conformes et transparentes. L’application de la Prévention des Fuites de Données pour les Pipelines GenAI et LLM n’est pas seulement une exigence réglementaire — c’est un avantage concurrentiel qui protège à la fois l’innovation et la réputation.

Alors que la gouvernance de l’IA devient centrale tant en termes de risque que d’opportunité, adopter une DLP en temps réel et contextuelle à travers les workflows GenAI n’est plus optionnel — c’est fondamental.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant