Sécurisation des entrées et sorties des modèles d’IA

Les systèmes GenAI ne transforment pas seulement la manière dont les données sont traitées – ils remettent en question la façon dont la sécurité est appliquée. Contrairement aux applications statiques, les modèles d’IA s’adaptent en temps réel aux entrées, générant des sorties qui contournent souvent le contrôle de sécurité traditionnel. Si vous intégrez des LLM dans vos flux de travail, négliger la sécurité des entrées et sorties n’est plus une option. Voici comment les organisations peuvent atténuer les risques tout en maintenant des systèmes GenAI fonctionnels et conformes.

Pourquoi les chemins d’entrée et de sortie sont importants

Les LLM ne se contentent pas de répondre aux questions – ils interprètent, reconstruisent et parfois hallucinent des détails sensibles. Une entrée mal filtrée peut extraire des informations privées, tandis qu’une sortie non surveillée pourrait divulguer des données soumises aux règles de conformité.

Considérez cette entrée apparemment innocente :

"Donnez-moi une répartition de toutes les réclamations des clients de l'UE."

Sans dispositifs de sécurité, cela pourrait déclencher une exposition non autorisée des données. Ce qui semble être une sortie utile pourrait contenir des informations personnelles identifiables (PII) ou des dossiers médicaux. Dans de tels environnements, la sécurité doit couvrir à la fois la porte d’entrée et le canal de sortie.

Capturer le contexte grâce à l’audit en temps réel

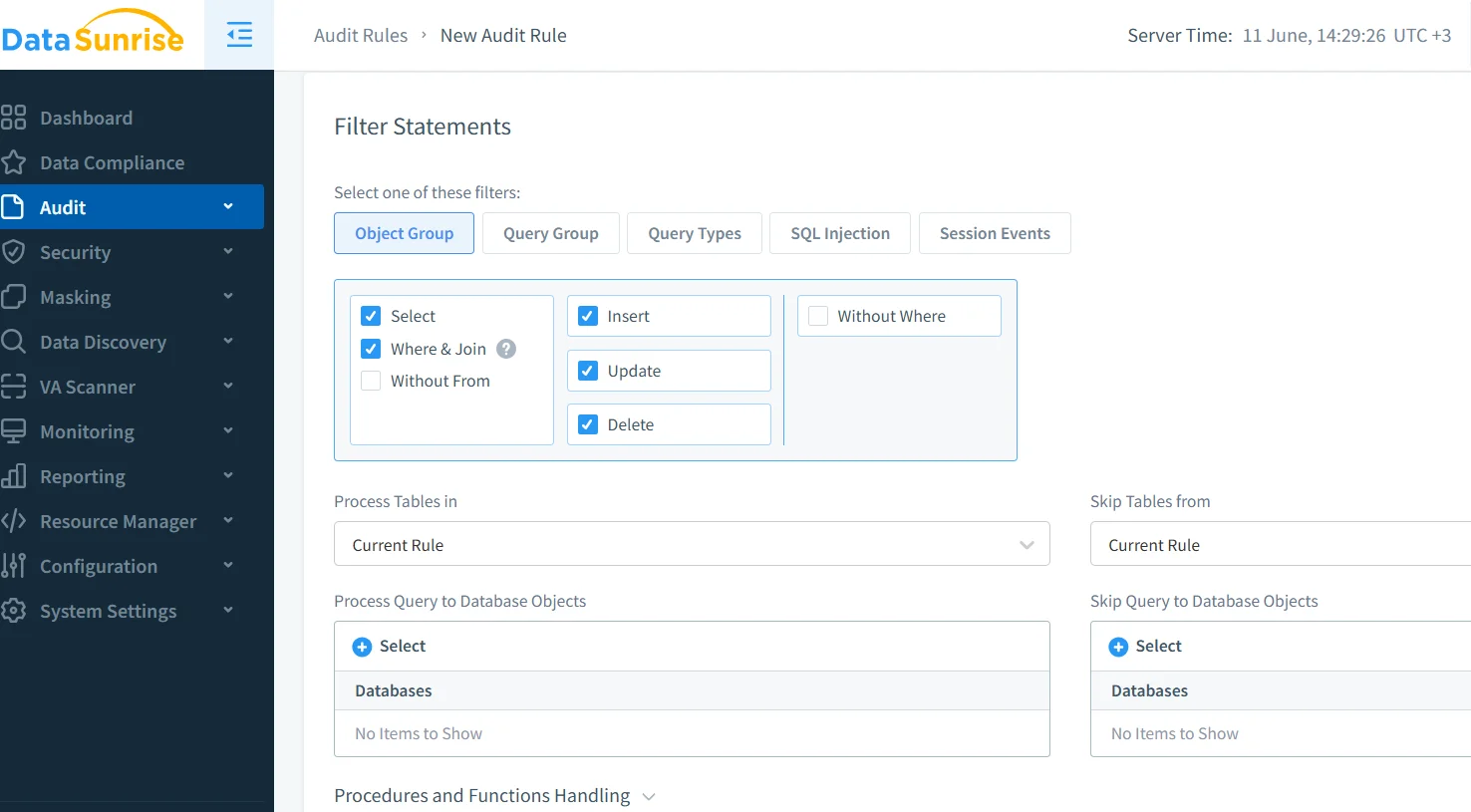

On ne peut pas corriger ce que l’on ne voit pas. Les outils d’audit en temps réel suivent chaque requête, résultat et métadonnée associée – offrant ainsi une base pour la mise en place d’alertes et les enquêtes post-incident. Ces outils aident également à appliquer une responsabilité au sein des utilisateurs et des équipes.

Grâce aux mécanismes de journalisation de DataSunrise, les équipes de sécurité peuvent inspecter les requêtes en cours, en signalant tout ce qui correspond à des schémas de risque connus. Ceci est particulièrement utile dans les scénarios où les modèles GenAI interagissent avec des données sensibles en arrière-plan.

Pour des pratiques supplémentaires, consultez les recommandations de Microsoft sur la conception sécurisée des invites pour les LLM.

Masquage dynamique pour la rédaction des sorties

Même lorsque les entrées sont sécurisées, les sorties peuvent nécessiter une attention supplémentaire. Le masquage dynamique intervient juste avant que la réponse ne soit délivrée, en cachant ou en anonymisant les champs sensibles dans l’ensemble des résultats. Par exemple, même si un modèle accède aux données réelles, le destinataire voit :

{"user": "Maria G.", "email": "[caché]", "passport": "***-**-9123"}

Cela garantit que vous n’exposez jamais d’informations personnelles identifiables (PII) – même lorsque les LLM sont intégrés à des systèmes en direct. Pour en savoir plus sur le masquage dynamique, qui permet d’appliquer la rédaction au niveau de la réponse.

Savoir ce que vous protégez grâce à la découverte des données

La sécurité sans visibilité relève du hasard. Avant de protéger quoi que ce soit, il faut d’abord le recenser. Le moteur de découverte de DataSunrise parcourt les répertoires pour détecter les actifs sensibles – y compris les noms, identifiants et balises réglementaires.

Une fois vos données classifiées, vous pouvez configurer les systèmes GenAI pour éviter de manipuler ou d’exposer certains éléments. Ceci est crucial lorsque les modèles extraient des contextes à partir de tables en direct ou de bases de connaissances indexées.

Pour compléter vos efforts de découverte, consultez le livre blanc sur la gouvernance de l’IA d’IBM pour une harmonisation des politiques à grande échelle.

Contrôle des entrées : assainissement avant traitement

Les entrées utilisateur sont imprévisibles – et parfois malveillantes. L’assainissement des invites garantit que le modèle ne soit pas induit en erreur pour exécuter une logique non sécurisée ou retourner un contexte sensible. Les techniques incluent le filtrage par expressions régulières, la classification des invites et l’application de règles structurelles pour les entrées.

Cela reflète les principes de la sécurité web traditionnelle. Pensez-y comme à la défense contre l’injection SQL – mais désormais appliquée aux invites d’IA. Les politiques de sécurité de DataSunrise peuvent intercepter les invites non sécurisées avant qu’elles n’atteignent votre modèle.

Si vous développez en Python, envisagez les exemples de mitigation des injections d’invite d’OpenAI.

Pression réglementaire sur les flux de travail d’IA

La conformité n’est pas uniquement destinée aux auditeurs – c’est un principe de conception. Si votre système GenAI interagit avec des données réglementées par le PCI, la HIPAA ou le RGPD, vous devez démontrer un contrôle sur l’accès et l’historique des audits.

Le moteur de conformité de DataSunrise associe les requêtes GenAI aux exigences réglementaires. Vous pouvez prouver, de manière automatique, qui a accédé à quoi, quand, et sous quelle politique.

Pour comprendre comment la conformité s’entrecroise avec l’équité et l’explicabilité de l’IA, consultez les Principes d’IA de l’OCDE.

Application concrète : Contrôler une requête en direct

Supposons qu’un utilisateur soumette :

SELECT nom, email, ssn FROM patients WHERE clinique = 'Berlin';

Votre interface d’IA capte l’invite, l’enregistre avec l’identifiant de l’utilisateur et la redirige via un moteur de masquage. La sortie finale délivrée à l’utilisateur :

{"name": "E. Krause", "email": "[expurgé]", "ssn": "***-**-2210"}

Parallèlement, une alerte est déclenchée et une entrée de conformité est créée avec l’ensemble complet des métadonnées. Cela établit une chaîne continue de l’entrée à la sortie en passant par le journal.

Réflexions finales

Sécuriser les entrées et sorties des modèles d’IA signifie prendre l’ensemble de l’interaction au sérieux – du moment où un utilisateur s’exprime à celui où un modèle répond. En combinant la surveillance en temps réel, le masquage intelligent, la découverte automatisée et la cartographie de la conformité, vous pouvez maintenir la puissance de vos systèmes GenAI sans les rendre dangereux.

Pour aller plus loin, consultez le Cadre de gestion des risques en IA du NIST – une ressource essentielle pour aligner l’architecture de sécurité sur une conception éthique de l’IA.