Comment sécuriser les pipelines d’IA générative

L’IA générative (GenAI) a transformé les industries en permettant la création de textes, d’images et de code semblables à ceux des humains. Mais derrière cette innovation se cache un pipeline de données sensibles, de modèles d’apprentissage automatique et de charges de travail dynamiques, de plus en plus vulnérables aux abus. Sécuriser ces pipelines est crucial pour préserver la confidentialité, garantir la confiance et assurer la conformité.

Cet article explore comment sécuriser les pipelines d’IA générative en utilisant l’audit en temps réel, le masquage dynamique des données et la découverte automatisée des données. Il inclut également un exemple de base et des liens vers d’autres ressources.

Ce qui rend les pipelines d’IA générative vulnérables

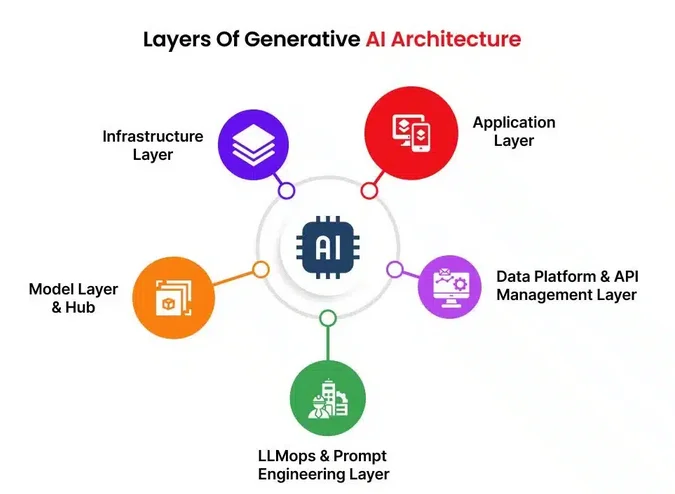

Les flux de travail GenAI impliquent généralement l’entraînement des modèles et l’inférence en utilisant d’immenses ensembles de données. Ces pipelines comprennent l’ingestion des données, leur prétraitement, l’hébergement des modèles, les invites et les sorties générées. À chaque étape, des données sensibles telles que les informations personnelles identifiables (PII), la propriété intellectuelle exclusive ou les dossiers financiers peuvent être exposées.

Parmi les vulnérabilités typiques figurent les injections d’invites, les attaques de jailbreak et l’exposition de données sensibles utilisées lors de l’entraînement ou de l’inférence. Les pipelines manquent souvent de supervision en temps réel et souffrent de pratiques de contrôle d’accès insuffisantes. Même des modèles de langage bien ajustés peuvent renvoyer des fragments de données non intentionnels provenant de la mémoire ou générer des sorties qui enfreignent les limites de conformité.

Audit en temps réel : la première ligne de défense

L’audit en temps réel permet aux organisations de surveiller chaque accès et chaque action impliquant des données, des invites ou l’utilisation de modèles. En enregistrant les requêtes et les interactions des utilisateurs, vous créez une piste de responsabilité qui soutient les enquêtes et détecte les anomalies dès leur apparition.

Un exemple de base avec PostgreSQL :

CREATE EVENT TRIGGER audit_prompt_access

ON sql_drop

EXECUTE FUNCTION log_prompt_usage();

Avec un outil tel que la surveillance de l’activité de base de données DataSunrise, vous pouvez étendre cette surveillance pour couvrir l’analyse comportementale, suivre qui a interrogé quel modèle et recevoir des alertes concernant des schémas d’entrée risqués.

Masquage dynamique des données pour les entrées et les sorties des invites

Le masquage au niveau des invites est crucial lorsqu’on travaille avec des données réglementées. Par exemple, un modèle GenAI chargé de générer un rapport ne devrait jamais voir les vrais noms des patients. Le masquage dynamique cache ou redacte des champs lors de l’exécution des requêtes, sans modifier les données sources. Cela protège les requêtes d’inférence, empêche les fuites de résultats sensibles et réduit l’étendue des dommages en cas de fuite d’invite ou de vulnérabilité de la mémoire.

Exemple :

SELECT name, diagnosis, treatment

FROM patients

WHERE region = 'EU'

MASKED WITH (name = 'XXXX', treatment = '***');

Des outils comme DataSunrise appliquent des règles dynamiques basées sur les rôles et le contexte des requêtes.

Découverte automatisée des données : savoir ce qui est en jeu

Avant de sécuriser GenAI, vous devez savoir ce que vous protégez. Les outils de découverte des données analysent automatiquement les bases de données et les pipelines pour détecter les informations personnelles identifiables (PII), les informations de santé protégées (PHI), les données PCI et tout contenu non structuré partagé avec les LLM. Ces outils peuvent également inspecter le stockage de blobs ou les bases de données vectorielles à la recherche de contenus sensibles.

En tirant parti des moteurs de découverte des données intégrés aux outils de sécurité, les organisations peuvent classifier les actifs et appliquer automatiquement des politiques de masquage ou de journalisation appropriées.

S’aligner avec les réglementations en matière de conformité des données

Que vous soyez dans le domaine de la santé, de la finance ou du commerce électronique, l’utilisation de l’IA générative doit être conforme aux lois sur la conformité des données telles que le RGPD, la HIPAA ou la norme PCI DSS.

Pour rester conforme, il est important de mettre en œuvre des contrôles d’accès basés sur les rôles, de classifier les données en fonction de leur niveau de sensibilité, et d’utiliser des pistes d’audit ainsi que des techniques de masquage pour répondre aux exigences légales. Les vérifications de conformité en temps réel servent de protection, empêchant les violations potentielles avant qu’elles ne se produisent.

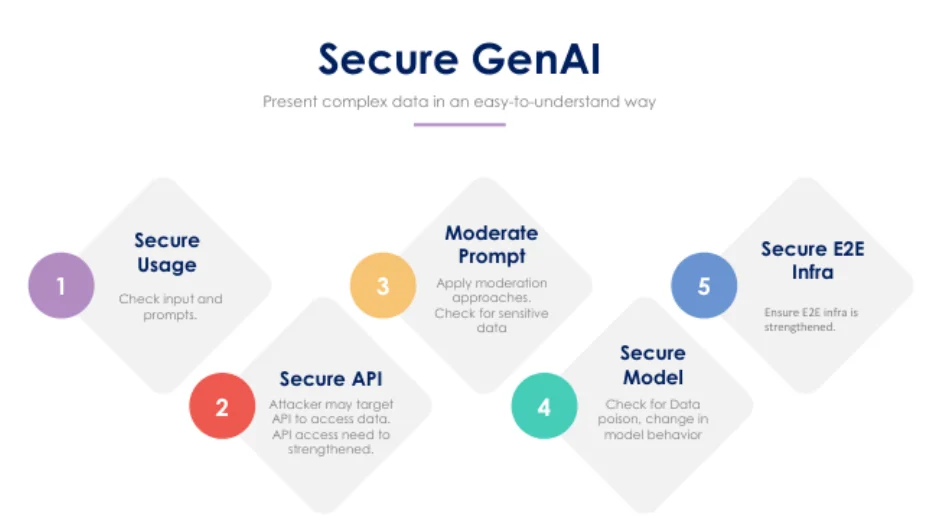

Bonnes pratiques pour la sécurité de l’IA générative

L’utilisation de proxys inverses ou de passerelles API avec filtrage aide à contrôler le trafic allant vers et depuis les modèles GenAI. En enregistrant chaque interaction avec le modèle et les données auxquelles il accède, on garantit une traçabilité. Il est tout aussi important d’établir des règles d’alerte basées sur le comportement des utilisateurs et les entrées risquées. Les invites et les réponses doivent être analysées afin de détecter des informations personnelles, et dans la mesure du possible, des données synthétiques devraient remplacer les données réelles lors des tâches d’entraînement des modèles.

Réflexions finales

À mesure que l’IA générative s’intègre davantage aux opérations commerciales, sa sécurité doit être traitée avec la même rigueur que les systèmes informatiques traditionnels. Associer l’audit en temps réel, le masquage, la découverte des données et l’application de la conformité permet de constituer une défense solide contre les violations de données et les amendes réglementaires.

Pour approfondir ces sujets, explorez :

- Outils LLM et ML pour la sécurité des bases de données

- Guide d’audit

- Politiques de sécurité pour les bases de données

Consultez également cet article d’OpenAI sur l’alignement de la sécurité des LLM et le Secure AI Framework (SAIF) de Google pour des concepts de sécurité plus larges.