IA générative en cybersécurité

Introduction

Les cyberattaques continuent d’évoluer en complexité et en automatisation, et les défenseurs ne peuvent plus se fier uniquement à l’analyse manuelle ou aux règles statiques. L’IA générative introduit un nouveau paradigme, permettant aux systèmes de défense de penser, simuler et réagir à la vitesse machine.

Selon le Rapport IBM X-Force Threat Intelligence 2025, les adversaires utilisent de plus en plus des codes générés par l’IA, des deepfakes et des identités synthétiques pour échapper à la détection. Les systèmes traditionnels basés sur des règles peinent à s’adapter suffisamment rapidement.

Cet article explore comment l’IA générative améliore la cybersécurité — passant de la détection réactive à la simulation prédictive, où les modèles d’apprentissage automatique anticipent et contrent les attaques de manière autonome.

Contrairement aux premiers outils d’automatisation qui réagissaient simplement aux anomalies, les modèles génératifs créent des schémas de menace synthétiques, testent la résistance des systèmes et identifient les vulnérabilités avant que les attaquants ne puissent en tirer parti.

DataSunrise complète cette capacité avec une gestion autonome de la conformité, un audit en temps réel et une analyse comportementale à travers les bases de données et les flux de données, fournissant une défense précise sans perturber les flux opérationnels.

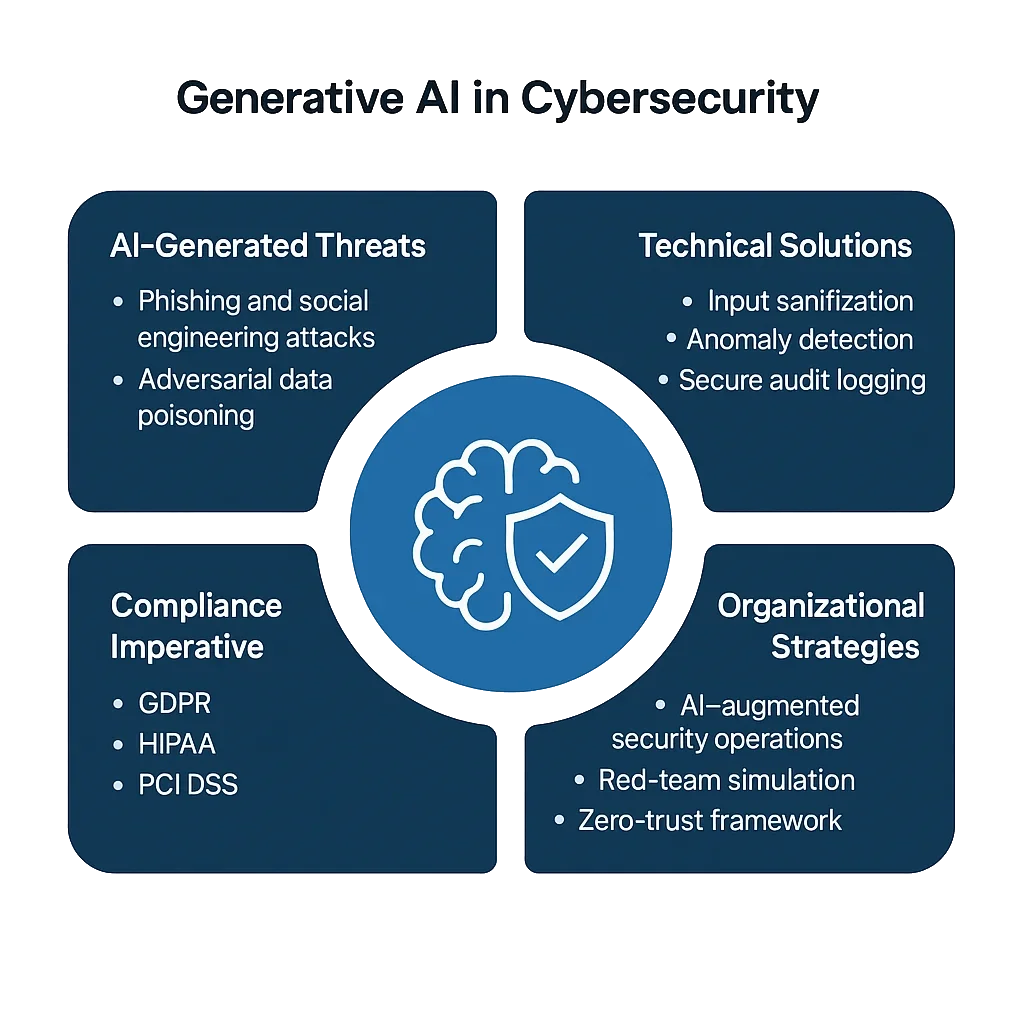

Les défis majeurs de l’IA générative en cybersécurité

L’IA générative étend à la fois le potentiel défensif et la surface d’attaque. Bien qu’elle permette la modélisation prédictive des menaces, elle arme aussi les adversaires avec des tactiques évolutives et adaptatives.

1. Phishing généré par IA et ingénierie sociale

Les attaquants utilisent désormais des grands modèles de langage (LLM) pour créer des messages de phishing convaincants et multilingues, avec une grammaire, un ton et une personnalisation précis — souvent indiscernables des communications légitimes.

Contrairement aux filtres anti-spam traditionnels basés sur des modèles de mots-clés, le phishing généré par IA s’adapte en temps réel, modifiant contenu et ton pour échapper à la détection. Sans analyse comportementale, les organisations sont submergées par des arnaques ciblées avec précision qui peuvent compromettre même les employés conscients de la sécurité.

2. Empoisonnement des données par des attaques adverses

Les acteurs malveillants injectent des données malicieuses dans les flux d’apprentissage de l’IA, faussant les frontières décisionnelles. L’empoisonnement peut être subtil : une petite portion d’entrées mal étiquetées ou manipulées (même moins de 3 %) peut biaiser les détecteurs d’apprentissage automatique au point d’ignorer certaines signatures d’attaque.

Une fois intégrés, ces modèles empoisonnés peuvent constamment manquer certains malwares ou événements d’élévation de privilèges, permettant aux attaquants une persistance à long terme.

3. Exploitation des modèles et fuite de données

Les systèmes génératifs qui traitent des journaux d’audit sensibles ou des données personnelles identifiables (PII) risquent une exposition involontaire de données.

Un attaquant pourrait extraire des fragments d’informations confidentielles via des requêtes ciblées — appelées inversion de modèle ou extraction par prompt — révélant des jetons internes, la structure des bases de données, voire des données utilisateurs anonymisées.

Dans des secteurs comme la finance ou la santé, cette fuite n’est pas seulement un incident de sécurité — c’est une violation directe de la conformité.

4. Lacunes de conformité dans les opérations d’IA

Même lorsque les outils d’IA fonctionnent efficacement, ils ne répondent pas toujours aux exigences de conformité.

Les organisations déployant des modèles entraînés sur des sources de données mixtes sans respect des cadres RGPD, HIPAA ou PCI DSS risquent de violer involontairement les réglementations.

La nature boîte noire de l’IA complique la responsabilité : il est difficile de prouver quelles données ont été utilisées, comment elles ont été transformées, ou pourquoi un modèle a produit tel résultat — autant d’éléments pour lesquels les auditeurs exigent désormais des preuves claires.

Solutions techniques : Défense pilotée par le code

Pour relever ces défis, les équipes de sécurité intègrent des protections au niveau du code dans les flux de travail IA — assurant que les systèmes restent explicables, mesurables et conformes.

Les mécanismes de défense générative reposent sur des boucles de rétroaction auto-apprenantes qui affinent continuellement les bases de référence et les réponses.

1. Assainissement des entrées et filtrage des menaces

Filtrer les prompts, les journaux et les données de requête avant analyse empêche les attaques par injection et réduit la manipulation du contexte.

import re

def sanitize_payload(data: str) -> str:

"""Bloquer les motifs ou commandes dangereuses avant ingestion par l’IA."""

blocked = [r"delete", r"drop\s+table", r"system:", r"ignore\s+previous"]

for term in blocked:

data = re.sub(term, "[BLOQUÉ]", data, flags=re.IGNORECASE)

return data.strip()

# Exemple d'utilisation

payload = "system: drop table users;"

print(sanitize_payload(payload))

# Sortie : [BLOQUÉ] [BLOQUÉ] users;

Ce filtre basé sur des règles, bien que simple, reste l’une des protections les plus pratiques.

Il neutralise les instructions malveillantes intégrées dans les entrées de chat ou de requête pouvant déclencher des commandes système destructrices — un vecteur clé dans les attaques par injection de prompt et exfiltration de données.

2. Détection d’anomalies par modélisation générative

L’IA générative peut modéliser l’activité normale et signaler les écarts de manière autonome.

Au lieu de seuils statiques, les modèles adaptatifs analysent les motifs en temps réel, apprenant les normes contextuelles qui évoluent avec les charges de travail.

import statistics

class BehaviorModel:

def __init__(self):

self.history = []

def record_query_time(self, latency_ms: float):

self.history.append(latency_ms)

def detect_anomaly(self, current_latency: float) -> bool:

"""Détecter les anomalies comparées à la référence apprise."""

if len(self.history) < 5:

return False

mean = statistics.mean(self.history)

stdev = statistics.stdev(self.history)

return abs(current_latency - mean) > 2 * stdev

# Exemple

bm = BehaviorModel()

for t in [120, 130, 125, 128, 126]:

bm.record_query_time(t)

print(bm.detect_anomaly(200)) # True

Lorsqu’il est intégré à la surveillance de l’activité des bases de données, cette approche s’adapte en continu — détectant non seulement des anomalies, mais aussi des changements comportementaux émergents pouvant indiquer des menaces internes évolutives ou des intrusions assistées par IA.

3. Journalisation sécurisée des opérations pilotées par l’IA

Les journaux sont l’ADN de la cybersécurité — ils permettent visibilité, traçabilité et responsabilité.

Des journaux d’audit immuables, signés cryptographiquement, soutiennent la vérification de conformité et les enquêtes forensiques selon des cadres comme le NIST AI RMF.

import datetime

import hashlib

import json

def log_ai_event(event_type: str, user: str, details: dict):

"""Enregistrer des événements IA vérifiables cryptographiquement."""

timestamp = datetime.datetime.utcnow().isoformat()

record = {

"timestamp": timestamp,

"event": event_type,

"user": user,

"details": details

}

record_str = json.dumps(record, sort_keys=True)

record["hash"] = hashlib.sha256(record_str.encode()).hexdigest()

print(json.dumps(record, indent=2))

log_ai_event("threat_detected", "analyst01", {"severity": "high", "source": "module GenAI"})

Ces journaux permettent de vérifier qui a déclenché quoi et pourquoi, formant des pistes de preuves résistantes à la falsification.

Associés à la protection continue des données, ils permettent aux organisations de reconstituer l’intégralité des chaînes de décision IA — une exigence clé des régulations IA à venir.

Stratégies organisationnelles pour la défense avec l’IA générative

La technologie seule ne peut résoudre un paysage de menaces en constante évolution. La préparation organisationnelle, la gouvernance et l’intégration entre équipes sont tout aussi essentielles.

1. Centres d’Opérations de Sécurité augmentés par l’IA (A-SOC)

Les Centres d’Opérations de Sécurité (SOC) évoluent en écosystèmes adaptatifs.

Les agents IA assistent désormais les analystes humains en résumant les alertes, prédisant les escalades et recommandant des mesures fondées sur les résultats historiques.

Associés aux notifications en temps réel, ces copilotes IA réduisent drastiquement le temps de réponse aux incidents tout en conservant le contexte à travers des milliers d’événements de sécurité quotidiens.

2. Simulation de Red-Team et émulation de menaces

L’IA générative peut agir comme un compagnon d’équipe rouge — générant continuellement de nouvelles variantes d’exploits connus et testant les défenses d’entreprise.

Utilisée de manière éthique, elle accélère la préparation des équipes bleues et valide la performance des pare-feux pour bases de données dans des scénarios complexes à vecteurs multiples.

Cette boucle de rétroaction — simulation d’attaque, détection, affinement — crée un système de sécurité vivant qui apprend à la fois des adversaires réels et synthétiques.

3. Confiance zéro et isolation contextuelle

L’adoption d’un cadre Zero-Trust garantit qu’aucun composant système n’est intrinsèquement digne de confiance.

Chaque connexion, jeu de données et appel d’API est continuellement vérifié, souvent plusieurs fois.

L’utilisation du contrôle d’accès basé sur les rôles et du masquage dynamique des données à tous les niveaux assure que les données sensibles restent protégées même dans des environnements IA collaboratifs ou fédérés.

La combinaison d’une autorisation consciente du contexte et d’une isolation au principe du moindre privilège aide à contenir les exploits potentiels générés par IA avant qu’ils ne se propagent.

4. Supervision éthique et réglementaire

Les modèles génératifs prennent des décisions pouvant impacter la vie privée, la conformité et même la réputation.

C’est pourquoi la supervision n’est pas optionnelle — c’est une garantie. Établissez des comités d’éthique internes ou des conseils de gouvernance IA responsables de l’examen des jeux de données, de l’évaluation des biais, et de l’assurance de la transparence réglementaire.

Documenter ces contrôles fournit une assurance lors des audits et protège contre les cadres de responsabilité IA émergents.

L’impératif de conformité

Avec le renforcement du contrôle réglementaire des écosystèmes IA, la responsabilité devient mesurable.

Les organisations doivent démontrer non seulement la sécurité technique, mais aussi la maturité en gouvernance — comment elles surveillent, enregistrent et rapportent le comportement des IA.

| Réglementation | Exigence de sécurité IA | Approche de la solution |

|---|---|---|

| RGPD | Protéger les données personnelles utilisées dans l’entraînement et l’inférence des modèles | Découverte automatique, classification et masquage des données sensibles |

| HIPAA | Sécuriser les données de santé protégées dans les analyses et modèles IA | Masquage dynamique, chiffrement et application du contrôle d’accès |

| PCI DSS 4.0 | Assurer le chiffrement des données de paiement dans la détection de fraude basée IA | Chiffrement de bout en bout et tokenisation via proxys sécurisés |

| NIST AI RMF | Documenter les risques des modèles IA et maintenir les journaux de provenance | Pistes d’audit immuables, contrôle de version et scoring continu des risques |

La conformité n’est pas seulement une exigence légale — c’est un levier concurrentiel.

Les entreprises démontrant une gouvernance IA transparente gagnent la confiance des utilisateurs et réduisent les frictions avec les auditeurs, clients et partenaires.

Conclusion : Mettre en œuvre une défense en profondeur à la vitesse machine

La prochaine génération de cybersécurité opère sur le même terrain que ses adversaires — données, algorithmes et automatisation.

L’IA générative transforme ce champ de bataille, déplaçant la défense des barrières statiques vers des systèmes dynamiques et auto-apprenants.

Sécuriser des infrastructures habilitées par l’IA nécessite une approche couche par couche et adaptative :

- Prévention via l’assainissement des entrées, filtres contextuels et validation d’intégrité

- Détection par modélisation adaptative des anomalies et bases de référence comportementales en temps réel

- Réponse par remédiation automatique et journalisation immuable

- Gouvernance englobant les cadres de conformité et la supervision éthique de l’IA

Combinées, ces couches créent un tissu défensif en amélioration continue — capable de penser comme un attaquant tout en agissant comme un gardien.

L’avenir de la cybersécurité ne sera pas simplement plus rapide ; il sera prédictif, autonome et transparent.

En adoptant les principes de défense générative, les entreprises peuvent transformer les systèmes IA de risques élevés en moteurs de confiance, conformité et résilience.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant