Mesures de sécurité pour les systèmes d’IA générative

Alors que l’IA générative continue de transformer des industries allant de la finance à la santé, ses implications en matière de sécurité se développent tout aussi rapidement. Ces systèmes traitent d’énormes quantités d’informations sensibles, et s’ils ne sont pas protégés, ils peuvent devenir une porte d’entrée aux fuites de données, aux attaques par injection de requêtes ou à l’exposition non autorisée d’informations. Dans cet article, nous explorons les mesures de sécurité essentielles pour les systèmes d’IA générative – en mettant l’accent sur l’audit en temps réel, le masquage dynamique, la découverte des données et l’application de la conformité – afin de garantir que ces modèles puissants fonctionnent en toute sécurité.

Pourquoi l’IA générative a besoin d’une sécurité spécialisée

Contrairement aux applications traditionnelles, les systèmes d’IA générative apprennent à partir de jeux de données historiques et interagissent par le biais d’instructions ouvertes. Ils peuvent accéder à des données confidentielles saisies par les utilisateurs ou à des informations sensibles commerciales pour produire des réponses. Ce modèle d’interaction présente deux risques principaux : la fuite involontaire de données dans les résultats du modèle et l’accès en coulisse à des bases de données sensibles.

Pour faire face à ces risques, les contrôles de sécurité doivent s’intégrer directement aux pipelines de données de l’IA. Cela inclut non seulement une surveillance en surface, mais également des techniques sensibles au contexte telles que l’analyse comportementale, le masquage dynamique des données et une gestion approfondie des journaux d’audit.

Audit en temps réel des interactions avec l’IA

Les journaux d’audit en temps réel constituent la base de toute sécurité dans un système d’IA. Chaque interaction – la requête soumise, le modèle utilisé et la source de données interrogée – doit être enregistrée avec précision. Cela permet aux équipes de sécurité de reconstituer l’activité et de remonter tout comportement non autorisé jusqu’à des utilisateurs spécifiques ou à des schémas de requêtes particuliers.

Des outils tels que la surveillance de l’activité des bases de données de DataSunrise permettent un suivi continu et peuvent être intégrés aux plateformes SIEM pour déclencher des alertes en cas d’anomalies. Cela peut inclure des tentatives répétées de requêtes, des taux de requête inhabituels ou un accès inattendu à des colonnes protégées.

Exemple (déclencheur de capture de journal de type PostgreSQL) :

CREATE OR REPLACE FUNCTION log_prompt_event()

RETURNS TRIGGER AS $$

BEGIN

INSERT INTO ai_audit_log(user_id, prompt_text, access_time)

VALUES (current_user, NEW.prompt, NOW());

RETURN NEW;

END;

$$ LANGUAGE plpgsql;

Masquage dynamique des données dans les pipelines d’IA

Les modèles d’IA générative travaillant avec des bases de données en direct peuvent, sans intention, faire apparaître des informations privées dans leurs réponses. Le masquage dynamique des données aide à prévenir ce risque en modifiant la présentation des données en fonction du contexte. Par exemple, un modèle accédant à une base de données financière pourrait renvoyer des valeurs masquées comme ****-****-****-1234 lorsqu’il référence des numéros de cartes de crédit, garantissant ainsi que le contenu original demeure protégé.

Le masquage dynamique des données peut être appliqué lors de l’exécution des requêtes ou dans la couche de réponse du système d’IA. La documentation de Microsoft sur le masquage dynamique des données fournit des indications supplémentaires pour sa mise en œuvre.

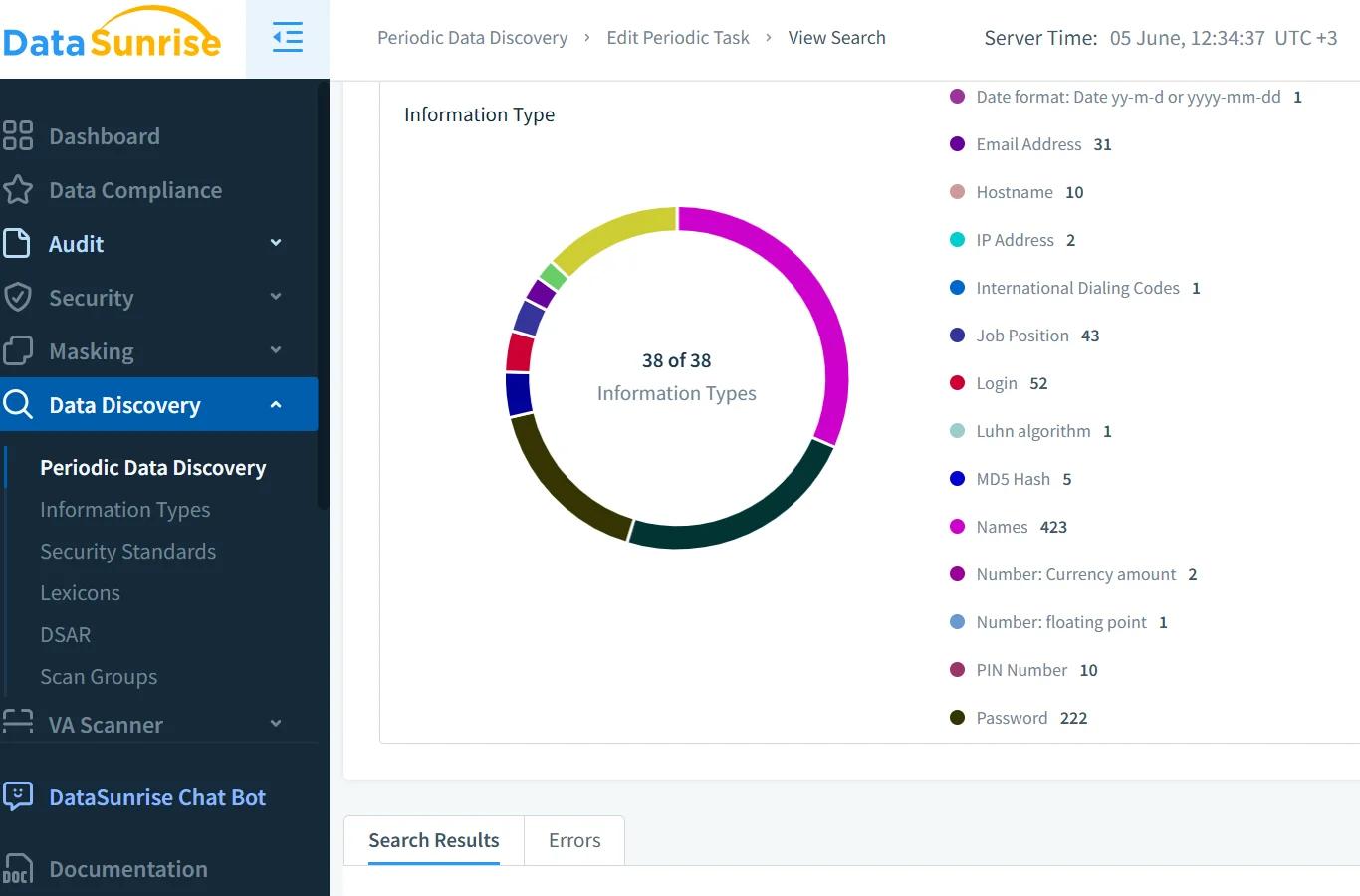

Découverte et classification des données avant l’accès au modèle

Avant que les modèles génératifs n’accèdent aux données structurées, il est essentiel de classifier le contenu sensible. Les informations personnelles identifiables (PII), les informations de santé protégées (PHI) et les identifiants financiers doivent être repérés à l’avance. Cela s’effectue grâce à des outils automatisés de découverte des données qui analysent les tables, les colonnes et le contenu des fichiers.

Grâce à l’outil de découverte de DataSunrise et à des plateformes natives du cloud telles que Google Cloud DLP, les organisations peuvent systématiquement étiqueter les données et leur assigner les politiques de traitement appropriées.

Application de la conformité des données dans les workflows des modèles de grande taille

L’IA générative doit fonctionner dans le respect des cadres réglementaires comme le RGPD, HIPAA et PCI DSS. Ces règles définissent la manière dont les données doivent être accédées, masquées, auditées et rapportées.

Le DataSunrise Compliance Manager simplifie l’application de ces règles en mappant les privilèges d’accès aux exigences propres à chaque réglementation. Il peut également générer des rapports adaptés aux audits et mettre en évidence en temps réel toute violation. Des approches complémentaires issues des directives d’éthique de l’IA d’IBM renforcent ce cadre pour des opérations IA transparentes et responsables.

Règles de sécurité et gouvernance des accès

Les environnements d’IA générative bénéficient de politiques de sécurité granulaires. Au-delà du traditionnel RBAC, la sécurité doit englober la reconnaissance des intentions et le profilage comportemental. Un utilisateur tentant d’extraire des enregistrements privés via des instructions ambiguës – plutôt qu’à travers des requêtes explicites – pourrait contourner les contrôles de base.

C’est pourquoi des règles renforcées de mitigation des injections SQL et une sécurité adaptative sont essentielles. Elles permettent aux systèmes de détecter tout usage abusif en analysant les schémas des requêtes, le timing des accès et les écarts par rapport au comportement habituel.

Perspective d’avenir : Une IA plus intelligente, une sécurité plus intelligente

L’avenir de la sécurité de l’IA repose sur la conscience du contexte. Les bases de données vectorielles, les plugins tiers et les interfaces de flux de données ouvrent de nouvelles surfaces de risque. Pour les atténuer, les organisations adoptent la détection d’anomalies comportementales, des alertes en temps réel et un filtrage en plusieurs couches des sorties.

Des ressources telles que le tableau de bord Responsible AI de Microsoft et la méthodologie des cartes système d’OpenAI aident les équipes à cartographier les schémas d’accès aux modèles. Des plateformes comme DataSunrise supportent l’application des politiques et l’audit dans le cadre d’une stratégie de sécurité plus globale.

Conclusion

L’essor des modèles de grande taille a redéfini l’aspect qu’une infrastructure sécurisée doit présenter. Des traces d’audit robustes, un masquage dynamique, une découverte approfondie des données sensibles et une conformité en temps réel sont désormais essentiels – et non optionnels.

En déployant ces mesures de sécurité pour les systèmes d’IA générative, vous jetez les bases d’une IA responsable et réduisez le risque de retombées réputationnelles ou juridiques.

Explorez le centre de connaissances DataSunrise et complétez votre stratégie de sécurité avec des cadres tels que le NIST AI RMF, l’ISO/IEC 23894 ou les Principes de l’OCDE sur l’IA.