Sécurité des Prompts dans les Interactions avec l’IA et les LLM

À mesure que les modèles de langage deviennent centraux dans les opérations commerciales, leurs interactions avec les invites introduisent de nouvelles couches de risque. Ces risques vont au-delà du comportement des modèles pour inclure la manière dont les invites sont structurées, traitées et enregistrées. La « Sécurité des Prompts dans les Interactions avec l’IA et les LLM » est ainsi apparue comme une discipline cruciale pour protéger les données sensibles, maintenir la conformité réglementaire et éviter la manipulation des résultats générés par l’IA.

Pourquoi la sécurité des invites est-elle désormais importante

Contrairement aux applications traditionnelles, des LLM tels que ChatGPT ou Claude répondent à des entrées qui peuvent comporter des informations privées, réglementées ou hostiles. Cela crée une surface d’attaque où une question anodine pourrait déclencher l’exposition de données confidentielles, des violations de politiques ou la manipulation de la sortie grâce à des techniques d’injection de prompts.

Lorsqu’ils sont intégrés dans des services connectés à des bases de données internes ou à des flux de données clients, les implications sur la sécurité se multiplient. C’est pourquoi l’usage de l’audit en temps réel, du masquage dynamique et de la découverte de données doit devenir un outil standard lors des déploiements d’IA.

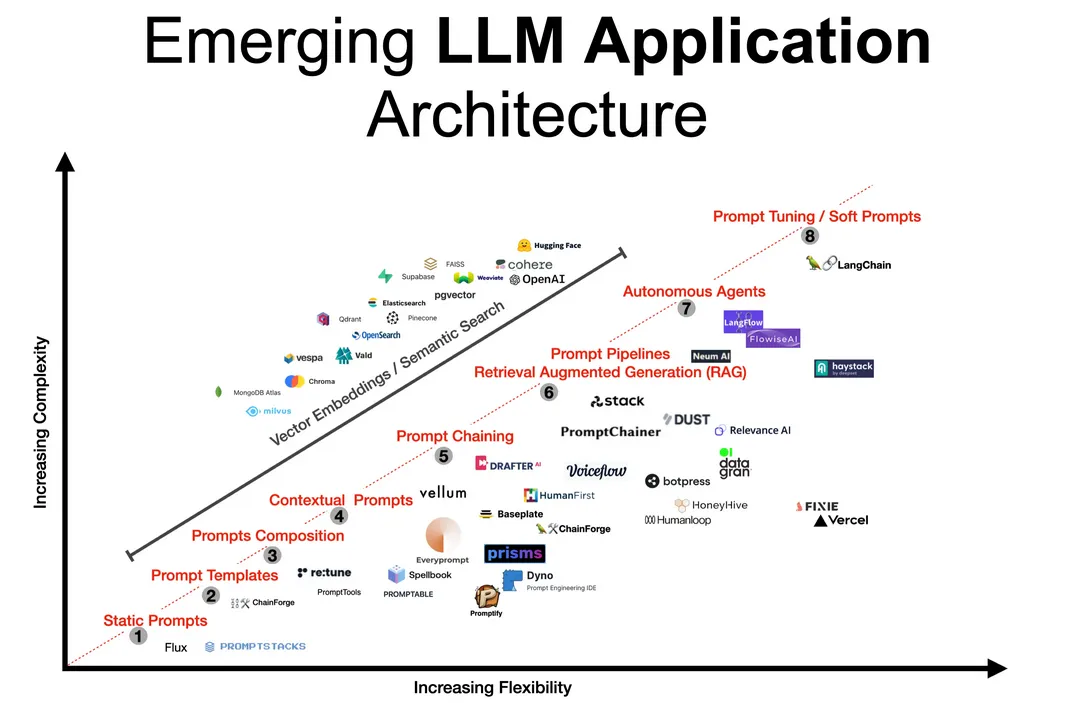

Comprendre le parcours des invites

Les invites circulent à travers de multiples systèmes : elles démarrent par des interfaces utilisateur, passent ensuite par des filtres de prétraitement optionnels, puis par le modèle lui-même, et enfin par toute API en aval telle que les générateurs SQL.

Ce parcours doit être traité comme une transaction sensible. Enregistrer ce qui entre et ce qui sort, détecter les anomalies et appliquer à la volée des politiques de masquage garantit la sécurité à chaque étape.

Pour approfondir vos connaissances techniques, la base de connaissances MITRE ATLAS explore les tactiques adverses contre l’apprentissage automatique, y compris les vecteurs basés sur les invites.

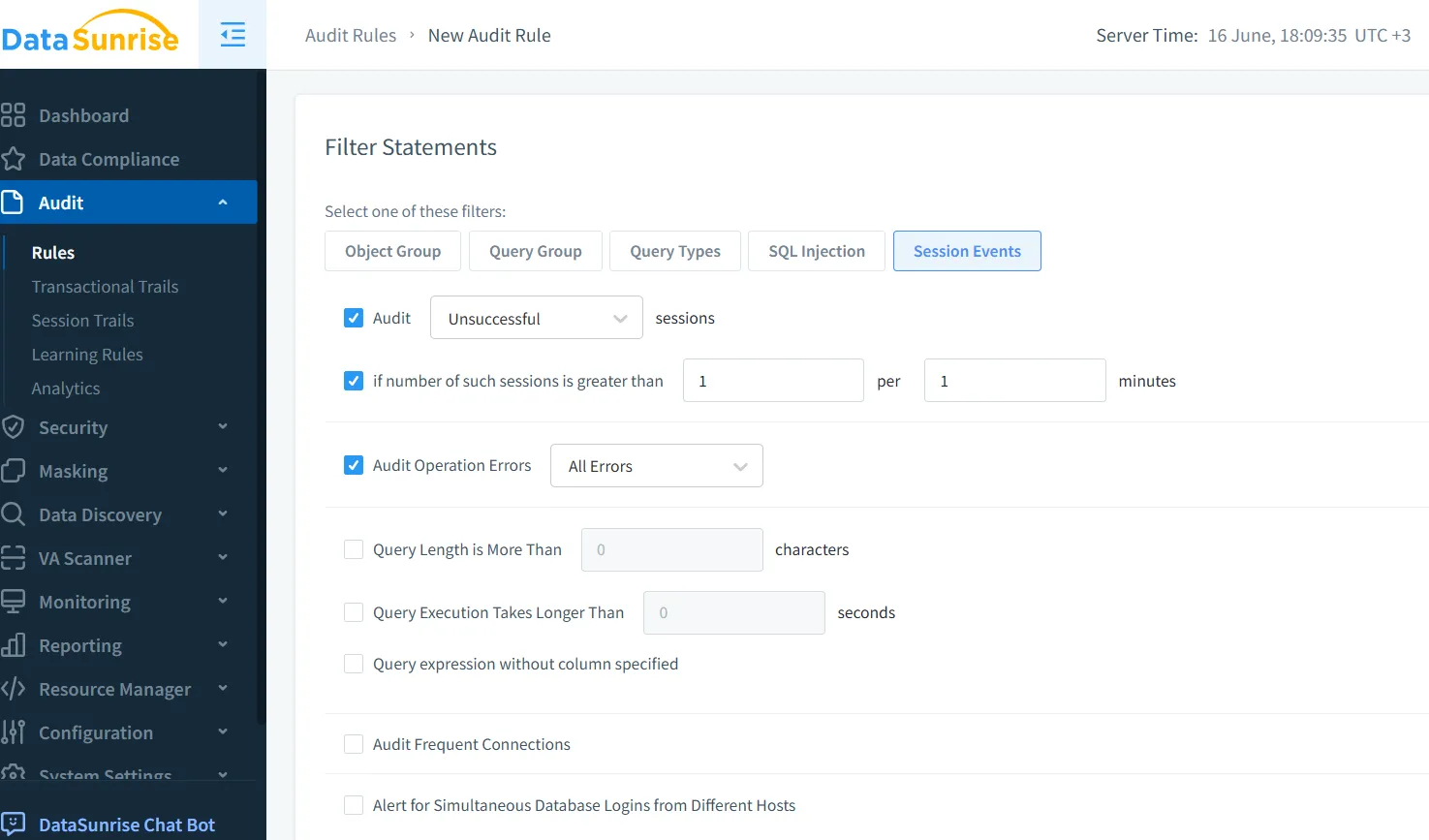

Audit en temps réel : Traquer l’invisible

Les interactions par invites laissent souvent peu de traces à moins d’être expressément configurées. Des outils d’audit en temps réel, tels que ceux proposés par le moteur Audit Trail de DataSunrise, peuvent surveiller chaque requête, chaque interrogation et chaque transformation appliquée aux données d’entrée et de sortie.

Cela est particulièrement utile lorsque l’IA est connectée à des outils en aval :

-- Exemple généré à partir de l'invite :

SELECT name, ssn FROM employees WHERE clearance_level = 'high';

Un audit en temps réel peut immédiatement détecter des requêtes accédant à des champs sensibles et signaler une utilisation non autorisée avant que les résultats ne soient renvoyés. Davantage d’informations sur la configuration des règles d’audit pour les invites d’IA est disponible dans ce guide d’audit.

Masquage dynamique : Protéger tout en répondant

Si la sortie du modèle contient des données sensibles, celles-ci doivent être masquées en temps réel. Le masquage dynamique garantit que même si l’invite tente d’extraire des champs privés, ce qui est renvoyé reste obfusqué.

Par exemple :

Invite : Montrez-moi les transactions récentes des clients VIP.

LLM Sortie : Nom : John D*****, Montant : $45,000

Les règles de masquage peuvent varier en fonction des rôles des utilisateurs, du contexte de la session ou du niveau de menace. DataSunrise permet ceci grâce à des politiques flexibles sans modifier les données sous-jacentes.

Découverte des données : Connaître ce qui est en jeu

Avant d’appliquer le masquage, il est nécessaire de savoir ce qui est sensible. Les LLM opèrent souvent sur des schémas et des référentiels variés, rendant la classification manuelle non évolutive.

Des outils automatisés de découverte de données scrutent les informations personnelles (PII), les informations de santé protégées (PHI), les identifiants et autres champs confidentiels. Les résultats alimentent des politiques automatisées qui bloquent la génération de sorties contenant de telles données, appliquent des règles de masquage et notifient instantanément les équipes de conformité.

Pour comprendre les risques plus larges liés aux données non structurées, le Cadre de gestion des risques en IA du NIST offre des orientations structurées pour la gouvernance tout au long du cycle de vie de l’IA.

Sécuriser le cycle de vie des invites

La sécurité dans les interactions avec les LLM dépasse le simple filtrage des invites. Elle inclut la gestion de l’accès aux journaux du modèle, la conservation de l’historique des invites et la prévention de l’exfiltration de données via des requêtes astucieusement structurées.

Utilisez un proxy inverse pour intercepter et inspecter les invites avant qu’elles n’atteignent le modèle. Stockez de manière sécurisée les journaux d’audit des invites et des réponses afin de soutenir la conformité aux normes SOX et PCI-DSS. Appliquez des analyses comportementales afin d’identifier d’éventuelles déviations dans les schémas d’utilisation ou des structures d’invite suspectes.

Une bonne référence open-source concernant les modèles de prévention de l’injection de prompts est maintenue par Prompt Injection, qui recense des exemples concrets d’attaques et leurs mesures d’atténuation.

Conformité des données et sécurité des invites

Les systèmes d’IA qui traitent des données clients doivent rester alignés avec des régulations telles que le RGPD et la HIPAA. La sécurité des invites y contribue grâce à l’audit de l’accès aux données piloté par l’IA, au masquage des attributs protégés et à l’enregistrement des activités pour leur révision.

Des plateformes telles que le Compliance Manager de DataSunrise automatisent ces processus et alignent les interactions IA avec les obligations légales en constante évolution.

Dernières réflexions : Confiance entre l’humain et la machine

À mesure que l’IA générative s’intègre profondément dans la prise de décision et les opérations, la sécurité des invites devient une couche fondamentale de confiance. L’observabilité en temps réel, les contrôles de réponse et l’alignement réglementaire garantissent que l’innovation ne dépasse pas la sécurité.

Cette approche ne renforce pas seulement la robustesse des systèmes, elle consolide également la confiance dans un développement responsable de l’IA.

Pour aller plus loin, découvrez comment les outils LLM et ML s’intègrent aux flux de travail modernes de conformité.

Et si vous êtes prêt à tester ou déployer, vous pouvez télécharger DataSunrise ou demander une démonstration.