Stratégies de Contrôle d’Accès dans les Systèmes GenAI et LLM

Alors que l’IA générative et les grands modèles de langage (LLM) deviennent essentiels pour les opérations des entreprises, sécuriser l’accès à leurs données sous-jacentes n’est plus facultatif. Ces systèmes ingèrent, traitent et génèrent des insights basés sur des ensembles de données de grande valeur, incluant souvent des informations personnelles, propriétaires ou réglementées. Sans un contrôle d’accès efficace, les organisations risquent des fuites de données, des violations de conformité et la contamination en aval des modèles.

Les Défis du Contrôle d’Accès dans GenAI

Contrairement aux bases de données traditionnelles, les systèmes GenAI traitent des données non structurées et semi-structurées, rendant insuffisants les contrôles basés sur le périmètre. Une simple requête peut déclencher plusieurs niveaux de recherches vectorielles, de génération augmentée par récupération (RAG) et de synthèse. L’accès doit être contrôlé à chaque étape : ingestion de la requête, interrogation du magasin vectoriel, traitement par le modèle et production des résultats. Cette complexité exige des stratégies de sécurité granulaires et adaptatives.

Le besoin de contrôles multicouches dans les charges de travail d’IA est également souligné dans des ressources telles que le Cadre Sécurisé d’IA (SAIF) de Google et le Cadre de Gestion des Risques pour l’IA du NIST, qui recommandent la transparence, la gouvernance et la traçabilité comme principes fondamentaux.

Contrôles d’Accès Dynamiques avec Audit en Temps Réel

Les systèmes d’IA modernes bénéficient de la surveillance en temps réel de l’activité de la base de données, permettant aux organisations de détecter et bloquer les requêtes non autorisées au moment où elles se produisent. L’audit en temps réel enregistre non seulement chaque interaction, mais permet également de déclencher des alertes basées sur le comportement et d’appliquer les politiques. Par exemple, si un utilisateur interroge de manière inattendue des enregistrements de haute sensibilité ou utilise une structure d’entrée inhabituelle, le système peut suspendre l’exécution ou masquer automatiquement les résultats.

-- Exemple de règle d'audit basée sur une politique dans PostgreSQL avec pgAudit

ALTER SYSTEM SET pgaudit.log = 'all';

-- En combinaison avec la journalisation du magasin vectoriel :

INSERT INTO audit_logs (timestamp, user_id, action, query)

VALUES (NOW(), current_user, 'embedding_lookup', 'SELECT * FROM vector_index WHERE ...');

Les journaux d’audit peuvent être transférés vers des systèmes SIEM ou intégrés avec des solutions telles que les fonctionnalités d’apprentissage des règles et d’alerte de DataSunrise pour une défense proactive. Pour les applications LLM natives sur le cloud, des plateformes comme Azure Monitor et Amazon CloudWatch supportent également l’inspection et la remédiation en temps réel.

Masquage Dynamique des Données pour la Protection des Requêtes et des Résultats

Une méthode efficace pour protéger le contenu sensible dans les entrées comme dans les sorties est le masquage dynamique des données. Par exemple, lorsqu’une requête inclut des identifiants personnels ou des relevés financiers, le masquage garantit que les LLM peuvent effectuer des tâches pertinentes (comme la classification ou la synthèse) sans exposer les données brutes aux utilisateurs, ni même au modèle sous forme de texte clair.

-- Règle pseudo pour masquer le numéro de carte de crédit avant de le fournir au modèle

IF query CONTAINS 'credit_card_number' THEN

MASK 'credit_card_number' USING 'XXXX-XXXX-XXXX-####';

END IF;

Cette approche permet aux LLM de maintenir leur fonctionnalité tout en minimisant l’exposition, ce qui est particulièrement utile dans les services clients, les ressources humaines et les flux de travail de documents juridiques. Des projets open source tels que Presidio de Microsoft démontrent comment le masquage et l’anonymisation peuvent être intégrés dans les pipelines NLP.

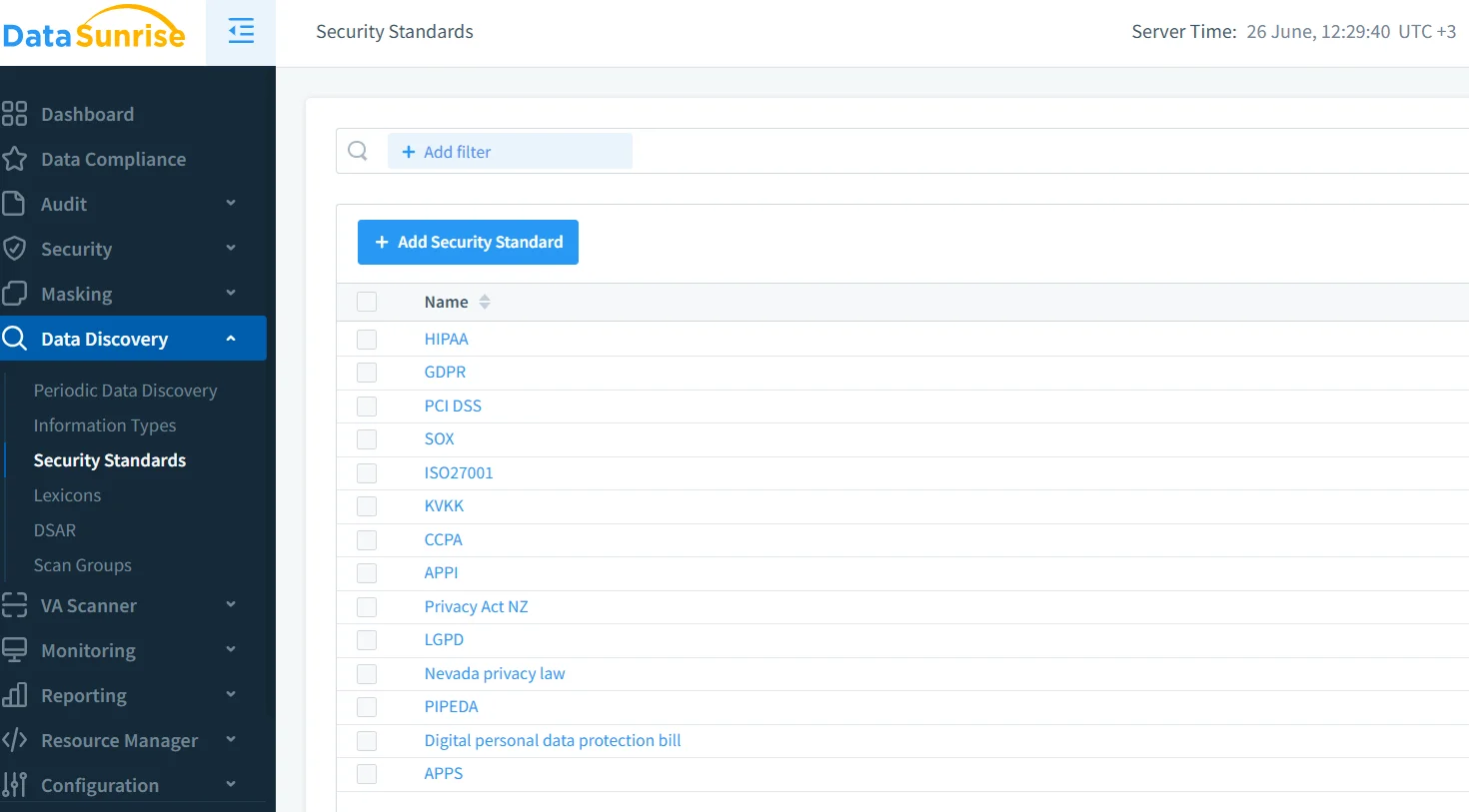

Découverte de Données pour Classifier et Gérer les Sources d’Entrée

Le contrôle d’accès commence par la visibilité. Les outils de découverte de données peuvent automatiquement scanner les bases de données, les magasins d’objets et les dépôts de documents pour classifier les champs sensibles avant même qu’ils n’atteignent le modèle. Cela inclut les données personnelles identifiables (PII), les informations de santé protégées (PHI), les données financières, le code source ou la propriété intellectuelle.

Associés aux pipelines d’IA, les actifs découverts peuvent être étiquetés, segmentés ou acheminés via différents flux de traitement selon leur classification. Cela garantit que les documents non sensibles sont traités avec plus de liberté tandis que les contenus à haut risque déclenchent des politiques plus strictes. Des principes similaires sont énoncés dans le Playbook de Gouvernance de l’IA d’IBM pour la gestion des données structurées et non structurées dans les industries réglementées.

Alignement sur la Conformité et Application des Politiques

Des réglementations telles que le RGPD, la HIPAA et la norme PCI DSS imposent des règles spécifiques concernant l’accès aux données, leur conservation et leur manipulation. Pour les systèmes d’IA, ces exigences s’étendent aux ensembles de données d’entraînement, aux inférences des modèles et aux journaux. Les responsables de conformité doivent intégrer directement ces exigences dans la logique de contrôle d’accès.

Par exemple, une plateforme LLM alignée sur le RGPD pourrait :

- Masquer les identifiants des utilisateurs dans les requêtes, sauf en cas de consentement explicite

- Faire expirer les journaux d’inférence après 30 jours

- Restreindre l’utilisation du modèle par région ou domaine légal

En utilisant des outils de conformité automatisés, les organisations peuvent appliquer ces politiques à grande échelle sans introduire de surcroît opérationnel. Davantage de conseils sont également disponibles à partir des recommandations de conformité en matière d’IA de l’EDPB et des orientations de l’ICO sur l’IA et la protection des données.

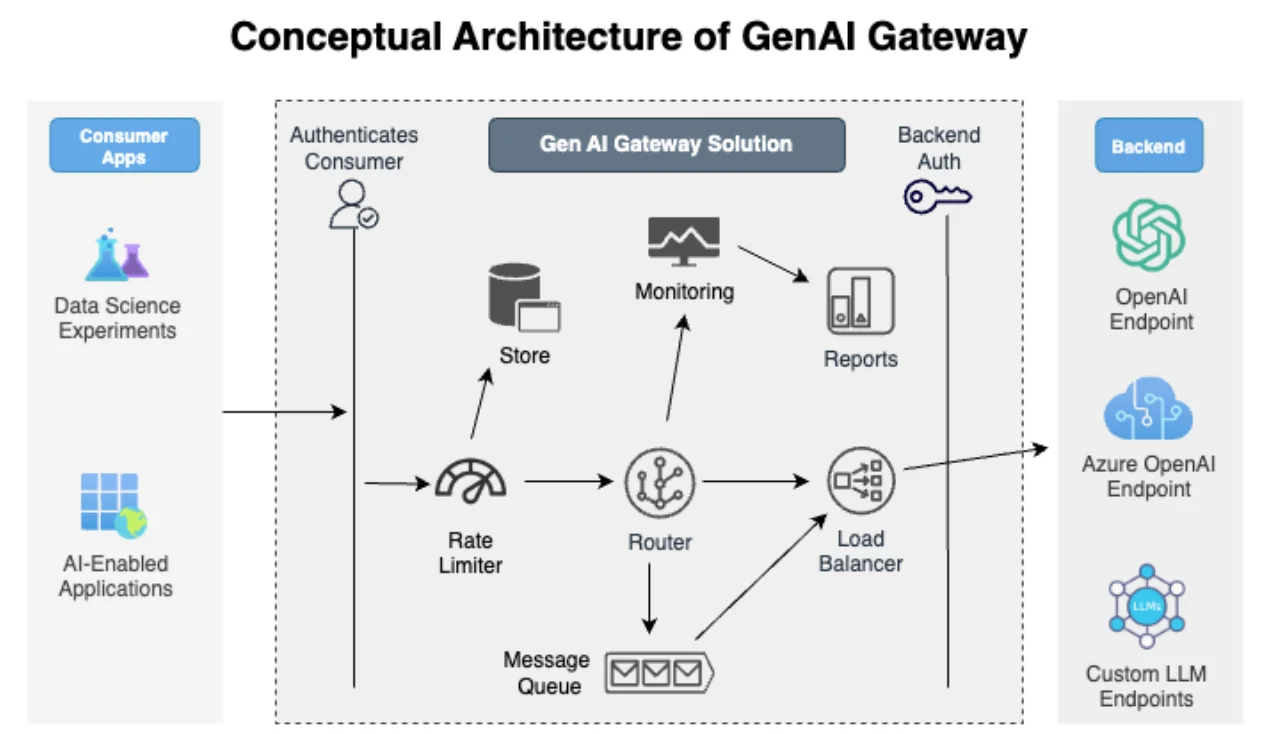

Architecture GenAI axée sur la Sécurité

Les stratégies efficaces de contrôle d’accès ne sont pas mises en place a posteriori, elles sont intégrées dans l’architecture du système. Cela inclut :

- Des pare-feu basés sur un proxy qui inspectent le contenu des requêtes

- Le Contrôle d’accès basé sur les rôles (RBAC) limitant qui peut interroger quels modèles et ensembles de données

- L’application du principe du moindre privilège aux clés API, aux portées d’accès du modèle et à l’utilisation des ensembles de données

Par exemple, les développeurs travaillant sur un modèle de chatbot ne peuvent accéder qu’à des échantillons de données synthétiques ou masquées, tandis que les responsables de la conformité peuvent consulter des journaux d’audit complets sans voir le texte brut des requêtes. Cela s’aligne avec les pratiques décrites dans le Cadre de Sécurité de l’IA de MITRE pour protéger les systèmes d’apprentissage contre l’injection de requêtes et l’utilisation abusive des modèles.

Conclusion

La mise en place de stratégies robustes de Contrôle d’Accès dans les Systèmes GenAI et LLM nécessite une combinaison de découverte, d’application, de surveillance et de gouvernance. Les journaux d’audit en temps réel, le masquage dynamique des données et les politiques basées sur la classification doivent fonctionner en harmonie pour sécuriser les données en transit et au repos.

Des solutions telles que le moteur d’audit et de masquage de DataSunrise offrent la flexibilité et l’intelligence nécessaires pour protéger les écosystèmes GenAI sans compromettre les performances ou la conformité. À mesure que de plus en plus d’entreprises intègrent les LLM dans leurs flux de travail, la capacité d’adapter dynamiquement les contrôles d’accès sera essentielle tant pour l’innovation que pour la responsabilité.

D’autres informations sont disponibles dans le guide de référence sur la sécurité des LLM, les principes fondamentaux de la sécurité des données et des cadres tels que la carte des connaissances sur les menaces liées à l’IA d’OpenCRE.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant