Stratégies de confidentialité des données pour l’IA et les modèles LLM

À mesure que l’intelligence artificielle transforme les opérations d’entreprise, 87 % des organisations déploient des modèles d’IA et LLM dans des processus critiques pour l’entreprise. Alors que ces technologies offrent des capacités inédites, elles introduisent des défis sophistiqués en matière de confidentialité des données que les cadres traditionnels de confidentialité ne peuvent pas gérer adéquatement.

Ce guide examine des stratégies complètes de confidentialité des données pour l’IA et les modèles LLM, en explorant des techniques de mise en œuvre qui permettent aux organisations de maintenir une protection robuste de la confidentialité tout en maximisant le potentiel transformateur de l’IA.

La plateforme avancée de protection de la confidentialité de l’IA de DataSunrise offre une orchestration de la confidentialité sans intervention avec une protection autonome des données sur toutes les principales plateformes d’IA. Notre cadre centralisé de confidentialité de l’IA intègre de manière transparente les stratégies de confidentialité avec des contrôles techniques, offrant une gestion de la confidentialité d’une précision chirurgicale pour une protection complète de l’IA et des modèles LLM avec Conformité de l’IA par défaut.

Comprendre les défis de la confidentialité des données en IA

Les modèles d’IA et LLM traitent d’énormes quantités de données tout au long de leur cycle de vie, créant des risques d’exposition à la vie privée sans précédent. Contrairement aux applications traditionnelles, les systèmes d’IA apprennent en continu à partir de sources de données diverses, ce qui rend la protection de la confidentialité exponentiellement plus complexe.

Ces modèles gèrent souvent des informations sensibles incluant des identifiants personnels et des données commerciales confidentielles. Les organisations doivent mettre en œuvre des mesures complètes de sécurité des données tout en maintenant des capacités d’audit conçues spécifiquement pour les environnements d’IA avec des politiques de sécurité appropriées.

Stratégies essentielles de protection de la confidentialité

Minimisation des données et limitation de la finalité

Les stratégies de confidentialité en IA doivent mettre en œuvre des principes stricts de minimisation des données, en veillant à ce que les modèles ne traitent que les informations essentielles à leur objectif prévu. Les organisations devraient appliquer des techniques de masquage dynamique des données et mettre en place des contrôles d’accès granulaires avec une protection par pare-feu de base de données.

Techniques de formation préservant la confidentialité

Les stratégies avancées de confidentialité incluent la mise en œuvre de la confidentialité différentielle, des approches d’apprentissage fédéré et la génération de données synthétiques pour l’entraînement des modèles. Ces techniques permettent le développement de l’IA tout en protégeant la confidentialité individuelle grâce à des garanties mathématiques associées à la mise en œuvre du chiffrement de base de données.

Surveillance de la confidentialité en temps réel

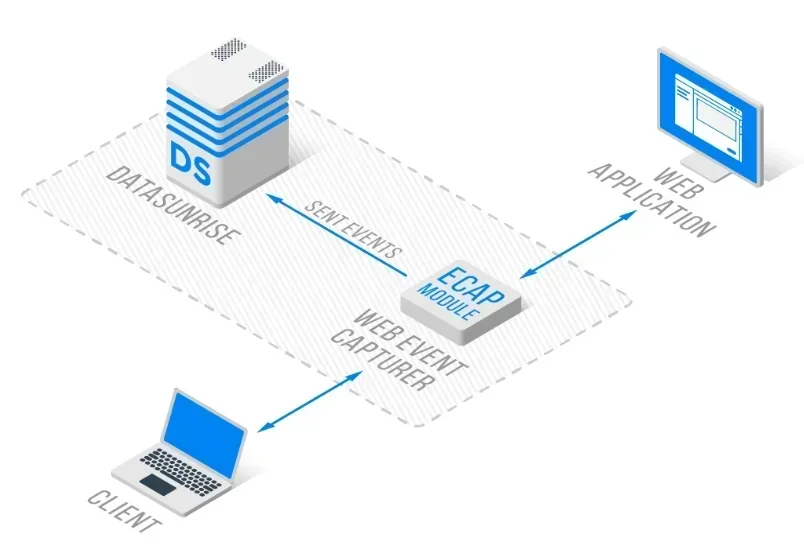

Une confidentialité efficace en IA nécessite une surveillance continue des flux de données, une détection automatisée des informations personnelles identifiables et des alertes immédiates en cas de violation de la confidentialité. Les organisations doivent déployer des systèmes de surveillance de l’activité des bases de données avec des analyses comportementales et des pistes d’audit complètes.

Exemples de mise en œuvre technique

Prétraitement des données préservant la confidentialité

L’implémentation suivante démontre comment détecter et masquer automatiquement les informations personnelles identifiables dans les données textuelles avant le traitement par l’IA. Cette approche garantit que les informations sensibles sont protégées tout en conservant l’utilité des données pour les modèles d’IA :

import hashlib

import re

class AIPrivacyPreprocessor:

def __init__(self):

self.pii_patterns = {

'email': r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b',

'phone': r'\b\d{3}-\d{3}-\d{4}\b',

'ssn': r'\b\d{3}-\d{2}-\d{4}\b'

}

def mask_sensitive_data(self, text: str):

"""Masquer les informations personnelles identifiables dans le texte avant le traitement par l'IA"""

masked_text = text

detected_pii = []

for pii_type, pattern in self.pii_patterns.items():

matches = re.findall(pattern, text)

for match in matches:

masked_value = f"[{pii_type.upper()}_MASKED]"

masked_text = masked_text.replace(match, masked_value)

detected_pii.append({'type': pii_type, 'original': match})

return {

'masked_text': masked_text,

'detected_pii': detected_pii,

'privacy_score': 1.0 if not detected_pii else 0.7

}

Système d’audit de la confidentialité des modèles IA

Cette implémentation montre comment créer un système d’audit complet qui surveille les interactions de l’IA pour détecter des violations de la confidentialité et génère des rapports de conformité :

from datetime import datetime

class AIModelPrivacyAuditor:

def __init__(self, privacy_threshold: float = 0.8):

self.privacy_threshold = privacy_threshold

self.audit_log = []

def audit_model_interaction(self, user_id: str, prompt: str, response: str):

"""Audit complet de la confidentialité pour les interactions avec le modèle IA"""

audit_record = {

'timestamp': datetime.utcnow().isoformat(),

'user_id': user_id,

'interaction_id': hashlib.md5(f"{user_id}{datetime.utcnow()}".encode()).hexdigest()[:12]

}

# Analyser les risques de confidentialité

privacy_score = self._calculate_privacy_score(prompt + response)

audit_record['privacy_score'] = privacy_score

audit_record['compliant'] = privacy_score >= self.privacy_threshold

self.audit_log.append(audit_record)

return audit_record

def _calculate_privacy_score(self, text: str):

"""Calculer le score de confidentialité basé sur la détection de PII"""

pii_patterns = [r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b']

score = 1.0

for pattern in pii_patterns:

if re.search(pattern, text):

score -= 0.3

return max(score, 0.0)

Bonnes pratiques de mise en œuvre

Pour les organisations :

- Architecture Privacy-by-Design : Intégrer des contrôles de confidentialité dans les systèmes d’IA dès leur conception avec le contrôle d’accès basé sur les rôles

- Protection multicouche : Déployer des contrôles de confidentialité complets à travers les phases d’entraînement et d’inférence

- Surveillance continue : Mettre en œuvre une surveillance de la confidentialité en temps réel avec des protocoles d’évaluation des vulnérabilités

Pour les équipes techniques :

- Contrôles de confidentialité automatisés : Mettre en place des mécanismes de masquage des données et de protection dynamique

- Techniques préservant la confidentialité : Utiliser l’apprentissage fédéré et la confidentialité différentielle avec du masquage statique des données

- Réponse aux incidents : Créer des procédures de réponse spécifiques à la confidentialité avec des capacités de détection des menaces et de protection des données

DataSunrise : Solution globale de confidentialité pour l’IA

DataSunrise offre une protection de la confidentialité des données de niveau entreprise, conçue spécifiquement pour les environnements d’IA et de modèles LLM. Notre solution garantit une sécurité maximale et un risque minimal grâce à la Conformité de l’IA par défaut sur ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant et des déploiements personnalisés d’IA.

Caractéristiques clés :

- Surveillance de la confidentialité en temps réel : Surveillance de l’IA sans intervention avec des pistes d’audit complètes

- Protection avancée contre les PII : Protection contextuelle avec un masquage des données d’une précision chirurgicale

- Couverture multiplateforme : Protection de la confidentialité unifiée sur plus de 50 plateformes prises en charge

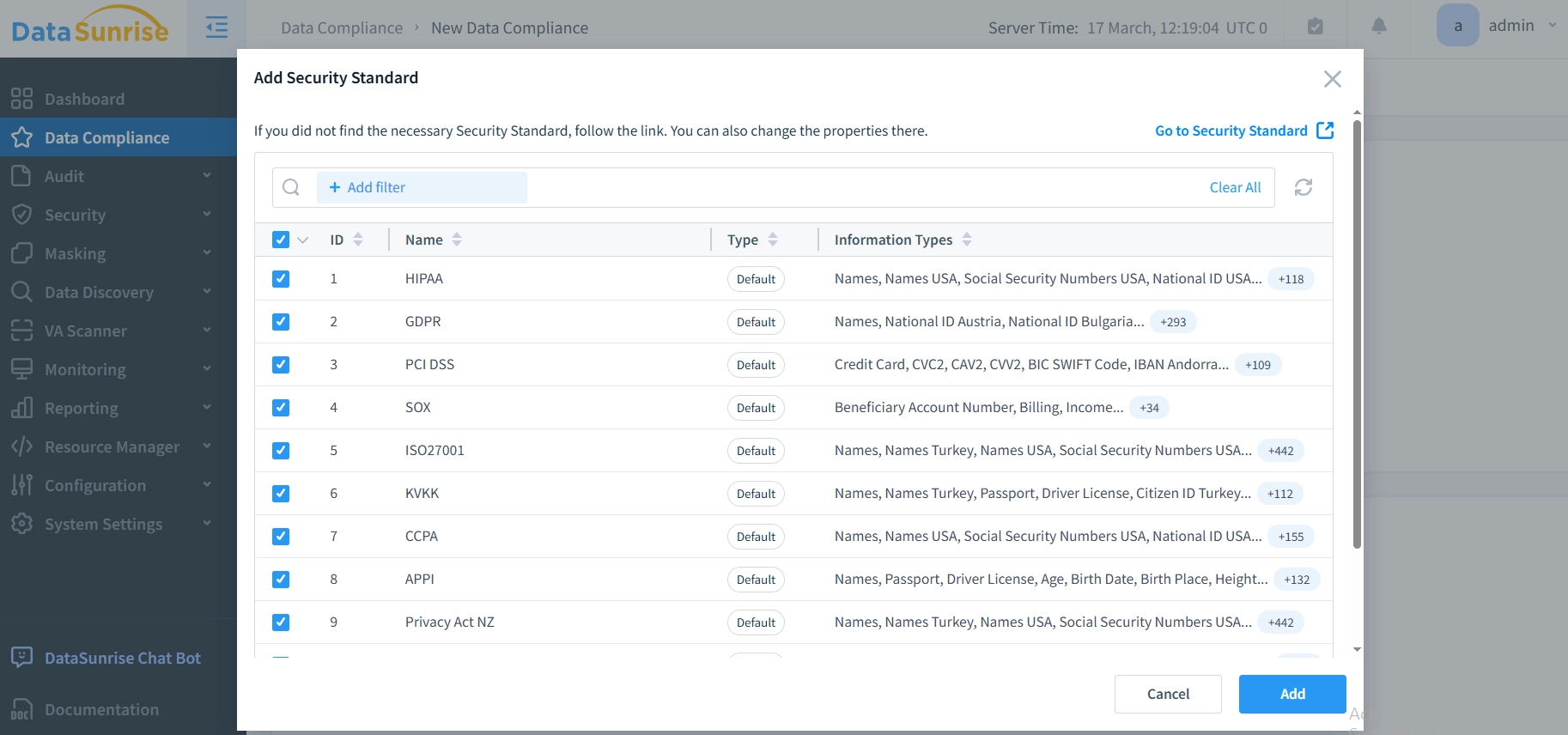

- Conformité automatisée : Autopilote de conformité pour les exigences du RGPD, de la HIPAA et du PCI DSS via Compliance Autopilot

- Détection pilotée par ML : Détection des comportements suspects avec identification des anomalies de confidentialité via outils LLM et ML pour la sécurité des bases de données

Les modes de déploiement flexibles de DataSunrise prennent en charge des environnements d’IA sur site, cloud et hybrides avec une implémentation sans intervention. Les organisations réduisent significativement les risques de confidentialité et améliorent leur conformité réglementaire grâce à une surveillance automatisée.

Considérations relatives à la conformité réglementaire

Les stratégies de confidentialité des données pour l’IA doivent répondre à des exigences réglementaires complètes :

- Protection des données : Le RGPD et la CCPA exigent des garanties spécifiques en matière de confidentialité pour le traitement des données par l’IA

- Normes industrielles : Les secteurs de la santé (HIPAA) et des services financiers (PCI DSS) ont des exigences spécialisées

- Gouvernance émergente de l’IA : La réglementation sur l’IA de l’UE et l’ISO 42001 imposent une approche Privacy-by-Design dans les systèmes d’IA

Conclusion : Construire des systèmes d’IA axés sur la confidentialité

Les stratégies de confidentialité des données pour l’IA et les modèles LLM constituent des exigences essentielles pour un déploiement responsable de l’IA. Les organisations qui mettent en œuvre des cadres complets de confidentialité se positionnent pour exploiter le potentiel transformateur de l’IA tout en maintenant la confiance des parties prenantes et la conformité réglementaire.

Une confidentialité efficace en IA se transforme d’une contrainte de conformité en un avantage concurrentiel. En mettant en œuvre des stratégies de confidentialité robustes avec une surveillance automatisée, les organisations peuvent déployer en toute confiance des innovations en IA tout en protégeant les données sensibles tout au long du cycle de vie de l’IA.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant