Stratégies de protection des données pour les architectures genAI

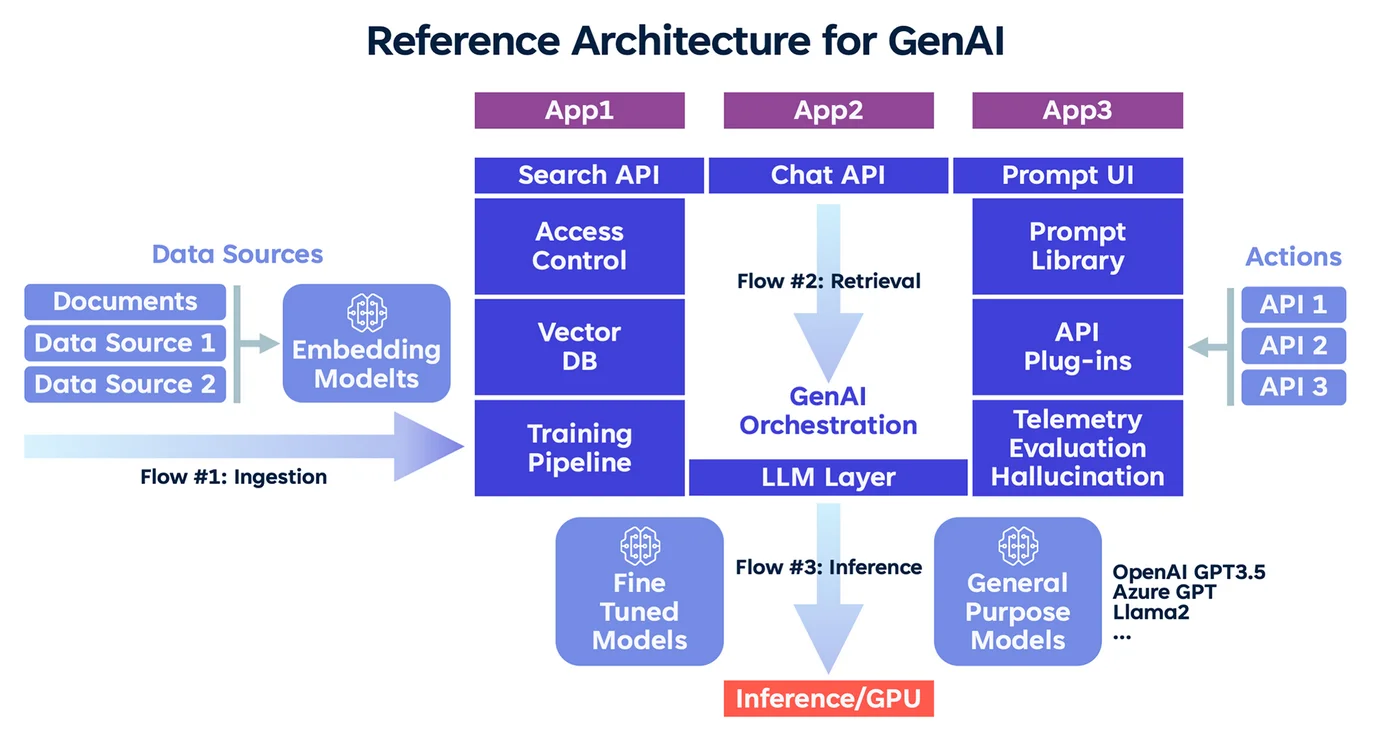

L’IA générative transforme la manière dont les organisations interagissent avec les données. Mais à mesure que ses capacités évoluent, les risques augmentent également — en particulier lorsque les grands modèles de langage traitent des informations personnelles, financières ou propriétaires. Concevoir des systèmes genAI sécurisés nécessite une attention particulière à la confidentialité, au contrôle et à la visibilité.

Cet article explore les stratégies essentielles de protection des données pour les architectures genAI, notamment l’audit en temps réel, le masquage dynamique, la découverte de données et la gestion de la conformité. Ensemble, ces approches garantissent que l’innovation ne compromet pas l’intégrité des informations.

Pourquoi le genAI exige des protections renforcées

Les modèles genAI sont conçus pour générer des résultats à partir de modèles appris. Bien que cela les rende utiles pour la génération de contenu, la synthèse ou la complétion de code, cela introduit également un risque. Les modèles peuvent mémoriser des données sensibles, révéler des artefacts d’entraînement ou produire du contenu halluciné contenant des informations réglementées.

Ces risques sont amplifiés lorsque les invites, les données des utilisateurs et les représentations intermédiaires ne sont pas correctement contrôlés. Un cadre de protection robuste doit surveiller, masquer et appliquer les politiques en temps réel.

Audit en temps réel comme couche de contrôle

Les journaux d’audit ne sont plus optionnels pour les systèmes d’IA — ils constituent une nécessité pour la conformité et la sécurité. Enregistrer chaque requête, interaction utilisateur et sortie de modèle permet aux équipes de reconstituer des séquences risquées, de détecter les tentatives d’injection d’instructions et de générer des rapports de conformité pour des réglementations telles que le RGPD ou la HIPAA.

Des outils tels que DataSunrise Audit fournissent une journalisation en temps réel sur les bases de données et les applications, capturant à la fois les activités structurées et non structurées. Combiné à l’analyse du comportement, cela permet aux organisations de signaler les anomalies dans l’accès ou l’utilisation abusive du genAI.

-- Exemple : table d'audit pour les invites et les réponses

CREATE TABLE genai_audit (

id SERIAL PRIMARY KEY,

user_id TEXT,

prompt TEXT,

response TEXT,

timestamp TIMESTAMPTZ DEFAULT now()

);

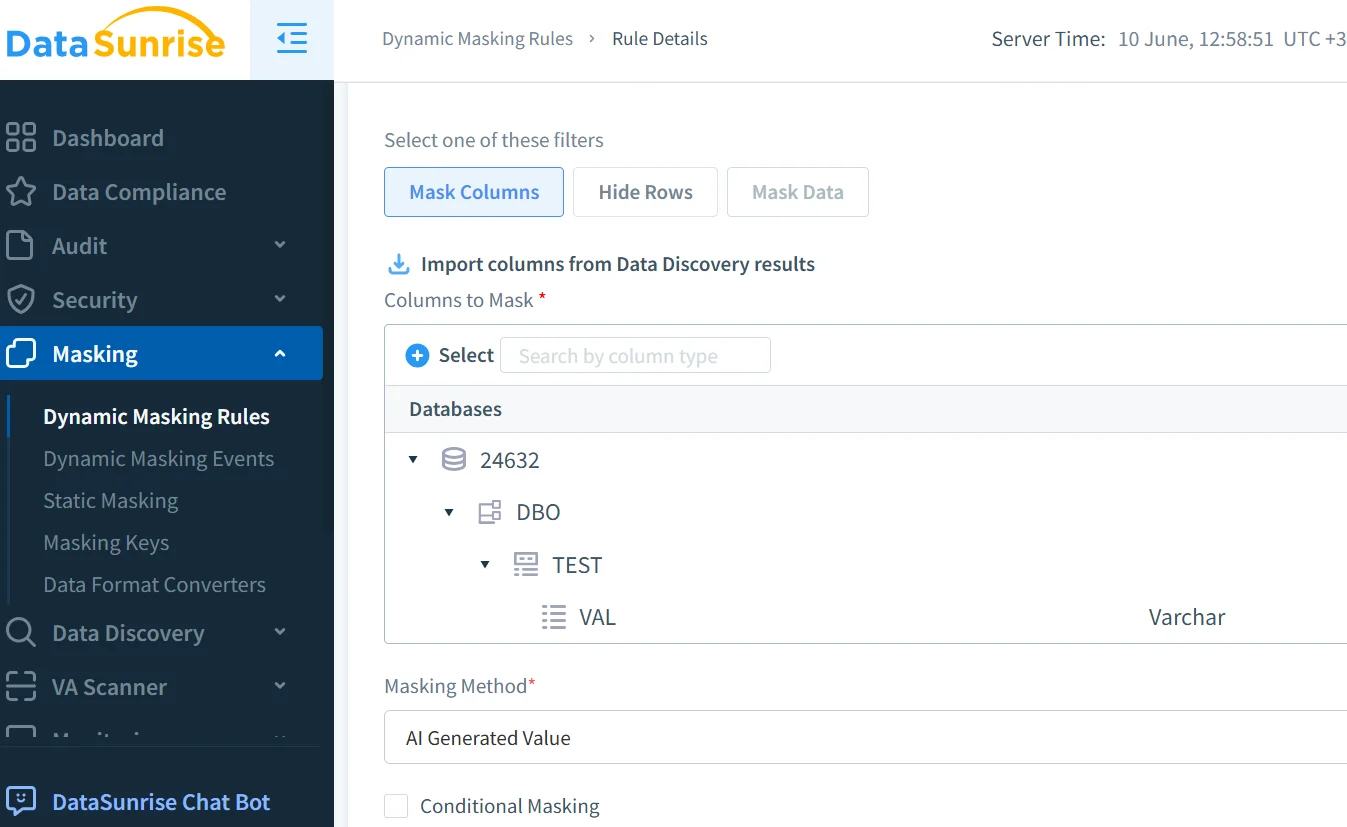

Masquage dynamique pour prévenir les fuites

L’une des protections les plus efficaces est le masquage dynamique, qui masque le contenu sensible lors du traitement par l’IA ou de la génération de réponses. Contrairement au masquage statique, il s’adapte en temps réel — essentiel pour les tâches génératives.

Par exemple, si une invite contient un numéro de sécurité sociale, les moteurs de masquage peuvent l’intercepter et l’obscurcir avant que le modèle ne traite l’entrée.

Le masquage dynamique de DataSunrise s’intègre aux systèmes NLP, appliquant des règles granulaires qui s’adaptent au contexte et aux rôles. Cela prévient l’exposition de données à caractère personnel et s’aligne sur les contrôles d’accès basés sur les rôles.

Découverte de données pour les pipelines d’entrée de l’IA

Il est impossible de protéger ce que l’on ne sait pas exister. Les outils de découverte de données analysent les lacs de données, les magasins de vecteurs et les entrées de modèles. Ils aident à localiser les données à caractère personnel (PII), les informations de santé protégées (PHI) et les données PCI, à dévoiler le contenu sensible d’entraînements et à révéler les bases de données fantômes souvent oubliées lors des révisions manuelles.

En utilisant les capacités de découverte de données de DataSunrise, les équipes peuvent automatiser la classification avant que les ensembles de données n’entrent dans le workflow d’entraînement ou d’inférence. Cela aide à appliquer les limites de conservation, l’utilisation basée sur le consentement et la rédaction.

Conformité aux cadres de conformité des données

La protection des données dans le genAI ne se limite pas à de bonnes pratiques — c’est une exigence de conformité. Selon l’industrie et la région, les organisations doivent peut-être respecter le RGPD en Europe, la HIPAA dans le secteur de la santé ou la norme PCI DSS dans le secteur financier.

Les outils de conformité tels que DataSunrise Compliance Manager prennent en charge la génération de rapports automatisés et les politiques de sécurité des données. Ceux-ci peuvent être associés aux points de terminaison de l’IA, garantissant que les invites et les sorties sont traitées conformément aux normes légales et éthiques.

Sécurité de bout en bout dans les workflows pilotés par l’IA

Au-delà du masquage et de l’audit, la sécurité du genAI doit aborder les risques au niveau de l’infrastructure. Cela inclut l’utilisation de contrôles de proxy inverse pour inspecter le trafic des grands modèles de langage, l’application de détection d’injections SQL sur des requêtes intégrées et la mise en œuvre de politiques d’accès au moindre privilège, tant au niveau du modèle que de la base de données.

Lorsque les modèles interrogent des bases de données ou enrichissent le contenu en utilisant la génération augmentée par récupération (RAG), ces contrôles empêchent la propagation latérale et la surexposition des données.

Construire un GenAI qui respecte les limites

Le véritable objectif de la protection des données dans le genAI n’est pas de restreindre mais de permettre une utilisation de confiance. En combinant une visibilité d’audit, un masquage contextuel et une découverte de données sensible à la sécurité, les organisations peuvent maintenir le contrôle des données sensibles, permettre une adoption de l’IA évolutive et réduire le risque de non-conformité à travers les départements.

En fin de compte, les stratégies de protection des données pour les architectures genAI servent de base à une intégration de l’IA éthique, sûre et évolutive. Pour une compréhension plus large des défis en matière de confidentialité liés à l’IA, consultez le Cadre de gestion des risques de l’IA du NIST. Pour explorer les pratiques de sécurité open source des grands modèles de langage, la base de connaissances MITRE ATLAS constitue une autre ressource externe précieuse. Le défi n’est pas seulement de rendre l’IA puissante — mais de la rendre responsable.