Stratégies de protection des données dans les environnements GenAI et LLM

L’intelligence artificielle générative (GenAI) et les grands modèles linguistiques (LLM) révolutionnent la manière dont les organisations automatisent, analysent et génèrent du contenu. Ces systèmes opèrent sur d’immenses ensembles de données, contenant souvent des informations sensibles ou réglementées. Sans mesures de protection adéquates, ils peuvent accidentellement exposer des données privées ou les reproduire dans leurs résultats. Ce risque s’amplifie lorsque ces modèles sont intégrés dans des chaînes de production pour le support client, la programmation ou l’analyse. Des experts, tels que ceux du Harvard Berkman Klein Center, ont exprimé des préoccupations quant à la manière dont les LLM traitent les données d’entraînement sensibles.

Principales stratégies de protection des données dans les environnements GenAI et LLM

Pour maintenir le contrôle sur les données sensibles dans les systèmes GenAI, les entreprises doivent adopter des défenses à plusieurs niveaux. Les stratégies les plus efficaces combinent l’audit en temps réel, le masquage dynamique des données, la découverte automatisée et l’application des politiques. Explorons comment ces techniques agissent de concert pour créer des protections robustes.

Audit en temps réel et enregistrement transparent

L’audit en temps réel aide à détecter et à comprendre comment les données sont consultées ou interrogées par les processus GenAI. Par exemple, si une requête déclenche accidentellement l’accès aux adresses des clients, une piste d’audit en direct consigne cet événement pour un examen immédiat. Ceci est particulièrement précieux lorsque les LLM sont connectés à des bases de données utilisant la recherche vectorielle ou la génération augmentée par récupération (RAG).

DataSunrise propose des règles d’audit flexibles et un suivi des sessions qui capturent les requêtes SQL, les sessions des utilisateurs et les anomalies comportementales. Ces journaux d’audit peuvent être exportés ou intégrés à des outils SIEM, fournissant ainsi une couche de conformité continue. En savoir plus sur les options de configuration de l’audit.

L’importance de l’auditabilité dans les LLM est soulignée dans des initiatives telles que la System Card pour GPT-4 d’OpenAI, qui met en lumière les risques liés à la fuite involontaire d’informations.

SELECT * FROM customers WHERE notes ILIKE '%refund%';

Si une telle requête est déclenchée par un modèle GenAI, elle est immédiatement enregistrée, étiquetée selon le niveau de risque et, éventuellement, bloquée ou masquée en fonction de la politique appliquée.

Masquage dynamique des données lors de l’exécution

Le masquage statique est utile pour anonymiser les ensembles de données avant l’entraînement, mais dans les workflows de production GenAI, le masquage dynamique est indispensable. Cette technique dissimule en temps réel les données sensibles sans modifier les données sources. Lorsque l’agent GenAI interroge le backend, les réponses masquées garantissent la conformité sans interrompre le service.

-- Exemple : Appliquer un masquage dynamique à la colonne SSN

CREATE MASKING RULE mask_ssn

ON customers(ssn)

USING FULL MASK;

Le masquage dynamique assure que les LLM entraînés sur des sources de données en direct ne renvoient jamais d’identifiants bruts, même lorsque leurs requêtes sont inattendues ou malveillantes. Associé aux politiques RBAC, il limite l’exposition pour des utilisateurs et agents d’IA spécifiques.

Comme l’indique le NIST dans son cadre de gestion des risques liés à l’IA, les contrôles d’accès contextuels et le masquage sont essentiels pour protéger des ensembles de données de grande valeur dans les systèmes d’IA.

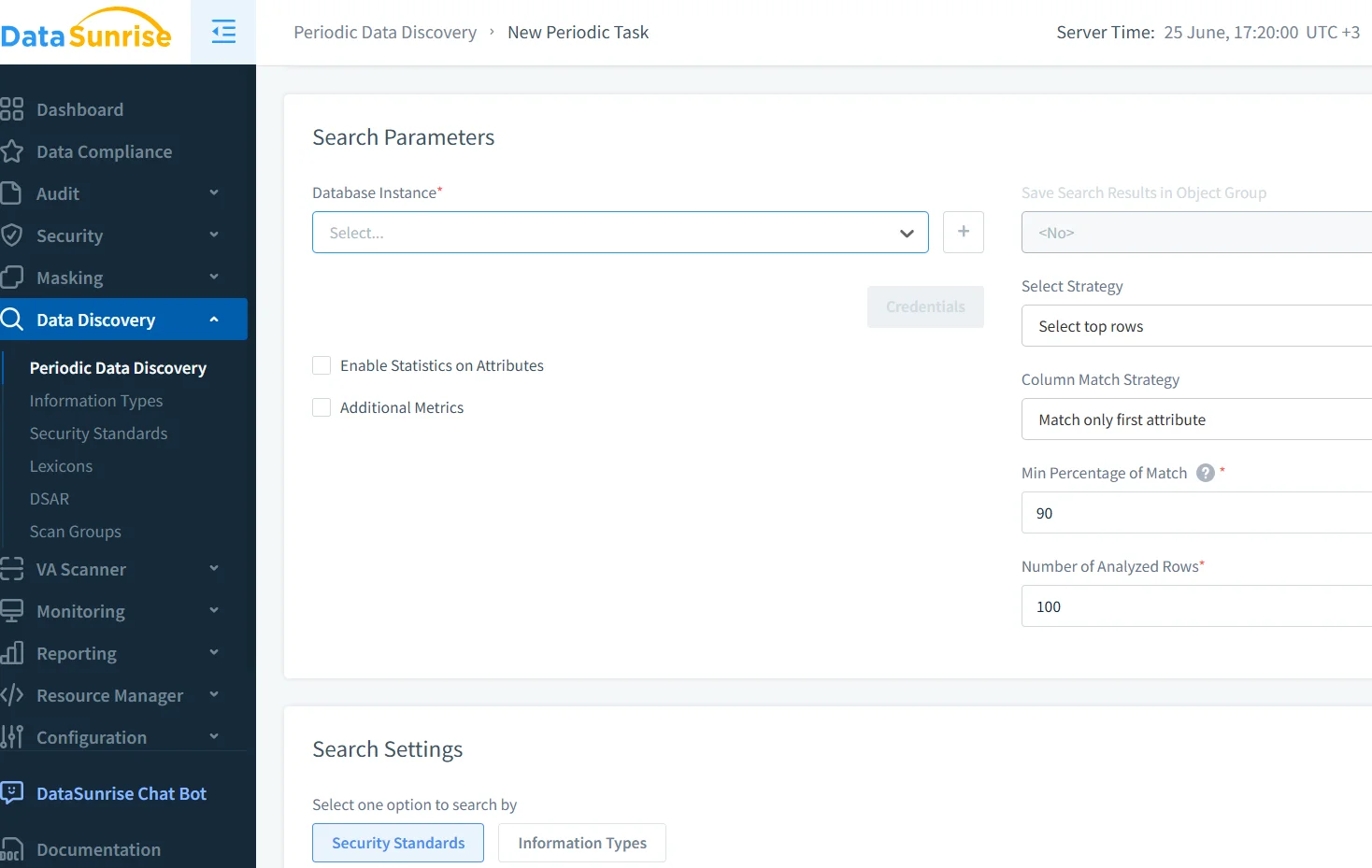

Découverte et classification automatiques des données

Avant de pouvoir protéger les données, il faut savoir où elles se trouvent. Les analyses de découverte des données automatisées aident à localiser les informations personnelles identifiables (PII), les informations de santé (PHI), les dossiers financiers ou les contenus réglementés à travers des stockages structurés et semi-structurés. Cela est crucial pour les applications GenAI qui extraient des données de plusieurs lacs de données ou index vectoriels.

DataSunrise permet des analyses périodiques ou à la demande, accompagnées d’un étiquetage et d’une classification de la sensibilité. Combinées aux modules d’audit et de masquage, ces investigations améliorent la visibilité et garantissent que aucune nouvelle source n’est oubliée.

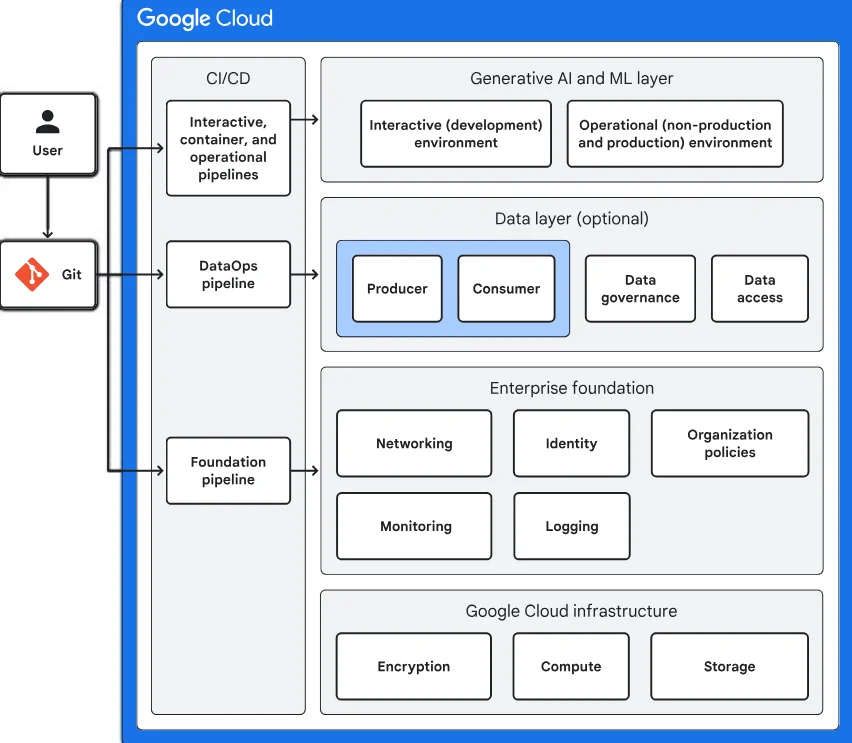

Des outils comme la Protection des données sensibles de Google offrent des approches complémentaires à la classification automatique dans des environnements natifs du cloud.

Renforcement de la sécurité dans les déploiements GenAI

Au-delà de l’audit et du masquage, les déploiements GenAI nécessitent une protection active contre des menaces telles que l’injection de requêtes, la fuite d’inférences ou la mémorisation accidentelle. Plusieurs techniques supplémentaires contribuent à cet effort :

- Analyse comportementale pour détecter des schémas de requêtes inhabituels

- Contrôles d’accès basés sur des politiques pour les intégrations externes

- Prévention des injections SQL lors de la traduction en langage naturel

DataSunrise intègre ces techniques via sa plateforme de sécurité des données. Grâce à des règles de sécurité adaptées aux workflows GenAI, les administrateurs peuvent inspecter les flux d’entrée et de sortie et bloquer les opérations suspectes avant qu’elles n’atteignent la couche de la base de données.

Les recherches menées par le Centre de recherche sur les modèles fondamentaux de Stanford illustrent en outre la nécessité de dispositifs de protection en temps réel et de cadres de sécurité multicouches lors du déploiement des LLM.

Alignement réglementaire et gestion de la conformité

La conformité est souvent le moteur des stratégies de protection des données. Que vos modèles GenAI interagissent avec des données clients dans le cadre du GDPR, de l’HIPAA ou du PCI DSS, les risques liés à une mauvaise gestion sont importants. Les gestionnaires de conformité automatisés aident à appliquer les exigences grâce à des modèles préétablis, des règles d’audit et des rapports exportables.

Par exemple, en vertu du GDPR, chaque accès aux données personnelles doit être traçable et limité. Les pistes d’audit, les journaux de contrôle d’accès et les règles de masquage répondent ensemble à cette exigence sans compromettre la performance ou les capacités des LLM.

Les conseils de l’ICO sur l’IA et la protection des données dans le cadre du RGPD au Royaume-Uni fournissent des étapes pratiques pour garantir que les opérations des LLM respectent la législation sur la confidentialité.

Bonnes pratiques pour la protection des données dans les environnements GenAI

Pour préserver l’intégrité des données et réduire les risques dans les pipelines GenAI, les organisations devraient :

- Activer l’audit en temps réel pour toutes les bases de données connectées à l’IA

- Utiliser le masquage dynamique afin d’empêcher l’accès direct aux informations personnelles identifiables

- Réaliser des analyses de découverte automatisée sur toutes les nouvelles sources de données

- Appliquer des politiques d’accès contextuelles pour les services LLM

- Automatiser la génération de rapports de conformité à travers les régions et normes

Ces pratiques peuvent être renforcées grâce à la génération de données synthétiques, aux tests d’intrusion (« red teaming ») pour les requêtes LLM, ainsi qu’aux dispositifs de validation des sorties des modèles – tout particulièrement dans des environnements réglementés comme ceux de la finance ou de la santé. Le Future of Privacy Forum aborde nombre de ces techniques dans son exploration des déploiements responsables de l’IA.

Conclusion

Les stratégies de protection des données dans les environnements GenAI et LLM doivent relever les défis uniques liés à l’inférence, à l’ingénierie des requêtes et à l’accès dynamique. Grâce à des outils tels que l’audit en temps réel, le masquage dynamique, la découverte automatisée et l’application des politiques offerts par des plateformes comme DataSunrise, les équipes peuvent déployer le GenAI en toute sécurité sans compromettre la confidentialité des données ou la conformité réglementaire. À mesure que le GenAI continue d’évoluer, les mécanismes de défense intégrés à son architecture devront également progresser.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant