Approches de Masquage des Données dans les Workflows d’IA et de LLM

Alors que l’intelligence artificielle (IA) et les grands modèles de langage (LLM) transforment les workflows d’entreprise modernes, la protection des données sensibles est devenue plus cruciale que jamais. Le masquage des données aide à relever ce défi sans ralentir l’innovation. Dans cet article, nous explorons des approches pratiques de masquage des données dans les workflows d’IA et de LLM, en mettant l’accent sur les mesures de protection en temps réel et l’intégration de la conformité.

Pourquoi le Masquage des Données est Crucial dans les Workflows d’IA

Les modèles d’IA générative traitent souvent des entrées sensibles telles que des journaux internes, des e-mails, des données personnelles et des dossiers financiers. Ces systèmes peuvent stocker ou reproduire ces données de manière involontaire. Le masquage permet de prévenir ces risques en cachant ou en modifiant les informations sensibles avant qu’elles n’atteignent le modèle.

Par exemple, si une requête d’un LLM ajusté contient le nom et le numéro de téléphone d’un véritable client, le modèle pourrait mémoriser et réutiliser ces informations. Une couche de masquage empêche cela en remplaçant les identifiants avant leur ingestion. La politique d’utilisation des données d’OpenAI explique comment les LLM peuvent involontairement conserver le contenu des utilisateurs.

Masquage Statique et Dynamique dans les Contextes LLM

Masquage Statique pour le Prétraitement

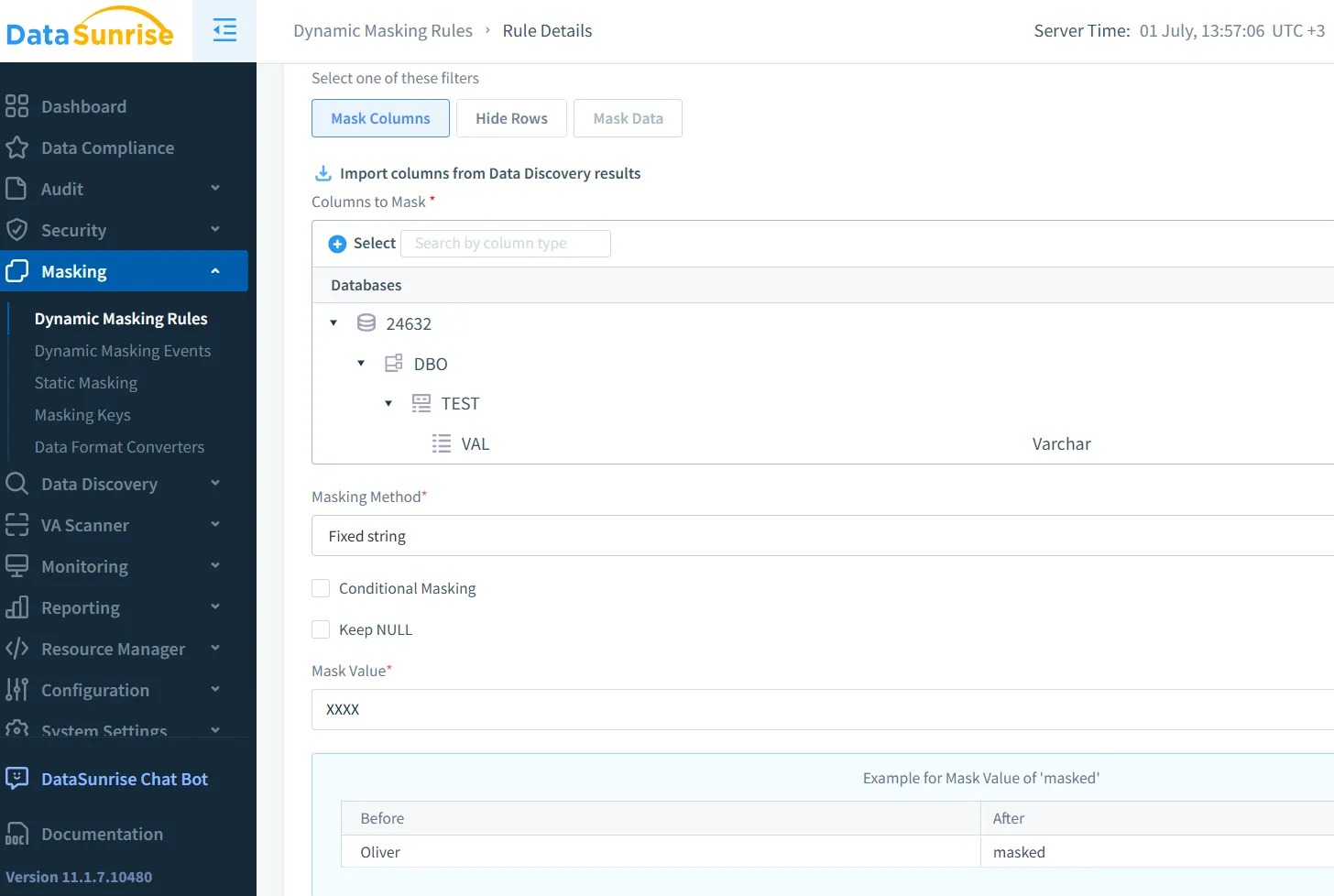

Le masquage statique modifie les données sensibles au repos et est souvent utilisé lors de la préparation des ensembles de données. Le masquage statique de DataSunrise transforme de manière permanente les exportations tout en préservant la structure.

Google Cloud DLP prend en charge un masquage statique similaire, y compris des techniques de préservation du format pour les données structurées.

Masquage Dynamique pour une Utilisation en Temps Réel

Le masquage dynamique opère sur des données en temps réel. Par exemple, lorsque les LLM traitent des requêtes utilisateur, les moteurs de masquage peuvent supprimer les numéros de carte de crédit ou les identifiants nationaux avant que le modèle ne les voie. Le masquage dynamique de DataSunrise est parfaitement adapté à cet usage en production.

Amazon Macie offre un service similaire qui analyse et masque les données dans les environnements AWS. Voir plus d’informations dans cet article AWS.

Masquage des Requêtes LLM en Pratique

Considérez un chatbot de support client utilisant un LLM. Les messages incluent souvent des données privées. Une règle dynamique pourrait ressembler à ceci :

CREATE MASKING RULE mask_pii

ON inbound_messages.content

WHEN content LIKE '%SSN%'

REPLACE WITH '***-**-****';

Cette règle empêche les modèles d’accéder aux numéros de sécurité sociale en clair.

En appliquant cette logique au niveau de la couche middleware, les équipes n’ont pas besoin de modifier le modèle. Les outils de sécurité pour LLM et ML de DataSunrise aident à automatiser ce processus grâce à une détection contextuelle.

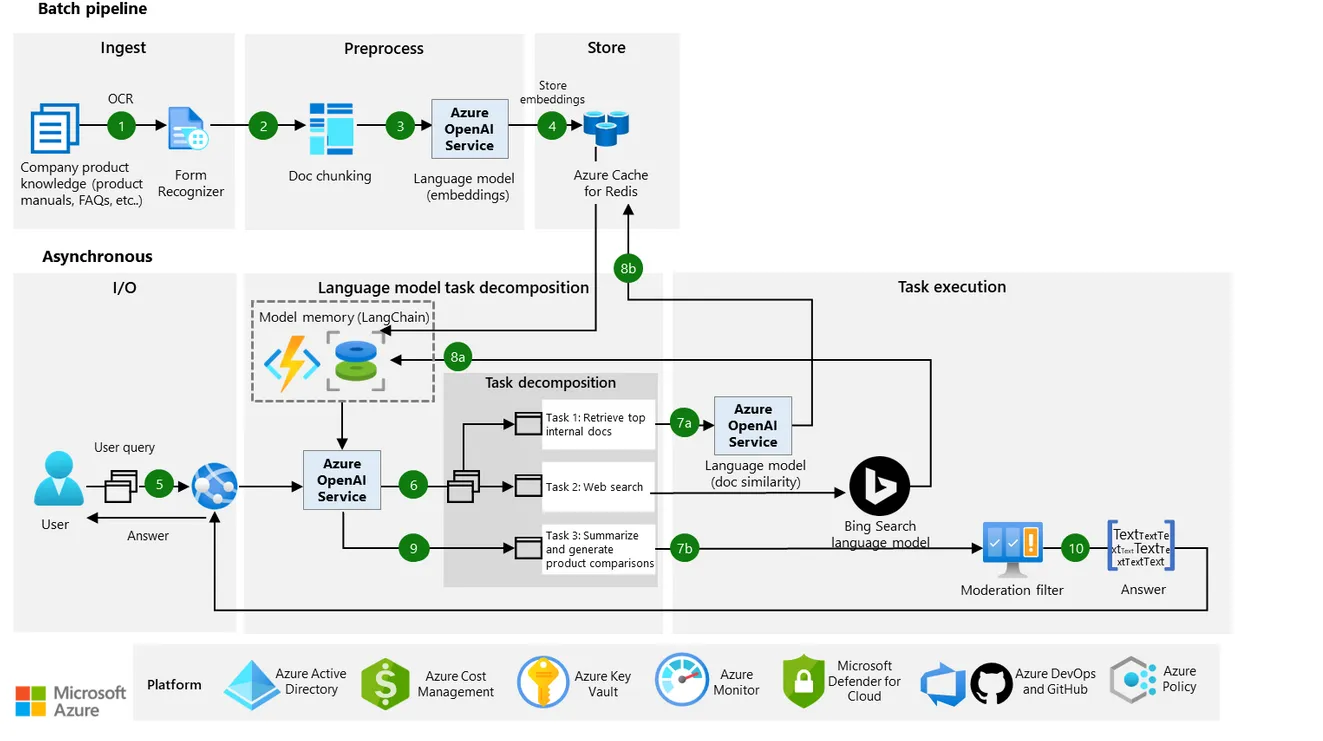

Les recommandations d’architecture de Microsoft mettent également en avant le masquage en temps réel et l’utilisation responsable des données dans les workflows LLM.

Du Masquage aux Contrôles d’Accès Contextuels

Le masquage est plus efficace lorsqu’il est associé à des contrôles d’accès basés sur les rôles, à des pistes d’audit et à une analyse comportementale. Un développeur en staging peut voir des données réalistes mais fictives, tandis que les entrées en production restent expurgées.

Lorsqu’il est connecté à des outils de surveillance de l’activité, les équipes peuvent détecter un accès non masqué ou déclencher des alertes. Le masquage devient ainsi une couche de sécurité, et non seulement une solution de confidentialité.

Cette conception s’aligne sur les principes Zero Trust du NIST Zero Trust, qui privilégient une visibilité restreinte et une application rigoureuse des politiques.

Les Données de Synthèse comme Alternative au Masquage

Plutôt que de masquer des données réelles, de nombreuses équipes génèrent désormais des données synthétiques pour entraîner ou tester des modèles IA. Ces ensembles de données préservent le schéma et la logique sans exposer de véritables personnes.

Le ICO britannique reconnaît les données synthétiques comme une méthode préservant la vie privée dans le cadre du RGPD, en particulier pour le développement de l’IA et du ML.

Les Facteurs de Conformité et la Gestion des Risques en IA

Des réglementations telles que le RGPD, la HIPAA et le PCI DSS exigent que les organisations justifient, anonymisent ou masquent les données sensibles lors du traitement. Le masquage répond à ces exigences grâce à la minimisation des données et au contrôle des risques.

Il s’intègre également aux modèles de sécurité inspirés des données, où la gouvernance et la protection sont intégrées à chaque couche.

Modèles d’Implémentation dans le Monde Réel

Dans les systèmes réels, le masquage se fait généralement via :

- Des scripts de prétraitement pour les données d’entraînement

- Des moteurs middleware pour le masquage en temps réel

- Le masquage via un reverse proxy pour les sorties

- L’audit des journaux d’inférence

En utilisant un reverse proxy, les développeurs peuvent intercepter et expurger les données sensibles avant qu’elles n’atteignent le modèle ou les journaux.

Cette approche en couches n’améliore pas seulement la protection—elle instaure la confiance. Les utilisateurs sont plus enclins à s’engager lorsqu’ils savent que leurs entrées restent privées.

Conclusion : Construire des Pipelines LLM Plus Sûrs

Le masquage n’est pas simplement une case à cocher de conformité. C’est une décision de conception qui détermine la sécurité de votre IA. Le masquage statique et dynamique jouent tous deux des rôles essentiels dans la protection des données des utilisateurs tout au long du cycle de vie.

Lorsqu’elles sont combinées à des outils de découverte, des politiques d’audit et une automatisation de la sécurité, ces techniques contribuent à la construction de systèmes d’IA sûrs dès leur conception.

Pour les équipes qui déploient la GenIA à grande échelle, la bonne stratégie de masquage peut prévenir les violations, réduire la responsabilité et protéger les utilisateurs sans freiner l’innovation.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant