Techniques d’atténuation des risques GenAI

L’intelligence artificielle générative (GenAI) a changé la façon dont les entreprises interagissent avec les données. Ces modèles rédigent du contenu, génèrent du code, résument des documents et automatisent des décisions. Cependant, ils soulèvent également des préoccupations concernant la confidentialité, la sécurité et la conformité des données. Le risque augmente lorsque les systèmes GenAI traitent des données sensibles ou réglementées sans les contrôles appropriés.

Cet article explore les techniques d’atténuation des risques GenAI essentielles, notamment l’audit en temps réel, le masquage dynamique, la découverte des données et d’autres protections fondamentales. Chaque technique joue un rôle spécifique dans la réduction de l’exposition aux menaces tout en favorisant l’innovation.

Pourquoi GenAI présente des risques de sécurité uniques

Contrairement aux systèmes basés sur des règles, GenAI apprend à partir de grands ensembles de données et utilise un raisonnement probabiliste. Il peut déduire des relations, reconstruire des données privées et produire des résultats qui violent les politiques internes. Ces problèmes surviennent souvent en raison de contrôles d’invocation insuffisants, d’un entraînement sur des ensembles de données non filtrés et d’une transparence limitée sur le comportement du modèle. En l’absence de journalisation ou de mise en œuvre appropriée, cela devient un vecteur de menace majeur dans les environnements réglementés.

Pour plus d’informations, consultez l’AI Index de Stanford qui met en lumière les défis liés à l’alignement des modèles et à la transparence des données.

Audit en temps réel pour la visibilité des invites et des données

La surveillance en temps réel de l’activité de la base de données aide les organisations à suivre les requêtes GenAI pour assurer la conformité. Elle enregistre chaque demande qui interagit avec la couche de données, capturant les requêtes SQL, les rôles des utilisateurs, les adresses IP et les données de session.

Ceci est essentiel lorsqu’on travaille avec des outils tels que LangChain ou l’appel de fonctions d’OpenAI, où les requêtes de base de données sont générées dynamiquement. Par exemple:

SELECT full_name, email FROM customers WHERE preferences LIKE '%personal%';Cette requête, lorsqu’elle est déclenchée par un LLM, peut être enregistrée et examinée en utilisant les bonnes pratiques de journalisation d’audit afin de détecter tout accès aux données sensibles. Elle garantit la responsabilité et supporte la réponse aux incidents de sécurité.

Masquage dynamique des données pour contrôler la sortie

Le masquage dynamique protège les données sensibles même lorsqu’elles sont consultées. Il fonctionne en temps réel, en appliquant des politiques contextuelles qui masquent les numéros de cartes de crédit, les identifiants personnels et plus encore.

Exemple:

SELECT name, credit_card_number FROM payments;

-- résultat masqué: SELECT name, '****-****-****-1234'Le masquage est crucial lors de l’intégration de GenAI avec des bases de données relationnelles ou des stockages vectoriels. Selon les directives du NIST sur la sécurité de l’IA, les contrôles dynamiques aident à garantir que les LLM ne puissent pas divulguer de données privées même si l’accès est accordé. Voir également les recommandations d’IBM sur la confidentialité de l’IA.

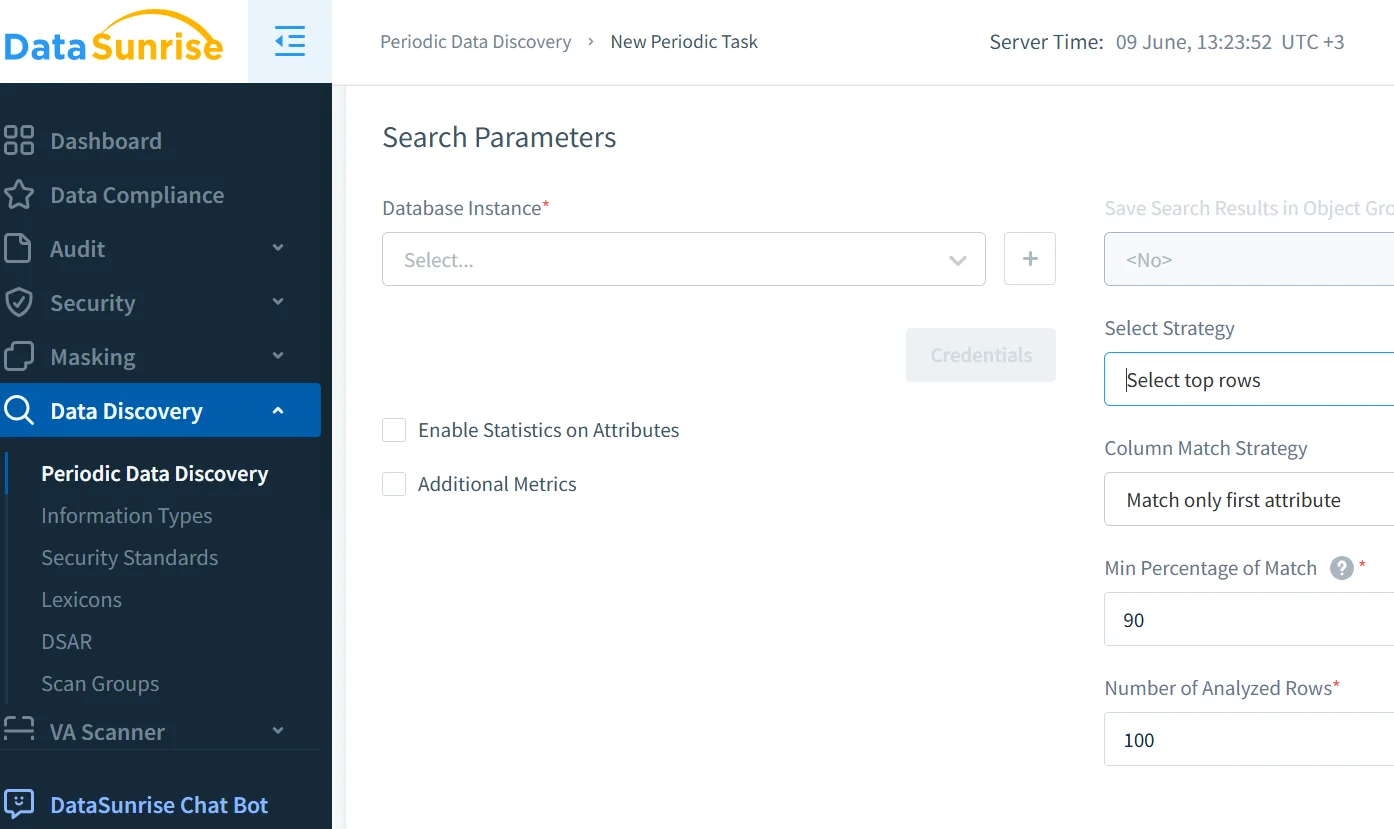

Découverte et classification des données avant l’ajustement fin

Afin d’utiliser les données dans les pipelines RAG ou pour l’entraînement GenAI, la découverte des données est essentielle. Elle identifie et classe le contenu réglementé, tel que les informations personnelles (PII), les informations de santé protégées (PHI) et les identifiants, évitant ainsi toute exposition accidentelle.

En combinaison avec la génération de données synthétiques et les techniques décrites par Google Cloud, cela permet un entraînement, un ajustement fin et des opérations de récupération plus sûrs.

Une classification appropriée aide à appliquer les politiques de sécurité, à activer les règles de masquage et à démontrer la conformité avec le RGPD, HIPAA et le PCI DSS. Le Future of Privacy Forum fournit également des directives solides sur l’utilisation responsable des données en IA.

Conformité et gouvernance pour les pipelines d’IA

La conformité pour GenAI va au-delà de la simple journalisation : elle doit intégrer des évaluations continues des risques, des contrôles d’accès, du masquage et une application automatisée.

Le DataSunrise Compliance Manager soutient la génération de rapports automatisés, l’application cohérente des politiques et des alertes en temps réel. Il s’intègre avec des outils externes pour une observabilité plus large des risques et réduit l’effort de préparation aux audits. D’autres cadres sont détaillés dans les Principes d’IA de l’OCDE.

Couches de sécurité adaptées aux pipelines GenAI

Les défenses standard telles que les pare-feux ne sont pas suffisantes. Les systèmes GenAI nécessitent des contrôles d’accès basés sur les rôles (RBAC), une protection contre les injections SQL et des filtres basés sur le comportement pour les injections de prompt.

Envisagez d’aligner les défenses sur le Top 10 OWASP pour les applications de grands modèles de langage, qui recommande de masquer les sorties, de valider les entrées et de mettre en quarantaine les services d’IA. Explorez également le paysage des menaces de l’IA d’ENISA pour une vue globale des risques.

Pour les environnements natifs du cloud, les proxies compatibles IA et les pare-feux de bases de données aident à protéger les points d’entrée. Le pare-feu de base de données de DataSunrise offre cette fonctionnalité avec un support pour plus de 40 plateformes de données.

Exemple de cas d’utilisation : Chatbot de support client avec RAG

Un chatbot de support utilise la génération augmentée par récupération (RAG) pour extraire des données des connaissances internes et des dossiers clients basés sur PostgreSQL. Si aucune mesure n’est prise, il pourrait révéler des informations personnelles sensibles.

En activant le masquage au niveau SQL, en enregistrant chaque requête du chatbot, en scannant les données d’entraînement à la recherche d’informations personnelles (PII) et en classifiant les requêtes selon leur risque, l’entreprise maintient le chatbot à la fois réactif et conforme.

Cela est conforme à la norme d’IA responsable de Microsoft et contribue à appliquer la protection de la vie privée dès la conception.

Conclusion : Techniques d’atténuation des risques GenAI en pratique

Les systèmes d’IA modernes nécessitent plus que la confiance. Ils nécessitent du contrôle. En combinant l’audit, le masquage, la découverte et la gouvernance basée sur les politiques, les organisations réduisent le risque de fuites de données induites par l’IA et les échecs de conformité.

Les techniques efficaces d’atténuation des risques GenAI s’intègrent à tous les niveaux, du filtrage des invites à l’application des politiques de base de données, offrant ainsi traçabilité et défense en temps réel.

Pour approfondir les applications pratiques, visitez :

- Analyse comportementale

- Cadre de gestion des risques IA du NIST

- Outils de sécurité et de surveillance pour LLM

- Cadre d’IA sécurisé de Google (SAIF)

- Pratiques de protection des données

- Partenariat pour l’IA

- Base de données des incidents IA

En adoptant les bonnes pratiques, GenAI peut stimuler l’innovation de manière sûre et responsable.