Présentation des menaces de cybersécurité liées à l’IA

L’IA générative (GenIA) est en train de transformer la cybersécurité. Ces modèles non seulement analysent des données, ils les créent également. Ils rédigent des textes, génèrent du code et automatisent des décisions. Mais à mesure qu’ils gagnent en capacités, ils ouvrent également de nouvelles surfaces d’attaque. Qu’il s’agisse de divulguer des données sensibles via les sorties du modèle ou d’être exploités par des injections de requêtes, la GenIA introduit des menaces que les outils de sécurité traditionnels ne couvrent pas entièrement.

Cet article offre un aperçu des menaces de cybersécurité liées à l’IA et explique comment l’audit en temps réel, le masquage dynamique, la découverte de données et les outils de conformité peuvent atténuer les risques associés aux systèmes GenIA.

Les risques de la GenIA dépassent les failles de sécurité classiques

Contrairement aux applications traditionnelles, la GenIA utilise le langage naturel et la similarité basée sur des vecteurs pour renvoyer un contenu pertinent. Cela signifie qu’un modèle pourrait involontairement révéler des informations confidentielles si elles ont été exposées lors de l’entraînement — ou si un attaquant construit la requête adéquate.

Par exemple, une requête de recherche interne utilisant PostgreSQL avec pgvector pourrait ressembler à ceci :

SELECT * FROM documents

WHERE embedding <#> ' [0.1, 0.5, 0.9, ...] '

ORDER BY similarity

LIMIT 1;

Si le vecteur représente un concept sensible, le résultat pourrait être une note interne confidentielle. Sans règles de masquage ou d’audit en place, cet accès pourrait passer inaperçu.

Un autre exemple : si un chatbot interne utilise un LLM pour générer des réponses à partir de données SQL, une requête savamment conçue pourrait extraire plus d’informations que prévu.

PROMPT: Listez les transactions récentes des clients supérieures à 10 000 $

-- SQL généré par LLM --

SELECT customer_name, amount, transaction_date

FROM transactions

WHERE amount > 10000;

Si l’accès n’est pas limité ou masqué, cela pourrait dévoiler des informations financières personnelles (PII).

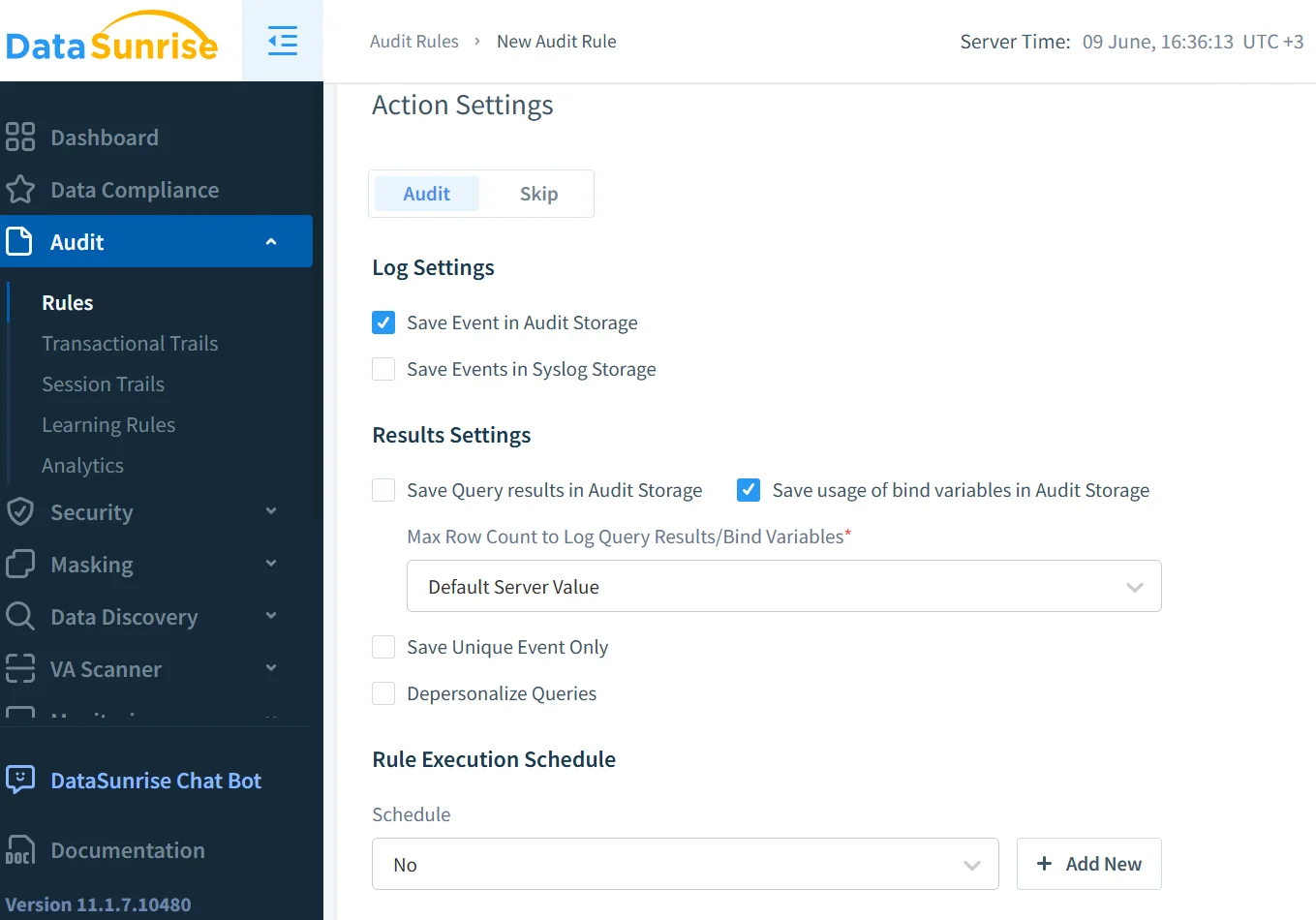

L’audit en temps réel aide à détecter instantanément les menaces

L’audit en temps réel est essentiel dans les environnements GenIA. Il enregistre les accès et alerte les équipes de sécurité lorsqu’un comportement suspect est détecté. Par exemple, un attaquant pourrait sonder un modèle en envoyant à plusieurs reprises des requêtes modifiées. Une solution d’audit en temps réel, comme celle décrite dans les journaux d’audit de DataSunrise, permet aux équipes de répondre à ces menaces au moment même où elles surviennent.

Les données d’audit comportemental peuvent également aider à retracer comment et quand des informations sensibles ont été consultées, apportant ainsi de la profondeur aux analyses d’incidents et aux rapports de conformité. Découvrez comment l’historique d’activité des données contribue à cette visibilité.

Le masquage garantit que les modèles n’exposent pas ce qu’ils ne devraient pas

Même le meilleur journal d’audit ne peut empêcher l’exposition — il ne fait que la documenter. Pour éviter une divulgation accidentelle, il faut empêcher que du contenu sensible apparaisse dans les réponses du modèle. C’est là qu’intervient le masquage dynamique des données.

Le masquage dynamique intercepte et rédige les champs sensibles au moment de la requête. Par exemple, si un utilisateur demande : « Montrez-moi le dossier médical de John », et que le modèle tente de renvoyer des informations personnelles de santé, le masquage dynamique veille à ce que les noms, identifiants ou champs de diagnostic soient remplacés ou masqués dans la réponse. Cela fonctionne particulièrement bien lorsque la GenIA est intégrée dans des systèmes de recherche d’entreprise ou des chatbots.

Un exemple de configuration de masquage en SQL pourrait être le suivant :

CREATE MASKING POLICY mask_sensitive_fields

AS (val STRING)

RETURN CASE

WHEN CURRENT_ROLE IN ('admin') THEN val

ELSE '***MASKED***'

END;

La découverte vous aide à anticiper les risques inconnus

Il est difficile de protéger ce dont on ignore l’existence. Les systèmes GenIA peuvent puiser dans des jeux de données cachés, des tableurs obsolètes ou des partages de cloud regorgeant d’informations personnelles sensibles. La découverte de données permet d’identifier et de classifier ces sources de données.

Une fois que la découverte a cartographié les champs sensibles, les entreprises peuvent leur attribuer des règles de masquage, d’audit et d’accès. Cela boucle le cycle : les données découvertes deviennent des données régies. Cela empêche également les modèles GenIA d’accéder accidentellement à des sources anciennes avec des contrôles faibles.

L’injection de requêtes et les abus nécessitent de nouvelles règles de sécurité

L’injection de requêtes est le nouveau SQL injection. Au lieu de pénétrer dans une base de données, les attaquants tentent d’influencer le comportement du modèle en altérant son entrée. La GenIA peut être manipulée pour ignorer les instructions, divulguer des secrets ou exécuter des actions non autorisées.

Pour atténuer ce risque, mettez en œuvre des règles de sécurité qui surveillent le comportement des entrées et des sorties. La limitation du débit des recherches vectorielles, l’appariement de motifs avec des phrases d’abus connues, et le blocage de l’accès à des tables ou documents spécifiques sont autant de méthodes efficaces. Lorsqu’elles sont combinées avec des contrôles d’accès basés sur les rôles, les systèmes GenIA deviennent beaucoup moins vulnérables.

Un assainisseur de réponses typique pourrait être appliqué de la façon suivante :

if 'SSN' in response:

response = response.replace(user_ssn, '***')

La conformité n’est pas optionnelle — c’est une exigence du système

La GenIA doit fonctionner dans le respect des limites légales et éthiques. Que votre entreprise soit soumise au RGPD, à la HIPAA ou à la PCI DSS, les règles de conformité définissent comment les données sensibles sont utilisées, stockées et enregistrées.

Le Compliance Manager automatise la correspondance entre les réglementations et les contrôles techniques. Vous pouvez lier des règles de masquage à des champs PCI, appliquer des politiques d’audit pour des enregistrements couverts par la HIPAA et générer une documentation qui démontre une conformité continue.

La conformité ne se limite pas à éviter des amendes. Il s’agit de instaurer la confiance dans des systèmes d’IA qui agissent de manière responsable vis-à-vis des données auxquelles ils ont accès.

Une visibilité sur l’ensemble de l’infrastructure est essentielle

Pour une discussion plus approfondie sur l’impact de la sécurité des LLM sur l’infrastructure, consultez le point de vue du MIT sur l’injection de requêtes et les risques des modèles de fondation. Les risques dépassent les cas d’utilisation en entreprise, affectant les modèles open-source, les jeux de données universitaires et les pratiques publiques de collecte de données sur le web.

De plus, l’article du Stanford HAI sur la mise à l’épreuve des modèles de langage par des équipes rouges montre comment les chercheurs testent les systèmes d’IA pour détecter des défaillances éthiques et de sécurité, offrant une perspective utile pour façonner les politiques d’utilisation de la GenIA en entreprise.

L’avenir de la cybersécurité de l’IA réside dans la corrélation. L’audit en temps réel montre qui a fait quoi. Le masquage montre ce qui a été vu. La découverte révèle l’emplacement des données. Les règles de sécurité préviennent les abus. La conformité lie le tout ensemble.

Un système GenIA devient sécurisé uniquement lorsque ces outils partagent un contexte commun. C’est pourquoi la sécurité inspirée par les données — où les décisions de sécurité tiennent compte de la classification des données, des rôles métiers et des schémas d’utilisation — représente l’avenir.

Avec ce modèle, l’innovation et la conformité peuvent coexister, permettant à la GenIA de servir sans compromettre l’intégrité des données qu’elle traite.