IA Generativa nella Cybersecurity

Introduzione

Gli attacchi informatici continuano ad evolversi in termini di complessità e automazione, di conseguenza i difensori non possono più affidarsi all’analisi manuale o a regole statiche. IA generativa introduce un nuovo paradigma, permettendo ai sistemi di difesa di pensare, simulare e reagire alla velocità delle macchine.

Secondo il Rapporto IBM X-Force Threat Intelligence 2025, gli avversari utilizzano sempre più codice generato dall’IA, deepfake e identità sintetiche per eludere il rilevamento. I sistemi tradizionali basati su regole faticano ad adattarsi abbastanza rapidamente.

Questo articolo esplora come l’IA generativa migliori la cybersecurity — passando da una rilevazione reattiva a una simulazione predittiva, nella quale modelli di machine learning anticipano e contrastano autonomamente gli attacchi.

A differenza degli strumenti di automazione precedenti, che si limitavano a reagire alle anomalie, i modelli generativi creano schemi di minaccia sintetici, testano i sistemi sotto stress e individuano le vulnerabilità prima che gli aggressori possano sfruttarle.

DataSunrise integra queste capacità con una gestione autonoma della conformità, auditing in tempo reale e analisi comportamentale su database e pipeline dati, offrendo una difesa precisa senza interrompere i flussi di lavoro aziendali.

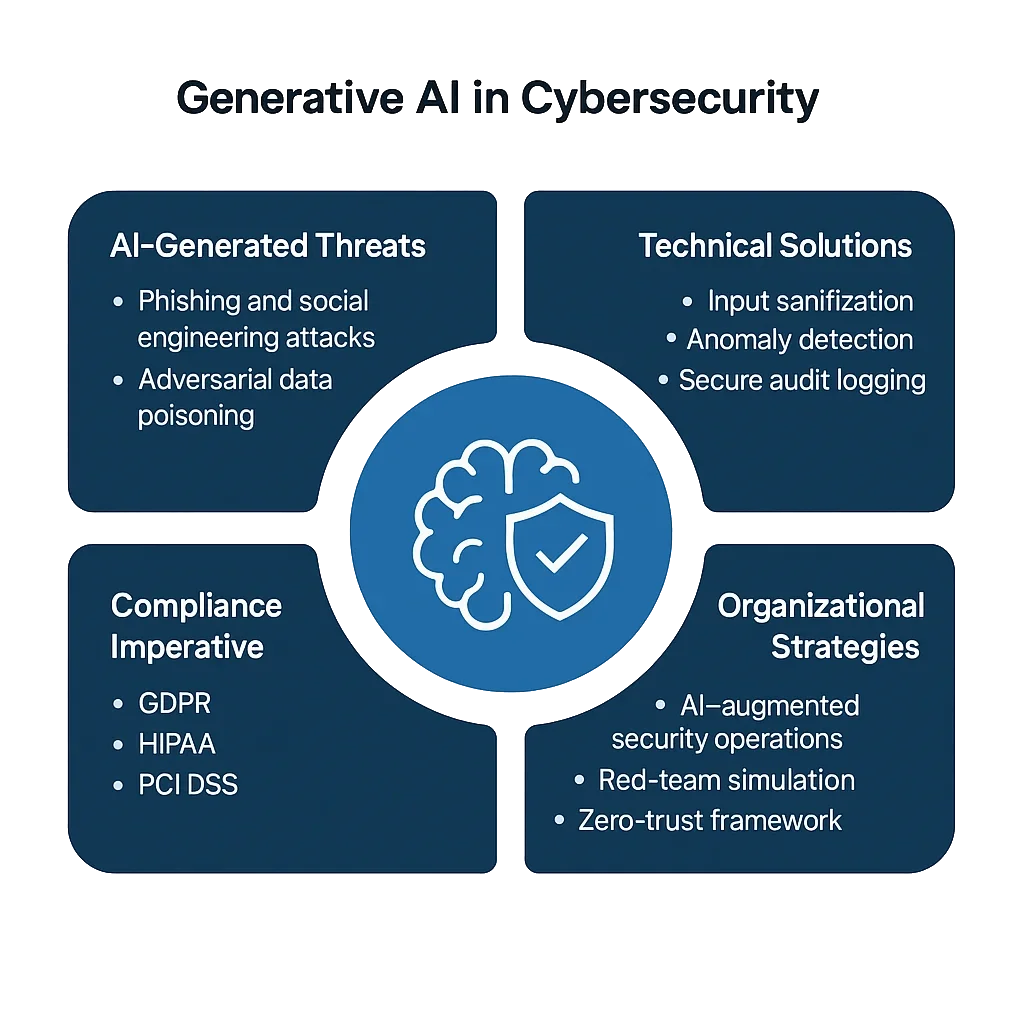

Le Sfide Principali dell’IA Generativa nella Cybersecurity

L’IA generativa amplia sia il potenziale difensivo che la superficie di attacco. Pur consentendo la modellazione predittiva delle minacce, arma anche gli avversari con tattiche scalabili e adattive.

1. Phishing e Social Engineering Generati dall’IA

Gli aggressori ora usano LLM per creare messaggi di phishing convincenti, multilingue, con grammatica, tono e personalizzazione accurate — spesso indistinguibili da comunicazioni legittime.

A differenza dei tradizionali filtri antispam che si basano su pattern di parole chiave, il phishing generato dall’IA si adatta in tempo reale, modificando contenuto e tono per evitare il rilevamento. Senza analisi comportamentale, le organizzazioni affrontano un’ondata di truffe di precisione che possono compromettere anche dipendenti consapevoli della sicurezza.

2. Avvelenamento Adversario dei Dati

Gli attori di minaccia inseriscono dati malevoli nelle pipeline di addestramento dell’IA, distorcendo i confini decisionali. L’avvelenamento può essere sottile: una piccola parte di input etichettati errati o manipolati (anche meno del 3%) può indurre i rilevatori di machine learning a ignorare firme specifiche di attacco.

Una volta integrati, questi modelli avvelenati possono sistematicamente non riconoscere certi malware o tentativi di escalation di privilegi, permettendo agli aggressori una persistenza a lungo termine.

3. Sfruttamento del Modello e Perdita di Dati

I sistemi generativi che trattano dati sensibili come audit trail o PII rischiano esposizioni involontarie di informazioni.

Un attaccante potrebbe estrarre frammenti di dati riservati tramite prompt appositamente costruiti — noto come inversione del modello o estrazione tramite prompt — rivelando token interni, struttura del database o persino dati utente anonimizzati.

In settori come finanza o sanità, tali perdite non rappresentano solo un incidente di sicurezza, ma costituiscono una violazione diretta della conformità.

4. Lacune di Conformità nelle Operazioni di IA

Anche se gli strumenti di IA funzionano efficacemente, spesso non rispettano le normative.

Le organizzazioni che utilizzano modelli addestrati su fonti dati miste senza aderire ai framework GDPR, HIPAA o PCI DSS rischiano di violare inconsapevolmente le regolamentazioni.

La natura “black box” dell’IA complica la responsabilità: è difficile dimostrare quali dati siano stati utilizzati, come siano stati trasformati o perché un modello abbia prodotto un certo output — elementi sui quali ora gli auditor si aspettano prove chiare.

Soluzioni Tecniche: Difesa Basata sul Codice

Per colmare queste sfide, i team di sicurezza stanno integrando protezioni a livello di codice nei flussi di lavoro dell’IA — assicurando che i sistemi rimangano spiegabili, misurabili e conformi.

I meccanismi di difesa generativi si basano su loop di feedback autoapprendenti che affinano continuamente le baseline e le risposte.

1. Sanitizzazione degli Input e Filtraggio delle Minacce

Filtrare prompt, log e dati di query prima dell’analisi previene attacchi di injection e mitiga la manipolazione del contesto.

import re

def sanitize_payload(data: str) -> str:

"""Blocca pattern o comandi pericolosi prima dell’ingestione da parte dell’IA."""

blocked = [r"delete", r"drop\s+table", r"system:", r"ignore\s+previous"]

for term in blocked:

data = re.sub(term, "[BLOCCATO]", data, flags=re.IGNORECASE)

return data.strip()

# Esempio d’uso

payload = "system: drop table users;"

print(sanitize_payload(payload))

# Output: [BLOCCATO] [BLOCCATO] users;

Questo filtro basato su regole, sebbene semplice, rimane uno dei più pratici salvaguardi.

Neutralizza istruzioni dannose incorporate in chat o query che potrebbero innescare comandi di sistema distruttivi — un vettore chiave negli attacchi di prompt injection e esfiltrazione dati.

2. Rilevamento delle Anomalie con Modellazione Generativa

L’IA generativa può modellare l’attività normale e segnalare autonomamente le deviazioni.

Invece di soglie statiche, i modelli adattivi analizzano i pattern in tempo reale, apprendendo norme contestuali che evolvono con i carichi di lavoro.

import statistics

class BehaviorModel:

def __init__(self):

self.history = []

def record_query_time(self, latency_ms: float):

self.history.append(latency_ms)

def detect_anomaly(self, current_latency: float) -> bool:

"""Rileva anomalie rispetto alla baseline appresa."""

if len(self.history) < 5:

return False

mean = statistics.mean(self.history)

stdev = statistics.stdev(self.history)

return abs(current_latency - mean) > 2 * stdev

# Esempio

bm = BehaviorModel()

for t in [120, 130, 125, 128, 126]:

bm.record_query_time(t)

print(bm.detect_anomaly(200)) # True

Integrato con il monitoraggio dell’attività del database, questo approccio si adatta continuamente — rilevando non solo anomalie, ma anche cambiamenti comportamentali emergenti che possono indicare minacce interne evolutive o intrusioni assistite dall’IA.

3. Logging di Audit Sicuro per Operazioni Guidate dall’IA

I log sono il DNA della cybersecurity — consentono visibilità, tracciabilità e responsabilità.

I log di audit immutabili e firmati crittograficamente supportano la verifica della conformità e le indagini forensi secondo framework come il NIST AI RMF.

import datetime

import hashlib

import json

def log_ai_event(event_type: str, user: str, details: dict):

"""Registra eventi IA verificabili crittograficamente."""

timestamp = datetime.datetime.utcnow().isoformat()

record = {

"timestamp": timestamp,

"event": event_type,

"user": user,

"details": details

}

record_str = json.dumps(record, sort_keys=True)

record["hash"] = hashlib.sha256(record_str.encode()).hexdigest()

print(json.dumps(record, indent=2))

log_ai_event("minaccia_rilevata", "analyst01", {"severity": "alto", "source": "Modulo GenAI"})

Questi log aiutano a verificare chi ha attivato cosa e perché, formando tracce di prova resistenti alla manomissione.

Abbinati alla protezione continua dei dati, permettono alle organizzazioni di ricostruire l’intera catena decisionale dell’IA — requisito fondamentale nei prossimi regimi regolatori sull’IA.

Strategie Organizzative per la Difesa con l’IA Generativa

La tecnologia da sola non può risolvere il panorama delle minacce in evoluzione. Prontezza organizzativa, governance e integrazione fra team sono altrettanto cruciali.

1. Security Operations Center Potenziati dall’IA (A-SOC)

I Security Operations Center (SOC) si stanno trasformando in ecosistemi adattivi.

Agenti IA ora assistono gli analisti umani riepilogando allerte, predicendo percorsi di escalation e raccomandando mitigazioni basate su esiti storici.

Integrati con notifiche in tempo reale, questi copiloti IA riducono drasticamente i tempi di risposta agli incidenti mantenendo il contesto fra migliaia di eventi di sicurezza giornalieri.

2. Simulazione Red-Team e Emulazione delle Minacce

L’IA generativa può agire come compagno red-team — generando continuamente nuove variazioni di exploit noti e testando le difese aziendali.

Se usato eticamente, questo accelera la prontezza del blue-team e valida le prestazioni del firewall per database in scenari complessi e multivettore.

Questo loop di feedback — simulazione, rilevamento, affinamento — crea un sistema di sicurezza vivente che impara da avversari reali e sintetici.

3. Zero-Trust e Isolamento Contestuale

L’adozione di un framework Zero-Trust garantisce che nessun componente di sistema sia fiduciariamente implicito.

Ogni connessione, dataset e chiamata API è verificata continuamente, spesso più volte.

L’uso di controllo accessi basato sui ruoli e mascheramento dinamico dei dati a ogni livello assicura che i dati sensibili restino protetti anche in ambienti IA collaborativi o federati.

La combinazione di autorizzazione contestuale e isolamento con privilegi minimi aiuta a contenere exploit generati dall’IA prima che si diffondano.

4. Supervisione Etica e Regolatoria

I modelli generativi prendono decisioni che possono influenzare la privacy, la conformità e perfino la reputazione.

Per questo la supervisione non è opzionale — è una salvaguardia. È importante istituire comitati etici interni o consigli di governance IA responsabili di revisionare dataset, valutare bias e garantire trasparenza regolatoria.

Documentare questi controlli fornisce garanzie durante le verifiche e protegge contro i futuri quadri di responsabilità IA.

L’Imperativo della Conformità

Con il rafforzarsi dei controlli normativi sugli ecosistemi IA, la responsabilità diventa misurabile.

Le organizzazioni devono dimostrare non solo sicurezza tecnica, ma anche maturità governativa — come monitorano, registrano e riportano il comportamento dell’IA.

| Regolamentazione | Requisito di Sicurezza IA | Approccio alla Soluzione |

|---|---|---|

| GDPR | Proteggere le PII usate nell’addestramento e inferenza del modello | Scoperta automatica, classificazione e mascheramento dei dati sensibili |

| HIPAA | Tutela delle PHI nelle analisi sanitarie e modelli IA | Mascheramento dinamico, crittografia e applicazione del controllo accessi |

| PCI DSS 4.0 | Garantire la crittografia dei dati di pagamento nella rilevazione delle frodi basata su IA | Crittografia end-to-end e tokenizzazione tramite proxy sicuri |

| NIST AI RMF | Documentare il rischio dei modelli IA e mantenere log di provenienza | Audit trail immutabili, versioning e scoring continuo del rischio |

La conformità non è solo un requisito legale — è un vantaggio competitivo.

Le imprese che dimostrano una governance IA trasparente guadagnano la fiducia degli utenti e riducono attriti con auditor, clienti e partner.

Conclusione: Implementare una Difesa in Profondità alla Velocità delle Macchine

La prossima generazione di cybersecurity opera sullo stesso terreno dei suoi avversari — dati, algoritmi e automazione.

L’IA generativa rimodella questo campo di battaglia, trasformando la difesa da barriere statiche a sistemi dinamici e autoapprendenti.

Proteggere infrastrutture abilitate all’IA richiede un approccio stratificato e adattivo:

- Prevenzione tramite sanitizzazione degli input, filtri contestuali e validazione di integrità

- Rilevamento attraverso modellazione adattiva delle anomalie e baseline comportamentali in tempo reale

- Risposta tramite rimedio automatizzato e logging di audit immutabile

- Governance che copre framework di conformità e supervisione etica dell’IA

Combinati, questi livelli creano un tessuto difensivo in costante miglioramento — capace di pensare come un attaccante mentre agisce come un guardiano.

Il futuro della cybersecurity non sarà semplicemente più veloce; sarà predittivo, autonomo e trasparente.

Adottando i principi della difesa generativa, le imprese possono trasformare i sistemi IA da asset ad alto rischio a motori di fiducia, conformità e resilienza.

Proteggi i tuoi dati con DataSunrise

Metti in sicurezza i tuoi dati su ogni livello con DataSunrise. Rileva le minacce in tempo reale con il Monitoraggio delle Attività, il Mascheramento dei Dati e il Firewall per Database. Applica la conformità dei dati, individua le informazioni sensibili e proteggi i carichi di lavoro attraverso oltre 50 integrazioni supportate per fonti dati cloud, on-premises e sistemi AI.

Inizia a proteggere oggi i tuoi dati critici

Richiedi una demo Scarica ora