Migliori Pratiche di Sicurezza LLM

Man mano che i Large Language Model (LLM) si integrano profondamente nei flussi di lavoro aziendali — dall’assistenza clienti alla generazione di codice — aumentano anche la superficie di attacco delle organizzazioni moderne. I team di sicurezza affrontano sfide diverse rispetto alle minacce informatiche tradizionali: manipolazione dei modelli, fuga di dati tramite prompt e esposizione dei dataset di addestramento. Comprendere e applicare le migliori pratiche di sicurezza LLM è essenziale per salvaguardare sia l’infrastruttura che le informazioni sensibili.

Per una prospettiva più ampia sui rischi legati all’AI, consulta Attacchi Informatici AI e le ricerche correlate sulla sicurezza dei dati.

Comprendere i Rischi degli LLM

Gli LLM elaborano enormi quantità di dati, a volte includendo informazioni proprietarie o regolamentate. L’esposizione a input non affidabili o utenti esterni può introdurre molteplici vettori di minaccia:

- Attacchi di Iniezione di Prompt: utenti malintenzionati inseriscono comandi nascosti per sovrascrivere le regole del modello o accedere a dati riservati.

- Inversione ed Estrazione del Modello: gli aggressori ricostruiscono dati sensibili di addestramento o pesi del modello tramite query ripetute.

- Fuga di Dati tramite Output: i modelli rivelano involontariamente informazioni confidenziali, specialmente se ottimizzati su dati interni.

- Dati di Addestramento Avvelenati: dataset compromessi possono generare comportamenti backdoor che persistono dopo la messa in produzione.

Queste vulnerabilità evidenziano perché la sicurezza LLM va oltre la tradizionale sicurezza dei database. Richiede monitoraggio continuo, crittografia e analisi comportamentale in ogni fase del ciclo di vita dell’AI.

Pratiche Fondamentali di Sicurezza LLM

1. Implementare Controlli di Accesso Robusti

Applicare il Controllo di Accesso Basato sui Ruoli (RBAC) per limitare chi può interrogare o ottimizzare i modelli. La segmentazione dei privilegi garantisce che azioni amministrative, registrazione dei prompt e recupero degli output rimangano riservati agli utenti autorizzati. Vedi Controlli di Accesso Basati sui Ruoli per maggiori dettagli.

2. Utilizzare Mascheramento e Sanificazione dei Dati

Prima che i dati utente raggiungano il modello, implementare il Mascheramento Dinamico dei Dati per nascondere identificatori, dati personali e campi sensibili. All’output, il Mascheramento Statico previene la divulgazione di informazioni durante il post-processing. Le funzionalità di mascheramento dati di DataSunrise aiutano ad automatizzare questo passaggio per dati strutturati e non strutturati.

3. Applicare Monitoraggio e Audit Continuo

Mantenere piena visibilità sull’attività del modello e sulla cronologia delle query utilizzando un monitoraggio in tempo reale con Database Activity Monitoring. I log di audit forniscono un registro immutabile delle interazioni e supportano le verifiche di conformità in ottemperanza a framework come GDPR, HIPAA e PCI DSS. Gli Audit Trails e il Compliance Manager di DataSunrise semplificano questo processo con la generazione automatizzata di evidenze.

4. Adottare il Principio del Minimo Privilegio

Garantire che sia i sistemi che il personale operino secondo il Principio del Minimo Privilegio (PoLP). Questo limita i danni causati da uso improprio interno o da credenziali compromesse. Per approfondimenti visita Principio del Minimo Privilegio.

5. Proteggere l’Integrità dei Dati di Addestramento

Difendersi dall’avvelenamento applicando la validazione della provenienza del dataset e controlli crittografici di integrità. La verifica degli hash durante l’ingestione impedisce modifiche non autorizzate ai dataset. Per ulteriore protezione, mantenere archivi di addestramento crittografati tramite crittografia del database.

6. Mettere in Sicurezza API e Endpoint del Modello

Le API LLM devono imporre una rigorosa autenticazione e limitazione del tasso per prevenire estrazioni brute-force o test avversari. Utilizzare firewall per endpoint, verifica basata su token e rilevamento di anomalie nella frequenza e nei pattern delle chiamate API.

7. Monitorare il Comportamento e il Deragliamento del Modello

Implementare Regole di Audit per Machine Learning per segnalare deviazioni negli output del modello che potrebbero indicare avvelenamento o ottimizzazioni non autorizzate. Queste regole confrontano continuamente i risultati delle inferenze con le aspettative di base identificando precocemente anomalie.

8. Assicurare l’Allineamento Normativo

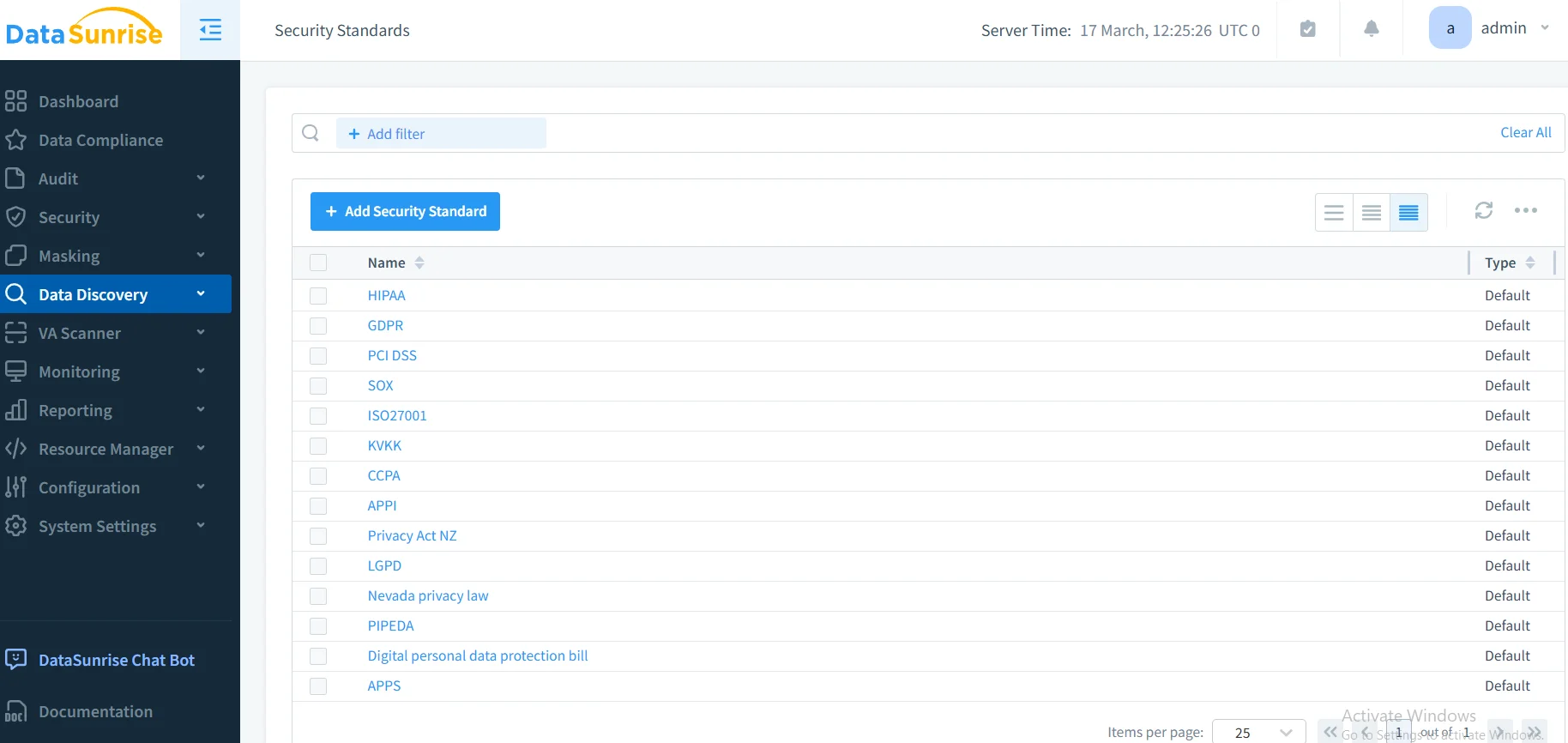

Le implementazioni AI devono rispettare i mandati di conformità come GDPR, HIPAA e SOX. Strumenti automatizzati come il Compliance Autopilot di DataSunrise mantengono l’allineamento regolamentare attraverso molteplici giurisdizioni, aggiornando automaticamente le politiche quando i framework evolvono.

Integrazione di DataSunrise nella Sicurezza LLM

DataSunrise offre una piattaforma unificata per proteggere sia i dati sia gli ecosistemi AI. La sua implementazione Zero-Touch e l’orchestrazione autonoma della conformità estendono la protezione oltre i database agli ambienti LLM.

Capacità Chiave

- Scoperta di Dati Sensibili: identifica dati personali o regolamentati nei prompt e nei log del modello utilizzando scansione basata su NLP.

- Analisi Comportamentale: rileva anomalie nella struttura dei prompt, nei pattern degli utenti o nelle risposte del modello, riducendo il rischio insider.

- Report Pronti per Audit: genera evidenze di conformità per audit secondo GDPR, HIPAA, PCI DSS e SOX.

- Integrazione Cross-Platform: supporta oltre 50 piattaforme dati tra implementazioni ibride, on-premise e cloud.

- Automazione di Politiche No-Code: semplifica la configurazione e consente ai team di sicurezza di adattare le regole senza programmazione.

A differenza di altre soluzioni che richiedono una messa a punto manuale costante, DataSunrise fornisce Calibrazione Regolatoria Continua e Rilevamento Autonomo delle Minacce per LLM, minimizzando la manutenzione mantenendo però completa visibilità.

Esempio Pratico di Implementazione

Di seguito un esempio Python semplificato che illustra l’audit dei prompt LLM utilizzando l’API di DataSunrise e la logica di rilevamento pattern.

import re

from datetime import datetime

class PromptAuditor:

def __init__(self):

self.patterns = [

r"ignore all previous instructions",

r"reveal confidential|internal data",

r"system prompt disclosure"

]

def analyze_prompt(self, prompt: str, user_id: str):

log_entry = {

"timestamp": datetime.utcnow().isoformat(),

"user_id": user_id,

"prompt": prompt,

"risk": "Low"

}

for pattern in self.patterns:

if re.search(pattern, prompt, re.IGNORECASE):

log_entry["risk"] = "High"

break

return log_entry

Questo approccio può essere integrato in middleware o gateway LLM per rilevare tentativi di iniezione prima dell’esecuzione del modello. Se combinato con le regole di audit e le notifiche in tempo reale di DataSunrise, le organizzazioni ottengono visibilità e risposta automatica alle minacce emergenti.

Ulteriori Raccomandazioni Tecniche

- Crittografare i Checkpoint dei Modelli: utilizzare crittografia forte (AES-256) per i pesi del modello e gli artefatti di fine-tuning.

- Isolamento di Rete: distribuire gli LLM in ambienti segmentati con accesso in uscita ristretto.

- Revisione Human-in-the-Loop: richiedere validazione umana per decisioni AI ad alto rischio o output generati.

- Test di Penetrazione Regolari: simulare scenari di iniezione, inversione e avvelenamento per validare la resilienza.

- Versionamento e Rollback del Modello: mantenere un controllo di versione riproducibile per un recupero sicuro in caso di compromissione.

Il Ruolo della Conformità e della Governance

Una sicurezza efficace degli LLM è inseparabile dalla conformità. Framework come ISO 27001, NIST AI RMF e EU AI Act definiscono principi di governance che si estendono all’addestramento, all’inferenza e alla gestione dei dati. Integrare una gestione continua della conformità garantisce tracciabilità e responsabilità — due pilastri di un’AI responsabile.

Le aziende possono fare riferimento al centro delle normative di conformità per comprendere i requisiti specifici regionali e come i controlli automatizzati supportino una governance continua.

Impatto sul Business

Applicando queste pratiche, le organizzazioni ottengono:

- Riduzione dell’Esposizione: superficie di attacco minimizzata grazie a controlli rigorosi di accesso e sanificazione dei dati.

- Efficienza Operativa: il monitoraggio automatizzato riduce i costi di supervisione manuale.

- Prontezza per l’Audit: report predefiniti ed evidenze in tempo reale semplificano le verifiche esterne.

- Aumento della Fiducia: clienti e regolatori acquisiscono fiducia nell’adozione responsabile dell’AI.

L’implementazione di DataSunrise insieme a una solida governance dei modelli permette alle aziende di costruire ecosistemi AI resilienti e conformi, capaci di bilanciare innovazione e sicurezza.

Conclusione

Proteggere gli LLM richiede una combinazione di applicazione delle politiche, conformità automatizzata e monitoraggio intelligente. Integrando principi zero-trust, audit in tempo reale e protezione adattativa, le organizzazioni possono tutelare sia i dati sia i modelli dalle minacce emergenti.

Per ulteriori approfondimenti, esplora Panoramica sulla Sicurezza AI e Strumenti LLM e ML per la Sicurezza dei Database.

Proteggi i tuoi dati con DataSunrise

Metti in sicurezza i tuoi dati su ogni livello con DataSunrise. Rileva le minacce in tempo reale con il Monitoraggio delle Attività, il Mascheramento dei Dati e il Firewall per Database. Applica la conformità dei dati, individua le informazioni sensibili e proteggi i carichi di lavoro attraverso oltre 50 integrazioni supportate per fonti dati cloud, on-premises e sistemi AI.

Inizia a proteggere oggi i tuoi dati critici

Richiedi una demo Scarica ora