Computazione Confidenziale per l’IA

Introduzione

Man mano che le imprese distribuiscono l’intelligenza artificiale (IA) in ambienti ibridi e cloud, la confidenzialità dei dati diventa una delle principali preoccupazioni.

L’addestramento di modelli moderni richiede enormi quantità di informazioni private — dalle immagini mediche e i dati finanziari alle interazioni con i clienti — spesso elaborate su infrastrutture condivise o multi-tenant.

Le misure di sicurezza tradizionali proteggono i dati a riposo tramite crittografia e in transito tramite protocolli sicuri come TLS. Tuttavia, i dati rimangono esposti in uso durante il calcolo — una lacuna che gli attaccanti possono sfruttare.

La Computazione Confidenziale colma questa lacuna. Protegge i dati mentre sono attivamente elaborati, utilizzando Trusted Execution Environments (TEE) — enclave isolate e protette dall’hardware all’interno delle CPU. All’interno di queste enclave, i dati rimangono crittografati e inaccessibili anche agli utenti privilegiati, agli hypervisor o allo stesso fornitore cloud.

Scopri di più dalla guida di Google Cloud alla Computazione Confidenziale per l’IA per approfondimenti architetturali.

La Necessità di un’IA Confidenziale

I sistemi di IA coinvolgono diversi livelli interdipendenti — acquisizione, pre-elaborazione, addestramento e inferenza. Ogni livello introduce una propria superficie di esposizione:

- Dati in Transito: Le informazioni inviate tra servizi cloud possono essere intercettate.

- Dati a Riposo: Una crittografia inadeguata o politiche di accesso errate possono portare al recupero non autorizzato dei dati.

- Dati in Uso: Quando decrittografati in memoria, i dati sensibili possono essere accessibili da insider o sistemi operativi compromessi.

La maggior parte delle imprese gestisce già i primi due stati con strumenti di sicurezza maturi come la crittografia dei database e la protezione a livello di rete. Tuttavia, i dati in uso rimangono vulnerabili perché la crittografia deve essere temporaneamente disabilitata per l’elaborazione.

La Computazione Confidenziale elimina questa necessità. Mantiene il calcolo crittografato, garantendo che i dati grezzi non escano mai dall’enclave sicura. Questo la rende indispensabile per il federated learning, le analisi transfrontaliere e i settori regolamentati dove la conformità a GDPR, HIPAA e PCI DSS è obbligatoria.

Come Funziona la Computazione Confidenziale

La Computazione Confidenziale sfrutta TEE basati su hardware come Intel SGX, AMD SEV e ARM TrustZone. Queste enclave sono piccole porzioni dedicate di memoria CPU che garantiscono integrità, confidenzialità e attestazione.

All’interno di un TEE:

- I dati vengono decrittografati e processati solo entro i confini dell’enclave.

- L’esecuzione del codice rimane isolata dal sistema operativo, dall’hypervisor e dalle altre macchine virtuali.

- L’attestazione remota verifica che solo codice autorizzato e integro venga eseguito nell’enclave prima che le chiavi sensibili vengano fornite.

Questo modello assicura che nemmeno gli amministratori di sistema, gli insider o hypervisor compromessi possano spiare o modificare il carico di lavoro.

Trasforma gli ambienti AI cloud in zone di calcolo affidabili, ideali per carichi confidenziali come l’addestramento di modelli multi-parte o l’inferenza sicura su dati utente.

Flussi di Lavoro AI Protetti dalla Computazione Confidenziale

1. Addestramento di Modelli Sensibili

Dati ad alto rischio, come quelli genomici o finanziari, possono essere processati in modo sicuro all’interno dei TEE senza mai essere esposti.

Ciò consente alle istituzioni di addestrare modelli in modo collaborativo attraverso diverse giurisdizioni mantenendo riservate le informazioni sensibili.

2. Federated Learning e Collaborazione sui Dati

Le organizzazioni possono contribuire con dati crittografati a un processo di addestramento condiviso.

Sono solo i parametri risultanti del modello — non gli input grezzi — a uscire dall’enclave, abilitando una collaborazione che preserva la privacy tra ospedali, banche o centri di ricerca.

3. Inferenza e Predizione Sicure

L’input dell’utente (es. un’immagine medica o una richiesta di prestito) può essere analizzato in modo sicuro all’interno dell’enclave, proteggendo sia l’input che i pesi del modello da accessi esterni.

4. Conformità Regolamentare

La Computazione Confidenziale consente una conformità continua alle normative sulla privacy come GDPR, HIPAA e PCI DSS.

Garantisce un processo pronto per la verifica senza compromettere prestazioni o accessibilità.

Panoramica Architetturale

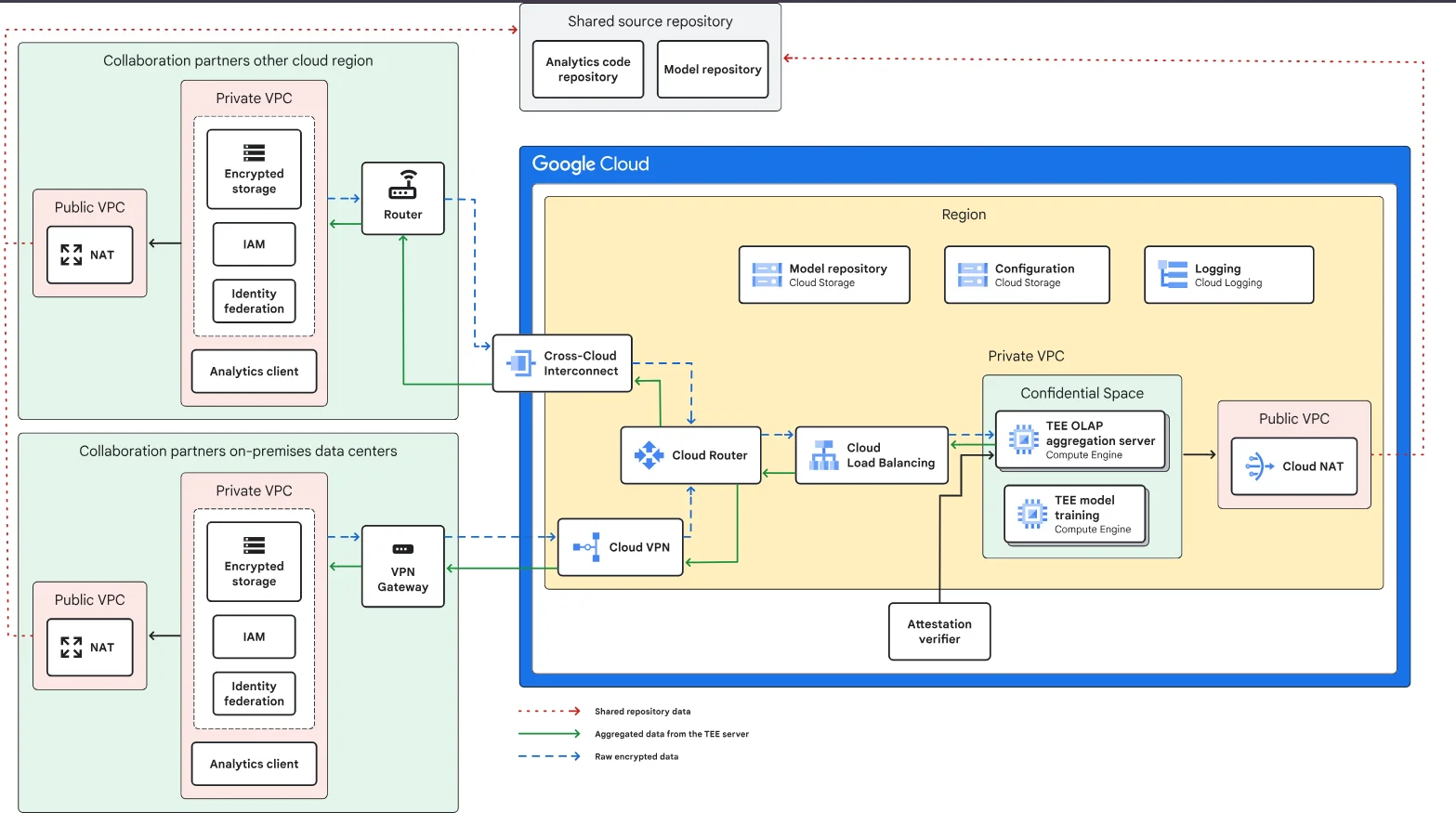

Di seguito un’architettura concettuale di riferimento tratta dalla guida confidenziale per l’IA di Google Cloud.

Suddivisione dell’Architettura

| Componente | Ruolo | Funzione di Sicurezza |

|---|---|---|

| Spazio Confidenziale (TEE) | Esegue calcoli sensibili | Crittografa e isola i dati in uso |

| Storage Crittografato | Conserva i dataset di addestramento | Protegge i dati a riposo con chiavi gestite |

| Bilanciatore di Carico Cloud & Router | Indirizza il traffico tra enclave | Mantiene segmentazione di rete e crittografia |

| Interconnessione Cross-Cloud / VPN | Collega ambienti partner | Garantisce comunicazione crittografata |

| Verificatore di Attestazione | Conferma l’integrità dell’enclave | Previene l’esecuzione di codice non verificato |

| Logging & Monitoraggio | Monitora eventi dell’enclave | Supporta log di audit e verifica della conformità |

Esempio: Esecuzione di modello basata su Enclave

Di seguito un esempio semplificato di esecuzione di modello basata su enclave con attestazione remota prima dell’esecuzione di codice sensibile:

class ConfidentialEnclave:

def __init__(self, enclave_id: str):

self.enclave_id = enclave_id

self.attested = False

def attest(self, signature: str):

"""Verifica l'integrità dell'enclave tramite attestazione."""

if signature == "valid_signature":

self.attested = True

print("Enclave verificata e attendibile.")

else:

raise PermissionError("Attestazione fallita!")

def run_model(self, data: list):

if not self.attested:

raise PermissionError("Il modello non può essere eseguito in un'enclave non verificata.")

print(f"Elaborazione sicura di {len(data)} record all'interno dell'enclave {self.enclave_id}.")

# Esempio di utilizzo

enclave = ConfidentialEnclave("TEE-01")

enclave.attest("valid_signature")

enclave.run_model(["record1", "record2"])

In ambienti di produzione, il processo coinvolge la fornitura sicura delle chiavi e controlli hardware delle firme prima di consentire l’accesso ai pesi crittografati del modello o ai dataset sensibili.

Vantaggi Operativi e di Sicurezza

La Computazione Confidenziale introduce miglioramenti misurabili sia in termini di efficienza operativa che di garanzia di conformità:

- Privacy Migliorata: La memoria crittografata impedisce fughe di dati tramite strumenti di sistema o memory dump.

- Fiducia Verificabile: L’attestazione hardware fornisce prove di integrità dell’enclave per gli auditor esterni.

- Collaborazione Sicura: Diverse organizzazioni possono elaborare dati condivisi senza rivelare dettagli proprietari.

- Allineamento alla Conformità: Meccanismi di crittografia integrati semplificano gli audit secondo framework come SOX o GDPR.

- Resilienza contro le Minacce Interne: Anche gli account privilegiati non possono visualizzare o manipolare i dati dell’enclave.

Queste capacità rendono la Computazione Confidenziale essenziale per la gestione sicura del ciclo di vita dei modelli IA, dall’acquisizione dei dati all’inferenza.

Integrazione della Computazione Confidenziale nelle Pipeline IA

Le organizzazioni possono integrare i TEE nei propri flussi ML esistenti con una minima riprogettazione.

Un tipico flusso di implementazione include:

import hashlib

def secure_pipeline_hash(stage: str, payload: bytes) -> str:

"""Genera un hash immutabile per ogni fase della pipeline IA."""

stage_hash = hashlib.sha256(stage.encode() + payload).hexdigest()

print(f"Fase '{stage}' registrata con hash: {stage_hash}")

return stage_hash

# Esempio: registrazione sicura delle fasi di addestramento

secure_pipeline_hash("data_preprocessing", b"normalized_features")

secure_pipeline_hash("model_training", b"weights_v3.4")

secure_pipeline_hash("evaluation", b"accuracy_0.98")

L’hashing immutabile e i log di attestazione assicurano completa tracciabilità per audit di conformità e analisi forense di incidenti — allineandosi alle best practice nel monitoraggio dell’attività del database.

Sfide e Considerazioni

Nonostante la forte isolazione offerta, le organizzazioni devono considerare fattori pratici prima di un’implementazione su larga scala:

- Overhead di Prestazioni: Il calcolo crittografato può introdurre latenza, richiedendo una pianificazione della capacità.

- Maturità dell’Ecosistema: L’integrazione con GPU, TPU e acceleratori è ancora in fase di sviluppo.

- Compatibilità delle Applicazioni: Il codice legacy potrebbe necessitare di refactoring per funzionare all’interno dei TEE.

- Gestione delle Chiavi: La sicurezza dipende da una robusta gestione del ciclo di vita delle chiavi di crittografia.

Combinare la Computazione Confidenziale con le politiche di sicurezza esistenti e la continua valutazione delle vulnerabilità aiuta a mitigare efficacemente queste sfide.

Mappatura della Conformità

La IA confidenziale supporta direttamente diversi requisiti di conformità che regolano la protezione dei dati durante il processamento.

| Regolamento | Requisito IA Confidenziale | Approccio alla Soluzione |

|---|---|---|

| GDPR | Minimizzazione dei dati e pseudonimizzazione durante il calcolo AI | Isolare e crittografare i dataset in enclave sicure |

| HIPAA | Proteggere le informazioni sanitarie durante le analisi AI | Eseguire addestramento e inferenza del modello all’interno dei TEE |

| PCI DSS 4.0 | Prevenire l’esposizione di dati di pagamento durante l’inferenza del modello | Processare record sensibili solo in ambienti attestati |

| SOX | Garantire responsabilità e auditabilità nel processamento dati AI | Mantenere tracce [audit verificabili](https://www.datasunrise.com/professional-info/aim-of-a-db-audit-trail/) per le operazioni dell’enclave |

| NIST AI RMF | Integrità e resilienza dell’esecuzione AI affidabile | Sfruttare attestazioni hardware e verifica a runtime |

Conclusione

Proteggere i sistemi AI richiede di tutelare i dati lungo tutto il loro ciclo di vita — a riposo, in transito e ora anche in uso.

La Computazione Confidenziale completa questo modello di protezione crittografando i dati durante il calcolo, garantendo che nemmeno gli insider più privilegiati o i fornitori cloud possano accedervi.

Le organizzazioni che adottano questo approccio possono abilitare la collaborazione AI cross-cloud, le analisi che preservano la privacy e la conformità normativa senza compromettere la scalabilità.

Estendendo il design zero-trust allo strato di calcolo, costruiscono una base di fiducia, trasparenza e responsabilità per i sistemi AI di nuova generazione.

Proteggi i tuoi dati con DataSunrise

Metti in sicurezza i tuoi dati su ogni livello con DataSunrise. Rileva le minacce in tempo reale con il Monitoraggio delle Attività, il Mascheramento dei Dati e il Firewall per Database. Applica la conformità dei dati, individua le informazioni sensibili e proteggi i carichi di lavoro attraverso oltre 50 integrazioni supportate per fonti dati cloud, on-premises e sistemi AI.

Inizia a proteggere oggi i tuoi dati critici

Richiedi una demo Scarica ora