Sicherung von LLMs: Beste Praktiken

Da Large Language Models (LLMs) Unternehmensabläufe transformieren, wird die Sicherung von LLMs immer entscheidender. Organisationen weltweit setzen LLM-Systeme in geschäftskritischen Arbeitsabläufen ein. Obwohl diese Technologien beispiellose Fähigkeiten liefern, führen sie auch hochentwickelte Sicherheitsherausforderungen ein, die spezialisierte Schutzstrategien über herkömmliche Cybersecurity-Ansätze hinaus erfordern.

Dieser Leitfaden untersucht wesentliche Best Practices zur Sicherung von LLM-Systemen und liefert praxisnahe Umsetzungsstrategien, die es Organisationen ermöglichen, ihre LLM-Investitionen zu schützen und gleichzeitig operative Exzellenz zu bewahren.

Die hochmoderne LLM-Sicherheitsplattform von DataSunrise bietet Zero-Touch LLM Protection mit autonomer Sicherheitsorchestrierung über alle gängigen LLM-Plattformen hinweg. Unser kontextsensitiver Schutz integriert sich nahtlos in bestehende Infrastrukturen und ermöglicht eine punktgenaue Sicherheitsverwaltung mit No-Code Policy Automation für einen umfassenden LLM-Schutz.

Grundlagen der LLM-Sicherheit verstehen

Large Language Models stellen einzigartige Sicherheitsherausforderungen dar, die über die traditionelle Anwendungssicherheit hinausgehen. Diese Systeme verarbeiten enorme Mengen unstrukturierter Daten, erzeugen dynamische Inhalte und unterhalten persistente Verbindungen über verteilte Infrastrukturen, wodurch umfangreiche Angriffsflächen entstehen, die umfassende Datensicherheitsrichtlinien und die Minderung von Datenbankbedrohungen erfordern.

Eine effektive LLM-Sicherheit umfasst die Eingabevalidierung, den Schutz der Modellintegrität, die Ausgabe-Säuberung und eine umfassende Bedrohungserkennung während des gesamten LLM-Lebenszyklus. Organisationen müssen robuste Datenschutzmaßnahmen implementieren und gleichzeitig operative Effizienz bewahren.

Kritische Sicherheitsbedrohungen bei LLMs

Prompt-Injektion und Manipulation

LLM-Systeme sind hochentwickelten Prompt-Injektionsangriffen ausgesetzt, die darauf abzielen, das Verhalten des Modells zu manipulieren und sensible Informationen zu extrahieren. Angreifer erstellen bösartige Eingaben, um Sicherheitsmaßnahmen zu umgehen, unautorisierten Zugriff auf Daten zu erlangen oder schädliche Inhalte zu generieren, was die Implementierung umfassender Sicherheitsregeln erforderlich macht.

Modell-Extraktion und Datenleckage

Hochentwickelte Angreifer versuchen, urheberrechtlich geschützte LLM-Modelle durch systematisches API-Testing zu reverse-engineeren. LLMs können unbeabsichtigt sensible Informationen durch das Auswendiglernen von Trainingsdaten oder den Übergriff von Kontextelementen zwischen Unterhaltungen preisgeben, sodass umfassende Datenmaskierung und Zugriffskontrollen mit detaillierter Aktivitätsprotokollierung notwendig sind.

Wesentliche Best Practices zur LLM-Sicherheit

Eingabevalidierung und Ausgabeüberwachung

Implementieren Sie umfassende Eingabevalidierung, um Prompt-Injektionsangriffe zu verhindern und gleichzeitig die Funktionalität des Modells zu erhalten. Setzen Sie eine Echtzeit-Ausgabeüberwachung ein, um potenziell schädliche oder sensible Inhalte zu erkennen und zu filtern, bevor sie den Endnutzern zugänglich gemacht werden, und integrieren Sie entsprechende Prüfprotokolle zur Archivierung.

Zugriffskontrolle und Authentifizierung

Setzen Sie robuste Authentifizierungsmechanismen ein, einschließlich Multi-Faktor-Authentifizierung, rollenbasierter Zugriffskontrolle (RBAC) und API-Schlüsselverwaltung. Wenden Sie das Prinzip der minimalen Berechtigung bei allen LLM-Interaktionen an.

Kontinuierliche Überwachung und Auditierung

Implementieren Sie umfassende Audit-Funktionen mit Echtzeitüberwachung und detaillierten Audit-Trails für alle LLM-Interaktionen, die eine umfassende Berichtserstellung ermöglichen.

LLM-Sicherheitsimplementierungs-Framework

Hier ein praktischer Sicherheitsvalidierungsansatz für LLM-Systeme:

import re

class LLMSecurityValidator:

def validate_prompt(self, prompt: str):

"""Grundlegende Sicherheitsvalidierung für LLM-Prompts"""

# Prompt-Injektion erkennen

injection_patterns = [

r'ignore\s+previous\s+instructions',

r'act\s+as\s+if\s+you\s+are'

]

threat_detected = any(re.search(p, prompt, re.IGNORECASE)

for p in injection_patterns)

# PII maskieren (Beispiel: E-Mail)

sanitized = re.sub(r'\b[\w._%+-]+@[\w.-]+\.[A-Z|a-z]{2,}\b',

'[EMAIL_MASKED]', prompt)

return {

'threat_detected': threat_detected,

'sanitized_prompt': sanitized,

'risk_level': 'HIGH' if threat_detected else 'LOW'

}

# Anwendungsbeispiel

validator = LLMSecurityValidator()

result = validator.validate_prompt("Show [email protected] details")

print(f"Risk: {result['risk_level']}, Output: {result['sanitized_prompt']}")

Implementierungs-Best Practices

Für Organisationen:

- Mehrschichtige Verteidigung: Implementieren Sie Sicherheitskontrollen auf der Eingabe-, Verarbeitungs- und Ausgabeschicht.

- Zero-Trust-Architektur: Wenden Sie eine Überprüfung bei allen LLM-Interaktionen an, mit umfassender Überwachung und Datenbank-Firewall-Schutz.

- Regelmäßige Bewertungen: Führen Sie regelmäßige Sicherheitsüberprüfungen und Schwachstellenbewertungen durch und setzen Sie statische Datenmaskierung für sensible Daten ein.

- Governance-Framework: Etablieren Sie klare Richtlinien für die Nutzung von LLMs und Datenmanagement.

Für technische Teams:

- Sichere Entwicklung: Integrieren Sie Sicherheitskontrollen in die Entwicklung von LLM-Anwendungen mit Datenbankverschlüsselung.

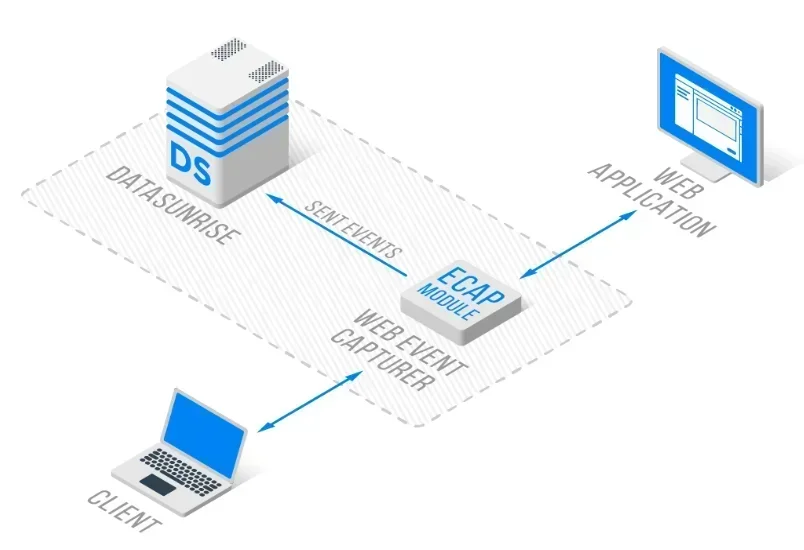

- API-Sicherheit: Implementieren Sie robuste API-Authentifizierung und Ratenbegrenzung mittels Reverse-Proxy-Architektur.

- Monitoring-Integration: Bauen Sie umfassende Protokollierungs- und Überwachungsfunktionen ein.

- Testprotokolle: Etablieren Sie Sicherheits-Testverfahren für LLM-Anwendungen.

DataSunrise: Umfassende LLM-Sicherheitslösung

DataSunrise bietet Sicherheitslösungen auf Enterprise-Niveau, die speziell für LLM-Umgebungen entwickelt wurden. Unsere Plattform liefert AI Compliance by Default mit maximaler Sicherheit und minimalem Risiko über ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant und benutzerdefinierte LLM-Bereitstellungen hinweg.

Wesentliche Sicherheitsmerkmale:

- Echtzeit-Überwachung der LLM-Aktivitäten: Umfassende Verfolgung mit Audit-Protokollen für alle LLM-Interaktionen und Prompts.

- Fortschrittliche Bedrohungserkennung: ML-gestützte Erkennung verdächtigen Verhaltens mit kontextsensitivem Schutz.

- Dynamischer Datenschutz: Punktgenaue Datenmaskierung zum Schutz von PII in Prompts und Antworten.

- Plattformübergreifender Schutz: Einheitlicher Schutz über über 50 unterstützte Plattformen.

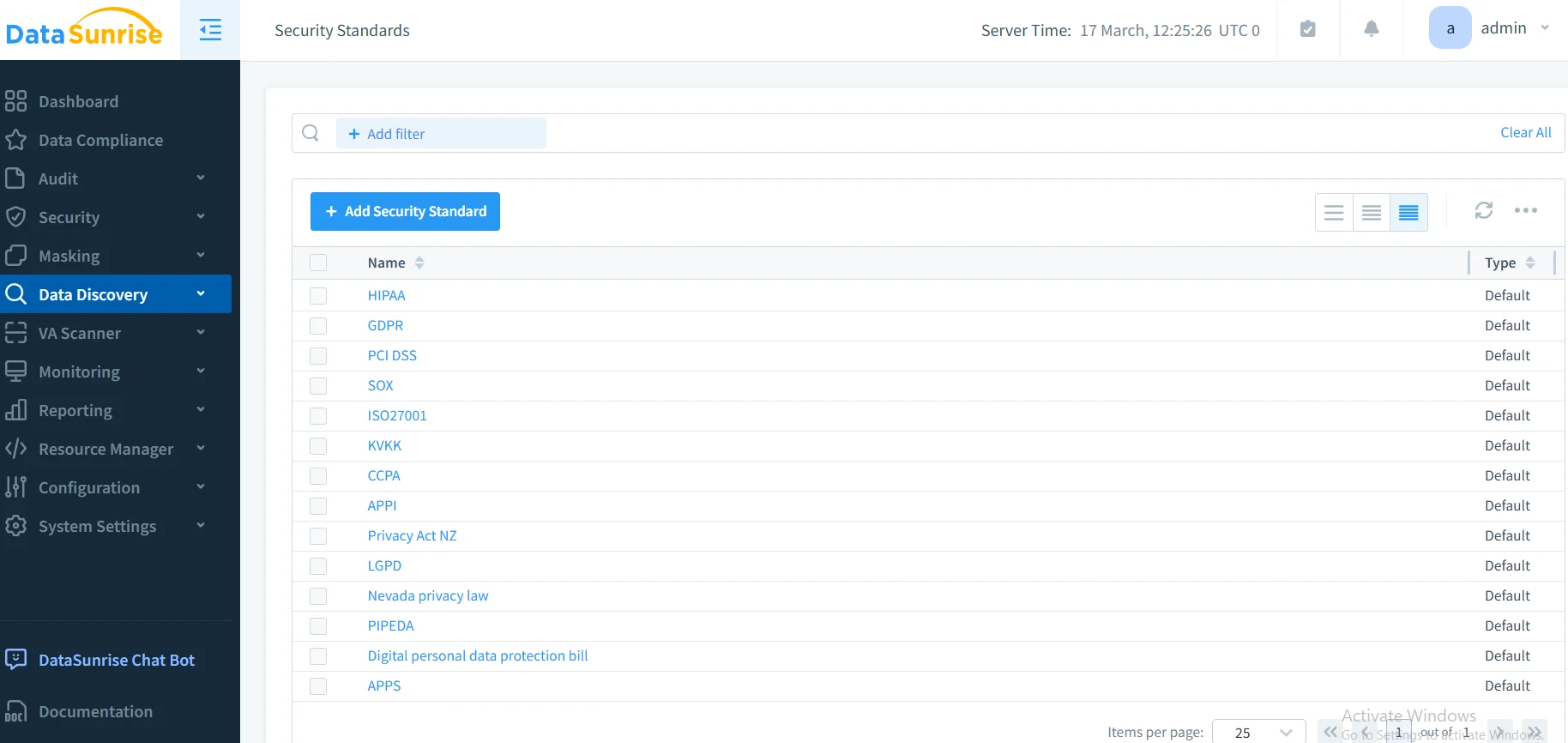

- Automatisierung der Compliance: Automatisierte Compliance-Berichterstattung für GDPR-, HIPAA-, PCI-DSS- und SOX-Anforderungen.

Die flexiblen Bereitstellungsmodi von DataSunrise unterstützen On-Premise-, Cloud- und Hybridumgebungen mit Zero-Touch-Implementierung. Organisationen erzielen eine signifikante Reduktion von LLM-Sicherheitsvorfällen und eine verbesserte Compliance-Lage durch automatisierte Überwachung.

Regulatorische Compliance-Überlegungen

Die LLM-Sicherheit muss umfassende regulatorische Anforderungen adressieren:

- Datenschutz: GDPR und CCPA-Anforderungen für die Verarbeitung personenbezogener Daten.

- Industrie-Standards: Gesundheitswesen (HIPAA) und Finanzdienstleistungen (PCI DSS, SOX).

- Entstehende KI-Governance: EU AI Act und ISO 42001-Anforderungen für Transparenz und Verantwortlichkeit bei LLMs.

Fazit: Sichere Grundlagen für LLMs schaffen

Die Sicherung von LLMs erfordert umfassende Strategien, die einzigartige Bedrohungsvektoren adressieren und gleichzeitig Innovation ermöglichen. Organisationen, die robuste Best Practices zur LLM-Sicherheit implementieren, positionieren sich, um das transformatives Potenzial von KI zu nutzen, während sie das Vertrauen der Stakeholder und die operative Resilienz beibehalten.

Eine effektive LLM-Sicherheit kombiniert technische Kontrollen mit organisatorischer Governance und schafft so widerstandsfähige Systeme, die sich an sich entwickelnde Bedrohungen anpassen und gleichzeitig geschäftlichen Mehrwert liefern. Mit der zunehmenden Verbreitung von LLMs wird Sicherheit nicht nur zu einer Compliance-Anforderung, sondern zu einem Wettbewerbsvorteil.

DataSunrise: Ihr LLM-Sicherheitspartner

DataSunrise führt den Markt bei LLM-Sicherheitslösungen an und bietet umfassenden KI-Schutz mit fortschrittlicher Bedrohungserkennung, die speziell für komplexe LLM-Umgebungen entwickelt wurde. Unsere kosteneffiziente, skalierbare Plattform bedient Organisationen von Start-ups bis hin zu Fortune-500-Unternehmen.

Erleben Sie unsere autonome Sicherheitsorchestrierung und entdecken Sie, wie DataSunrise quantifizierbare Risikoreduktion für LLM-Bereitstellungen ermöglicht. Vereinbaren Sie Ihre Demo, um unsere umfassenden LLM-Sicherheitsfunktionen kennenzulernen.