Bewertung der Sicherheitslage in KI & LLM-Kontexten

Generative KI (GenAI) und große Sprachmodelle (LLMs) haben neue Wege eröffnet, wie Organisationen Automatisierung, Analyse und die Beschleunigung von Entscheidungsprozessen realisieren können. Allerdings wirft ihr inhärentes Design – der Umgang mit dynamischen, oft unstrukturierten und sensiblen Daten – ernsthafte Sicherheitsbedenken auf. Die Bewertung der Sicherheitslage in KI- und LLM-Kontexten erfordert neue Strategien, die darauf zugeschnitten sind, wie diese Modelle Daten verarbeiten und offenlegen.

Von traditionellen zu adaptiven Sicherheitsmodellen

In traditionellen Systemen beruhte die Datensicherheit oft auf einem perimetrischen Ansatz. Bei GenAI muss die Sicherheit kontextbezogen werden. Diese Modelle verarbeiten große Datensätze, identifizieren Muster und können sensible Informationen regenerieren, wenn sie nicht ordnungsgemäß abgestimmt sind. Ein Prompt könnte unbeabsichtigt Zugangsdaten, Geschäftsgeheimnisse oder personenbezogene Informationen (PII) extrahieren.

Daher geht es bei der Sicherung von KI-Pipelines nicht nur um Firewalls und Rollen. Es erfordert adaptive Datensicherheit, datenschutzkonformes Logging und in Echtzeit implementierte Kontrollen im KI-Lebenszyklus. Wie durch Googles sichere KI-Praktiken hervorgehoben wird, müssen KI-spezifische Kontrollen sowohl mit der Infrastruktur als auch mit dem Modellverhalten übereinstimmen.

Echtzeit-Audit und Verhaltensüberwachung

KI-Arbeitslasten benötigen Echtzeitaudit-Mechanismen, um jede Interaktion zwischen Benutzern und Modellen zu erfassen. Da GenAI-Systeme bei jedem Prompt neuartige Ausgaben erzeugen können, muss das Logging Eingaben, Ausgaben, Sitzungsidentitäten und nachgelagerte Anfragen abdecken.

Betrachten Sie folgendes Szenario: Ein Datenanalyst interagiert über natürliche Sprache mit einem internen GenAI-System.

Prompt: "Liste alle Kunden aus Deutschland, die im letzten Quartal Einkäufe über $10,000 getätigt haben."

Das LLM generiert die SQL-Abfrage:

SELECT customer_id, name, email, country, total_purchase

FROM sales.customers

WHERE country = 'Deutschland' AND total_purchase > 10000 AND purchase_date BETWEEN '2024-10-01' AND '2024-12-31';

Diese Anfrage betrifft Kundenkennungen, Kontaktinformationen und Finanzdaten. Ein gut gestalteter Audit-Trail erfasst sowohl den Prompt als auch das generierte SQL und verknüpft diese mit der Sitzung und dem Zeitkontext des Benutzers. Tools wie Behavior Learning Audit helfen dabei zu ermitteln, ob ein solcher Zugriff üblich oder potenziell missbräuchlich ist. Dieser Ansatz stimmt mit dem AI Risk Management Framework des NIST überein, das eine kontinuierliche Überwachung betont.

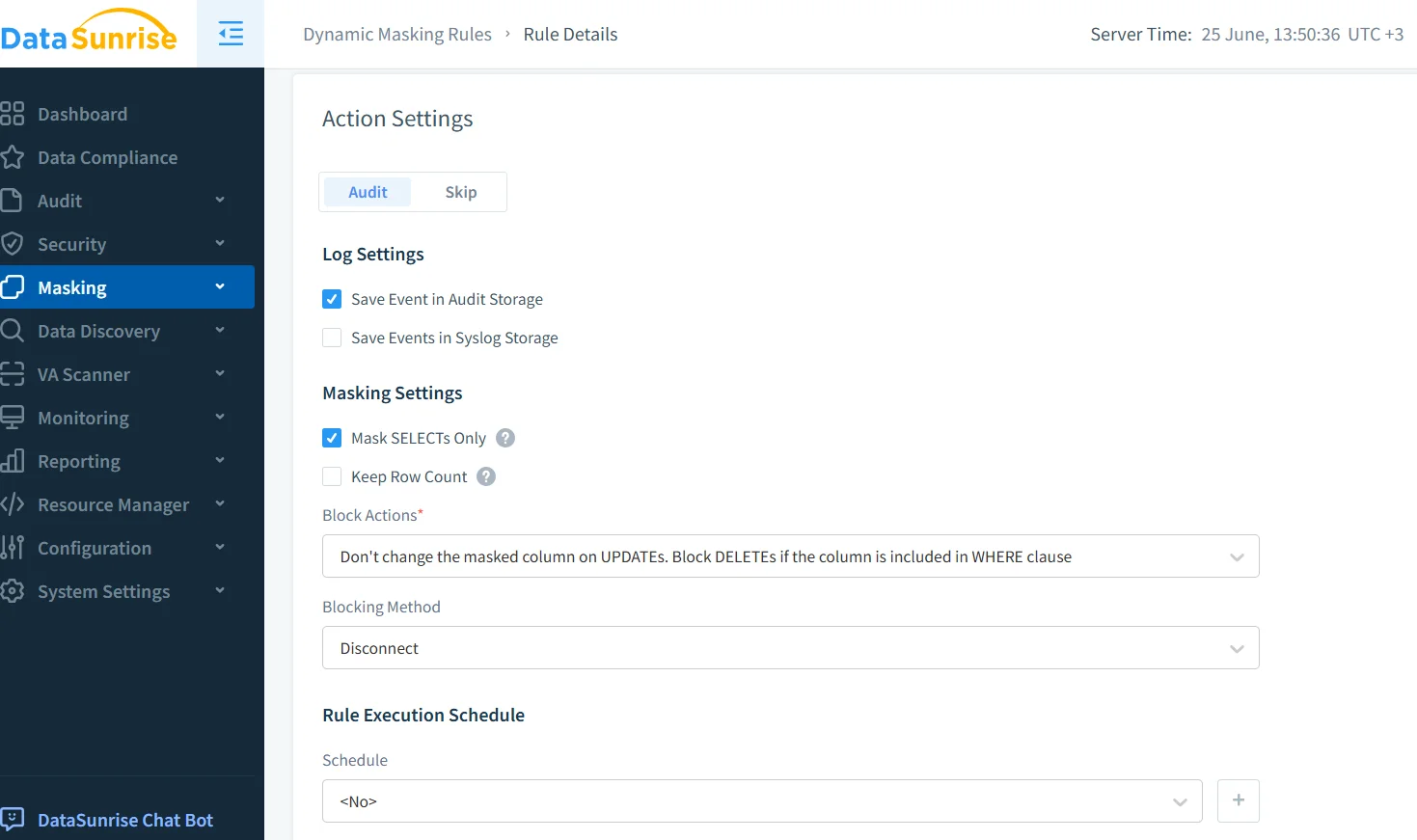

Dynamische Maskierung für Modellantworten

Da die Ausgaben von GenAI dynamisch generiert werden, sorgt die dynamische Datenmaskierung dafür, dass sensible Informationen vor der Anzeige verschleiert werden. Dieser Ansatz balanciert Benutzerfreundlichkeit und Compliance.

Angenommen, ein Support-Bot ist mit einer Kundendienst-Datenbank verbunden. Wenn gefragt wird:

"Zeige mir das Kundenprofil von John Doe."

Das Backend könnte folgende Ausgabe erzeugen:

{

"name": "John Doe",

"email": "[email protected]",

"ssn": "123-45-6789",

"credit_card": "4111 1111 1111 1111"

}

Mit aktivierter Maskierung für sensible Felder:

{

"name": "John Doe",

"email": "j*****[email protected]",

"ssn": "***-**-6789",

"credit_card": "**** **** **** 1111"

}

Die Maskierung ist kontextbezogen und hängt von der Benutzerrolle, der Quelle und den Klassifizierungsregeln ab. Microsoft empfiehlt zudem, Datenausgaben in KI-Systemen durch mehrschichtige Durchsetzungstechniken zu schützen.

Datenentdeckung vor der KI-Einbindung

Bevor Daten in LLMs eingespeist werden, müssen Organisationen Datenentdeckungstools einsetzen, um nach PII, finanziellen Identifikatoren und geschäftssensiblen Werten zu suchen. Dies ermöglicht es den Sicherheitsteams, risikoreiche Assets zu kennzeichnen und sie von Trainingssätzen oder Echtzeitzugriff auszuschließen.

Anstatt sich ausschließlich auf manuelle Konfiguration zu verlassen, kann die automatisierte Entdeckung sensible Felder klassifizieren und in Maskierungs-, Verschlüsselungs- oder Zugriffregeln integrieren. Der Data Governance Guide von IBM bietet wertvolle Praktiken zur effektiven Einrichtung dieser Workflows. Die Integration mit automatisierten Richtlinien-Engines gewährleistet eine konsistente Durchsetzung in KI-Umgebungen.

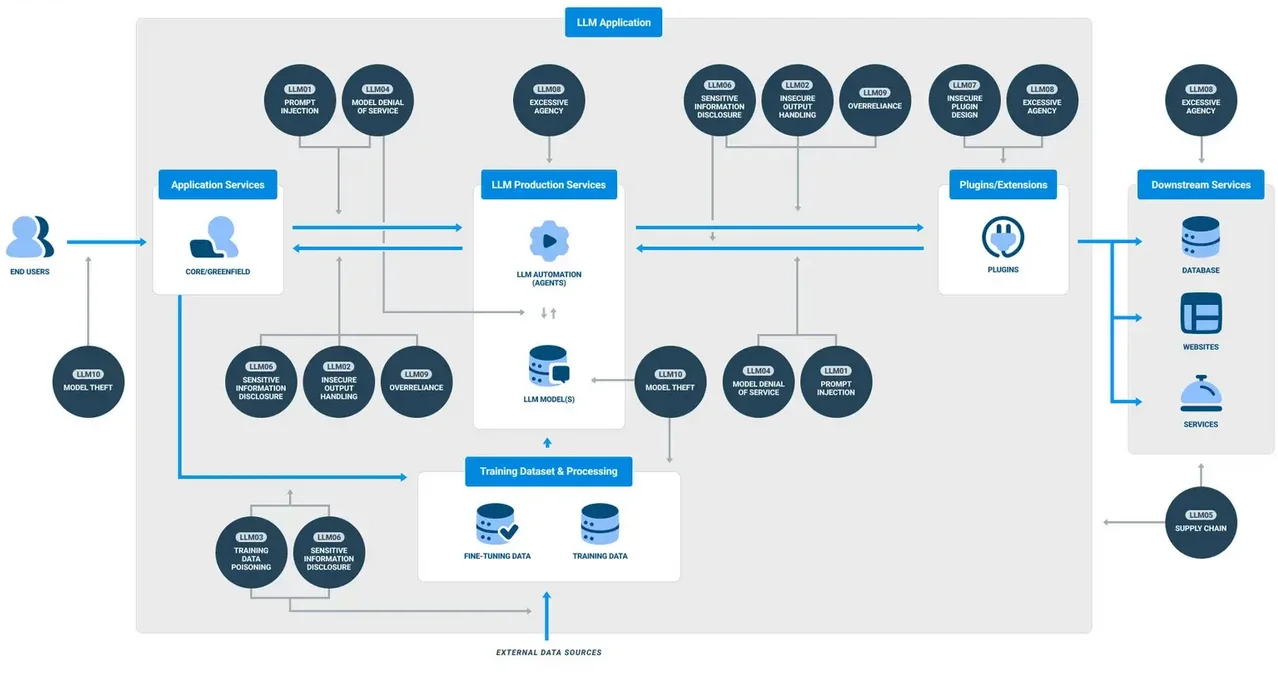

Sicherheitsrichtlinien, die auf KI zugeschnitten sind

Statische Erlaubnis-/Ablehnungsregeln sind im GenAI-Kontext unzureichend. Richtlinien müssen sich basierend auf dem Benutzerverhalten, der Intention des Prompts und der Sensitivität der Ausgabe anpassen. Beispielsweise kann die Musteranalyse bösartige Prompt-Injection-Versuche erkennen, während zeitbasierte Beschränkungen den Zugriff auf bestimmte Daten außerhalb der Geschäftszeiten einschränken können.

Systeme wie der Schutz vor SQL-Injektionen müssen sich weiterentwickeln, um nicht nur SQL, sondern auch natürliche Sprachprompts, die Datenbankaktivitäten generieren, zu analysieren. Forschungen von Stanford zeigen, wie subtile Prompt-Variationen herkömmliche Filter umgehen und privilegierte Daten extrahieren können.

GenAI an Daten-Compliance-Standards anpassen

LLM-basierte Systeme müssen dennoch den Anforderungen der DSGVO, HIPAA und PCI DSS genügen. Dies beinhaltet die Sicherstellung der Prüfungsfähigkeit, die Achtung der Löschrechte von Benutzerdaten und die Verhinderung unbefugter grenzüberschreitender Datenaussetzungen.

Compliance in GenAI-Umgebungen bedeutet, Datenaufbewahrungsrichtlinien zu implementieren, die die Speicherung der Prompt-Historie einschränken, Zugriffsbeschränkungen durch rollenbasierte Kontrollen durchzusetzen und Maskierung auf Audit-Logs anzuwenden. Compliance Manager vereinfachen die Überwachung, indem sie automatisierte Berichte erstellen und standardisierte Richtlinien durchsetzen. Zum Nachlesen bietet CNILs Leitfaden zu KI und DSGVO nützliche Rahmenwerke, die speziell auf den Einsatz von KI zugeschnitten sind.

Fazit: Ein lebendiges Sicherheits-Framework

Die Bewertung der Sicherheitslage in KI- und LLM-Kontexten ist keine einmalige Checkliste. Es handelt sich um einen kontinuierlichen Kreislauf aus Monitoring, Maskierung, Auditierung und der Anpassung an Compliance. Tools müssen interoperabel, in Echtzeit und KI-bewusst sein. Sicherheit muss über die Infrastruktur hinausgehen und auch die Model-Prompts, Ausgaben und das Benutzerverhalten umfassen.

Organisationen, die GenAI einsetzen, müssen ein lebendiges Sicherheits-Framework aufbauen – eines, das sich anpasst, während sich das Modell weiterentwickelt, lernt und mit einer zunehmend dynamischen Umgebung interagiert.