GenAI Sicherheits- & Governance-Checkliste für LLMs

Generative KI (GenAI), insbesondere Modelle, die von großen Sprachmodellen (LLMs) betrieben werden, eröffnet eine neue Grenze der Innovation – und des Risikos. Diese Modelle verarbeiten, generieren und analysieren Daten in großem Umfang, wobei sie häufig auf unterschiedliche und sensible Quellen zurückgreifen. Mit großer Leistung kommt der dringende Bedarf an starker Sicherheit und Governance.

Diese Checkliste zeigt auf, wie man GenAI-Pipelines durch mehrschichtige Kontrollen absichert: Sichtbarkeit, Schutz, Verantwortlichkeit und Automatisierung.

Echtzeitüberwachung für LLM-Arbeitslasten

LLMs sehen vielleicht nicht wie traditionelle Datenbanken aus, aber ihr Verhalten sollte ebenso gründlich protokolliert werden. Das Erfassen jeder Interaktion – von Eingabeaufforderungen bis zu generierten Antworten – ermöglicht es, sensible Datenausgaben nachzuvollziehen, Missbrauch zu erkennen und den Anforderungen von Compliance-Prüfern gerecht zu werden. Tools wie Database Activity Monitoring bieten diese Sichtbarkeit in Echtzeit.

SELECT * FROM pg_stat_activity WHERE datname = 'llm_logs';

Dieses PostgreSQL-Beispiel zeigt, wie man Datenbanksitzungen mit Metadaten zur LLM-Nutzung in Beziehung setzt.

Siehe auch: Lernregeln und Audit zur Feinabstimmung von Prüfungsrichtlinien.

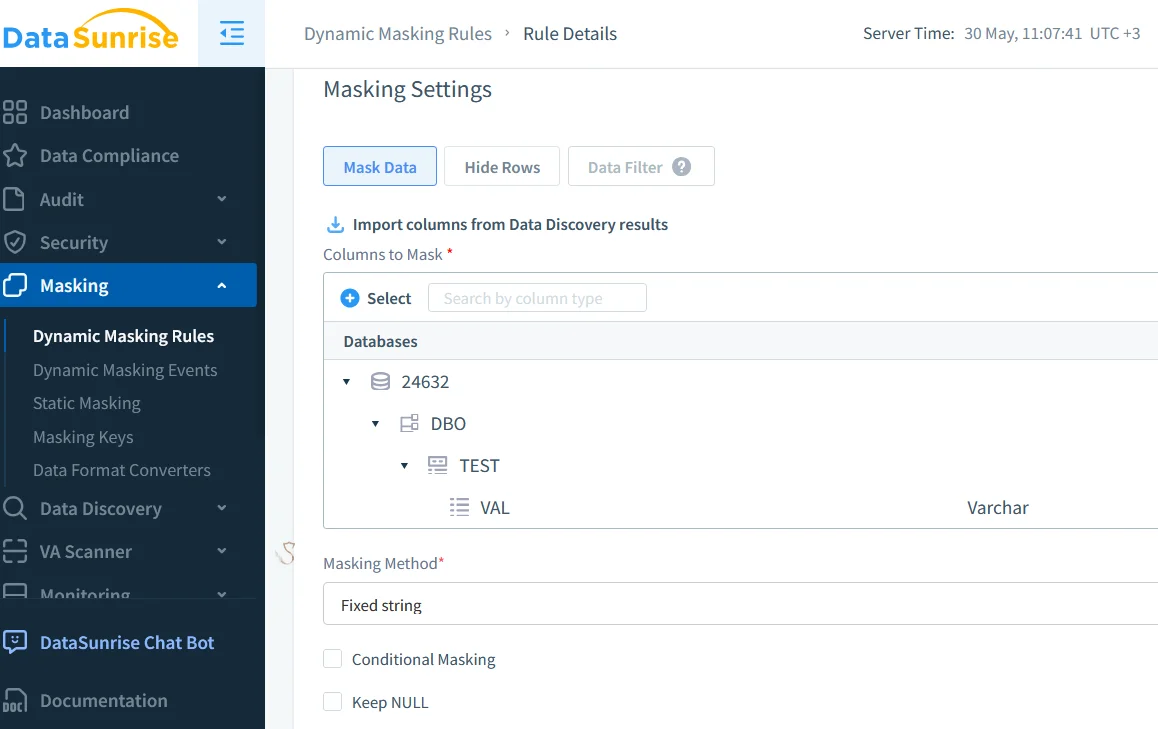

Echtzeit-Datenmaskierung in GenAI-Pipelines

Sensible Daten wie Kunden-E-Mails, Tokens oder medizinische Aufzeichnungen dürfen nicht in Eingabeaufforderungen, Antworten oder Protokolle gelangen. Dynamische Datenmaskierung wirkt in Echtzeit und passt sich basierend auf der Benutzerrolle oder dem Zugriffslevel an.

Sie ist besonders wertvoll in Umgebungen wie Prompt-Engineering-Tools, RAG-basierten Systemen und geteilten Inferenz-APIs – wo Benutzerinteraktionen häufig sind und Datenrisiken hoch eingeschätzt werden.

Für tiefere Einblicke in den Schutz sensibler Felder besuchen Sie den Artikel über In-Place Masking.

Automatisierte Entdeckung sensibler Daten

Man kann nicht das steuern, was man nicht findet. Automatisierte Datenerkennungs-Scans sind entscheidend, um sensible Felder aufzuspüren, insbesondere in Vektorspeichern oder multimodalen Pipelines.

Diese Scans klassifizieren Eingabeaufforderungen und Benutzerdaten, kennzeichnen Ausgaben für die Richtliniendurchsetzung und unterstützen regulatorische Anforderungen wie die DSGVO oder HIPAA. Sie helfen Teams dabei, die Kontrolle darüber zu behalten, was das Modell lernt und ausgibt.

Schauen Sie sich Daten als wertvolles Gut behandeln an, um Ihre Entdeckungsstrategie zu verstärken.

Zugriffskontrolle und Einschränkungen auf Prompt-Ebene

LLMs sind anfällig für Missbrauch durch Prompt-Injektion oder Plugin-Eskalation. Um diese Risiken zu reduzieren, implementieren Sie rollenbasierte Zugriffskontrolle (RBAC) und Eingabefilterung. Diese Maßnahmen verhindern Lecks durch Nutzer mit geringem Vertrauen, begrenzen den Missbrauch von Prompts, der administrative Aktionen anvisiert, und helfen dabei, den Zugriff über Teams und Abteilungen hinweg zu verwalten.

Möglicherweise möchten Sie auch Zugriffskontrollen und das Prinzip der geringsten Privilegien erkunden, um LLM-Einsätze abzusichern.

Optimiertes Compliance-Management

Manuelle Überprüfungen lassen sich nicht skalieren. Tools wie der Compliance Manager helfen dabei, regulatorische Zuordnungen festzulegen, Zugriffs- und Aufbewahrungsregeln durchzusetzen und Berichte auf Abruf zu erstellen.

Zum Beispiel:

CREATE MASKING RULE mask_email

ON llm_prompt_logs(email)

USING FULL;

Diese Regel stellt sicher, dass E-Mail-Daten maskiert werden, bevor sie analysiert oder exportiert werden.

Weitere Informationen zur Bedeutung dieses Schrittes finden Sie unter Berichtserstellung.

Ressourcen, die es zu erkunden lohnt

Durchstöbern Sie diese Referenzen, um weitere Einblicke in die Sicherung von LLM-Pipelines zu gewinnen:

- NIST AI Risikomanagement-Framework

- Microsoft Responsible AI

- OWASP Top 10 für LLMs

- Google Secure AI Framework (SAIF)

- Anthropic’s Constitutional AI-Papier

Auf Sichtbarkeit und Vertrauen bauen

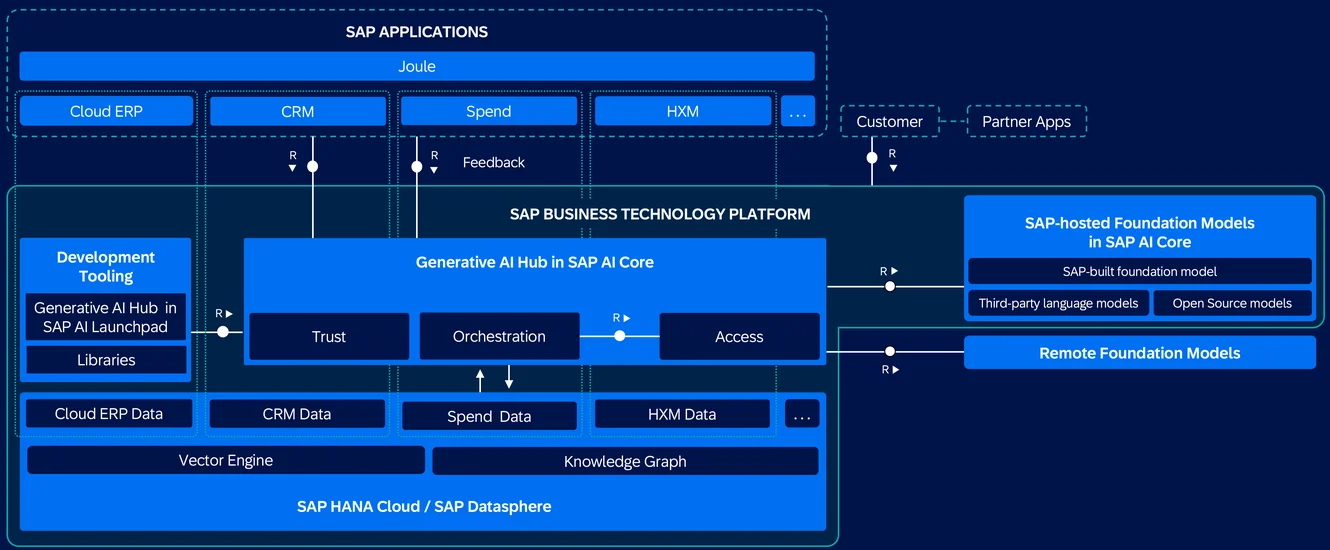

Die Sicherung von GenAI basiert darauf, intelligente Steuerungen zu schichten, anstatt Innovationen zu blockieren. Ihre Governance-Architektur sollte Echtzeit-Auditierbarkeit, rollenbasierte Maskierung, kontinuierliche Erkennung und automatisierte Compliance-Prüfungen beinhalten.

Um tiefer einzutauchen, lesen Sie über Audit Trails, Datensicherheit, LLM- und ML-Tools für die Datenbanksicherheit sowie synthetische Datengenerierung als Alternative für das sichere Testen oder Trainieren von GenAI-Systemen.