GenAI Risikominderungsstrategien

Generative KI (GenAI) hat die Art und Weise verändert, wie Unternehmen mit Daten interagieren. Diese Modelle erstellen Inhalte, generieren Code, fassen Dokumente zusammen und automatisieren Entscheidungen. Gleichzeitig bringen sie jedoch Bedenken hinsichtlich Datenschutz, Sicherheit und Compliance mit sich. Das Risiko steigt, wenn GenAI-Systeme sensible oder regulierte Daten ohne angemessene Kontrollen verarbeiten.

Dieser Artikel beleuchtet wesentliche GenAI Risikominderungsstrategien, darunter Echtzeitaudit, dynamisches Maskieren, Datenerkennung und weitere Kernschutzmaßnahmen. Jede Strategie spielt eine spezifische Rolle dabei, die Angriffsfläche zu verringern und gleichzeitig Innovation zu ermöglichen.

Warum GenAI einzigartige Sicherheitsrisiken mit sich bringt

Im Gegensatz zu regelbasierten Systemen lernt GenAI aus großen Datensätzen und verwendet probabilistisches Schließen. Es kann Zusammenhänge ableiten, private Daten rekonstruieren und Ausgaben erzeugen, die interne Richtlinien verletzen. Diese Probleme entstehen oft durch schwache Eingabekontrollen, das Training mit ungefilterten Datensätzen und eingeschränkte Transparenz über das Verhalten des Modells. Ohne ordnungsgemäße Protokollierung oder Durchsetzung wird dies zu einem wesentlichen Bedrohungsvektor in regulierten Umgebungen.

Weitere Einblicke erhalten Sie unter Stanford’s AI Index, der Herausforderungen bei der Modellanpassung und Daten-Transparenz hervorhebt.

Echtzeitaudit für Prompt- und Daten-Transparenz

Echtzeit-Überwachung der Datenbankaktivitäten hilft Organisationen, GenAI-Anfragen nachzuverfolgen, um die Compliance sicherzustellen. Es werden alle Prompts aufgezeichnet, die die Datenebene berühren, wobei SQL-Abfragen, Benutzerrollen, IP-Adressen und Sitzungsdaten erfasst werden.

Dies ist besonders wichtig bei der Arbeit mit Tools wie LangChain oder der Funktionsaufrufmethode von OpenAI, bei denen Datenbankabfragen dynamisch generiert werden. Zum Beispiel:

SELECT full_name, email FROM customers WHERE preferences LIKE '%personal%';Diese Abfrage, die von einem LLM ausgelöst wird, kann protokolliert und mit best practices für Audit-Logs überprüft werden, um den Zugriff auf sensible Daten zu erkennen. Dies gewährleistet Verantwortlichkeit und unterstützt Reaktionen bei Sicherheitsvorfällen.

Dynamisches Maskieren von Daten zur Steuerung der Ausgabe

Dynamisches Maskieren schützt sensible Daten auch dann, wenn auf sie zugegriffen wird. Es arbeitet in Echtzeit und wendet kontextbezogene Richtlinien an, die Kreditkartennummern, persönliche Identifikatoren und mehr verbergen.

Beispiel:

SELECT name, credit_card_number FROM payments;

-- maskiertes Ergebnis: SELECT name, '****-****-****-1234'Maskierung ist entscheidend bei der Integration von GenAI in relationale Datenbanken oder Vektorspeicher. Laut den NIST-Richtlinien zur KI-Sicherheit helfen dynamische Kontrollen sicherzustellen, dass LLMs keine privaten Daten preisgeben, selbst wenn der Zugriff gewährt wird. Siehe auch IBMs Richtlinien zum Datenschutz bei KI.

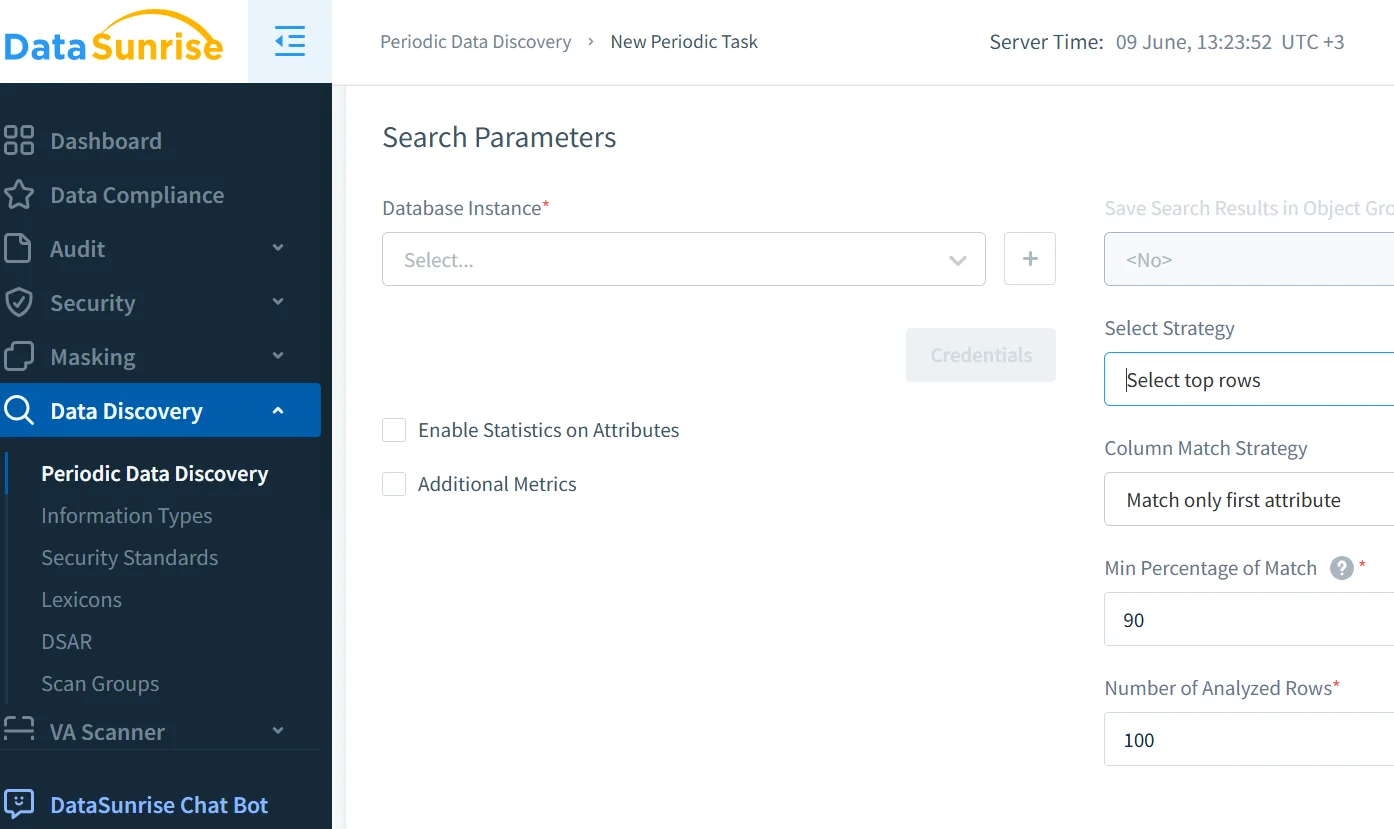

Datenerkennung und -klassifizierung vor dem Fine-Tuning

Bevor Daten in RAG-Pipelines oder beim GenAI-Training verwendet werden, ist die Datenerkennung entscheidend. Sie identifiziert und kennzeichnet regulierte Inhalte wie PII, PHI und Zugangsdaten, um eine versehentliche Offenlegung zu verhindern.

In Kombination mit der synthetischen Datengenerierung und den von Google Cloud beschriebenen Techniken ermöglicht dies sichereres Training, Fine-Tuning und Abrufvorgänge.

Eine ordnungsgemäße Klassifizierung hilft, Sicherheitsrichtlinien durchzusetzen, Maskierungsregeln zu aktivieren und die Einhaltung von DSGVO, HIPAA und PCI DSS nachzuweisen. Auch das Future of Privacy Forum bietet fundierte Empfehlungen zum verantwortungsvollen Umgang mit KI-Daten.

Compliance und Governance für KI-Pipelines

Compliance bei GenAI geht über die Protokollierung hinaus – sie muss kontinuierliche Risikobewertungen, Zugangskontrollen, Maskierung und automatisierte Durchsetzung integrieren.

Der DataSunrise Compliance Manager unterstützt automatisierte Berichterstattung, konsequente Richtlinienanwendung und Echtzeit-Alarme. Er integriert sich mit externen Tools zur erweiterten Risikobeobachtung und reduziert den Aufwand für die Audit-Vorbereitung. Weitere Rahmenwerke werden in den OECD AI-Prinzipien beschrieben.

Sicherheits-Schichten, maßgeschneidert für GenAI-Pipelines

Standardabwehrmaßnahmen wie Firewalls reichen nicht aus. GenAI-Systeme benötigen rollenbasierte Zugangskontrollen (RBAC), Schutz vor SQL-Injektionen und verhaltensbasierte Filter zur Verhinderung von Prompt-Injektionen.

Es empfiehlt sich, die Abwehrmaßnahmen an den OWASP Top 10 für LLMs auszurichten, die das Maskieren von Ausgaben, die Validierung von Eingaben und das Sandboxen von KI-Diensten empfehlen. Weitere Einblicke bietet die ENISA KI-Bedrohungslandschaft für einen umfassenden Risikobetrachtungsrahmen.

Für cloud-native Umgebungen helfen KI-fähige Proxies und Datenbank-Firewalls dabei, Einstiegspunkte zu schützen. Die Datenbank-Firewall von DataSunrise bietet diese Funktionalität mit Unterstützung für über 40 Datenplattformen.

Beispielanwendung: Kundenservice-Chatbot mit RAG

Ein Support-Chatbot nutzt Retrieval-Augmented Generation, um Daten aus internem Wissen und PostgreSQL-basierten Kundendaten abzurufen. Wird dies nicht kontrolliert, könnte er sensible persönliche Informationen preisgeben.

Durch die Aktivierung von Maskierungen auf SQL-Ebene, die Protokollierung jeder Chatbot-Anfrage, das Scannen der Trainingsdaten auf PII und die Klassifizierung von Prompts nach Risiko bleibt der Chatbot sowohl reaktionsfähig als auch compliant.

Dies entspricht dem Responsible AI Standard von Microsoft und unterstützt das Konzept des Privacy-by-Design.

Fazit: GenAI Risikominderungsstrategien in der Praxis

Moderne KI-Systeme benötigen mehr als Vertrauen. Sie benötigen Kontrolle. Durch die Kombination von Audit, Maskierung, Datenerkennung und richtliniengetriebener Governance verringern Organisationen das Risiko von durch KI verursachten Datenlecks und Compliance-Verstößen.

Effektive GenAI Risikominderungsstrategien integrieren sich über den gesamten Stack – von der Filterung der Prompts bis zur Durchsetzung von Datenbankrichtlinien – und bieten Rückverfolgbarkeit sowie Echtzeit-Abwehr.

Um noch tiefer in praktische Anwendungen einzutauchen, besuchen Sie:

- Verhaltensanalysen

- NIST AI-Risikomanagement-Rahmen

- LLM-Sicherheits- und Überwachungstools

- Google Secure AI Framework (SAIF)

- Datenschutzpraktiken

- Partnership on AI

- AI Incident Database

Mit den richtigen Maßnahmen kann GenAI Innovationen auf sichere und verantwortungsvolle Weise vorantreiben.