LLM-Sicherheit vs. LLM-Schutz

Große Sprachmodelle (LLMs) transformieren Softwareentwicklung, Bildung und Analytik. Doch der schnelle Einsatz hat eine wachsende Debatte entfacht: LLM-Sicherheit vs. LLM-Schutz – und welche davon ist wichtiger.

Die beiden Konzepte überschneiden sich oft, stellen jedoch sehr unterschiedliche Herausforderungen bei der verantwortungsvollen Bereitstellung von KI dar.

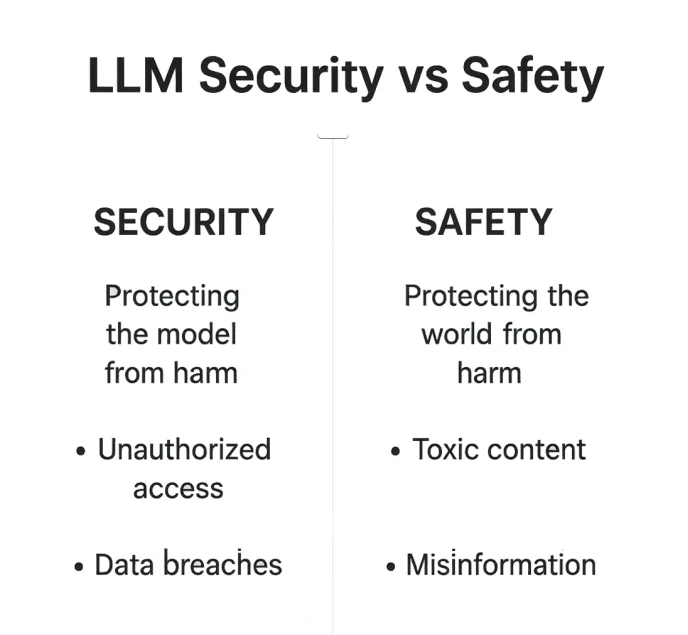

LLM-Sicherheit vs. LLM-Schutz: Den Unterschied verstehen

Wenn über die Absicherung von großen Sprachmodellen diskutiert wird, werden Sicherheit und Schutz häufig synonym verwendet – sie operieren jedoch auf sehr unterschiedlichen Ebenen des KI-Ökosystems.

LLM-Sicherheit bedeutet, die Umgebung des Modells zu stärken: Datenbanken, Zugangspunkte und APIs vor Ausnutzung zu schützen. Gleichzeitig konzentriert sich LLM-Schutz darauf, was das Modell sagt – also sicherzustellen, dass seine Antworten ethisch, faktisch korrekt und innerhalb akzeptabler Grenzen bleiben.

Sicherheit ist ein Kampf gegen äußere Manipulation. Schutz ist eine Absicherung gegen interne Fehlanpassungen. In der Praxis überschneiden sich beide Bereiche. Ein kompromittiertes Modell kann unsichere Ausgaben erzeugen, und ein unsicheres Modell kann durch Social Engineering oder Datenlecks zu einem Sicherheitsrisiko werden. Das Verständnis der Nuancen zwischen diesen beiden Dimensionen ist entscheidend für den Aufbau von KI-Systemen, die sowohl vertrauenswürdig als auch widerstandsfähig sind.

| Aspekt | LLM-Sicherheit | LLM-Schutz |

|---|---|---|

| Fokus | Schutz der Infrastruktur, Daten und Modelle vor unbefugtem Zugriff | Verhinderung schädlicher, voreingenommener oder unethischer Ausgaben |

| Bedrohungen | Injection-Angriffe, unbefugter Zugriff, Datenpannen | Toxische Inhalte, Fehlinformationen, ethische Verstöße |

| Ziel | Modell und Daten sicher halten | Ausgaben sicher und ausgerichtet halten |

| Beispiel | Prävention von SQL-Injektionen | RLHF-Inhaltsfilterung |

Beide Aspekte bilden das Rückgrat einer verantwortungsvollen KI-Bereitstellung – technische Schutzmaßnahmen sichern das Vertrauen, während ethische Ausrichtung die Verantwortlichkeit gewährleistet.

1. Was Sicherheit bei LLMs bedeutet

Die Sicherheit von LLMs konzentriert sich darauf, Infrastruktur, Modelle und Datenpipelines vor unbefugtem Zugriff oder Manipulation zu schützen.

Sie ist der technische Schild, der vertrauliche Daten, geistiges Eigentum und Systemintegrität bewahrt – die stille Barriere zwischen sicherem Betrieb und Datenkatastrophen.

Typische Sicherheitsrisiken

Angreifer sondieren LLM-Systeme ständig nach Schwachstellen: Sie injizieren versteckte Anweisungen, nutzen ungefilterte Prompts aus oder ernten Tokens aus ungesicherten Logs.

Sogar das fortschrittlichste Modell kann kompromittiert werden, wenn es auf einer nicht geschützten Abruf-Pipeline beruht oder vertrauliche Einbettungen preisgibt.

Typische Schwachstellen sind:

- Unbefugter Datenzugriff über Prompt-Injektion oder falsch konfigurierte APIs

- Enthüllung sensibler Felder oder Tokens in Logs

- Fehlende Verschlüsselung in Abruf- oder Feinabstimmungs-Pipelines

Diese Bedrohungen machen intelligente Modelle zu Vektoren potenzieller Haftung – sofern nicht robuste Verteidigungsschichten implementiert sind.

Sicherheitskontrollen

LLM-Sicherheit ist keine einzelne Barriere – sie ist ein System mehrschichtiger Abwehrmaßnahmen:

- Datenbank-Firewall für den Perimeterschutz

- Datenschutz und Verschlüsselung für gespeicherte und übertragene Daten

- Datenbank-Aktivitätsüberwachung zur Erkennung abnormalen Verhaltens, bevor es sich ausbreitet

2. Was Schutz bei LLMs bedeutet

Schutz bezieht sich darauf, wie ein LLM verhält – seine ethischen Grenzen, faktische Zuverlässigkeit und Fähigkeit, Schaden zu vermeiden.

Wenn Sicherheit der Tresor um das Modell ist, dann ist Schutz das Gewissen darin.

Schutz zielt weniger darauf ab, Hacker zu stoppen, sondern auf die Verhinderung sozialer, reputationsbezogener oder moralischer Schäden, die aus ungeprüften Ausgaben resultieren können.

Ein unsicheres Modell kann Fehlinformationen verbreiten, so wie ein kompromittiertes Modell Zugangsdaten leaken kann.

Schutzziele und Risiken

Schlecht abgestimmte Modelle könnten produzieren:

- Giftige, voreingenommene oder anstößige Inhalte

- Halluzinierte oder irreführende Informationen

- Prompt-Jailbreaks, die Moderationsfilter außer Kraft setzen

Jeder dieser Ausfälle untergräbt das Vertrauen der Nutzer – und in regulierten Branchen können daraus schwerwiegende Compliance-Folgen entstehen.

Schutzmaßnahmen

Entwickler begegnen diesen Risiken, indem sie Trainingsstrategien und Datenkontrollen kombinieren:

- Reinforcement Learning from Human Feedback (RLHF)

- Datenaufdeckung und PII-Erkennung zur Identifizierung sensibler Informationen

- Statische Datenmaskierung vor dem Training, um eine Offenlegung zu verhindern

# Einfaches Beispiel für ein Schutz-Geländer bei Ausgaben

def safe_response(output: str) -> str:

banned = ["password", "SSN", "card number"]

return "[REDACTED]" if any(b in output.lower() for b in banned) else output

3. Wo sich LLM-Sicherheit und LLM-Schutz überschneiden

Die Grenze verschwimmt an der Modellschnittstelle – dort, wo Prompts, Abruf und Generierung aufeinandertreffen.

Dies ist die Grauzone, in der ein sicheres System dennoch unsichere Ausgaben erzeugen kann und ein „geschütztes“ Modell ungewollt interne Daten preisgeben könnte.

Ein System kann sicher, aber unsicher sein (indem es privat gespeicherte Daten leakt) oder geschützt, aber unsicher (zensiert, jedoch leicht gehackt). Die robustesten Frameworks adressieren beide Bereiche simultan.

Gemeinsame Kontrollen

In dieser Schnittmenge schützen bestimmte Mechanismen sowohl die Infrastruktur als auch die Qualität der Ausgaben:

- Rollenbasierte Zugriffskontrolle (RBAC)

- SQL-Injektionserkennung

- Geleitete Prompt-Verarbeitung und Inhaltsmoderationsfilter

| Überschneidungsbereich | Beispielkontrolle | Zweck |

|---|---|---|

| Eingabevalidierung | Bereinigung von Prompts | Verhinderung von Injektionen oder sensiblen Lecks |

| Zugriffskontrolle | RBAC / Reverse Proxy | Einschränkung von Modellwerkzeugen und Plugins |

| Ausgabekontrolle | Filter nach der Generierung | Entfernung unethischer oder privater Daten |

Die Schnittmenge von Schutz und Sicherheit ist nicht theoretisch – sie ist operativ. Die widerstandsfähigsten LLM-Umgebungen verbinden Zugriffsmanagement, Prompt-Analyse und ethische Moderation zu einem kontinuierlichen Prozess.

4. LLM-Sicherheit in der Praxis

In der Produktion bedeutet LLM-Sicherheit mehrschichtiger Schutz – nicht nur die Verschlüsselung von Daten, sondern auch die Kontrolle darüber, wie diese fließen.

Jeder API-Aufruf, jede Vektor-Suche oder jede Einbettungsabfrage sollte als potenzieller Angriffspunkt betrachtet werden.

Kernpraktiken

- Kontinuierlicher Datenschutz während des gesamten Modelllebenszyklus

- Audit-Logs für transparente Rückverfolgbarkeit

- Automatisierte Compliance-Validierung integriert mit Aktivitätsüberwachung

Die Proxy-Architektur von DataSunrise filtert und anonymisiert Payloads bevor sie die Modellendpunkte erreichen, sodass auch komplexe Retrieval- oder Feinabstimmungs-Workflows konform und geschützt bleiben.

5. LLM-Schutz in der Praxis

Im Gegensatz zur Sicherheit wird der Schutz oft im Nachhinein bewertet. Doch proaktive Schutzmechanismen können die meisten ethischen oder reputationsbezogenen Vorfälle bereits im Vorfeld verhindern.

Techniken

- Reinforcement Learning (RLHF) zur ethischen Anpassung

- Kontextmodulationsfilter zur Ausgabenkontrolle

- Compliance-Ausrichtung über verschiedene Rechtsräume hinweg

- Statische Datenmaskierung, um schädliche Trainingsexposition zu verhindern

Beispiel: Logik zur Ausgabefilterung

def moderation_layer(text):

if "hate speech" in text.lower():

return "Content blocked for safety"

return text

Durch mehrschichtige Moderation können Organisationen das Verhalten der KI in Einklang mit sozialen, kulturellen und rechtlichen Normen bringen – nicht als nachträglichen Einfall, sondern als integralen Bestandteil des Trainings- und Bereitstellungsprozesses.

6. Auf dem Weg zu einem einheitlichen Rahmenwerk

Sicherheit und Schutz sollten sich verstärken und nicht konkurrieren.

Eine ausgereifte KI-Governance-Strategie verwebt beide Aspekte zu einem operativen Ganzen – sodass das Modell technisch robust und sozial verantwortlich zugleich ist.

Einheitlicher Ansatz

- Verhaltensanalytik zur Erkennung von Anomalien und Vorurteilen

- Audit-Trails für Transparenz und Rückverfolgbarkeit

- Datenklassifizierung für ein kontextbezogenes Risikomanagement

| Ebene | Sicherheitsziel | Schutzziel |

|---|---|---|

| Daten | Verschlüsselung & Maskierung | Ethisch einwandfreie Trainingsdaten |

| Modell | Isolation & Zugriffskontrolle | Ausrichtung & Leitplanken |

| Ausgabe | Protokollierung & Validierung | Toxizitätsfilter & Transparenz |

Durch die Vereinigung von Sicherheitskontrollen und ethischen Richtlinien schaffen Unternehmen KI-Systeme, die nicht nur externen Druck aushalten, sondern auch intern menschliche Werte wahren.

Fazit

Sicherheit hält das Modell geschützt vor der Welt.

Schutz bewahrt die Welt vor dem Modell.

Beide Dimensionen definieren die Glaubwürdigkeit jedes KI-Systems.

Erst wenn sie koexistieren – harmonisiert durch Richtlinien, Überwachung und automatisierte Compliance – können Unternehmen das volle Potenzial von LLMs ausschöpfen, ohne Privatsphäre, Integrität oder Vertrauen zu gefährden.

Schützen Sie Ihre Daten mit DataSunrise

Sichern Sie Ihre Daten auf jeder Ebene mit DataSunrise. Erkennen Sie Bedrohungen in Echtzeit mit Activity Monitoring, Data Masking und Database Firewall. Erzwingen Sie die Einhaltung von Datenstandards, entdecken Sie sensible Daten und schützen Sie Workloads über 50+ unterstützte Cloud-, On-Premise- und KI-System-Datenquellen-Integrationen.

Beginnen Sie noch heute, Ihre kritischen Daten zu schützen

Demo anfordern

Jetzt herunterladen

Schützen Sie Ihre Daten mit DataSunrise

Sichern Sie Ihre Daten auf jeder Ebene mit DataSunrise. Erkennen Sie Bedrohungen in Echtzeit mit Activity Monitoring, Data Masking und Database Firewall. Erzwingen Sie die Einhaltung von Datenstandards, entdecken Sie sensible Daten und schützen Sie Workloads über 50+ unterstützte Cloud-, On-Premise- und KI-System-Datenquellen-Integrationen.

Beginnen Sie noch heute, Ihre kritischen Daten zu schützen

Demo anfordern Jetzt herunterladen