LLM-Sicherheitsumfragen und Einblicke

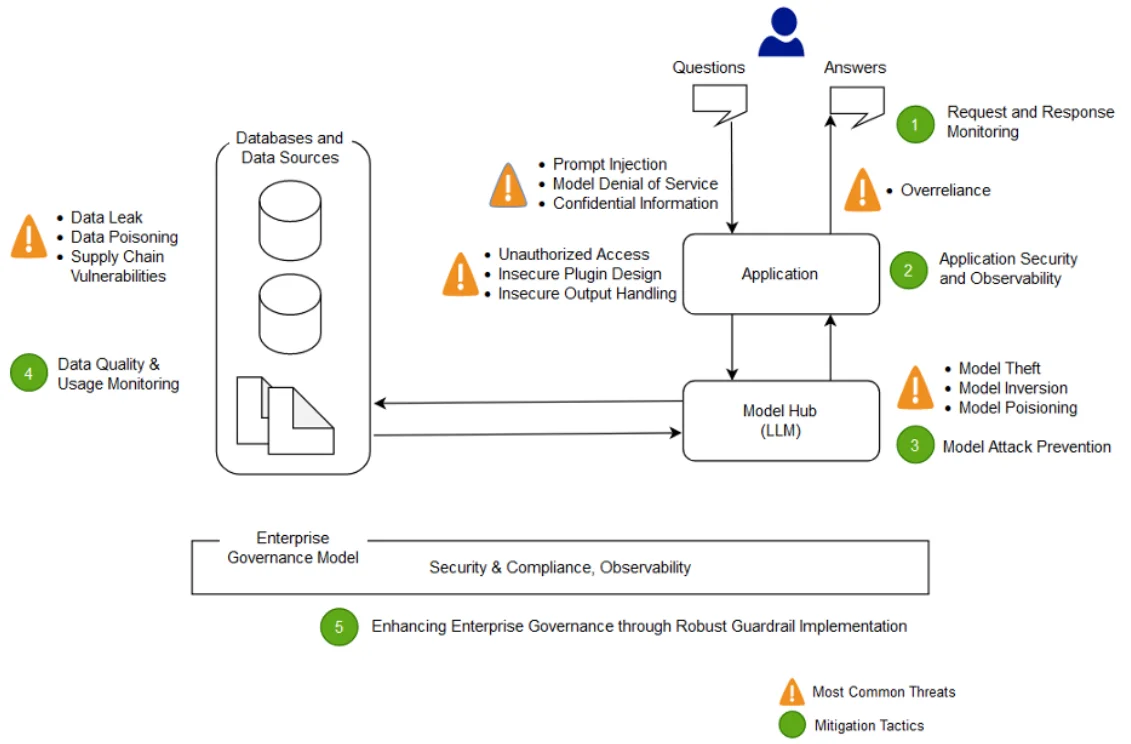

Da Organisationen große Sprachmodelle (LLMs) in ihre täglichen Abläufe integrieren, ist der Fokus auf LLM-Sicherheit rapide gewachsen. Diese Modelle verarbeiten sensible Daten und müssen strenge Standards hinsichtlich Auditierung, Maskierung und Compliance einhalten. Dieser Artikel untersucht LLM-Sicherheitsumfragen und Einblicke anhand praktischer Techniken, um GenAI-Einsätze zu stärken und die Einhaltung von Vorschriften wie GDPR und HIPAA sicherzustellen.

LLMs in sicherheitsorientierten Anwendungsfällen

LLMs unterstützen mittlerweile Aufgaben wie Phishing-Erkennung, Log-Zusammenfassungen und Regelgenerierung. Der Zugriff auf Code, Protokolle oder Benutzerdaten birgt allerdings das Risiko unbeabsichtigter Lecks. Deshalb ist der Einsatz von Werkzeugen für Echtzeit-Compliance-Überwachung und dynamische Maskierung entscheidend, wenn LLMs in Produktionsumgebungen eingesetzt werden.

Detailliertere Bedrohungsmodelle finden Sie in diesem MITRE ATLAS Blogpost, der LLM-spezifische angreifende Taktiken darlegt.

Echtzeit-Audit für Inferenz und Training

Der Datenzugriff von LLMs muss ebenso überwacht werden wie Datenbankabfragen. Echtzeitaudits zeichnen Eingabedetails, abgerufene Kontexte und Vektorsuchen auf. Wenn Ihr LLM beispielsweise PostgreSQL mit pgvector verwendet, können Sie diese Abfragen mit dem Modul zur Datenbankaktivitätsüberwachung protokollieren.

SELECT content FROM documents

WHERE embedding <#> '[0.134, -0.256, 0.789, ...]' < 0.75

LIMIT 5;

Diese Abfrage kann sofort auf die Klassifizierung der Datenquelle oder auf Verstöße gegen Compliance überprüft werden. Sie können auch Audit-Methoden im Engineering-Blog von Pinecone erkunden, der vektorbezogene Herausforderungen hervorhebt.

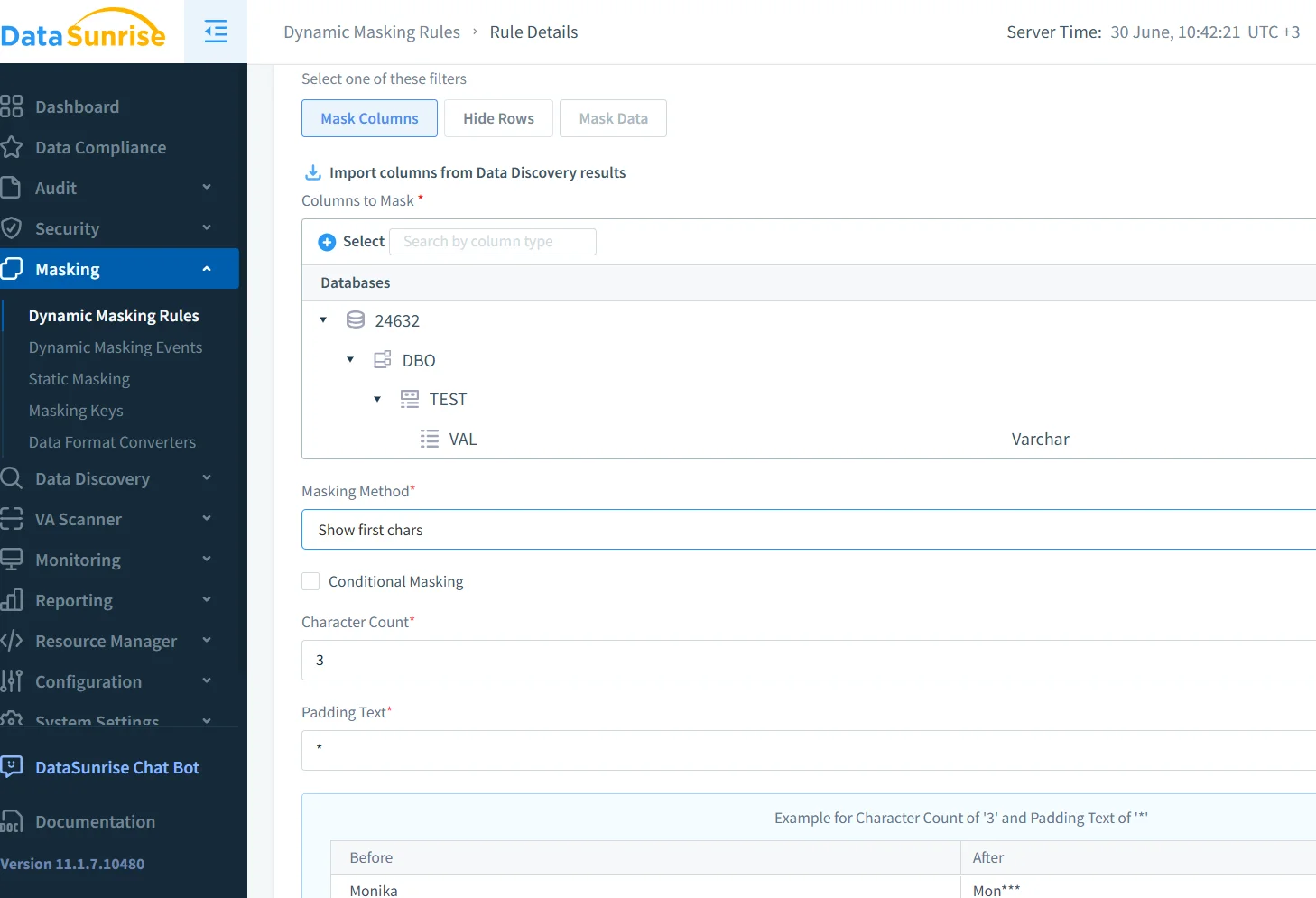

Dynamische Maskierung für Eingabesicherheit

Die dynamische Maskierung verbirgt sensible Elemente wie E-Mails oder IDs, bevor sie das Modell erreichen. Sie wird kontextabhängig angewendet und kann je nach Rolle oder Muster variieren. In DataSunrise funktioniert die Datenmaskierung promptübergreifend mittels regelbasierter Vorlagen.

{"user_id": "u-4982", "email": "[email protected]", "error": "access denied"}Wird zu:

{"user_id": "u-4982", "email": "*****@company.com", "error": "access denied"}Der Artikel von OpenAI über das Lernen, abzulehnen untersucht verwandte Maskierungsstrategien.

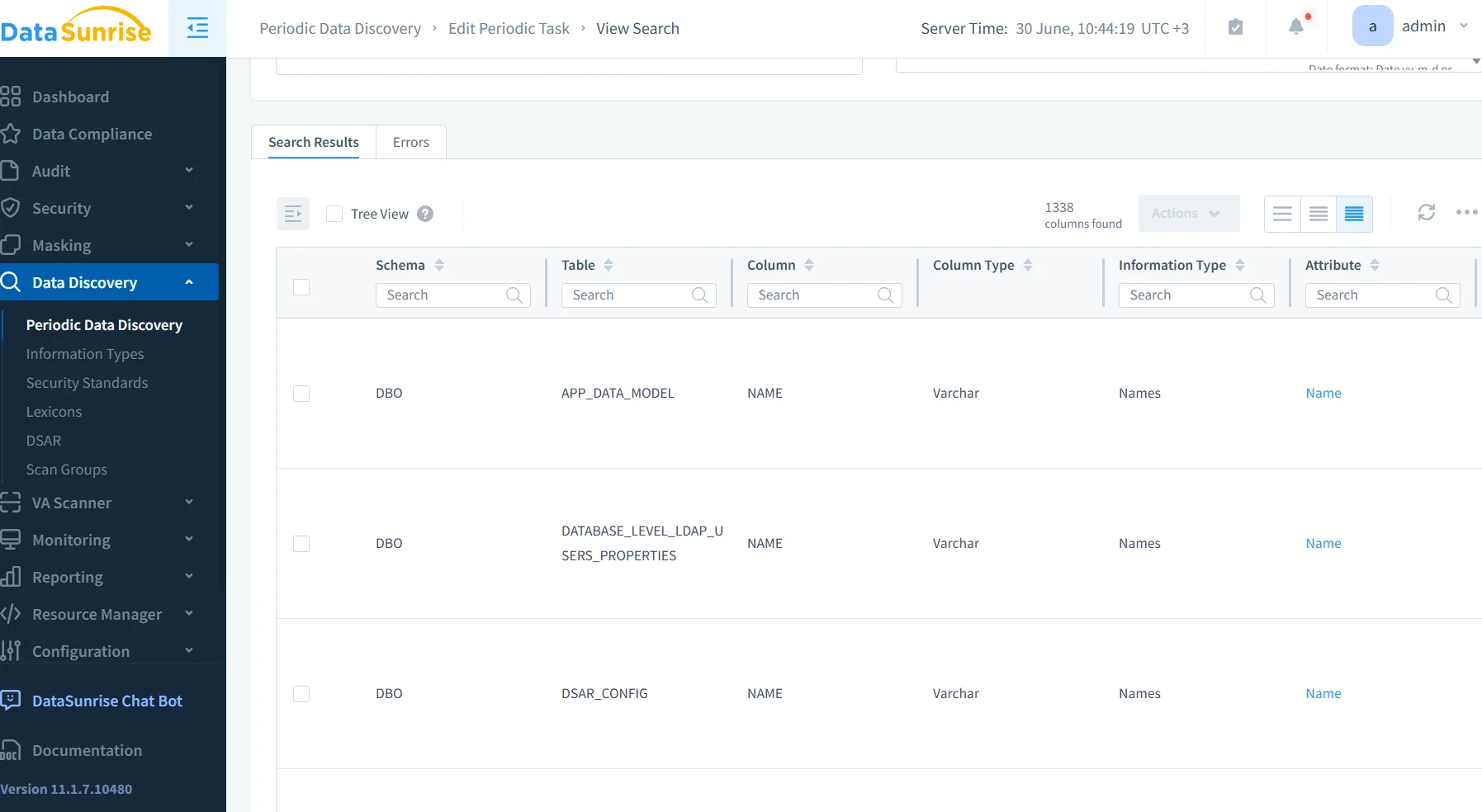

Datenerkennung in Einbettungspipelines

In vielen Systemen beginnt die Vektorisierung, bevor der Inhalt analysiert wird. Dieser Ansatz ist riskant. Stattdessen sollten Sie Werkzeuge zur Datenerkennung verwenden, um Datensätze vor der Indizierung zu überprüfen.

Datensätze mit PII oder PHI können markiert und umgeleitet werden. DataSunrise integriert sich in Workflows wie Airflow oder dbt, um diese Scans automatisch durchzuführen.

Der Leitfaden von Cohere zur LLM-Privatsphäre zeigt, wie man ähnliche Best Practices anwendet.

Sicherheitseinblicke aus LLM-Einsätzen

Umfragen von Sicherheitsteams heben wiederkehrende Probleme hervor. Prompt-Injektionen bleiben eine Sorge. Fehlende Maskierungsregeln erlauben es, dass sensible Inhalte abgespeichert werden. Lücken in den Vektor-Audit-Protokollen verzögern Untersuchungen, und Modelländerungen bleiben unentdeckt.

Um dem entgegenzuwirken, integrieren viele Teams Audit-Tags, beschränken Eingaben und nutzen Gateways für Inferenzverkehr. Sie können weiterführende Gegenmaßnahmen in LLMGuard erkunden, der sowohl Proxy-Kontrollen als auch Token-Filtermethoden untersucht.

Compliance-fähige LLM-Betriebe

Um den Vorgaben von GDPR, HIPAA oder PCI-DSS zu entsprechen, muss Ihr System den Datenzugriff protokollieren, Quellen klassifizieren und bei Bedarf Maskierung anwenden. Die Isolation zwischen LLMs und Live-Daten ist ebenfalls entscheidend.

Der DataSunrise Compliance Manager unterstützt all diese Kontrollen und integriert sich problemlos in externe SIEM-Plattformen. Außerdem können Sie sich an NISTs AI-Risikorahmenwerk orientieren, um umfassendere Richtlinien zu erhalten.

Blick in die Zukunft: LLM-bewusste Datenfirewalls

Die nächste Generation von Firewalls wird nicht nur SQL untersuchen – sie werden auch Eingaben, Einbettungen und Abschlussinformationen analysieren. Diese Werkzeuge werden Missbrauch erkennen, übermäßige Datenfreigabe verhindern und gefährliche Datenflüsse blockieren. Ähnlich einer Datenbank-Firewall, jedoch mit LLM-Bewusstsein.

Projekte wie Guardrails AI und LLM-Defender entwickeln diese Vision. In Kombination mit regelbasierten Sicherheitsrichtlinien von DataSunrise resultiert daraus ein starker und adaptiver Schutz.

Dieses Konzept spiegelt sich in Anthropics Constitutional AI wider, das LLMs vorschlägt, die durch ihr Design interne Richtlinienkontrollen durchsetzen.

Abschließende Gedanken

Heutige LLMs benötigen mehr als nur Leistung – sie benötigen Schutz. Echtzeitaudits, dynamische Maskierung und Entdeckungs-Workflows bilden den Kern moderner LLM-Sicherheitsumfragen und Einblicke. Mit Plattformen wie DataSunrise werden diese Sicherheitsvorkehrungen integraler Bestandteil Ihrer LLM-Architektur – und nicht nur ein nachträglicher Gedanke.

Schützen Sie Ihre Daten mit DataSunrise

Sichern Sie Ihre Daten auf jeder Ebene mit DataSunrise. Erkennen Sie Bedrohungen in Echtzeit mit Activity Monitoring, Data Masking und Database Firewall. Erzwingen Sie die Einhaltung von Datenstandards, entdecken Sie sensible Daten und schützen Sie Workloads über 50+ unterstützte Cloud-, On-Premise- und KI-System-Datenquellen-Integrationen.

Beginnen Sie noch heute, Ihre kritischen Daten zu schützen

Demo anfordern Jetzt herunterladen