OWASP LLM Risiken und Abhilfemaßnahmen

Der Anstieg des Interesses an großen Sprachmodellen (LLMs) hat die Art und Weise revolutioniert, wie Organisationen mit Daten interagieren, Entscheidungen automatisieren und Erkenntnisse gewinnen. Doch mit dieser transformativen Fähigkeit geht eine neue Reihe von Sicherheits- und Compliance-Risiken einher. Die OWASP Top 10 für LLM-Anwendungen hebt diese Schwachstellen hervor und bietet Abhilfemaßnahmen, die für jede Organisation, die generative KI einsetzt, von entscheidender Bedeutung sind.

Dieser Artikel untersucht diese Risiken mit einem praktischen Fokus auf Echtzeit-Auditing, dynamische Maskierung, Datenerkennung und darauf, wie die Daten-Compliance in GenAI-gestützten Umgebungen aufrechterhalten werden kann.

Die Landschaft verstehen: LLM-Risikokategorien

OWASP kategorisiert LLM-spezifische Risiken in Bereiche wie Prompt Injection, Datenlecks, Modellmissbrauch, unsichere Plugins und die Vergiftung von Trainingsdaten. Diese Bedrohungen nutzen die Stärken der GenAI – ihre Anpassungsfähigkeit und das kontextbezogene Lernen – aus und können das Modell dazu verleiten, interne Schutzmechanismen zu umgehen und sensible Ausgaben preiszugeben.

Echtzeit-Audit: Alles beobachten, sofort reagieren

Die Minderung von Risiken in dynamischen LLM-Umgebungen beginnt mit Transparenz. Echtzeit-Audit-Funktionen ermöglichen es Organisationen, Abfragen, Antworten und Datenzugriffsmuster in Echtzeit zu überwachen. Tools wie DataSunrise Audit Logs können sofort unautorisierte Datenzugriffsversuche oder verdächtige Eingabemuster erkennen.

Beispielsweise könnte eine Sicherheitsregel wiederholte Versuche, sensible Schemafelder zu ermitteln, erkennen und Warnmeldungen via Slack oder MS Teams auslösen:

{

"event_type": "query_attempt",

"query": "SELECT * FROM information_schema.columns WHERE ...",

"action": "alert_and_block"

}

Mit Unterstützung für Echtzeitbenachrichtigungen und lernbasierte Audit-Regeln können Teams die Audit-Logik an die sich entwickelnden LLM-Bedrohungen anpassen.

Dynamische Maskierung: Nicht nur blockieren – verdecken

Die dynamische Datenmaskierung schützt personenbezogene Daten und sensible Felder während der LLM-Interaktionen, ohne die Funktionalität der Anwendung zu beeinträchtigen. Anstatt den Zugriff vollständig zu entfernen, ersetzt sie echte Werte durch maskierte Platzhalter.

Beispielsweise könnte die Antwort auf eine Vektorabfrage:

SELECT name, credit_card_number FROM customers LIMIT 1;

folgendermaßen zurückgegeben werden:

John Doe | XXXX-XXXX-XXXX-1234

Diese Funktionalität ist entscheidend für Anwendungsfälle, die die Erweiterung von Prompts oder RAG (Retrieval-Augmented Generation) beinhalten, bei denen das LLM Unternehmensdaten abrufen und synthetisieren muss, ohne Datenschutzrichtlinien zu verletzen. Dynamische Maskierung in DataSunrise ermöglicht fein abgestimmte Richtlinien pro Rolle oder Modellverhalten.

Datenerkennung: Wissen, was Sie haben, bevor es LLMs tun

Bevor LLM-Sicherheitsmaßnahmen implementiert werden, ist es unerlässlich zu verstehen, wo sich sensible Daten befinden. Hier kommen automatisierte Datenerkennungstools ins Spiel.

Die Kartierung von Datenbeständen aus unstrukturierten Quellen, relationalen Datenbanken und Vektor-Indizes kann dabei helfen, Kontrollen zu priorisieren und die Exposition zu reduzieren. Die Integration in LLM-Pipelines stellt sicher, dass nur konforme und klassifizierte Daten für die Erweiterung oder Inferenz in Frage kommen.

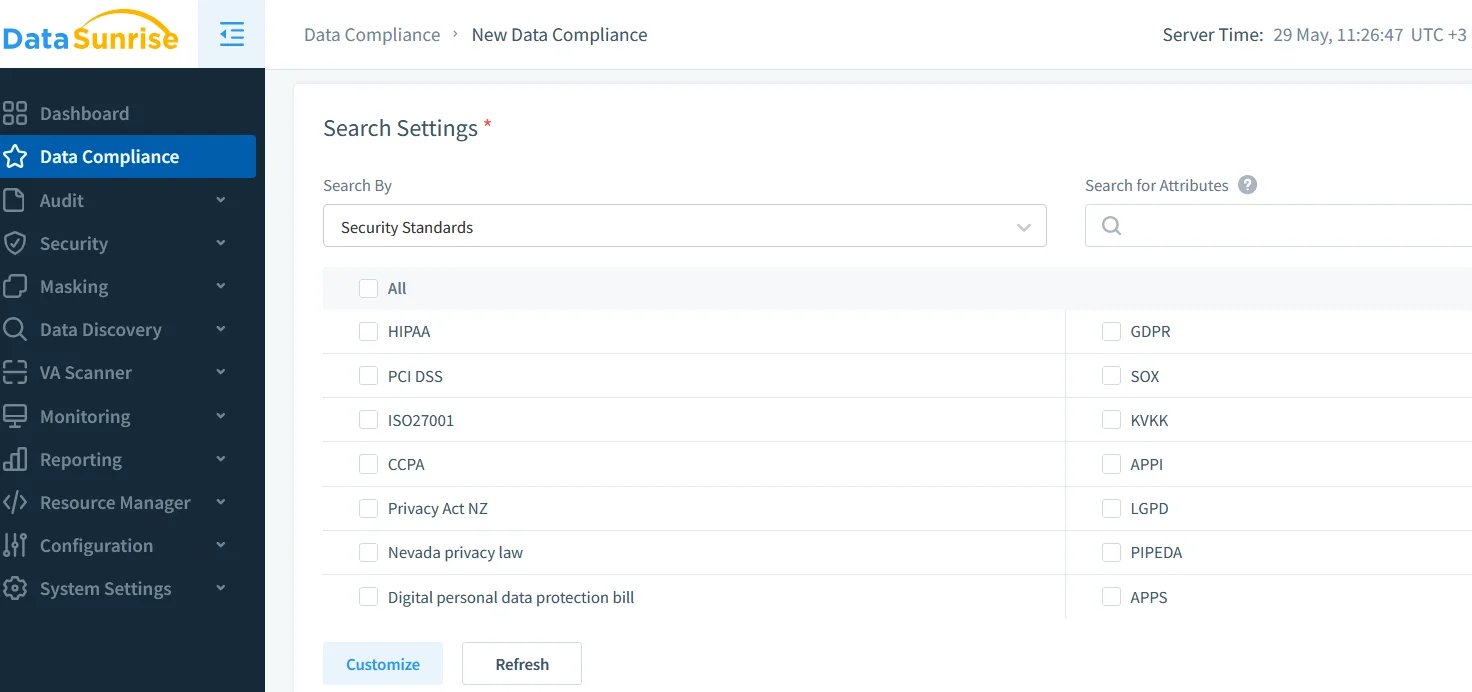

Daten-Compliance: Angleichung der LLM-Nutzung an globale Standards

GDPR, HIPAA, PCI DSS und andere Vorschriften gelten, unabhängig davon, ob Daten von Menschen oder Maschinen verarbeitet werden. Daher erfordert die Integration von LLMs in Daten-Workflows Rückverfolgbarkeit, Zugangskontrollen und klare Prüfpfade.

Lösungen wie der DataSunrise Compliance Manager bieten ein zentrales Dashboard zur Verwaltung von Compliance-Artefakten, Maskierungsrichtlinien und Audit-Ergebnissen. Dies hilft Organisationen, Prüfungen zu bestehen und eine verantwortungsvolle Nutzung von LLMs nachzuweisen.

Zusätzlich ist die Unterstützung für GDPR und HIPAA in die Audit- und Maskierungsschichten integriert, sodass sichergestellt ist, dass LLM-Ausgaben niemals geschützte Gesundheits- oder persönliche Informationen preisgeben.

Sichere Prompt-Schnittstellen und rollenbasierte Kontrollen

Die Anwendung von rollenbasierter Zugriffskontrolle (RBAC) stellt sicher, dass Eingabeaufforderungen von verschiedenen Benutzertypen (Admin, Analyst, externe API) durch unterschiedliche Richtlinien geregelt werden. In Kombination mit datenbezogenen Sicherheitstechniken hilft dies, den Einsatz von LLMs an unternehmensweiten Standards auszurichten.

Sichere Plugin-Systeme, sandboxed Ausführungsumgebungen und Sicherheitsregeln gegen SQL-Injektionen spielen ebenfalls eine wichtige Rolle beim Schutz vor gängigen LLM-Exploits.

Fazit: Eine ausgewogene, auditiert und maskierte Zukunft für GenAI

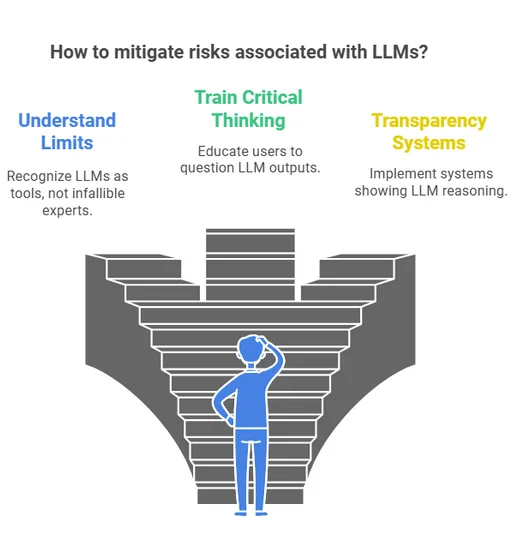

Die Integration von GenAI in Unternehmensumgebungen ist unvermeidlich, muss jedoch verantwortungsvoll erfolgen. Durch die Annahme des LLM-Risikorahmens von OWASP, die Durchsetzung von Echtzeit-Audits, die Anwendung dynamischer Maskierung, die Ermöglichung umfassender Datenerkennung und die Einhaltung von Compliance-Normen können Organisationen das volle Potenzial der generativen KI sicher ausschöpfen.

Um mehr darüber zu erfahren, wie Sie sichere GenAI-Systeme mit Audit und Maskierung aufbauen, erkunden Sie unsere Ressourcen zu Database Activity Monitoring und Data Security.