OWASP LLM Sicherheitsrichtlinien

Große Sprachmodelle (LLMs) werden zunehmend in modernen Anwendungen und Arbeitsabläufen eingebettet und treiben alles voran, von Kundensupport-Bots bis hin zur Echtzeit-Dateninterpretation. Doch mit großer Macht kommen auch neue Angriffsflächen. Die OWASP LLM Top 10 hat weltweit Diskussionen darüber angestoßen, wie man GenAI-Risiken begegnet, und nun müssen Sicherheitsteams ihre Vorgehensweisen erweitern.

Dieser Artikel erläutert, wie Sie die OWASP LLM Sicherheitsrichtlinien nutzen können, um in LLM-integrierten Systemen Sicherheit zu gewährleisten und gleichzeitig Echtzeit-Audits, dynamische Maskierung, Datenerkennung und die Einhaltung gesetzlicher Anforderungen zu erzielen.

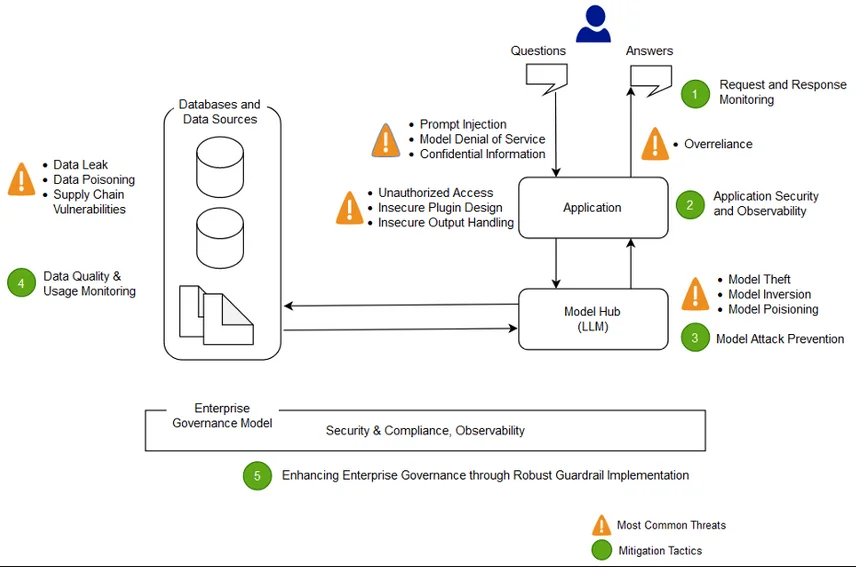

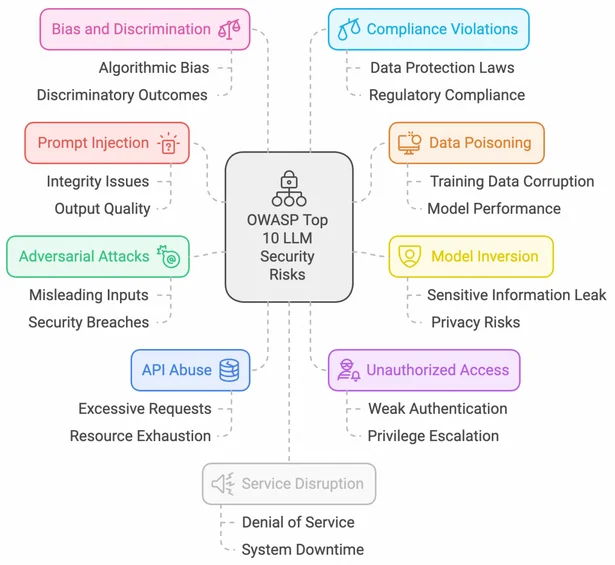

Das OWASP LLM Umfeld verstehen

Die Initiative von OWASP rund um LLMs bietet einen strukturierten Ansatz zur Identifizierung und Minderung von Schwachstellen, die speziell für GenAI-Systeme gelten. Zu den wichtigsten Bedrohungen zählen unter anderem Prompt Injection, Denial-of-Service-Angriffe auf Modelle, Lecks sensibler Daten und die unsichere Nutzung von Plugins.

Sicherheitsteams können sich an den OWASP Top 10 für LLM-Anwendungen orientieren, um ihre GenAI-Einführung an einem auf LLM-Arbeitsabläufe zugeschnittenen Threat-Modeling-Prozess auszurichten.

Echtzeit-Audit: Überwachung des KI-Verhaltens und des Datenzugriffs

Um Systeme, die durch LLMs angetrieben werden, zu schützen, ist es entscheidend, Audit-Mechanismen zu implementieren, die sowohl Benutzerinteraktionen als auch interne vom System ausgestellte Anweisungen erfassen.

Lösungen wie die Audit-Regeln von DataSunrise und das Datenbank-Aktivitätsmonitoring können eine kontinuierliche Nachverfolgung der Interaktionen von LLMs mit strukturierten Datenquellen ermöglichen.

Hier ist ein PostgreSQL-Snippet zur Erfassung von Zugriffsmustern durch LLM-Agenten:

SELECT datname, usename, query, backend_start, state_change

FROM pg_stat_activity

WHERE application_name LIKE '%llm_agent%';

Audit-Logs, angereichert mit Benutzerkontext, Modelleingaben/-ausgaben und Zeitstempeldaten, helfen Organisationen dabei, die forensische Einsatzbereitschaft aufzubauen und abnormales Verhalten zu erkennen.

Dynamische Datenmaskierung für Prompt-Sicherheit

Wenn LLMs auf Produktionsdaten zugreifen, können unmaskierte sensible Felder unbeabsichtigt in der Ausgabe erscheinen. Die Integration einer dynamischen Maskierung direkt in die Datenpipeline ist daher entscheidend.

Mithilfe der Datenmaskierungsfunktion von DataSunrise können Sie persönlich identifizierbare Informationen (PII) redigieren oder tokenisieren, bevor sie in Prompts übernommen werden.

Eine Maskierungsregel könnte reale E-Mail-Adressen durch Platzhalterwerte ersetzen, wie beispielsweise:

REPLACE(email, SUBSTRING(email, 1, POSITION('@' IN email)-1), 'user')

Dies stellt die Einhaltung der DSGVO und der HIPAA sicher, wenn KI-Lösungen mit realen Daten entwickelt werden.

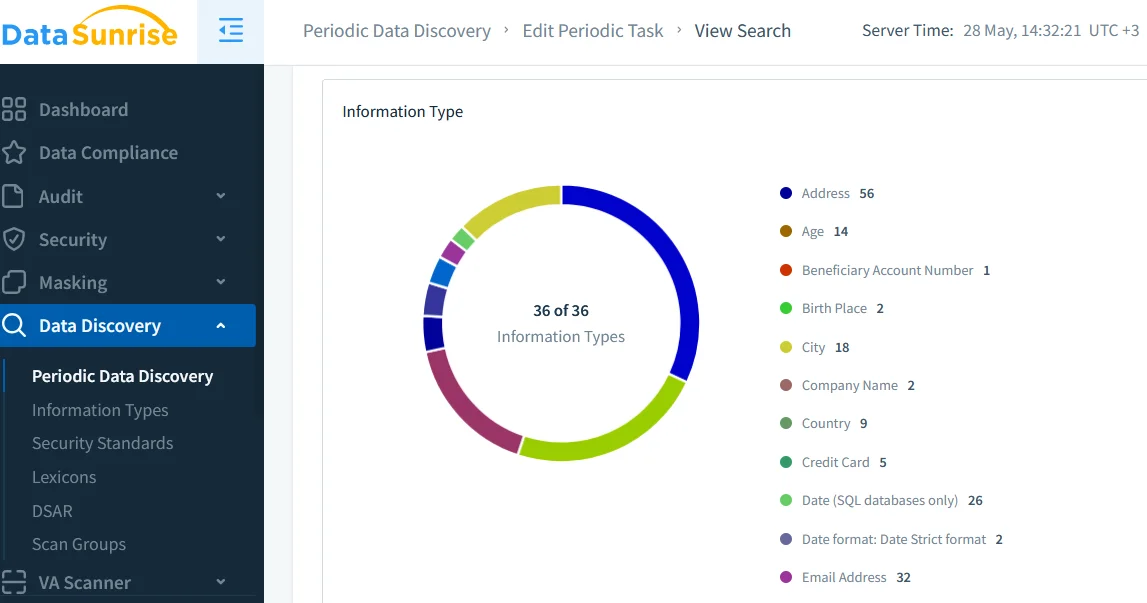

Datenerkennung: Vertrauen in Ihr Eingabekorpus aufbauen

LLMs können das Risiko verstärken, wenn sie mit unbekannten oder unklassifizierten Datensätzen trainiert oder feinabgestimmt werden. Tools zur Datenerkennung ermöglichen es Organisationen, sensible Daten automatisch zu scannen, zu kennzeichnen und zu katalogisieren, bevor sie in eine Einbettungs- oder Abrufschicht gelangen.

Ein robuster Erkennungsprozess hilft dabei, inoffizielle KI-Pipelines zu reduzieren und entspricht Sicherheitsrichtlinien wie rollenbasierten Zugriffssteuerungen (RBAC).

Externe Daten-Governance-Lösungen wie der Open Policy Agent können ebenfalls mit diesen Erkenntnissen integriert werden, um dynamische Zugriffsbedingungen für Prompt-Erstellungsagenten durchzusetzen.

Sicherheitsrichtlinien: KI-Arbeitsabläufe mit Kontrollen ausrichten

LLMs können nicht wie traditionelle Anwendungen überwacht werden – ihr Verhalten ist probabilistisch, kontextabhängig und oft nicht-deterministisch. Daher müssen Organisationen mehrschichtige Sicherheitsrichtlinien anwenden, die Folgendes beinhalten:

- Eingabevalidierung und Ausgabe-Filterung

- Ratenbegrenzung und API-Nutzungsüberwachung

- Plugin-Sandboxing oder Review-Workflows

Verweisen Sie auf den Sicherheitsleitfaden von DataSunrise, um ein verteidigungsintensives Modell zu entwickeln, das speziell auf GenAI-Operationen zugeschnitten ist.

Um durch LLM verursachte Sicherheitsabweichungen zu reduzieren, setzen einige Teams eine leichte Firewall oder einen Proxy ein, der den Prompt-Inhalt analysiert und nicht konforme Daten redigiert, bevor sie an das Modell gesendet werden. Sicherheitsregeln gegen SQL-Injektionen können angepasst werden, um Exploits durch Prompt Injection zu verhindern.

Von OWASP inspirierte Schutzmaßnahmen im Überblick

| Kategorie | Empfohlene Kontrollen | Zweck |

|---|---|---|

| Eingabeverarbeitung | Validierung, Längenprüfungen, Token-Filterung | Verhinderung von Prompt Injection und Missbrauch |

| Datenzugriff | Rollenbasierter Zugang, Echtzeit-Audit, Maskierung | Durchsetzung des Prinzips der minimalen Rechte und Einhaltung von Vorschriften |

| Ausgabe-Filterung | Regex-Filter, Toxizitätsprüfung, Redigierung | Begrenzung der Exposition schädlicher oder privater Daten |

| Plugin- und Toolnutzung | Whitelist-Plugins, Sandboxing, Ratenbegrenzung | Reduktion der Kompromittierung des Modells durch Integrationen |

| Compliance-Logging | Audit-Trails, Alarmierungsregeln, Datenklassifizierung | Unterstützung der Anforderungen von DSGVO, HIPAA, PCI DSS |

Compliance: Wenn KI auf Regulierung trifft

Die Einführung von LLMs befreit eine Organisation nicht von der Einhaltung von Standards. Im Gegenteil, Vorschriften wie SOX, PCI DSS und HIPAA gelten noch strenger, wenn automatisierte Agenten auf sensible Daten zugreifen oder auf sie einwirken.

Der Einsatz einer compliance-bewussten KI-Infrastruktur, die Audit-Logs, Maskierung und Report-Generation-Tools kombiniert, ermöglicht es Unternehmen, Nachweise für Audits zu dokumentieren und die Durchsetzung der Richtlinien zu demonstrieren.

Mehrere Open-Source-Initiativen entstehen zudem, um KI-Audit-Trails zu standardisieren, wie beispielsweise Microsofts PyRIT und die EU-Bemühungen im Rahmen des KI-Gesetzes.

Fazit: Sichere und konforme LLM-Systeme entwickeln

Die Befolgung der OWASP LLM Sicherheitsrichtlinien bedeutet nicht, Innovationen einzuschränken – es geht darum, Vertrauen, Verantwortlichkeit und die Ausrichtung an unternehmensgerechter Sicherheit zu gewährleisten. Durch die Kombination von Echtzeit-Audit, dynamischer Maskierung und Datenerkennung können Organisationen die Komplexität von GenAI beherrschen und dessen volles Potenzial ausschöpfen, ohne sich übermäßigen Risiken auszusetzen.

Um tiefer einzutauchen, erkunden Sie den Compliance-Manager von DataSunrise und seine LLM/ML-Sicherheitsanalysen zum Schutz hybrider und KI-gestützter Datenbanken.