pgvector: Schutz von Daten vor Offenlegung durch Vektor-Einbettungen

Das verborgene Risiko von Vektor-Einbettungen

Vektor-Einbettungen treiben GenAI-Anwendungen an, indem sie semantische Suche, Empfehlungssysteme und KI-gestützte Erkenntnisse ermöglichen. In PostgreSQL macht die pgvector-Erweiterung es möglich, hochdimensionale Einbettungen effizient zu speichern und abzufragen, wodurch KI-gestützte Anwendungen mit schneller Ähnlichkeitssuche verbessert werden. Aber obwohl sie nach der Einbettung nur Zahlen sind, können sie dennoch sensible Daten preisgeben.

Können Vektor-Einbettungen tatsächlich sensible Informationen preisgeben?

Vektor-Einbettungen funktionieren wie Koordinaten in einem hochdimensionalen Raum – sie enthalten nicht direkt sensible Daten, können aber dennoch ausgenutzt werden, um Muster zu rekonstruieren. Der Schutz sensibler Informationen bedeutet, zu kontrollieren, was in die Einbettungen einfließt und wie sie abgefragt werden.

Wenn Einbettungen aus Rohtext generiert werden, der persönlich identifizierbare Informationen (PII) wie Namen, Sozialversicherungsnummern oder Adressen enthält, könnte das Modell Muster kodieren, die diese Informationen indirekt preisgeben. Angreifer können Nächsten-Nachbarn-Suchen ausnutzen, um sensible Daten zu rekonstruieren, was zu Verstößen gegen Compliance und Sicherheitsbedrohungen führt.

Also, können Vektor-Einbettungen tatsächlich sensible Informationen preisgeben? Ja – sensible Daten können unter bestimmten Umständen durch Einbettungen offengelegt werden. Und obwohl Einbettungen keine Rohdaten speichern, bedeutet die Art und Weise, wie sie Beziehungen zwischen Datenpunkten kodieren, dass sensible Informationen bei cleverer Abfrage erschlossen werden könnten. Abhängig davon, wie die Einbettungen generiert werden und welche Informationen zu ihrer Erstellung verwendet werden, kann Folgendes passieren:

🔍 Wie sensible Daten in Einbettungen offengelegt werden können

1. Direkte Kodierung

- Falls Einbettungen aus Rohtext erstellt werden, der sensible Informationen (z. B. Sozialversicherungsnummern, Namen oder Adressen) enthält, könnte das Modell Muster kodieren, die diese indirekt offenbaren.

➡️Beispiel: Wenn SSN: 123-45-6789 Teil des Mitarbeiterprofils ist, das für die Generierung der Einbettung verwendet wird, könnte ein Modell Einbettungen generieren, die bei spezifischen Abfragen Vektoren zurückliefern, die sensiblen Datenmustern ähneln oder mit ihnen korrelieren.

2. Implizite Datenkorrelation

- Wenn Einbettungen mit strukturierten Daten (z. B. den Rollen, Gehältern und Abteilungen von Mitarbeitern) trainiert werden, könnten Muster in diesen Daten mit PII korrelieren.

➡️Beispiel: Wird die Sozialversicherungsnummer eines Mitarbeiters zusammen mit Gehalt und Abteilung im Vektoring-Training verwendet, könnte ein KI-System Gehaltsdetails offenbaren, wenn nach ähnlichen Einbettungen gesucht wird.

3. Auswendiglernen durch KI-Modelle

- Wenn ein KI-Modell, das auf sensiblen Daten trainiert wurde, Einbettungen generiert, könnte es sich bestimmte Details einprägen und bei geschickter Aufforderung wiedergeben.

➡️Beispiel: Wenn Einbettungen Mitarbeiter-Namen und -Rollen speichern, könnte ein Modell ähnliche Vektoren abrufen, die persönliche Informationen enthalten, wenn es nach „Mitarbeitern im Finanzbereich mit einem Gehalt von über 100.000 $“ gefragt wird.

4. Rekonstruktionsrisiken

- In einigen Fällen können Einbettungen mittels adversarieller Angriffe rückentwickelt werden, sodass Teile der ursprünglichen Daten rekonstruiert werden.

➡️Beispiel: Wenn ein Angreifer das System mit spezifischen Eingabemustern abfragt, könnte er aus den Einbettungen aussagekräftige Daten extrahieren.

🔓 Wie sensible Daten aus Einbettungen offengelegt werden können

Angreifer oder unbeabsichtigte Abfragen können PII durch folgende Methoden offenbaren:

- Nächsten-Nachbarn-Suchen – Finden von Einbettungen, die sensiblen Datenmustern am nächsten kommen.

- Vektor-Clustering – Gruppierung ähnlicher Einbettungen, um damit verbundene persönliche Details zu erschließen.

- Prompt Injection – Das System dazu verleiten, gespeicherte sensible Inhalte preiszugeben.

- Adversariale Angriffe – Ausnutzung von Schwächen im Modell, um den ursprünglichen Input zu rekonstruieren.

Zusammenfassung

Ja, sensible Daten können in Einbettungen durchrutschen, wenn diese ohne angemessene Schutzmaßnahmen generiert werden. Wenn ein KI-System Einbettungen verwendet, die aus rohen, sensiblen Daten erstellt wurden, können bei geschickter Abfrage ähnliche Informationen wiedergegeben werden.

Best Practice: Betten Sie niemals rohe sensible Felder ein und bereinigen Sie die Daten stets vor der Vektorisierung.

Techniken zur Vermeidung von PII-Lecks in Vektor-Einbettungen

1. Datenbereinigung vor der Einbettungserstellung

Bevor Daten in Vektor-Einbettungen umgewandelt werden, sollten sensible Informationen entfernt oder transformiert werden, sodass sie niemals in den Vektorraum gelangen.

PII-Felder entfernen – Betten Sie keine rohen Daten wie Sozialversicherungsnummern, Namen und Adressen ein.

Daten verallgemeinern – Statt exakter Gehaltsangaben, diese in Kategorien einteilen.

Tokenisierung – Ersetzen Sie sensible Daten durch nicht umkehrbare Identifikatoren.

Beispiel: Anstatt einzubetten:

“John Doe, SSN: 123-45-6789, verdient 120.000 $”

Speichern Sie: “Mitarbeiter X, verdient 100T€-150T€”

Dies stellt sicher, dass PII niemals in den Vektor-Speicher gelangt.

2. Maskierung sensibler Daten in Abfragen und Antworten

Selbst wenn rohe PII eingebettet wurde oder Einbettungen Muster im Zusammenhang mit PII kodieren, können Sie sensible Daten während der Abfrage maskieren oder verschleiern.

Dynamisches Datenmasking – Rotezieren oder transformieren Sie sensible Ausgaben, bevor sie den Benutzern zugänglich gemacht werden.

Echtzeit-Abfragefilterung – Blockieren Sie unautorisierte Ähnlichkeitssuchen in Einbettungen.

Zugriffskontrolle & rollenbasierte Einschränkungen – Beschränken Sie den Zugriff auf Vektorsuchen für vertrauenswürdige Benutzer.

Beispiel: Wenn ein Benutzer eine Abfrage an Einbettungen stellt und ein Datenstück mit PII abruft:

Originalausgabe: “John Does Gehalt beträgt 120.000 $”

Maskierte Ausgabe: “Gehalt von Mitarbeiter X: 1XX.000 $”

Dies verhindert die unbeabsichtigte Offenlegung sensibler Informationen.

Proaktive vs. reaktive Ansätze zur Datensicherheit für Vektor-Einbettungen

1️⃣ Proaktive Sicherheit – PII-Schutz vor der Einbettung anwenden

Dieser Ansatz stellt sicher, dass sensible Daten niemals in die Vektor-Einbettung gelangen.

Wie?

Daten strukturiert bereinigen vor der Vektorisierung. ✅

Markieren sensibler Informationen vor der Einbettung. ✅

Tokenisierung verwenden, um identifizierbare Werte zu ersetzen. ✅

Differenzielle Privatsphäre anwenden, um Rauschen einzufügen. ✅

Vorteil: Dieser Ansatz eliminiert Risiken an der Quelle und macht es unmöglich, dass bei Abfragen der Einbettungen PII offengelegt wird.

2️⃣ Reaktive Sicherheit – Audit und Maskierung nach der Einbettung

Dieser Ansatz geht davon aus, dass Einbettungen bereits Verweise auf sensible Informationen enthalten, und konzentriert sich auf das Erkennen und Maskieren von PII während der Abfrage.

Wie?

Sensiblen Inhalt in den für die Einbettung verwendeten Daten identifizieren. ✅

Echtzeit-Maskierung anwenden, bevor die abgerufenen Daten angezeigt werden. ✅

Unautorisierte Abfragen des Zugriffs auf sensible Einbettungen verhindern. ✅

Überwachen der Vektor-Ähnlichkeitsabfragen, um anomale Zugriffsmuster zu erkennen. ✅

Vorteil: Selbst wenn sensible Informationen bereits existieren in den Einbettungen, stellt diese Methode sicher, dass sie bei der Abfrage niemals offengelegt werden.

🎯 Die beste Sicherheitsstrategie? – Beide Ansätze kombinieren

Die stärkste Sicherheit erzielt man durch die Kombination beider Methoden:

- Proaktive Bereinigung verhindert, dass sensible Daten eingebettet werden.

- Reaktive Überwachung stellt sicher, dass bestehende Einbettungen kein PII leaken.

Wie DataSunrise Daten hinter Vektor-Einbettungen absichert

DataSunrise bietet eine umfassende Sicherheitslösung zum Schutz der durch pgvector referenzierten Daten sowohl vor als auch nach ihrer Erstellung.

🛡️ Proaktiver Schutz: Absicherung der Quelldaten vor der Einbettung

Für Organisationen, die mit riesigen Mengen an strukturierten und unstrukturierten Daten umgehen, hilft DataSunrise dabei:

- Erkennung von PII, bevor es Teil einer Einbettung wird.

- Maskierung sensibler Daten vor der Vektorisierung.

- Anonymisierungstechniken einsetzen, um spezifische persönliche Details zu entfernen.

Beispiel: Bevor Kundenprofile eingebettet werden, kann DataSunrise den Datenspeicher nach sensiblen Daten durchsuchen, Sozialversicherungsnummern entfernen, Adressen anonymisieren und Finanzdaten verallgemeinern, sodass die vektorisierte Darstellung keine privaten Details enthält.

🛡️ Reaktiver Schutz: Absicherung der Quelldaten mit bestehenden Einbettungen und KI-Anwendungen

Falls eine KI-Anwendung bereits mit Einbettungen betrieben wird, die Verweise auf sensible Daten enthalten, bietet DataSunrise:

- Erkennung sensibler Daten in den für die Einbettung verwendeten Daten.

- Dynamische Maskierung der abgerufenen sensiblen Ergebnisse.

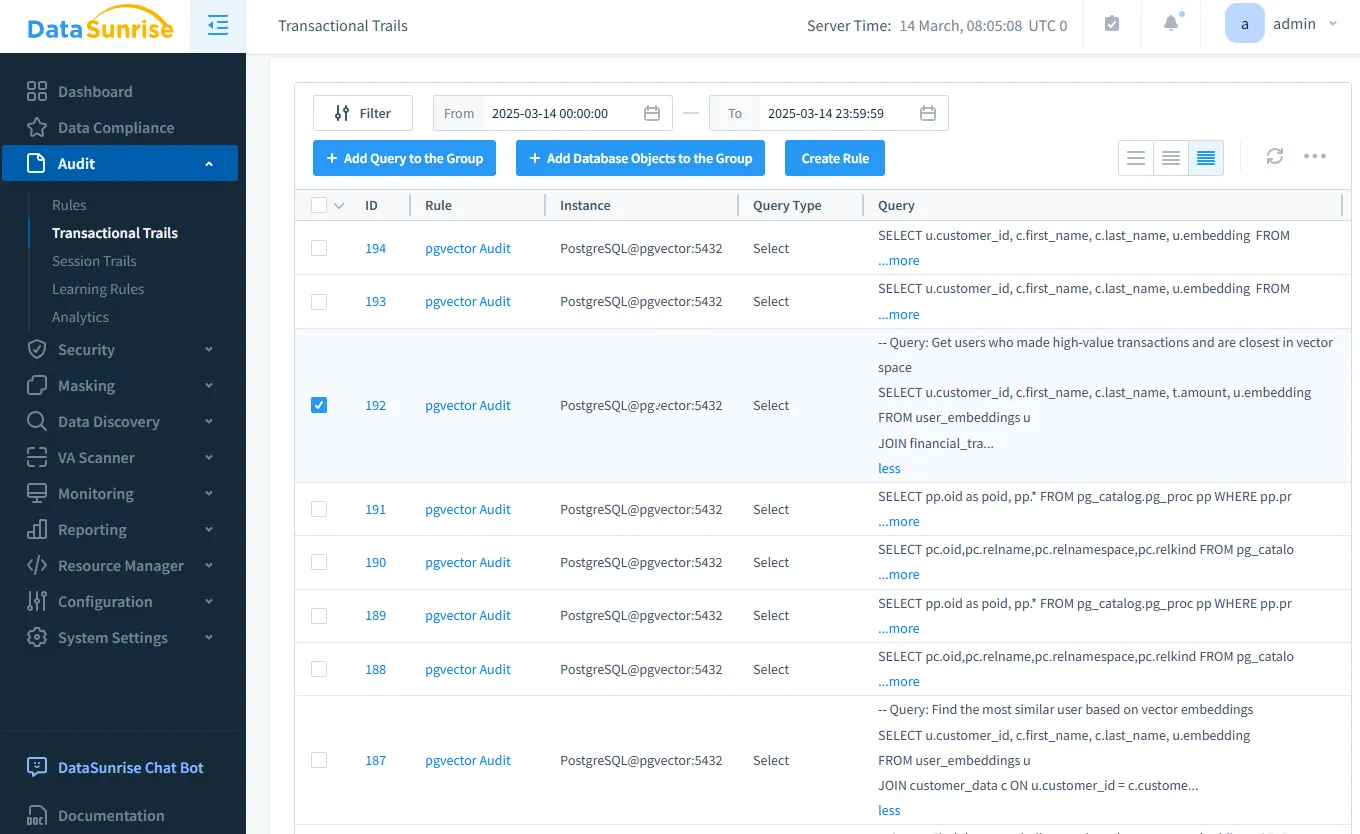

- Echtzeit-Auditing zur Erkennung unautorisierter Vektor-Ähnlichkeitssuchen.

Beispiel: Wenn ein Angreifer versucht, Einbettungen abzufragen, die PII enthalten könnten, überwacht und protokolliert DataSunrise solche Versuche und maskiert sensible Informationen, bevor sie offengelegt werden.

Die folgende Tabelle veranschaulicht den umfassenden Ansatz von DataSunrise zum Schutz von Vektor-Einbettungen, der sowohl die Prävention als auch die Erkennung der Offenlegung sensibler Daten abdeckt:

| Funktion | Proaktiver Schutz | Reaktiver Schutz |

|---|---|---|

| Datenerkennung | Identifiziert sensible Daten vor der Einbettung | Analysiert Einbettungsquellen zur Erkennung potenzieller PII-Offenlegung |

| Daten-Audit | Protokolliert die Erzeugung von Einbettungen | Erkennt verdächtige Abfragen |

| Datensicherheit | Verhindert PII in Einbettungen | Blockiert unautorisierte Vektorsuchen |

| Datenmaskierung | Verbirgt sensible Daten vor der Einbettung | Maskiert sensible Informationen bei der Abfrage |

Fazit: Ein dualer Sicherheitsansatz

Vektor-Einbettungen in pgvector sind mächtig, können jedoch sensible Daten offenlegen, wenn sie nicht korrekt gehandhabt werden. Der beste Ansatz besteht darin, proaktive und reaktive Sicherheitsmaßnahmen zu kombinieren, um die Risiken zu minimieren.

🔹 Vor der Erstellung der Einbettungen – Daten bereinigen, maskieren und den Zugriff kontrollieren.

🔹 Nach Vorhandensein der Einbettungen – Audits, Überwachung und Maskierung von PII in GenAI-Antworten durchführen.

Um Vektor-Einbettungen in PostgreSQL mit pgvector abzusichern, sollten Organisationen:

- ✅ Proaktive Maßnahmen einsetzen, um zu verhindern, dass PII in Einbettungen gelangt.

- ✅ Reaktive Sicherheitsmaßnahmen implementieren, um abgefragte Informationen zu überwachen und zu maskieren.

- 🛡️ DataSunrise nutzen, um in jeder Phase sensible Dateneinbettungen zu erkennen, zu schützen und vor Offenlegung zu bewahren.

DataSunrise ermöglicht beide Strategien und stellt sicher, dass KI-gestützte Anwendungen sicher und compliancegerecht betrieben werden. Ob Sie ein neues KI-System aufbauen oder ein bestehendes absichern, DataSunrise bietet umfassenden Schutz für sensible vektorisierte Daten.

Durch die Integration der Sicherheitsfunktionen von DataSunrise können Unternehmen ihre Daten für Vektor-Einbettungen nutzen, ohne Datenschutzverletzungen zu riskieren.

Benötigen Sie Schutz für Ihre Vektor-Einbettungs-Daten? Vereinbaren Sie noch heute eine DataSunrise-Demo, um Ihre GenAI-Anwendungen abzusichern!