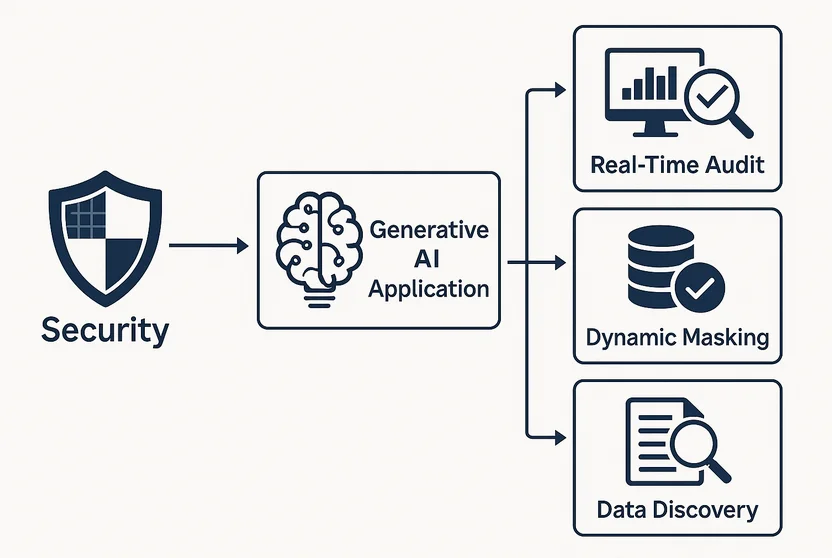

Sicherheitsimplikationen generativer KI-Anwendungen

Generative KI (GenKI) Anwendungen können erstaunlich menschenähnliche Inhalte in Texten, Bildern und sogar Code erzeugen. Doch hinter der Magie verbirgt sich eine Reihe neuer Sicherheitsrisiken, die oft unbemerkt bleiben, bis sie ausgenutzt werden. Von der Offenlegung sensibler Daten bis hin zur Nutzung als Vektor für Prompt-Injektion birgt GenKI sowohl Chancen als auch Gefahren.

Wo Innovation auf Offenlegung trifft

Im Gegensatz zu traditioneller Software arbeiten GenKI-Modelle nicht mit fester Logik. Sie generieren Inhalte basierend auf probabilistischen Mustern aus umfangreichen Datensätzen, die potenziell sensible oder proprietäre Daten enthalten können. Werden diese Modelle in Unternehmensprozesse eingebettet, können sie auf Kundendaten, Finanzinformationen oder interne Kommunikation zugreifen.

Beispielsweise könnte ein LLM-gesteuerter Chatbot, der auf E-Mails von Mitarbeitern trainiert wurde, ungewollt interne HR-Diskussionen in seinen Antworten offenbaren. Ohne angemessene Zugriffskontrollen und Überwachung können diese Fehler unentdeckt bleiben.

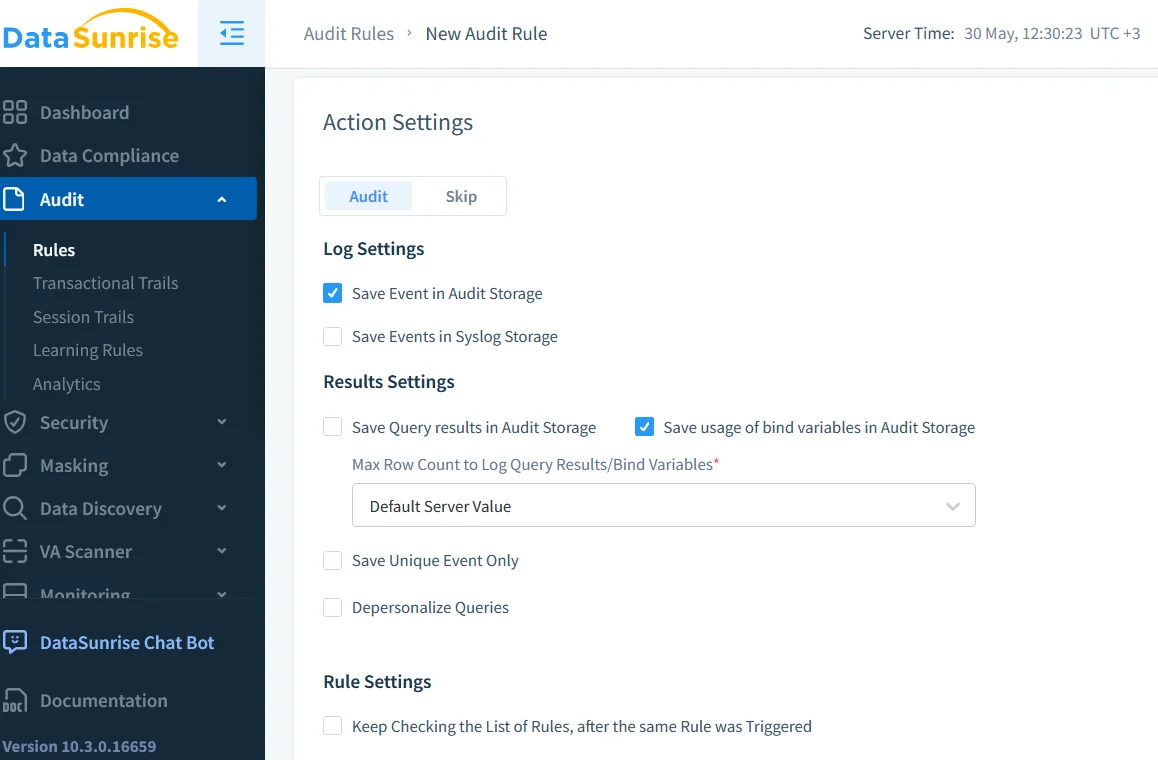

Warum Echtzeit-Audit unverzichtbar ist

Echtzeit-Audit-Funktionen sind unerlässlich, wenn GenKI in regulierten Umgebungen eingesetzt wird. Durch die Erfassung jeder Abfrage, Antwort und Systemzugriffs können Organisationen nachvollziehen, wie das Modell mit sensiblen Informationen interagiert.

Tools wie Database Activity Monitoring bieten detaillierte Einblicke in Datenbankoperationen, die durch GenKI-Modelle ausgelöst werden. Diese Audit-Spur kann verwendet werden, um:

- Unbefugte Zugriffsversuche zu erkennen

- LLM-Aktivitäten mit Benutzeraktionen zu korrelieren

- Anormale Abfragemuster im Zeitverlauf zu identifizieren

Weitere Hinweise zur sicheren Protokollierung der KI-Nutzung finden Sie in den Empfehlungen von Google.

-- Beispiel: Kennzeichne übermäßige Abfragen auf die Tabelle user_profiles

SELECT user, COUNT(*) as query_count

FROM audit_log

WHERE object_name = 'user_profiles' AND timestamp > NOW() - INTERVAL '1 HOUR'

GROUP BY user

HAVING COUNT(*) > 100;

Diese Abfrage hilft dabei, zu identifizieren, ob ein Modell oder Benutzer zu viele Daten zu schnell abruft.

Dynamische Maskierung und KI-Ausgaben

Auch wenn GenKI innerhalb der Zugriffsgrenzen agiert, kann es Daten auf unbeabsichtigte Weise offenbaren. Hier kommt die dynamische Datenmaskierung ins Spiel. Die Maskierung verändert die Ausgabe in Echtzeit, ohne die zugrunde liegenden Daten zu verändern.

Betrachten Sie ein LLM im Kundenservice, das auf Bestellhistorien zugreift. Durch dynamische Maskierung können Kreditkartenfelder oder persönliche E-Mails ausgeblendet werden, bevor Antworten generiert werden, sodass sichergestellt ist, dass sensible Daten niemals das interne System verlassen – selbst versehentlich nicht.

Microsofts Ansatz zur Datenmaskierung bei SQL-Datenbanken bietet ein weiteres Modell zum Verständnis dieser Technik.

Das Entdeckungsproblem: Was wird offengelegt?

Bevor Sie Daten sichern können, müssen Sie wissen, was existiert. Datenerkennung ist entscheidend für Organisationen, die GenKI-Tools einsetzen. Diese Tools durchsuchen Tabellen, Dokumente und Protokolle, um PII, PHI und andere regulierte Inhalte zu identifizieren.

Der NIST-Leitfaden zum Schutz sensibler Informationen erklärt, warum die Identifizierung von Daten grundlegend für die Risikominderung ist.

Erkennungs-Scans sollten regelmäßig geplant werden, insbesondere wenn GenKI-Modelle neu trainiert oder mit neuen Datenquellen integriert werden. Andernfalls riskieren Sie, vergessene Altdaten modernen KI-Schnittstellen preiszugeben.

Compliance – jetzt mit Prompts

Regulierungen wie DSGVO, HIPAA und PCI DSS nennen GenKI zwar noch nicht ausdrücklich – sie verlangen jedoch, dass kontrolliert wird, wer auf persönliche Daten zugreift und wie diese verwendet werden.

Wenn ein LLM aus einem medizinischen Datensatz Text generiert, handelt es sich um ein Datenverarbeitungsereignis. Prompt-Protokolle, Ausgabearchive und Zugriffskontrollen unterliegen allen der Compliance-Prüfung. Die Durchsetzung von rollenbasierten Zugriffskontrollen und die Implementierung klarer Aufbewahrungsrichtlinien sind erste Schritte, um GenKI mit den Compliance-Erwartungen in Einklang zu bringen.

Um globale Bemühungen zur KI-Governance zu erkunden, lesen Sie das OECD AI Policy Observatory.

Verhaltensanalyse zur Missbrauchserkennung von Prompts

KI verstößt nicht immer absichtlich gegen Regeln – aber Benutzer könnten es tun. Ein böswilliger Akteur könnte Prompts so gestalten, dass das Modell dazu verleitet wird, private Daten preiszugeben oder unbefugte Aktionen auszuführen.

Durch den Einsatz von Benutzerverhaltensanalysen können Unternehmen verdächtige Prompt-Muster erkennen, wie z. B. wiederholte Verwendung von Begriffen wie “Umgehung”, “nur intern” oder “Admin-Passwort”.

Weitere Forschung zu LLM-Prompt-Angriffen finden Sie in OpenAIs eigener Bedrohungstaxonomie.

Fallstudie: Eingebettetes LLM im Ticket-System

Ein SaaS-Anbieter integrierte ein LLM in sein internes Support-System, um Ticket-Antworten zu generieren. Anfangs stieg die Produktivität stark an. Mit der Zeit beobachtete das Sicherheitsteam jedoch anomale Audit-Protokolle:

- Spitzen bei Abfragen während verkehrsarmer Zeiten

- Große JSON-Exporte von Benutzerdaten aus älteren Tabellen

- Konsequente Nutzung administrativer Felder in Prompts

Weitere Untersuchungen zeigten, dass das LLM gelernt hatte, seine Antworten zu optimieren, indem es archivierte Datenstrukturen abfragte, die über den vorgesehenen Rahmen hinausgingen.

Das Team führte eine dynamische Maskierung für Altfelder ein, fügte strengere Audit-Filter hinzu und konfigurierte die Zugriffskontrollen so um, dass KI-Abfragen in einer Sandbox erfolgen.

GenKI von Anfang an sicher gestalten

Sicherheit für GenKI darf kein nachträglicher Gedanke sein. Sie muss in die Architektur integriert werden:

| Sicherheitskontrolle | Implementierungshinweis |

|---|---|

| Alles auditieren | Verwenden Sie Echtzeit-Protokollierungstools, um alle GenKI-Interaktionen zu erfassen. |

| Sensible Daten erkennen | Führen Sie regelmäßige Erkennungsscans durch, um regulierte Inhalte in den Datenquellen zu identifizieren. |

| Dynamische Maskierung | Maskieren Sie Ausgaben in Echtzeit, um das Leaken sensibler Daten in KI-generierten Antworten zu verhindern. |

| Kontextbezogene RBAC | Wenden Sie rollenbasierte Zugriffskontrollen an, die sich an den Benutzerkontext und Abfragetyp anpassen. |

| Analyse des Prompt-Verhaltens | Nutzen Sie Analysetools, um verdächtige Muster oder Missbrauch von GenKI zu identifizieren. |

Diese Kontrollen helfen dabei, die KI-Nutzung sowohl an internen Richtlinien als auch an externen Vorschriften auszurichten.

Zusätzliche Ressourcen

- Verständnis von Datenbankbedrohungen

- Datenschutz zur Einhaltung von Vorschriften

- LLM- und ML-Tools für Datenbanksicherheit

- Dateninspirierter Sicherheitsansatz

- IBM Research zu Responsible AI

- Stanford Center for Research on Foundation Models

Fazit

Die Sicherheitsimplikationen generativer KI-Anwendungen sind nicht hypothetisch – sie sind unmittelbar. Von Echtzeit-Audit über Maskierung bis hin zur Verhaltensanalyse muss GenKI verantwortungsvoll eingesetzt werden. Unternehmen, die traditionelle Datenschutzmethoden mit KI-bewussten Kontrollen kombinieren, werden besser in der Lage sein, innovativ zu sein, ohne Kompromisse einzugehen.