Übersicht über KI-Cybersicherheitsbedrohungen

Generative KI (GenAI) verändert die Cybersicherheit grundlegend. Diese Modelle analysieren Daten nicht nur – sie generieren sie auch. Sie schreiben Texte, erstellen Code und automatisieren Entscheidungen. Doch mit zunehmenden Fähigkeiten öffnen sie auch neue Angriffsflächen. Von der Weitergabe sensibler Daten durch Modelleingaben bis hin zur Ausnutzung durch Prompt-Injektionen – GenAI bringt Bedrohungen mit sich, die durch herkömmliche Sicherheitswerkzeuge nicht vollständig abgedeckt werden.

Dieser Artikel bietet einen Überblick über KI-Cybersicherheitsbedrohungen und erklärt, wie Echtzeitaudits, dynamische Maskierung, Datenerkennung und Compliance-Tools die mit GenAI-Systemen verbundenen Risiken mindern können.

GenAI-Risiken gehen über klassische Sicherheitslücken hinaus

Im Gegensatz zu herkömmlichen Anwendungen verwendet GenAI natürliche Sprache und vektorbasierte Ähnlichkeiten, um relevante Inhalte zurückzugeben. Das bedeutet, dass ein Modell versehentlich vertrauliche Informationen preisgeben könnte, wenn es während des Trainings exponiert wurde – oder wenn ein Angreifer den richtigen Prompt erstellt.

Beispielsweise könnte eine interne Suchanfrage unter Verwendung von PostgreSQL mit pgvector folgendermaßen aussehen:

SELECT * FROM documents

WHERE embedding <#> '[0.1, 0.5, 0.9, ...]'

ORDER BY similarity

LIMIT 1;

Wenn der Vektor ein sensibles Konzept repräsentiert, könnte das Ergebnis ein internes, vertrauliches Memo sein. Ohne Maskierungs- oder Audit-Regeln könnte dieser Zugriff unbemerkt bleiben.

Ein weiteres Beispiel: Nutzt ein interner Chatbot ein LLM, um basierend auf SQL-Daten Antworten zu generieren, könnte ein gezielt gestalteter Prompt mehr extrahieren, als beabsichtigt.

PROMPT: Liste die jüngsten Kundentransaktionen über 10.000 $

-- SQL generiert vom LLM --

SELECT customer_name, amount, transaction_date

FROM transactions

WHERE amount > 10000;

Wenn der Zugriff nicht eingeschränkt oder maskiert ist, könnte dies finanzielle personenbezogene Daten (PII) offenbaren.

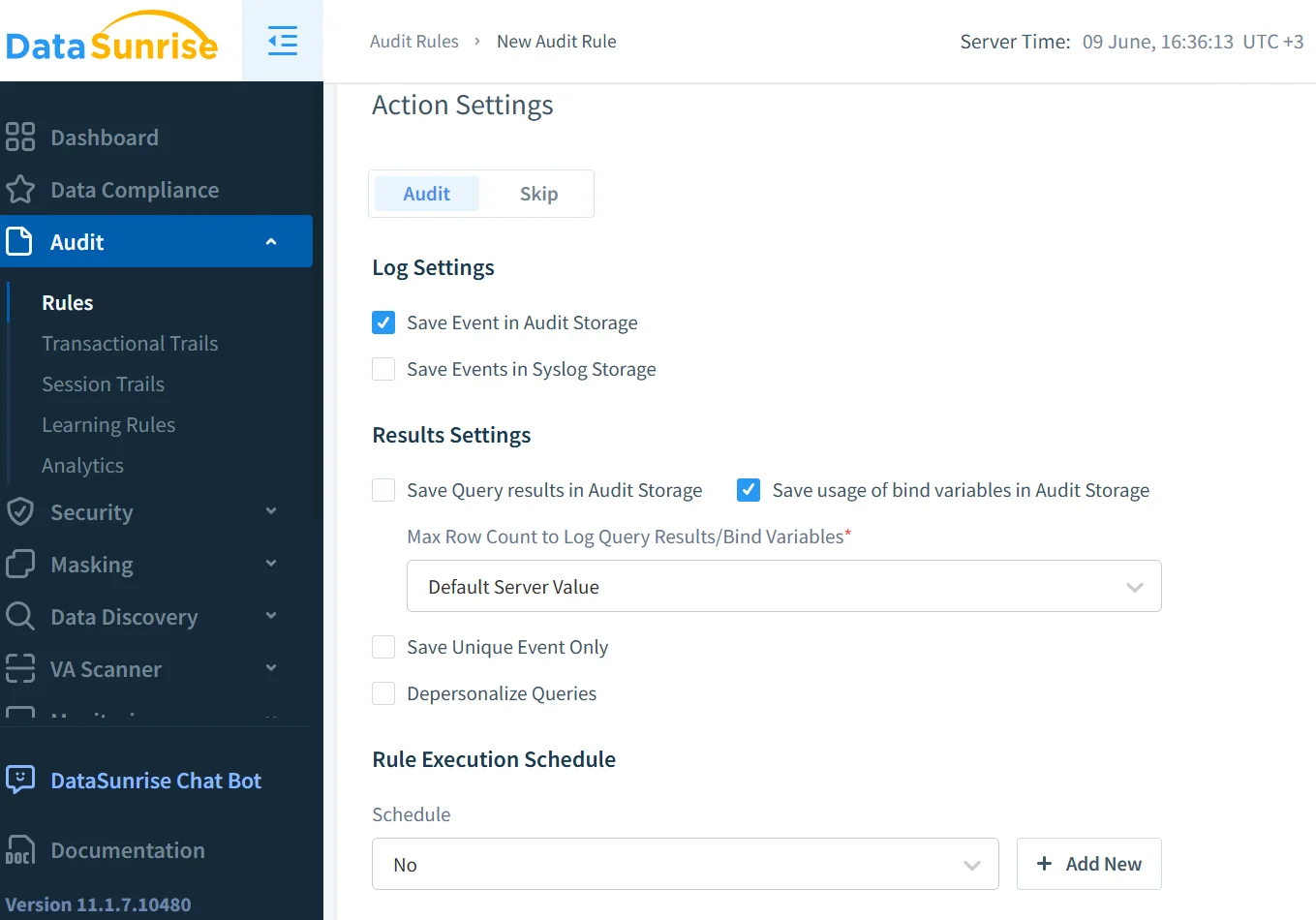

Echtzeitaudits helfen, Bedrohungen sofort zu erkennen

Echtzeitaudits sind in GenAI-Umgebungen unerlässlich. Sie protokollieren Zugriffe und benachrichtigen Sicherheitsteams, sobald verdächtiges Verhalten festgestellt wird. Beispielsweise könnte ein Angreifer ein Modell durch wiederholtes Senden modifizierter Prompts ausloten. Eine Echtzeitaudit-Lösung, wie sie in DataSunrise's Audit-Logs beschrieben wird, ermöglicht es den Teams, in solchen Fällen sofort zu reagieren.

Verhaltensbasierte Audit-Daten können auch dabei helfen, nachzuvollziehen, wie und wann auf sensible Informationen zugegriffen wurde, und so die Tiefenschärfe in der Vorfallforensik und den Compliance-Berichten erhöhen. Sehen Sie, wie die Datenaktivitäts-Historie diese Transparenz schafft.

Maskierung stellt sicher, dass Modelle nicht das preisgeben, was sie nicht preisgeben sollten

Selbst das beste Audit-Log kann eine Offenlegung nicht verhindern – es dokumentiert sie lediglich. Um ein versehentliches Leck zu vermeiden, muss verhindert werden, dass sensible Inhalte in den Modelleantworten erscheinen. Hier kommt die dynamische Datenmaskierung ins Spiel.

Dynamische Maskierung unterbricht und schwärzt sensible Felder während der Abfrage. Wenn beispielsweise ein Benutzer fragt: „Zeige mir Johns medizinische Akte“ und das Modell versucht, persönliche Gesundheitsinformationen zurückzugeben, stellt die dynamische Maskierung sicher, dass Namen, IDs oder Diagnosedaten ersetzt oder verborgen werden. Dies funktioniert besonders gut, wenn GenAI in unternehmensweite Such- oder Chatbot-Systeme integriert ist.

Eine Beispielkonfiguration für die Maskierung in SQL könnte folgendermaßen aussehen:

CREATE MASKING POLICY mask_sensitive_fields

AS (val STRING)

RETURN CASE

WHEN CURRENT_ROLE IN ('admin') THEN val

ELSE '***MASKED***'

END;

Die Entdeckung hält Sie vor unbekannten Risiken

Es ist schwer, etwas zu schützen, von dem man nicht weiß, dass man es hat. GenAI-Systeme können auf Schatten-Datensätze, veraltete Tabellenkalkulationen oder Cloud-Freigaben, die mit personenbezogenen Daten (PII) gefüllt sind, zugreifen. Die Datenerkennung hilft dabei, solche Datenquellen zu identifizieren und zu klassifizieren.

Sobald die Entdeckung sensible Felder kartiert, können Unternehmen diesen Feldern Maskierungs-, Audit- und Zugriffskontrollregeln zuweisen. Dies schließt den Kreis: Entdeckte Daten werden zu gesteuerten Daten. Es verhindert auch, dass GenAI-Modelle versehentlich auf Altsysteme mit schwachen Kontrollen zugreifen.

Prompt-Injektion und Missbrauch erfordern neue Sicherheitsregeln

Prompt-Injektion ist das neue SQL-Injection. Anstatt sich in eine Datenbank einzuhacken, versuchen Angreifer, das Verhalten des Modells zu beeinflussen, indem sie dessen Eingabe verändern. GenAI kann so manipuliert werden, dass es Anweisungen ignoriert, Geheimnisse preisgibt oder unbefugte Aktionen ausführt.

Zur Abschwächung dieser Risiken sollten Sicherheitsregeln implementiert werden, die das Eingabe- und Ausgabe-Verhalten überwachen. Die Begrenzung von Vektorsuchen, das Abgleichen bekannter Missbrauchsphrasen und das Sperren des Zugriffs auf bestimmte Tabellen oder Dokumente sind allesamt effektive Methoden. In Kombination mit rollenbasierten Zugriffskontrollen wird GenAI viel weniger angreifbar.

Ein typischer Response-Sanitizer könnte folgendermaßen angewendet werden:

if 'SSN' in response:

response = response.replace(user_ssn, '***')

Compliance ist nicht optional – sie ist eine Systemvoraussetzung

GenAI muss innerhalb gesetzlicher und ethischer Grenzen arbeiten. Unabhängig davon, ob Ihr Unternehmen unter GDPR, HIPAA oder PCI DSS fällt, bestimmen Compliance-Regeln, wie mit sensiblen Daten umgegangen, gespeichert und protokolliert wird.

Der Compliance Manager automatisiert die Zuordnung zwischen Vorschriften und technischen Kontrollen. Sie können Maskierungsrichtlinien mit PCI-Feldern verknüpfen, Audit-Richtlinien für HIPAA-geschützte Datensätze durchsetzen und Dokumentationen erstellen, die die kontinuierliche Einhaltung nachweisen.

Compliance geht nicht nur darum, Geldstrafen zu vermeiden. Es geht auch darum, Vertrauen in KI-Systeme aufzubauen, die verantwortungsvoll mit den ihnen anvertrauten Daten umgehen.

Transparenz über den gesamten Stack hinweg ist entscheidend

Für eine umfassendere Diskussion darüber, wie LLM-Security die Infrastruktur beeinflusst, lesen Sie MITs Perspektive zu Prompt-Injektion und Risiken von Foundation Models. Die Risiken gehen über Unternehmenseinsatzszenarien hinaus und betreffen Open-Source-Modelle, akademische Datensätze und öffentliche Web-Scraping-Praktiken.

Zudem zeigt der Artikel von Stanford HAI über Red Teaming von Sprachmodellen, wie Forscher KI-Systeme auf ethische und sicherheitstechnische Mängel testen – ein nützlicher Ansatz zur Gestaltung unternehmensinterner GenAI-Richtlinien.

Die Zukunft der KI-Cybersicherheit liegt in der Korrelation. Echtzeitaudits zeigen, wer was getan hat. Maskierung zeigt, was eingesehen wurde. Datenerkennung zeigt, wo sich die Daten befinden. Sicherheitsregeln verhindern Missbrauch. Compliance verbindet all dies miteinander.

Ein GenAI-System wird erst dann sicher, wenn diese Werkzeuge Kontext miteinander teilen. Daher ist datengestützte Sicherheit – bei der Sicherheitsentscheidungen die Datenklassifikation, die Geschäftsrolle und Nutzungsmuster widerspiegeln – die Zukunft.

Mit diesem Modell können Innovation und Compliance koexistieren, sodass GenAI dienen kann, ohne die Integrität der berührten Daten zu gefährden.