Wie man Generative-KI-Pipelines sichert

Generative KI (GenKI) hat Industrien revolutioniert, indem sie die Erstellung von menschenähnlichem Text, Bildern und Code ermöglicht. Doch hinter der Innovation verbirgt sich eine Pipeline mit sensiblen Daten, ML-Modellen und dynamischen Workloads, die zunehmend anfällig für Missbrauch sind. Die Absicherung dieser Pipelines ist entscheidend, um die Privatsphäre zu wahren, Vertrauen zu schaffen und die Einhaltung von Vorschriften zu gewährleisten.

Dieser Artikel untersucht, wie generative KI-Pipelines mit Echtzeitprüfung, dynamischer Datenmaskierung und automatischer Datenerkennung abgesichert werden können. Er enthält außerdem ein grundlegendes Beispiel und Links zu weiteren Ressourcen.

Was generative KI-Pipelines anfällig macht

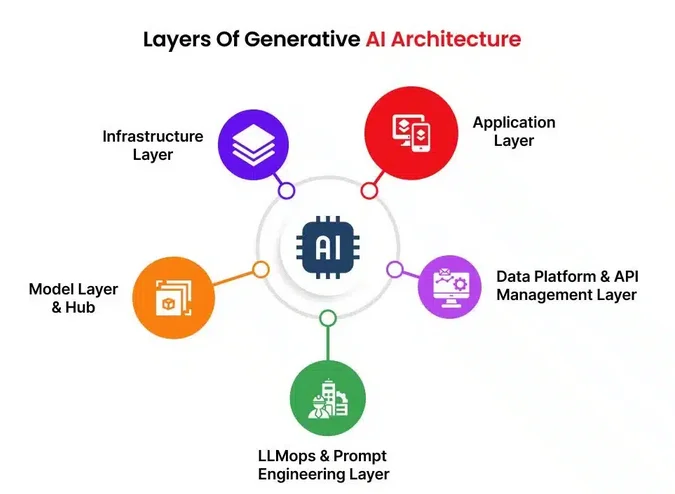

GenKI-Workflows beinhalten typischerweise das Modelltraining und die Inferenz unter Verwendung massiver Datensätze. Diese Pipelines umfassen die Datenaufnahme, Vorverarbeitung, Modellbereitstellung, Prompts und generierte Ausgaben. In jeder Phase können sensible Daten wie personenbezogene Daten (PII), proprietäres geistiges Eigentum oder Finanzunterlagen offengelegt werden.

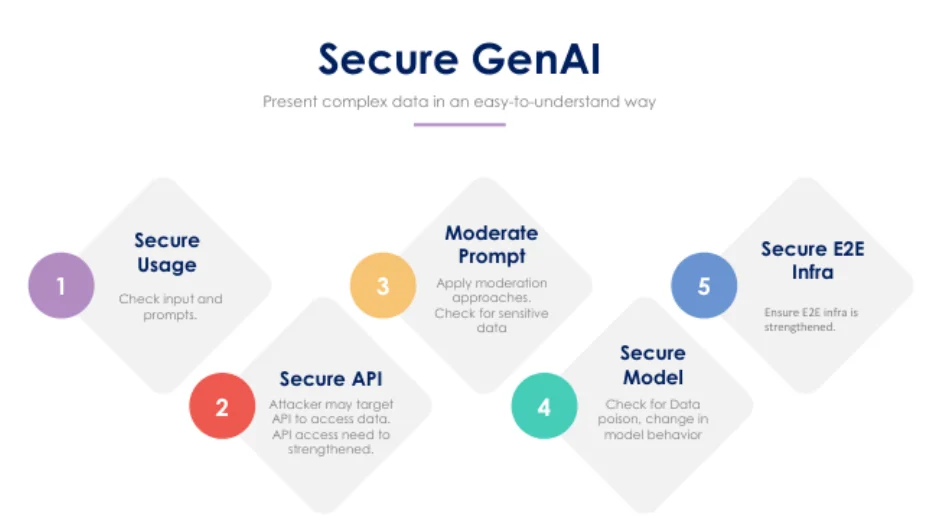

Zu den typischen Schwachstellen zählen Prompt-Injektionen, Jailbreak-Angriffe und die Offenlegung sensibler Trainings- oder Inferenzdaten. Pipelines weisen oft keine Echtzeitüberwachung auf und leiden unter unzureichenden Zugriffskontrollpraktiken. Selbst gut abgestimmte LLMs können unbeabsichtigte Datenfragmente aus dem Speicher zurückgeben oder Ausgaben erzeugen, die Compliance-Grenzen verletzen.

Echtzeitprüfung: Die erste Verteidigungslinie

Die Echtzeitprüfung ermöglicht es Organisationen, jeden Zugriff und jede Aktion im Zusammenhang mit Daten, Prompts oder der Nutzung von Modellen zu überwachen. Durch das Protokollieren von Abfragen und Benutzerinteraktionen schaffen Sie eine Nachvollziehbarkeit, die Untersuchungen unterstützt und Unregelmäßigkeiten im Moment ihres Auftretens erkennt.

Ein grundlegendes Beispiel mit PostgreSQL:

CREATE EVENT TRIGGER audit_prompt_access

ON sql_drop

EXECUTE FUNCTION log_prompt_usage();

Mit einem Tool wie DataSunrise Database Activity Monitoring können Sie dies auf Verhaltensanalysen ausweiten, nachvollziehen, wer welches Modell abgefragt hat, und Warnungen bei riskanten Eingabemustern erhalten.

Dynamische Datenmaskierung für Prompt-Eingaben und -Ausgaben

Die Maskierung auf Prompt-Ebene ist entscheidend, wenn mit regulierten Daten gearbeitet wird. Beispielsweise sollte ein GenKI-Modell, das aufgefordert wird, einen Bericht zu erstellen, niemals die echten Patientennamen sehen. Dynamische Maskierung verbirgt oder schwärzt Felder zum Zeitpunkt der Abfrage, ohne die Quelldaten zu verändern. Dies schützt Inferenzabfragen, verhindert das Auslaufen sensibler Ausgaben und reduziert den Schadensradius im Falle eines Prompt-Lecks oder einer Speicherschwachstelle.

Beispiel:

SELECT name, diagnosis, treatment

FROM patients

WHERE region = 'EU'

MASKED WITH (name = 'XXXX', treatment = '***');

Tools wie DataSunrise setzen dynamische Regeln basierend auf Rollen und Abfragekontexten durch.

Automatisierte Datenerkennung: Wissen, was auf dem Spiel steht

Bevor Sie GenKI absichern, müssen Sie wissen, was Sie schützen. Tools zur Datenerkennung scannen automatisch Datenbanken und Pipelines, um personenbezogene Daten (PII), geschützte Gesundheitsinformationen (PHI), PCI-Daten und alle unstrukturierten Inhalte, die mit LLMs geteilt werden, zu identifizieren. Diese Tools können auch Blob-Speicher oder Vektor-Datenbanken auf sensible Inhalte überprüfen.

Durch die Nutzung von in Sicherheitswerkzeuge integrierten Datenerkennungs-Engines können Organisationen ihre Assets klassifizieren und automatisch geeignete Maskierungs- oder Protokollierungsrichtlinien anwenden.

Einhaltung von Datenschutzvorschriften

Egal ob Sie im Gesundheitswesen, Finanzsektor oder E-Commerce tätig sind, muss die Nutzung generativer KI mit Datenschutzvorschriften wie DSGVO, HIPAA oder PCI DSS übereinstimmen.

Um konform zu bleiben, ist es wichtig, rollenbasierte Zugriffskontrollen durchzusetzen, Daten entsprechend ihrer Sensitivitätsstufen zu klassifizieren und Prüfpfade sowie Maskierungstechniken zu verwenden, um den gesetzlichen Anforderungen gerecht zu werden. Echtzeit-Compliance-Prüfungen dienen als Schutzmaßnahme, die potenzielle Verstöße verhindert, bevor sie entstehen können.

Best Practices für die Sicherheit generativer KI

Der Einsatz von Reverse-Proxies oder API-Gateways mit Filterfunktionen hilft dabei, den Datenverkehr zu und von GenKI-Modellen zu kontrollieren. Das Protokollieren jeder Interaktion mit dem Modell und den von ihm abgerufenen Daten gewährleistet Verantwortlichkeit. Ebenso wichtig ist es, Alarmregeln basierend auf dem Benutzerverhalten und riskanten Eingaben aufzustellen. Prompts und Antworten sollten auf personenbezogene Daten geprüft werden, und wo immer möglich, sollten synthetische Daten anstelle von echten Daten bei Modelltrainingsaufgaben eingesetzt werden.

Abschließende Gedanken

Da generative KI immer stärker in Geschäftsprozesse integriert wird, muss ihre Sicherheit mit derselben Strenge behandelt werden wie traditionelle IT-Systeme. Die Kombination von Echtzeitprüfung, Maskierung, Datenerkennung und der Durchsetzung von Compliance-Richtlinien schafft eine robuste Verteidigung gegen Datenschutzverletzungen und regulatorische Bußgelder.

Um tiefer in diese Themen einzutauchen, erkunden Sie:

Siehe auch diesen OpenAI-Artikel über die Sicherheitsausrichtung von LLMs und Googles Secure AI Framework (SAIF) für weiter gefasste Sicherheitskonzepte.