Défis de sécurité des données dans les systèmes d’IA

Les systèmes d’IA générative transforment la manière dont les organisations utilisent et partagent les données. Ils rationalisent les flux de travail, automatisent la prise de décision et soutiennent les modèles d’apprentissage adaptatif. Mais cette évolution apporte également des menaces nouvelles et complexes pour la sécurité des données. Les modèles ingèrent des informations sensibles, produisent des résultats imprévisibles et nécessitent l’accès à d’énormes ensembles de données, rendant ainsi les contrôles de sécurité traditionnels insuffisants.

Comprendre les défis de sécurité des données dans les systèmes d’IA signifie aller au-delà des pare-feux réseau ou de la protection des terminaux. Cela implique de sécuriser les entrées, le comportement des modèles et les flux de données — le tout en temps réel, dans divers environnements. Les systèmes d’IA ont intrinsèquement besoin de données, et leur dépendance vis-à-vis des données en temps réel augmente l’exposition aux fuites, aux attaques par inférence et aux violations de conformité.

Audit en temps réel comme mécanisme de défense

Les journaux d’audit ne sont pas une nouveauté — mais leur rôle dans la sécurité de l’IA est désormais central. La journalisation des requêtes des utilisateurs, des réponses du modèle, des interactions API et des requêtes SQL vers des magasins de vecteurs ou des bases de données relationnelles offre une piste de responsabilité. Un système d’audit en temps réel permet de détecter immédiatement des anomalies comme l’injection de requêtes, l’accès non autorisé à des lignes sensibles ou la fuite d’informations personnelles identifiables (PII).

-- Exemple : journalisation de la requête utilisateur dans PostgreSQL avec une requête JSON

INSERT INTO prompt_audit_log (user_id, prompt_body, timestamp)

VALUES (current_user, to_jsonb($$Summarize financial data by client sector$$), now());

Combiné avec DataSunrise, les règles d’audit peuvent classifier et taguer automatiquement les requêtes interagissant avec des champs confidentiels, offrant ainsi une couche de surveillance transparente pour les applications d’IA construites sur des architectures GenAI.

Masquage dynamique pour les sorties sensibles

Les réponses de l’IA qui exposent des adresses électroniques, des numéros de téléphone ou des identifiants sont bien plus qu’une fuite de données — elles constituent une violation de conformité. C’est ici que le masquage dynamique devient essentiel. Contrairement à la rédaction statique, le masquage dynamique s’adapte en temps réel, protégeant les sorties sans perturber la logique du système.

Par exemple, lorsqu’une requête accède à une base de données de support client, le masquage dynamique peut masquer tous les champs liés aux cartes de crédit, que ce soit dans les données d’entraînement ou dans la sortie générée. Dans DataSunrise, cela se configure avec des règles de masquage liées à l’accès basé sur les rôles et aux motifs de contenu.

-- Exemple : règle de masquage pour la colonne credit_card

CREATE MASKING RULE hide_credit_cards

ON customers.credit_card

USING FULL MASKING

WHEN current_user_role != 'auditor';

Cela garantit que les outils d’IA tels que les pipelines de génération augmentée par récupération (RAG) ne révèlent jamais de champs sensibles bruts, même lorsqu’ils sont connectés à des magasins de vecteurs de confiance.

Découverte avant sécurisation

Avant de pouvoir protéger les données, il faut savoir où elles se trouvent — et l’IA amplifie ce défi. Les modèles affinés utilisent souvent des sources de données hybrides à travers des bases de données structurées, des journaux non structurés et des documents semi-structurés. Scanner toutes les sources pour détecter des attributs sensibles devient un point de départ essentiel.

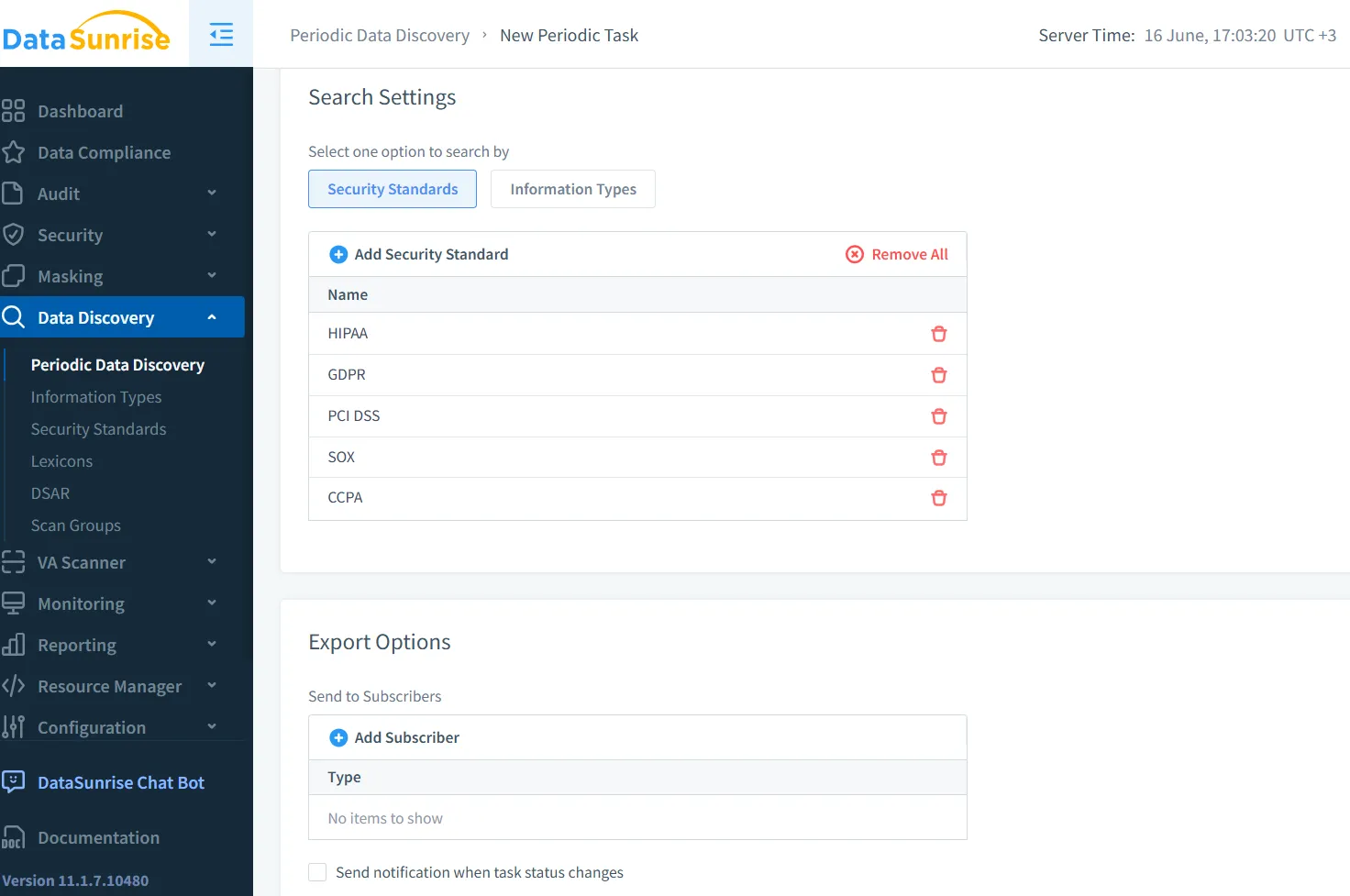

Les outils de découverte de données localisent, classifient et étiquettent automatiquement les éléments sensibles sur divers systèmes de stockage. Pour l’IA, cela inclut l’identification des ensembles de formation contenant des informations de santé protégées (PHI), des identifiants de clients ou des connaissances propriétaires qui ne devraient pas être exposées.

La découverte ne se limite pas à la phase pré-entraînement ; elle est continue. Lorsque les ensembles de données évoluent — par exemple avec l’indexation de nouveaux documents dans les magasins de vecteurs — la découverte doit déclencher une reclassification et une réévaluation des politiques. Cela la rend essentielle pour la gouvernance de l’IA et l’application automatique de la sécurité.

Architecture de sécurité adaptée à l’IA

La sécurité des GenAI ne consiste pas simplement à envelopper un nouvel outil avec des pare-feux existants. Il s’agit de concevoir pour la visibilité, la traçabilité et des contrôles adaptatifs. Une approche de sécurité en couches est la plus appropriée :

Pare-feux de requêtes pour intercepter les entrées malveillantes avant qu’elles n’atteignent le modèle

Classification des données basée sur des tokens à l’intérieur des pipelines de sortie des grands modèles linguistiques

Détection d’anomalies basée sur les sessions utilisant le contexte utilisateur et des requêtes

Masquage dynamique au niveau des vecteurs et des réponses SQL

Journalisation d’audit consciente des politiques qui reflète l’appétit de risque de l’organisation

Ces composants fonctionnent ensemble. Un utilisateur saisissant une requête suspecte dans une interface de chatbot pourrait déclencher un pare-feu de requêtes, enregistrer la demande dans une table d’audit et retourner une réponse masquée — le tout sans interrompre le service.

Rester conforme à l’ère de l’IA

L’IA ne vous exempte pas des obligations de conformité. En fait, son imprévisibilité ajoute des risques aux cadres existants tels que le RGPD, HIPAA et PCI-DSS. Vous devez toujours suivre où les informations personnelles identifiables sont accessibles, prouver qu’elles sont protégées, et répondre aux demandes d’effacement ou d’accès.

DataSunrise fait le lien entre l’IA et les obligations réglementaires en fournissant des contrôles de niveau conformité sur le mouvement des données, la visibilité d’accès et la protection. La suite Conformité des données garantit que les applications d’IA respectent les mêmes limites que les opérateurs humains. L’intégration avec des outils tels que la Découverte de Données et le Masquage Dynamique vous permet de définir des règles applicables — et non pas uniquement des rapports passifs.

Pour un guide pratique sur l’intégration de ces outils, le centre de connaissances sur la conformité réglementaire propose des meilleures pratiques en matière de sécurité des bases de données, de masquage et de journalisation d’audit pour les charges de travail pilotées par l’IA.

Regarder vers l’avenir : l’IA à la fois comme menace et allié

Il est tentant de considérer l’IA comme un risque pour la sécurité — mais elle peut également agir comme un agent de protection. Les architectures futures incluront probablement des agents de sécurité des données alimentés par des grands modèles linguistiques capables d’examiner les schémas d’accès, de recommander de nouvelles politiques de masquage et de bloquer en temps réel les chaînes de requêtes suspectes.

En combinant l’audit en temps réel, le masquage dynamique, la découverte continue et l’application basée sur des politiques, les organisations peuvent faire en sorte que l’IA travaille pour la sécurité plutôt que contre elle. Des outils comme DataSunrise aident à naviguer dans cette transition — passant d’une défense réactive à une protection proactive alignée sur l’IA.

Des perspectives externes soutiennent également cette évolution. L’article arXiv sur les risques de cybersécurité des grands modèles linguistiques explore comment les modèles peuvent divulguer ou déduire des secrets, tandis que la Cloud Security Alliance insiste sur l’importance de la sécurité des données axée sur l’IA.

Assurer la sécurité de l’IA générative ne relève pas de la peur — c’est une question de conception. Et la conception commence par la visibilité, l’adaptabilité et le contrôle du cycle de vie des données à chaque niveau.