Gestion de la posture de sécurité dans les environnements d’IA et de grands modèles de langage

À l’ère de l’IA générative (GenAI) et des grands modèles de langage, les données ne sont pas simplement une ressource, mais un acteur vivant dans chaque interaction. Ces modèles analysent, mémorisent et répondent aux requêtes avec une aisance déconcertante, mais ce faisant, ils s’entrelacent profondément avec des informations sensibles, réglementées ou exclusives. La liste de contrôle de sécurité traditionnelle ne suffit plus. À la place, une stratégie dynamique et adaptative est nécessaire — et cela commence par un accent sur la gestion de la posture de sécurité dans les environnements d’IA et de grands modèles de langage.

Qu’est-ce qui rend la sécurité de l’IA et des grands modèles de langage différente ?

Contrairement aux systèmes logiciels statiques, les grands modèles de langage fonctionnent sur des résultats probabilistes dérivés de vastes ensembles de données. Cela introduit de nouveaux défis. Les données d’entraînement peuvent contenir des informations personnelles identifiables (IPI) ou des secrets commerciaux. Les résultats d’inférence pourraient accidentellement divulguer ces informations. Des requêtes malveillantes peuvent même déclencher des comportements imprévus ou nuisibles. Ces risques signifient que la gestion de la posture de sécurité doit s’étendre sur l’ensemble du cycle de vie de l’IA — de l’ingestion et de l’entraînement jusqu’au déploiement et à l’interaction avec l’utilisateur.

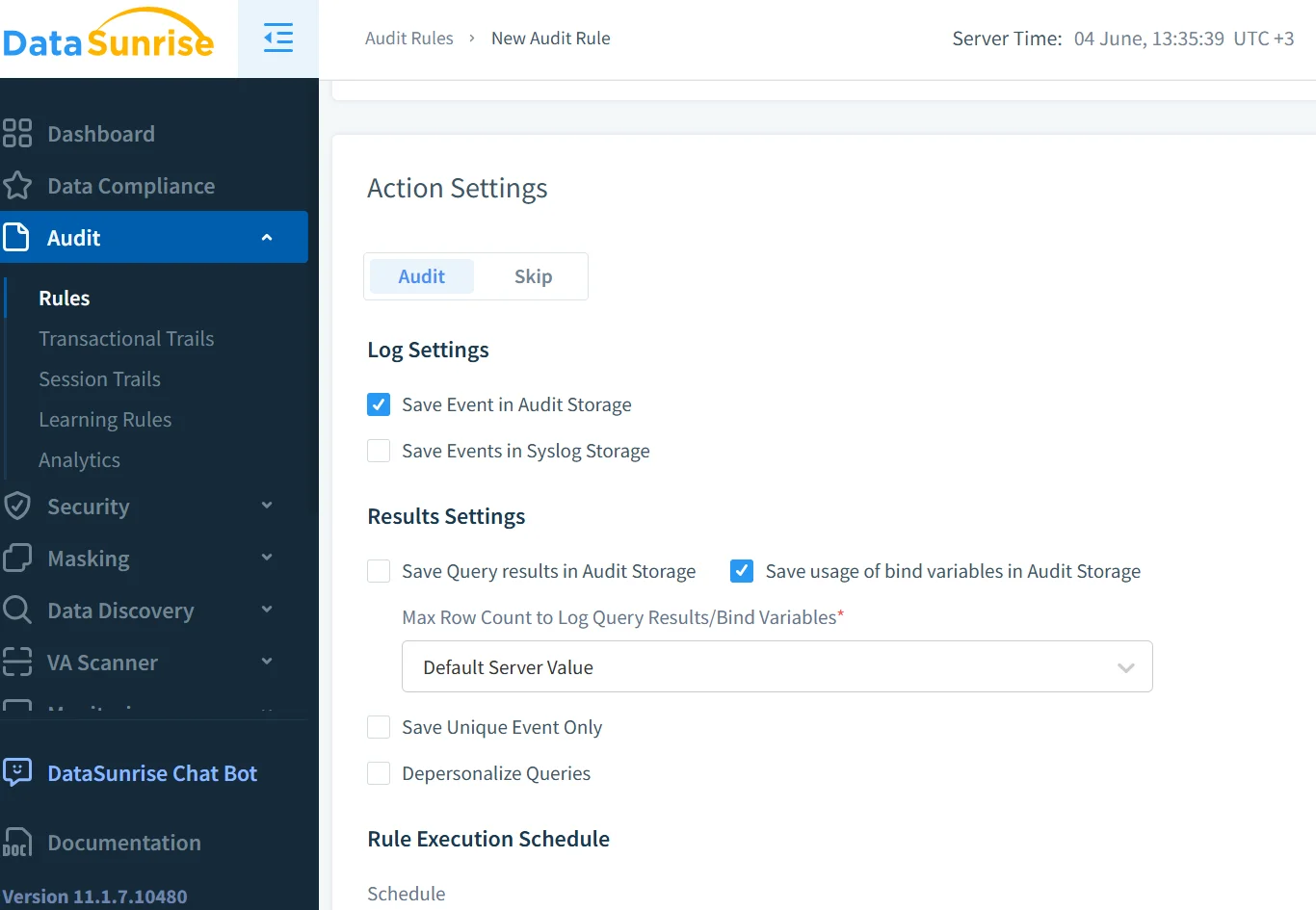

Audit en temps réel pour les interactions avec les grands modèles de langage

Les journaux d’audit constituent l’épine dorsale de tout cadre de gestion de la posture efficace. Mais dans le contexte de l’IA générative, nous avons besoin de capacités d’audit en temps réel qui vont au-delà des opérations de base. Par exemple, considérez ce modèle de requête de type SQL pour enregistrer l’accès aux requêtes d’IA :

INSERT INTO audit_logs (user_id, prompt, timestamp, model_version)

SELECT CURRENT_USER, :prompt_text, NOW(), :model_id;

L’association de cela à un outil de surveillance en temps réel garantit que les soumissions de requêtes, leurs complétions, et même les encodages sont capturés, signalés et traités. Grâce à la surveillance de l’activité de la base de données, les équipes de sécurité peuvent être alertées lorsqu’une requête touche des ensembles de données sensibles ou génère une sortie à haut risque.

Découverte des données sensibles avant qu’elles n’atteignent votre modèle

Les grands modèles de langage ont un appétit vorace pour les données, mais toutes les données ne devraient pas être intégrées dans un modèle. C’est là qu’intervient la découverte de données. Elle permet aux organisations d’identifier, de classifier et d’étiqueter les contenus sensibles avant même qu’ils n’entrent dans le processus d’entraînement. Un scanner basé sur le comportement peut signaler des identifiants en clair ou des expressions liées à la santé, garantissant ainsi que les données problématiques soient mises en quarantaine.

Les outils de découverte de données intégrés aux pipelines aident à appliquer les contrôles d’accès basés sur les rôles afin que seuls les utilisateurs autorisés puissent approuver les ensembles de données. Des plateformes externes comme AWS Macie offrent également une inspection avancée du contenu pour détecter les IPI dans de vastes lacs de données.

Masquage dynamique pour la protection au niveau des requêtes

Une requête telle que « Parlez-moi de mon compte » peut sembler inoffensive jusqu’à ce qu’elle récupère de véritables détails clients. Le masquage dynamique intercepte ce processus, en effaçant ou en remplaçant les valeurs sensibles en temps réel. Cela empêche la fuite d’informations confidentielles lors des cycles de requête et de réponse.

# Exemple : masquage du numéro de compte dans la requête avant de l'envoyer au modèle

if "account_number" in prompt:

prompt = prompt.replace(user_account_number, "***-****-1234")

Dans les systèmes de génération augmentée par récupération (RAG), le masquage dynamique garantit que les résultats vectorisés des documents ne réintroduisent pas de contenu expurgé. LangChain prend également en charge des couches d’application de politiques pour gérer les entrées et sorties masquées.

Construire une stratégie de sécurité conforme et adaptative

La conformité en matière de sécurité devient centrale dans le déploiement des grands modèles de langage. Des réglementations telles que le RGPD, la HIPAA et les projets de loi sur la gouvernance de l’IA exigent une responsabilité claire.

Une posture de sécurité solide comprend des pistes d’audit, des alertes en temps réel, un masquage lié aux règles de conformité et une génération de rapports automatisée. Le gestionnaire de conformité de DataSunrise facilite le suivi des violations. De même, le Secure AI Framework (SAIF) de Google fournit des principes pour sécuriser les écosystèmes d’IA.

Exemple : Sécuriser un assistant interne basé sur la RAG

Considérez un assistant LLM d’entreprise qui utilise la RAG pour répondre aux questions des ressources humaines. Une requête telle que « Montrez-moi la répartition des salaires pour les cadres » pourrait révéler des informations restreintes.

Pour atténuer ce problème :

- Les journaux en temps réel suivent les requêtes et détectent les mots-clés.

- Le masquage efface les valeurs numériques dans la réponse.

- La découverte de données signale les fichiers sensibles tels que les tableaux de salaires.

- Les règles de sécurité restreignent l’accès en fonction du rôle de l’utilisateur.

Le système devient sensible au contexte et conforme, tout en maintenant à la fois la fonctionnalité et la sécurité.

L’avenir de la posture de sécurité dans l’IA générative

La gestion de la posture de sécurité dans les grands modèles de langage doit évoluer au rythme des modèles eux-mêmes. Il ne s’agit pas seulement de restreindre l’accès par des pare-feux, mais de concevoir des systèmes d’IA dotés d’une résilience intrinsèque. Cela signifie combiner des techniques classiques telles que la protection des données avec la détection des menaces en temps réel et l’analyse du comportement des utilisateurs.

De plus en plus d’outils apparaissent pour combler ces lacunes, allant des filtres de contenu d’IA de Microsoft Azure à l’IA constitutionnelle d’Anthropic, qui impose des contraintes éthiques au niveau du modèle.

Les organisations doivent considérer l’IA générative non pas comme une boîte noire, mais comme un système vivant. La surveillance, l’audit, le masquage et la conformité doivent faire partie intégrante du processus de conception de l’IA.

Pour plus d’informations, consultez comment DataSunrise prend en charge plus de 40 plateformes de bases de données avec des outils de gestion de la posture de sécurité pour les systèmes traditionnels et l’IA générative.

Suivant